1. 随机森林的基本概念

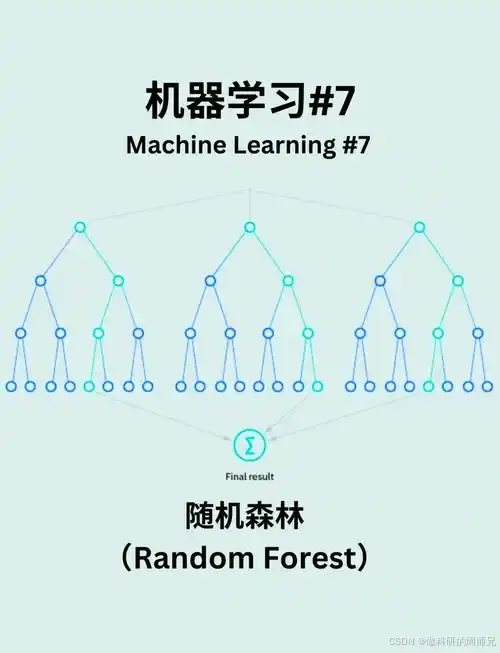

随机森林是一种集成学习方法,由多个决策树组成,通过投票或平均的方式得出最终结果。它由Leo Breiman在2001年提出,结合了Bagging(自助法)和随机特征选择两种技术,是机器学习中最强大、最常用的算法之一。

1.1 决策树的局限性

在讲解随机森林之前,我们需要了解单个决策树的局限性:

- 过拟合问题:单个决策树容易对训练数据过度拟合,导致泛化能力差

- 不稳定性:训练数据的微小变化可能导致决策树结构发生较大变化

- 预测能力有限:单个决策树的预测准确度通常不如其他复杂模型

1.2 随机森林的核心思想

随机森林通过两个关键的随机化过程来克服决策树的局限性:

- 样本随机化:对原始数据集进行有放回抽样(Bootstrap),生成多个训练子集

- 特征随机化:在构建每棵决策树时,随机选择特征子集进行节点分裂

这种"双重随机性"使得森林中的每棵树都具有差异性,从而提高了整体模型的泛化能力和鲁棒性。

2. 随机森林的工作原理

2.1 算法流程

随机森林的构建过程可以概括为以下步骤:

- 从原始训练集中有放回地抽取n个样本,形成新的训练子集

- 对于每个节点的分裂,从所有特征中随机选择m个特征(m远小于特征总数)

- 使用最佳分裂方式(如基尼系数、信息增益)在这m个特征中选择最优特征进行分裂

- 重复步骤2-3,直到树生长完全(达到最大深度或节点样本数小于阈值)

- 重复步骤1-4,构建多棵决策树,形成随机森林

- 对于分类问题,采用多数投票法;对于回归问题,采用平均值作为最终预测结果

2.2 关键参数

随机森林的主要参数包括:

- n_estimators:森林中决策树的数量

- max_features:每次分裂时考虑的特征数量

- max_depth:决策树的最大深度

- min_samples_split:分裂内部节点所需的最小样本数

- min_samples_leaf:叶节点所需的最小样本数

- bootstrap:是否使用有放回抽样

3. 随机森林的优缺点

3.1 优点

- 高准确性:通常比单个决策树有更高的预测准确度

- 抗过拟合:随机性的引入减少了过拟合风险

- 鲁棒性:对噪声和异常值不敏感

- 特征重要性评估:可以评估各个特征的重要程度

- 处理高维数据:能有效处理高维特征空间

- 处理缺失值:能够处理含有缺失值的数据集

- 并行计算:树的构建过程可以并行化,提高计算效率

3.2 缺点

- 计算复杂度:训练多棵决策树需要更多的计算资源

- 解释性较差:相比单个决策树,随机森林的决策过程不那么直观

- 参数调优:需要调整多个参数以获得最佳性能

- 对极度不平衡的数据集效果不佳:需要额外的处理技术

4. 随机森林实战案例

下面通过一个土壤湿度预测的案例,展示随机森林在实际问题中的应用。

4.1 案例背景

假设我们有一个数据集,包含多个环境因素(如温度、降水量、海拔、土壤类型等)和对应的土壤湿度值。我们的目标是建立一个模型,根据这些环境因素预测特定区域的土壤湿度。

4.2 Python代码实现

import numpy as np

import pandas as pd

import matplotlib.pyplot as plt

from sklearn.ensemble import RandomForestRegressor

from sklearn.model_selection import train_test_split, GridSearchCV

from sklearn.metrics import mean_squared_error, r2_score

import seaborn as sns

# 1. 数据加载与预处理

print("加载数据...")

# 假设我们有一个CSV文件,包含环境因素和土壤湿度数据

data = pd.read_csv('e:\\soil_moisture_data.csv')

# 查看数据基本情况

print("数据概览:")

print(data.head())

print("\n数据统计信息:")

print(data.describe())

# 检查缺失值

print("\n缺失值检查:")

print(data.isnull().sum())

# 特征和目标变量分离

X = data.drop('soil_moisture', axis=1) # 假设'soil_moisture'是目标变量

y = data['soil_moisture']

# 特征名称列表

feature_names = X.columns

# 划分训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

print(f"训练集大小: {X_train.shape}")

print(f"测试集大小: {X_test.shape}")

# 2. 构建随机森林模型

print("\n构建随机森林模型...")

# 初始模型

rf = RandomForestRegressor(n_estimators=100, random_state=42)

rf.fit(X_train, y_train)

# 3. 模型评估

print("\n模型评估...")

y_pred = rf.predict(X_test)

# 计算评估指标

mse = mean_squared_error(y_test, y_pred)

rmse = np.sqrt(mse)

r2 = r2_score(y_test, y_pred)

print(f"均方误差 (MSE): {mse:.4f}")

print(f"均方根误差 (RMSE): {rmse:.4f}")

print(f"决定系数 (R²): {r2:.4f}")

# 4. 特征重要性分析

print("\n特征重要性分析...")

importances = rf.feature_importances_

indices = np.argsort(importances)[::-1]

print("特征重要性排名:")

for f in range(X.shape[1]):

print(f"{f + 1}. {feature_names[indices[f]]} ({importances[indices[f]]:.4f})")

# 可视化特征重要性

plt.figure(figsize=(10, 6))

plt.title("特征重要性")

plt.bar(range(X.shape[1]), importances[indices], align="center")

plt.xticks(range(X.shape[1]), [feature_names[i] for i in indices], rotation=90)

plt.tight_layout()

plt.savefig('e:\\feature_importance.png')

plt.close()

# 5. 模型调优

print("\n模型调优...")

# 定义参数网格

param_grid = {

'n_estimators': [50, 100, 200],

'max_depth': [None, 10, 20, 30],

'min_samples_split': [2, 5, 10],

'min_samples_leaf': [1, 2, 4]

}

# 使用网格搜索进行参数调优

grid_search = GridSearchCV(

estimator=RandomForestRegressor(random_state=42),

param_grid=param_grid,

cv=5,

n_jobs=-1,

scoring='neg_mean_squared_error'

)

grid_search.fit(X_train, y_train)

# 输出最佳参数

print("最佳参数:")

print(grid_search.best_params_)

# 使用最佳参数重新训练模型

best_rf = grid_search.best_estimator_

best_rf.fit(X_train, y_train)

# 评估调优后的模型

y_pred_best = best_rf.predict(X_test)

mse_best = mean_squared_error(y_test, y_pred_best)

rmse_best = np.sqrt(mse_best)

r2_best = r2_score(y_test, y_pred_best)

print(f"调优后的均方误差 (MSE): {mse_best:.4f}")

print(f"调优后的均方根误差 (RMSE): {rmse_best:.4f}")

print(f"调优后的决定系数 (R²): {r2_best:.4f}")

# 6. 预测结果可视化

plt.figure(figsize=(10, 6))

plt.scatter(y_test, y_pred_best, alpha=0.5)

plt.plot([y.min(), y.max()], [y.min(), y.max()], 'k--', lw=2)

plt.xlabel('实际值')

plt.ylabel('预测值')

plt.title('随机森林回归:实际值 vs 预测值')

plt.tight_layout()

plt.savefig('e:\\prediction_vs_actual.png')

plt.close()

# 7. 残差分析

residuals = y_test - y_pred_best

plt.figure(figsize=(10, 6))

plt.scatter(y_pred_best, residuals, alpha=0.5)

plt.hlines(y=0, xmin=y_pred_best.min(), xmax=y_pred_best.max(), colors='r', linestyles='--')

plt.xlabel('预测值')

plt.ylabel('残差')

plt.title('残差分析')

plt.tight_layout()

plt.savefig('e:\\residual_analysis.png')

plt.close()

# 8. 保存模型

import joblib

joblib.dump(best_rf, 'e:\\soil_moisture_rf_model.pkl')

print("\n模型已保存至 'soil_moisture_rf_model.pkl'")

print("\n随机森林分析完成!")

4.3 案例解析

上述代码展示了随机森林在土壤湿度预测中的完整应用流程:

- 数据预处理:加载数据、检查缺失值、划分训练集和测试集

- 模型构建:使用默认参数构建随机森林回归模型

- 模型评估:计算MSE、RMSE和R²等评估指标

- 特征重要性分析:识别对预测结果影响最大的环境因素

- 模型调优:使用网格搜索找到最佳参数组合

- 结果可视化:绘制预测值与实际值的对比图和残差分析图

- 模型保存:将训练好的模型保存为文件,便于后续使用

5. 随机森林在不同领域的应用

随机森林因其强大的性能和易用性,在多个领域有广泛应用:

5.1 生态学和环境科学

- 物种分布预测

- 土地覆盖分类

- 气候变化影响评估

- 生物多样性研究

5.2 医疗健康

- 疾病诊断

- 基因表达分析

- 药物反应预测

- 医学图像分析

5.3 金融领域

- 信用评分

- 欺诈检测

- 股票价格预测

- 风险评估

5.4 计算机视觉

- 图像分类

- 目标检测

- 人脸识别

6. 随机森林的进阶技巧

6.1 处理不平衡数据

对于类别不平衡的分类问题,可以采用以下策略:

- 使用class_weight参数调整类别权重

- 结合过采样/欠采样技术(如SMOTE)

- 调整决策阈值

6.2 特征选择

随机森林可以用于特征选择:

- 基于特征重要性排序选择顶部特征

- 使用递归特征消除(RFE)

- 结合主成分分析(PCA)降维

6.3 处理缺失值

随机森林处理缺失值的方法:

- 使用中位数/众数填充

- 使用MissForest算法(基于随机森林的缺失值填充方法)

- 在节点分裂时考虑缺失值情况

7. 总结与展望

随机森林作为一种强大的集成学习方法,具有高准确性、抗过拟合和易于使用的特点,在各个领域都有广泛应用。通过本文的讲解和案例分析,希望您已经对随机森林有了全面的了解。

随着计算能力的提升和算法的不断改进,随机森林及其变体(如极端随机树、梯度提升树等)将在机器学习领域继续发挥重要作用。在实际应用中,建议将随机森林与其他模型进行对比,选择最适合特定问题的解决方案。

记住,模型选择和参数调优是一个反复试验的过程,需要结合领域知识和数据特点,才能获得最佳结果。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?