情绪分析

情绪分析侧重于主观陈述——意见、情绪、情绪:很难用几个关键词来表达。

主观性分类 Subjectivity classification 通常是情感分析的第一步:主观与客观文本

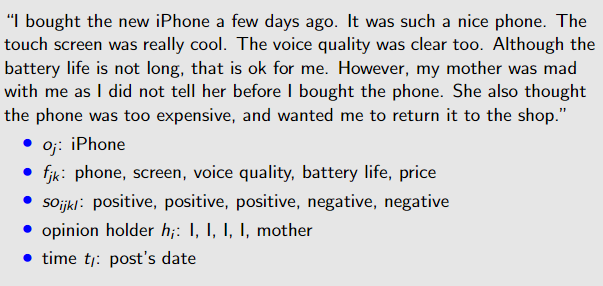

opinion是一个五元组quintuple (oj , fjk , soijkl , hi , tl ),其中后面标黑的是需要完成的任务:

• oj:目标对象:命名实体识别

• fjk:oj 的一个特征:信息提取

• soijkl:是观点持有者观点的情感价值 情感确定

• hi:意见持有者:信息(或元数据)提取

• tl:时间:信息(或元数据)提取

Granularity level 粒度级别

• 文档级别:根据意见持有者表达的总体情绪将文档(例如电影评论)分类为,例如:正面或负面(和中性)。

假设:每个文档都关注一个对象并包含来自一个意见持有者的意见:(oj , fjk , soijkl , hi , tl ),其中 oj = fjk

• 句子级别:同上,但对于(主观)句子,所以这些需要首先要被识别。

• 特征级别:文档和句子可能包含混合意见,此级别的分析无法具体确定人们喜欢/不喜欢什么。

对一个对象的整体正面/负面意见并不意味着意见持有者喜欢/不喜欢它的一切。允许进行各种分析

情绪分析的方法

Lexicon-based 基于词典

分为二元和gradable,后者使用情绪范围而不是二元系统来处理诸如absolutely, utterly, completely, totally, nearly, virtually, essentially,

mainly, almost

• rule-based Binary

Rule-based sentiment classifier (sentence/document-level)

**Rule-based subjectivity classifier:**如果一个句子/文档至少有 n 个(比如 2 个)来自情感词词典的词,那么它是主观的;否则句子/文件是客观的。

Rule-based sentiment classifier:对于主观句子/文档,计算句子/文档中正面和负面的词/短语。如果比正面词/短语更负面,则负面;否则为正(如果相等,则为中性)。

Rule-based sentiment classifier (feature-level)

对于每个特征,计算词典中正面和负面情绪的词/短语。 如果比正面词/短语更负面,则负面;否则为正(如果相等,则为中性)。

• gradable

根据情感内容的水平对文本(文档、句子或特征级别)的一般 valence 进行分类

Valence: affective quality referring to the intrinsic attractiveness or averseness of an event, object, or situation

效价:情感质量,指的是事件、对象或情况的内在吸引力或厌恶性

否定规则Negation rule:

• E.g: “I am not good today”.

Emotion(good)= +3; “not” is detected in neighbourhood (of 5 words around); so emotional valence of “good” is decreased by 1 and sign is

inverted → Emotion(good) = −2

强化规则Intensifier rule:

本文探讨了情绪分析的关键概念,包括主观性分类的五元组,如目标对象、特征提取、情感判断等。重点介绍了基于词典和语料库的方法,如词典驱动的二元和gradable分类,以及规则、否定、强化和减量规则的应用。此外,还涵盖了词义消歧、词性分析和自然语言生成等技术,展示了在信息技术领域的应用和挑战。

本文探讨了情绪分析的关键概念,包括主观性分类的五元组,如目标对象、特征提取、情感判断等。重点介绍了基于词典和语料库的方法,如词典驱动的二元和gradable分类,以及规则、否定、强化和减量规则的应用。此外,还涵盖了词义消歧、词性分析和自然语言生成等技术,展示了在信息技术领域的应用和挑战。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

502

502

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?