Bridging Self-Attention and Time Series Decomposition for Periodic Forecasting

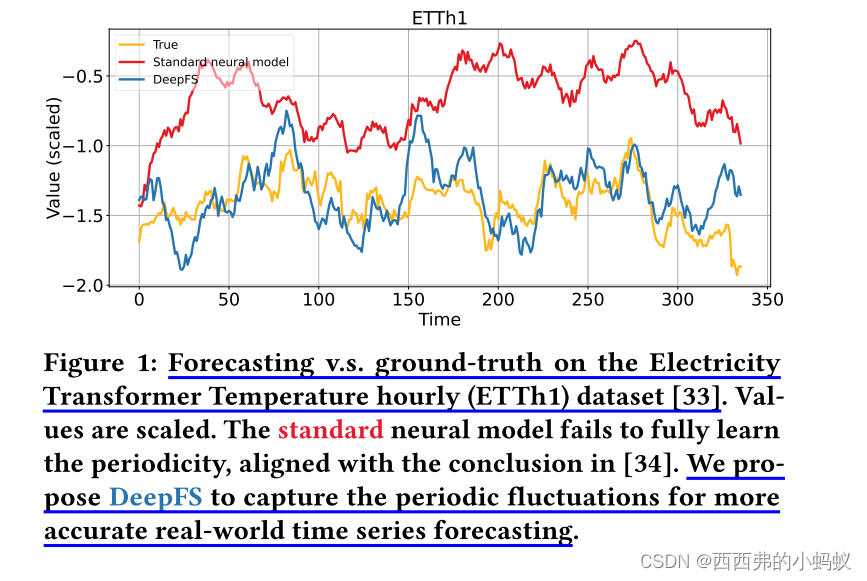

本文研究在单变量时间序列预测中,如何捕获显式周期性以提高深度模型的精度。最近的高级深度学习模型,如循环神经网络(rnn)和transformer,由于其强大的表达能力,在建模自然语言等顺序数据方面达到了新的高度。然而,现实世界的时间序列往往比一般的序列数据更具周期性,而最近的研究证实,标准的神经网络不能充分捕捉周期性,因为它们没有模块可以显式地表示周期性。

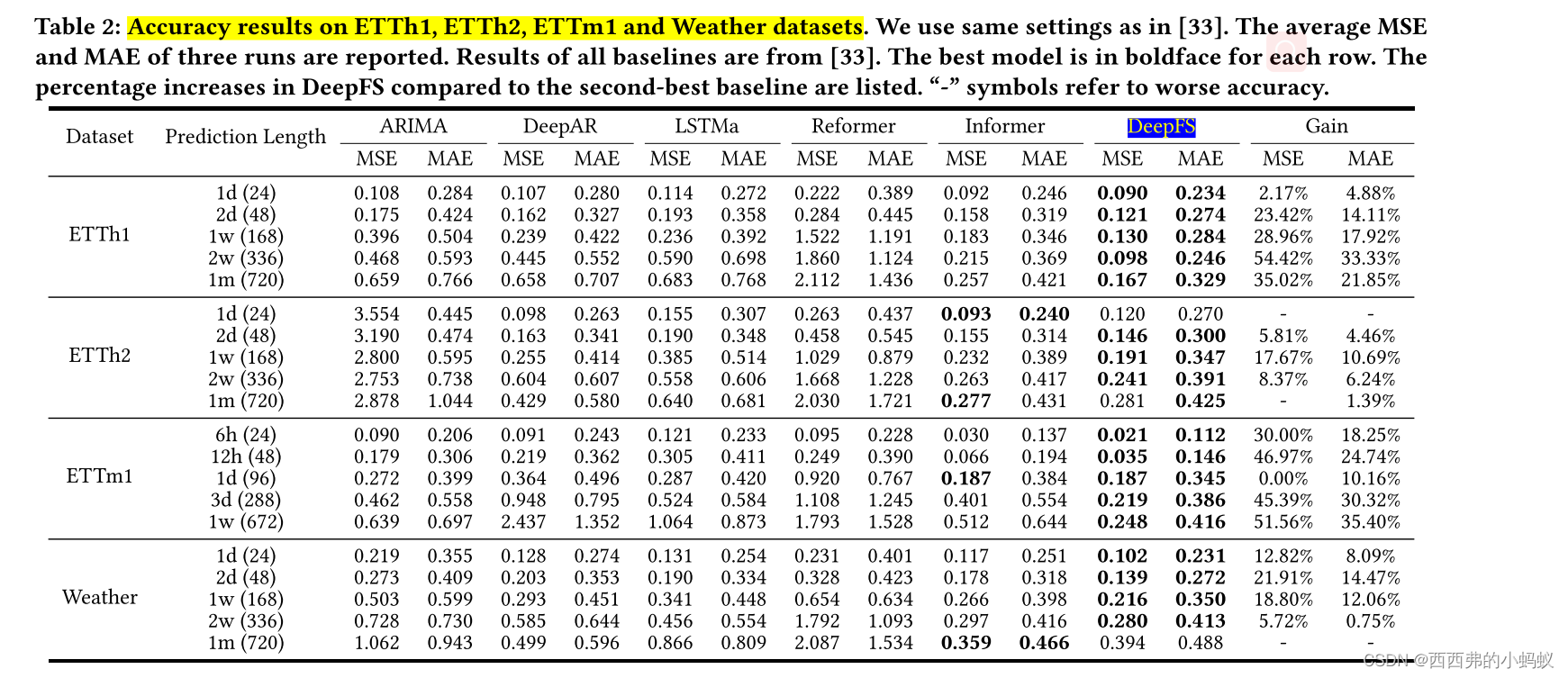

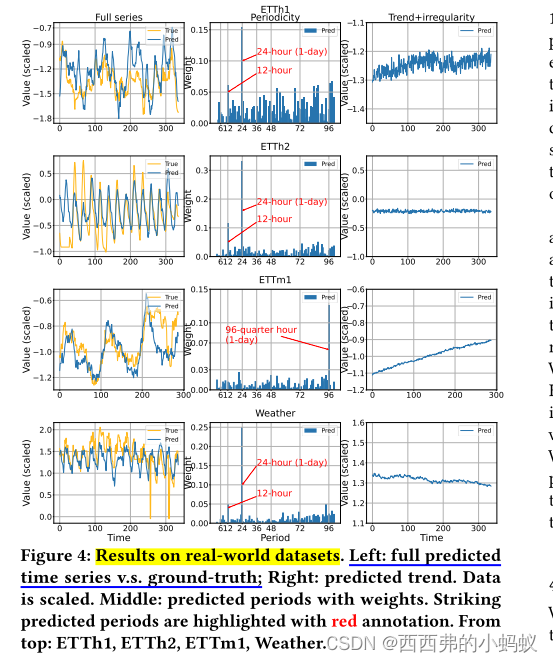

本文通过将自注意力网络与时间序列分解桥接起来来缓解这一挑战,提出了一种新的框架DeepFS。DeepFS为深度模型提供傅里叶级数,以保持时间序列的周期性。该模型首先使用自注意力对时间模式进行编码,从中预测周期和非周期成分,以重建预测输出。傅里叶级数作为一个归纳偏差注入到周期分量中。捕捉周期性不仅提高了预测精度,而且为现实世界的时间序列提供了可解释的见解。在合成数据集和真实数据集上的广泛实证分析证明了DeepFS的有效性。关于DeepFS为什么工作以及何时工作的研究提供了对我们模型的进一步理解。

二研究内容:

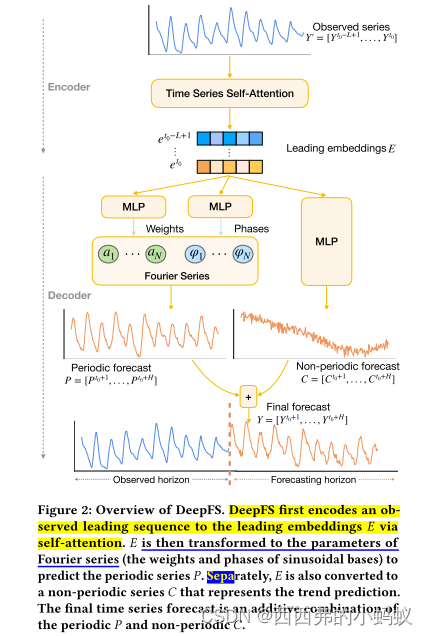

通过一种简单有效的编码器-解码器范式将深度序列网络和时间序列分解联系起来。所提出的模型DeepFS通过自注意力机制保留时间模式,其中使用周期归纳偏差来捕获周期性,以更准确地预测时间序列。

DeepFS使用傅里叶级数来表示周期分量,并将先导级数嵌入转换为傅里叶基的参数。学习到的傅立叶级数是一个周期性的归纳偏差,它明确地揭示了序列的周期性,以更好地预测。

DeepFS遵循编码器-解码器范式,其中编码器通过自注意力机制将起始值转换为每个时间戳的潜在表示,将这些嵌入转换为预测的周期序列和非周期序列的解码器,它们分别反映了周期性和趋势。结合周期序列和非周期序列,采用[11]加性分解模型重构最终的预测序列。

总结:这个模型结构很明显看出来。两部分,一部分是embedding部分,实现结构化预测,另一个是使用非线性结构预测

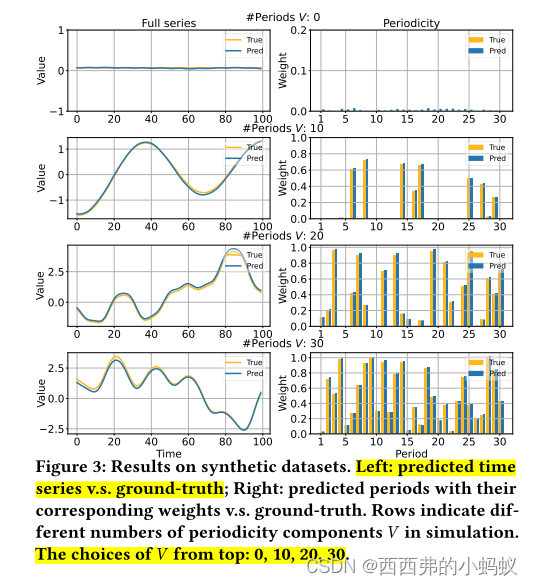

我们注意到,即使时间序列完全是非周期性的,DeepFS仍然可以工作(图3的第一行)

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?