决策树:

决策树模型呈树形结构,在分类问题中,表示基于特征对实例进行分类的过程,它可以认为是if-then 规则的集合,也可以认为是定义在特征空间与类空间上的条件概率分布。学习时,利用训练数据,根据损失函数最小化的原则建立决策树模型.预测时,对新的数据,利用决策树模型进行分类决策树学习通常包括3 个步骤: 特征选择、决策树的生成和决策树的修剪。

决策树模型由结点和有向边组成,其中结点分为:内部结点和叶结点。内部结点表示一个特证或属性,叶结点表示个类。

特征选择:

特征选择在于选取对训练数据具有分类能力的特征.这样可以提高决策树学习的效率.如果利用一个特征进行分类的结果与随机分类的结果没有很大差别,则称这个特征是没有分类能力的。经验上扔掉这样的特征对决策树学习的精度影响不大.通常特征选择的准则是信息增益或信息增益比。

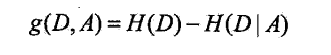

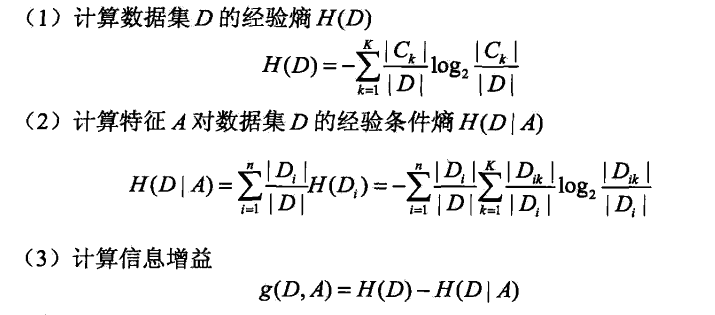

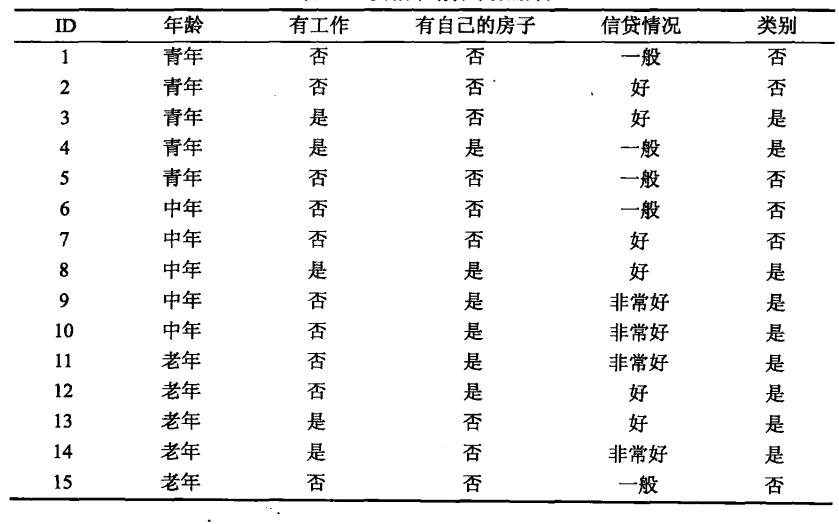

接下来重点介绍信息增益:

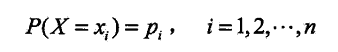

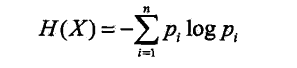

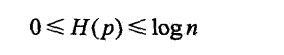

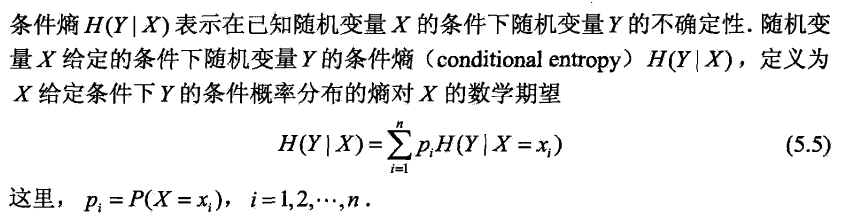

- 熵(entropy)

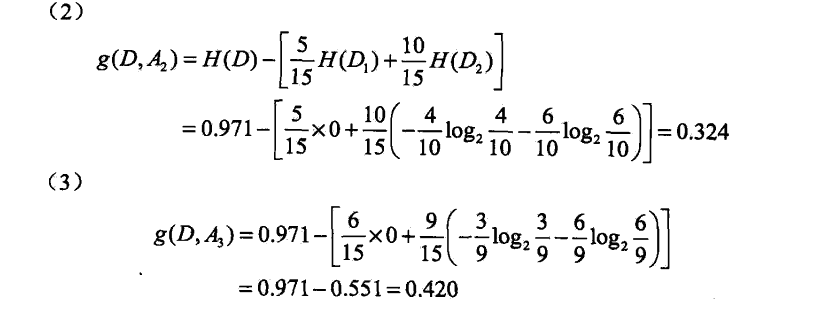

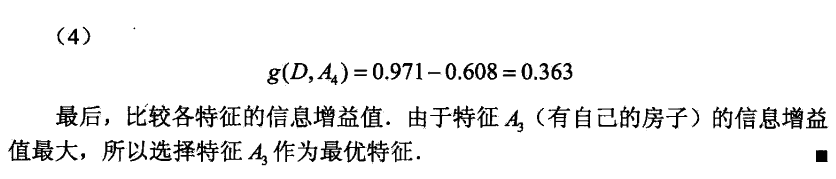

例子:这是一个15样本的贷款申请训练数据。

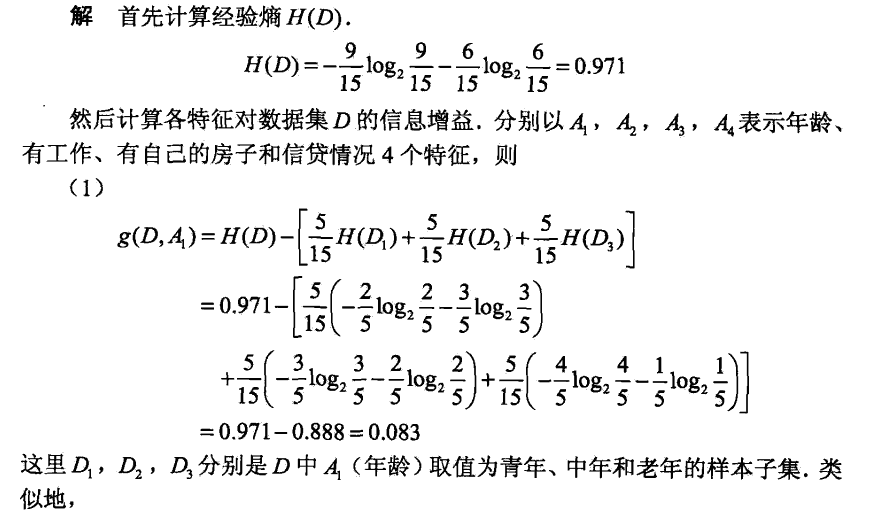

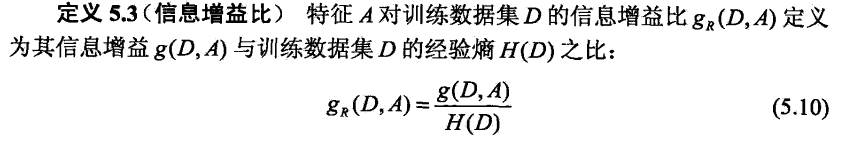

信息增益比:

信息增益选择方法有一个很大的缺陷,它总是会倾向于选择属性值多的属性,如果我们在上面的数据记录中加一个姓名属性,假设14条记录中的每个人姓名不同,那么信息增益就会选择姓名作为最佳属性,因为按姓名分裂后,每个组只包含一条记录,而每个记录只属于一类(要么购买电脑要么不购买),因此纯度最高,以姓名作为测试分裂的结点下面有14个分支。但是这样的分类没有意义,它没有任何泛化能力。

而信息增益比就是信息增益与数据集D的经验熵之比:

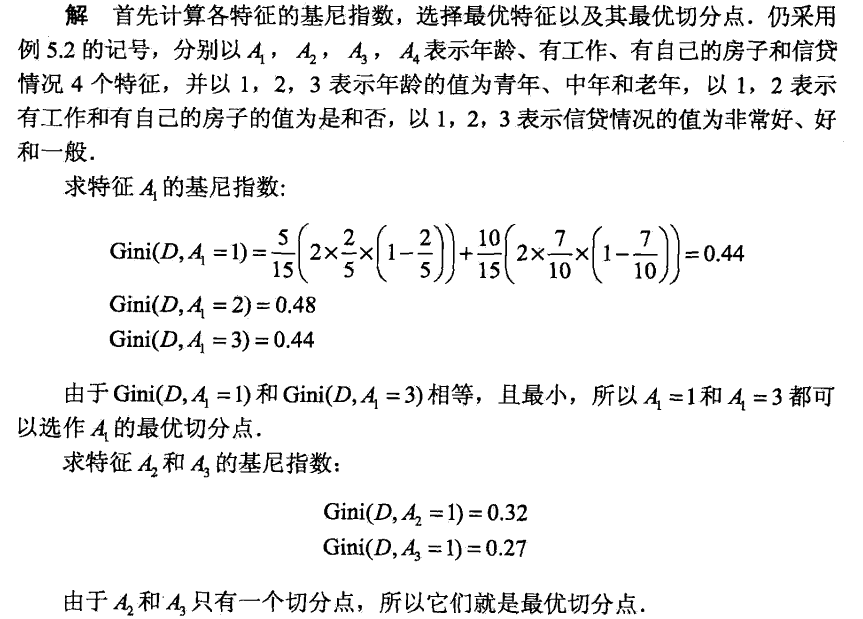

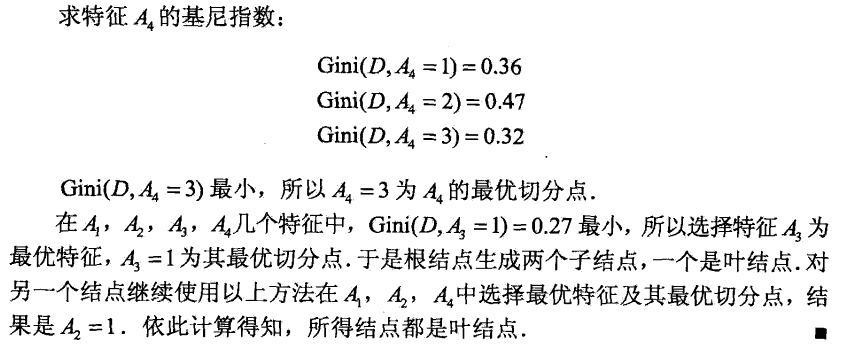

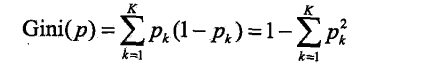

基尼指数:

给出定义:

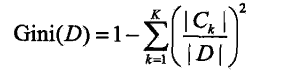

对于给定的样板集合D,其基尼指数为

这里,Ck是D中属于第k类的样本子集,K是类个数。

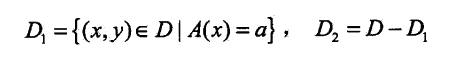

如果样本集合D根据A是否取某一可能值a被分割成D1,D2两部分,即

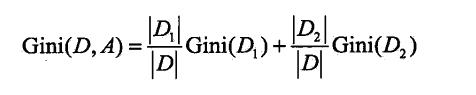

则在特征A的条件下,集合D的基尼指数定义为:

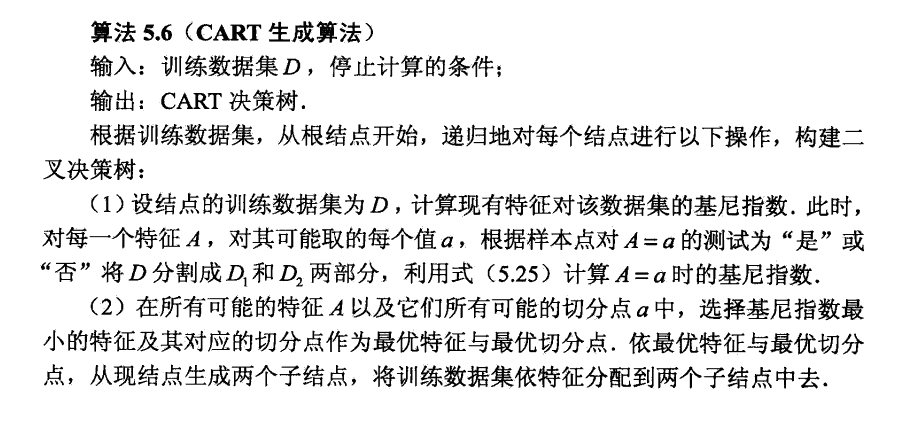

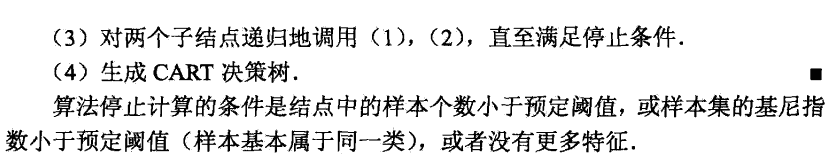

决策树的生成:

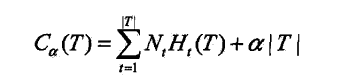

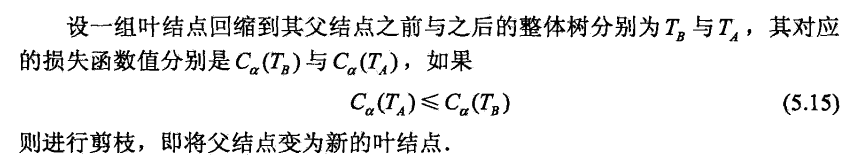

决策树剪枝:

278

278

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?