目录

前言

📅大四是整个大学期间最忙碌的时光,一边要忙着备考或实习为毕业后面临的就业升学做准备,一边要为毕业设计耗费大量精力。近几年各个学校要求的毕设项目越来越难,有不少课题是研究生级别难度的,对本科同学来说是充满挑战。为帮助大家顺利通过和节省时间与精力投入到更重要的就业和考试中去,学长分享优质的选题经验和毕设项目与技术思路。

🚀对毕设有任何疑问都可以问学长哦!

大家好,这里是海浪学长计算机毕设专题,本次分享的课题是

🎯深度学习技术驱动的细胞图像分割方法算法实现

项目背景

在医学和生物学领域,准确地分割细胞图像对于细胞结构和功能的研究至关重要。然而,由于细胞图像的复杂性和多样性,传统的图像处理方法往往难以达到准确的分割效果。深度学习技术的兴起为细胞图像分割提供了一种新的解决方案。通过结合深度学习和计算机视觉技术,可以实现对细胞图像的自动分割和准确识别,为细胞生物学研究提供有力的支持和推动。

设计思路

1. 算法理论

1.1 双路特征提取

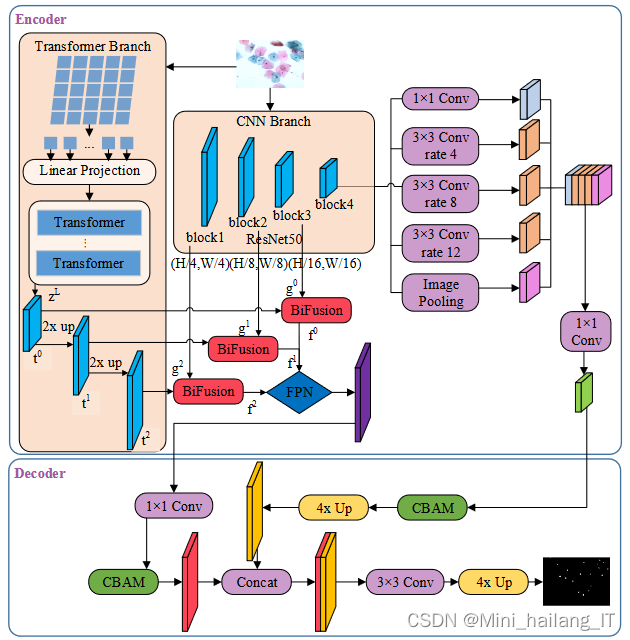

通过引入基于ResNet50和Transformer的特征提取网络并行运行,以及双路特征融合模块,构建了DL_RT细胞核分割模型。该模型相较于基于DeepLabv3+的基础模型,在干扰物相对细胞核特征明显、细胞团内环境清晰的情况下,提升了分割精度。然而,当前模型仍然无法准确辨别细胞核与细胞内的不同干扰物,如非上皮细胞成分和细胞内容物。DL_RT模型的主干网络由两个平行的分支组成,分别是CNN分支和Transformer分支。CNN分支利用原始的ResNet50主干网络进行特征提取,从局部到全局进行编码。Transformer分支使用全局自我注意力机制捕获全局依赖性的上下文信息,并通过上采样恢复局部细节。最后,两个分支的特征经过融合,以提高对细胞核的识别能力。这些改进扩充了宫颈细胞团分割模型,使其更适用于解决细胞核分割中的干扰物问题。

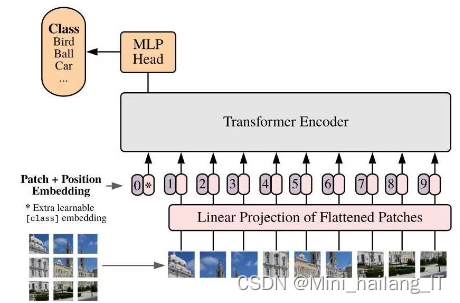

Vision Transformer (ViT) 是一种完全采用纯Transformer结构的模型,用于图像分类任务。与传统的深度神经网络中的卷积操作不同,ViT将Transformer应用于图像处理。ViT的主要架构类似于语言Transformer,但输入图像首先被转换为一系列固定尺寸的图像块,并以矢量形式平铺,然后按序列的方式输入到Transformer编码器中。通过线性层将矢量化的图像块展平为一维向量,并附加位置嵌入以编码图像块的位置信息。在图像序列的开头引入代表类别的标志位,并通过位置编码输入到多个串行的Transformer编码器中进行注意力计算和特征提取。最后,使用与第一个位置对应的输出作为图像的分类结果。

ViT模型由L个串联的Transformer编码器组成,编码器结构包括多头自注意力(MSA)层和多层感知器(MLP)层,即前馈神经网络。在每一层中,数据先经过归一化处理(LN),然后与输入数据进行残差连接,最后输入到下一层进行处理。通过这种方式,ViT模型能够对图像进行注意力计算和特征提取,并生成与图像分类相关的输出。

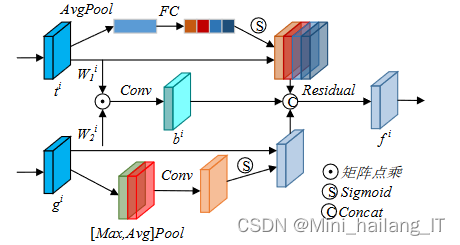

为了克服Transformer模型在提取细节信息方面的局限性,特别是在处理边缘模糊的医学图像分析任务时,可以将CNN与Transformer结合起来。在BiFusion模块中,将CNN和Transformer两个分支的特征分别进行处理,并将它们融合在一起,以提高图像特征的表达能力。在Transformer分支的输出特征上,采用SE-Block来对通道进行注意力操作,通过对不同通道分配不同大小的权重,从而实现对全局空间信息的压缩。这样可以促进模型在通道维度上进行特征学习,以提取有效的全局信息。而对于CNN分支的输出特征,采用CBAM的空间注意力部分进行空间滤波处理。该部分为每个像素点赋予不同大小的权重,以增强局部细节并抑制无关区域。这对于处理低层CNN特征中存在的干扰信息非常有用。

1.2 图像分割

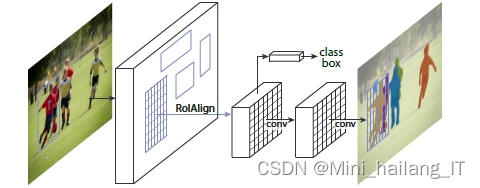

通过使用融合后的特征作为输入,采用先进的分割方法如Mask R-CNN,可以实现对宫颈细胞图像的精确分割预测。Mask R-CNN结合了区域提议网络和全卷积网络,能够定位和分割细胞核,并生成像素级的分割掩码。这种细粒度的分割结果能够提供有关细胞核形状和位置的详细信息,为进一步的结果后处理和最终的分割结果生成提供基础。

Mask R-CNN通过在Faster R-CNN的基础上添加一个分割分支,实现了像素级的目标分割。该算法利用预训练的卷积神经网络提取图像特征,并结合区域提议网络和ROI池化来生成候选目标区域。然后,通过分类和边界框回归确定目标的类别和位置。与此同时,Mask R-CNN还引入了一个全卷积网络分支,通过对ROI特征进行处理生成精确的分割掩码。这种联合目标检测和实例分割的方法能够在像素级别上准确地识别和分割图像中的目标。

2. 数据集

由于网络上缺乏现有的合适数据集,为了支持该课题的研究,我决定使用网络爬虫技术进行数据收集。通过爬取公开的细胞图像数据库和科研论文中的细胞图像,我制作了一个全新的、多样化的细胞图像数据集。通过数据预处理和增强技术,我对细胞图像进行了扩充和增强,包括图像的旋转、缩放和变换等操作。这样做的目的是进一步丰富数据集的多样性,提高算法系统的鲁棒性和泛化能力。

import scrapy

class CellImagesSpider(scrapy.Spider):

name = "cell_images"

def start_requests(self):

urls = [

"http://example.com/cell_images",

"http://example2.com/cell_images",

]

for url in urls:

yield scrapy.Request(url=url, callback=self.parse)

def parse(self, response):

image_urls = response.css("img.cell-image::attr(src)").getall()

for image_url in image_urls:

yield {

'image_url': image_url,

'source': response.url,

}

next_page_url = response.css("a.next-page::attr(href)").get()

if next_page_url:

yield response.follow(next_page_url, callback=self.parse)3. 模型训练

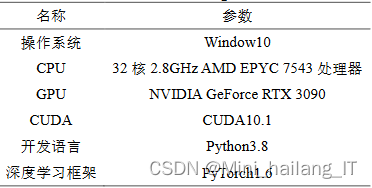

3.1 实验环境

基于Windows 10系统、PyTorch深度学习框架,以及32核2.8GHz AMD EPYC 7543处理器和NVIDIA GeForce RTX 3090显卡的加速计算能力,该实验能够高效地进行深度学习模型的训练和测试,为细胞图像分割任务提供了可靠的实验环境和计算资源。

3.2 实验分析

设计思路流程:

- 数据准备:收集细胞图像数据集,并进行标注,标注包括细胞核的分割掩码。

- 特征提取:使用ResNet50和Transformer网络作为双路特征提取器,并并行提取图像的局部特征和全局上下文特征。

- 特征融合:通过双路特征融合模块将ResNet50和Transformer网络提取的特征进行融合。融合方法可以采用简单的连接或者使用注意力机制进行加权融合。

- 分割预测:通过使用融合后的特征作为输入,采用先进的分割方法如Mask R-CNN,可以实现对细胞图像的精确分割预测。

- 损失函数与训练:定义适当的损失函数,如交叉熵损失函数或Dice损失函数,根据实际情况进行权衡选择。使用标注的分割掩码与模型预测结果之间的差异来计算损失,并通过反向传播算法进行模型训练。

- 模型评估:使用测试集对训练好的模型进行评估,计算分割结果的准确率、召回率、F1分数等指标。

相关代码示例:

import torch

import torch.nn as nn

class FeatureFusionModule(nn.Module):

def __init__(self, resnet_features, transformer_features, fusion_type='concat'):

super(FeatureFusionModule, self).__init__()

self.resnet_features = resnet_features

self.transformer_features = transformer_features

self.fusion_type = fusion_type

if self.fusion_type == 'concat':

fusion_dim = resnet_features + transformer_features

self.fusion_layer = nn.Sequential(

nn.Linear(fusion_dim, fusion_dim),

nn.ReLU(inplace=True)

)

elif self.fusion_type == 'attention':

self.attention = nn.Sequential(

nn.Linear(transformer_features, resnet_features),

nn.Softmax(dim=1)

)

def forward(self, resnet_output, transformer_output):

if self.fusion_type == 'concat':

fused_features = torch.cat((resnet_output, transformer_output), dim=1)

fused_features = self.fusion_layer(fused_features)

elif self.fusion_type == 'attention':

attention_weights = self.attention(transformer_output)

fused_features = resnet_output + attention_weights * transformer_output

return fused_features海浪学长项目示例:

本文介绍了一种利用深度学习技术(如ResNet50和Transformer)进行细胞图像分割的方法,包括双路特征提取、特征融合和MaskR-CNN的应用。项目介绍了实验背景、设计思路,以及模型在特定环境下的训练过程,旨在提高细胞核分割的准确性。

本文介绍了一种利用深度学习技术(如ResNet50和Transformer)进行细胞图像分割的方法,包括双路特征提取、特征融合和MaskR-CNN的应用。项目介绍了实验背景、设计思路,以及模型在特定环境下的训练过程,旨在提高细胞核分割的准确性。

627

627

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?