http://blog.csdn.net/pipisorry/article/details/51482120

文本分析的三类参数估计方法-最大似然估计MLE、最大后验概率估计MAP及贝叶斯估计。

参数估计

参数估计中,我们会遇到两个主要问题:(1)如何去估计参数的value。(2)估计出参数的value之后,如何去计算新的observation的概率,即进行回归分析和预测。

首先定义一些符号:

数据集X中的所有Xi,他们是独立同分布的,因此后面求X 的概率的时候,xi可以相乘。

贝叶斯公式

这个公式也称为逆概率公式,可以将后验概率转化为基于似然函数和先验概率的计算表达式,即

最大似然估计MLE

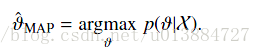

最大后验估计MAP

最大后验估计与最大似然估计相似,不同点在于估计的函数中允许加入一个先验

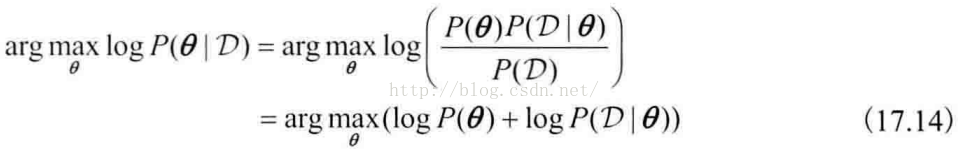

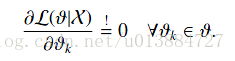

,也就是说此时不是要求似然函数最大,而是要求由贝叶斯公式计算出的整个后验概率最大,不是在整个后验概率上积分,而是搜索该分布的最大值,即

Note: 这里P(X)与参数无关,因此等价于要使分子最大。

通过加上这个先验分布项,我们可以编码额外的信息,并且可以避免参数的过拟合问题。

与最大似然估计相比,现在需要多加上一个先验分布概率的对数。在实际应用中,这个先验可以用来描述人们已经知道或者接受的普遍规律。例如在扔硬币的试验中,每次抛出正面发生的概率应该服从一个概率分布,这个概率在0.5处取得最大值,这个分布就是先验分布。先验分布的参数我们称为超参数(hyperparameter)即,我们认为,theta也是服从一个先验分布的:alpha是他的超参数

同样的道理,当上述后验概率取得最大值时,我们就得到根据MAP估计出的参数值。

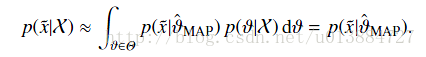

给定观测到的样本数据,一个新的值 发生的概率是

发生的概率是

Note: 这里积分第一项与theta无关(使用的是MAP值),所以第二项积分为1(也就是后验概率不随新来的数据变化,为1?)。

扔硬币的伯努利实验示例

我们期望先验概率分布在0.5处取得最大值,我们可以选用Beta分布(lz:实际上选择beta分布的原因是beta分布和二项分布是共轭分布)即

其中Beta函数展开是

当x为正整数时

Beta分布的随机变量范围是[0,1],所以可以生成normalized probability values。下图给出了不同参数情况下的Beta分布的概率密度函数

我们取,这样先验分布在0.5处取得最大值(观察上面的图,因为我们先验认为p约等于0.5,因此超参数a和b是相等的,我们这里选择等于5)。

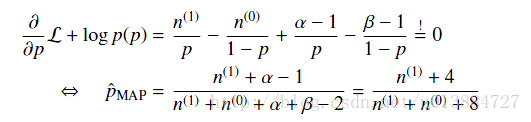

现在我们来求解MAP估计函数的极值点,同样对p求导数,得到参数p的的最大后验估计值为

后面两项是对log(p(p|alpha,beta))的求导

和最大似然估计ML的结果对比可以发现结果中多了,我们称这两者为pseudo count伪计数,这两项的作用是使总概率p向0.5拉近,因为我们的先验认为就是约等于0.5的。这样的pseudo-counts就是先验在起作用,并且超参数越大,为了改变先验分布传递的belief所需要的观察值就越多,此时对应的Beta函数越聚集,紧缩在其最大值两侧。

如果我们做20次实验,出现正面12次,反面8次,那么,根据MAP估计出来的参数p为16/28 = 0.571,小于最大似然估计得到的值0.6,这也显示了“硬币一般是两面均匀的”这一先验对参数估计的影响。

MAP估计*

MAP参数的敏感性以及后验概率形式的不敏感性

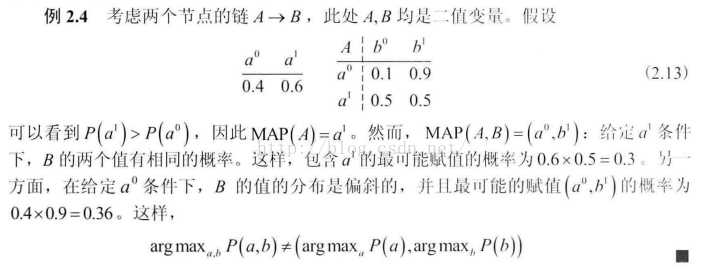

MAP表示独立性

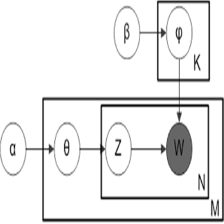

[PGM原理与技术]

最大后验查询的一个示例

贝叶斯思想和贝叶斯参数估计

[

贝叶斯思想和贝叶斯参数估计 ]

MLE,MAP和贝叶斯估计对参数估计的比较

综上所述我们可以可视化MLE,MAP和贝叶斯估计对参数的估计结果如下

lz:从MLE到MAP再到贝叶斯估计,对参数的表示越来越精确(由易到难,估计的value也越来越perfect),得到的参数估计结果也越来越接近0.5这个先验概率,越来越能够反映基于样本的真实参数情况。

Why the MLE doesn’t work well?

While MLE is guaranteed to maximizes the probability of an observed data, we areactually interested in finding estimators that perform well on new data. A serious problemarises from this perspective because the MLE assigns a zero probability to elements thathave not been observed in the corpus. This means it will assign a zero probability to anysequence containing a previously unseen element.

from: http://blog.csdn.net/pipisorry/article/details/51482120

ref: Gregor Heinrich: Parameter estimation for text analysis*

文本分析中的参数估计,以LDA为例,英文版:Heinrich-GibbsLDA.pdf

Reading Note : Parameter estimation for text analysis 暨LDA学习小结

本文深入探讨了三种参数估计方法:最大似然估计(MLE)、最大后验概率估计(MAP)及贝叶斯估计。通过理论讲解与实例分析,详细说明了这些方法如何应用于解决文本分析中的关键问题。

本文深入探讨了三种参数估计方法:最大似然估计(MLE)、最大后验概率估计(MAP)及贝叶斯估计。通过理论讲解与实例分析,详细说明了这些方法如何应用于解决文本分析中的关键问题。

1362

1362

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?