1. Introduction

监督学习(supervised learning):粗糙的说就是需要利用输入值来预测输出.

变量解释:

X :输入变量

Y :定量输出

G :定性输出,G∈G

xi : X 的第i 个观测值

X :矩阵

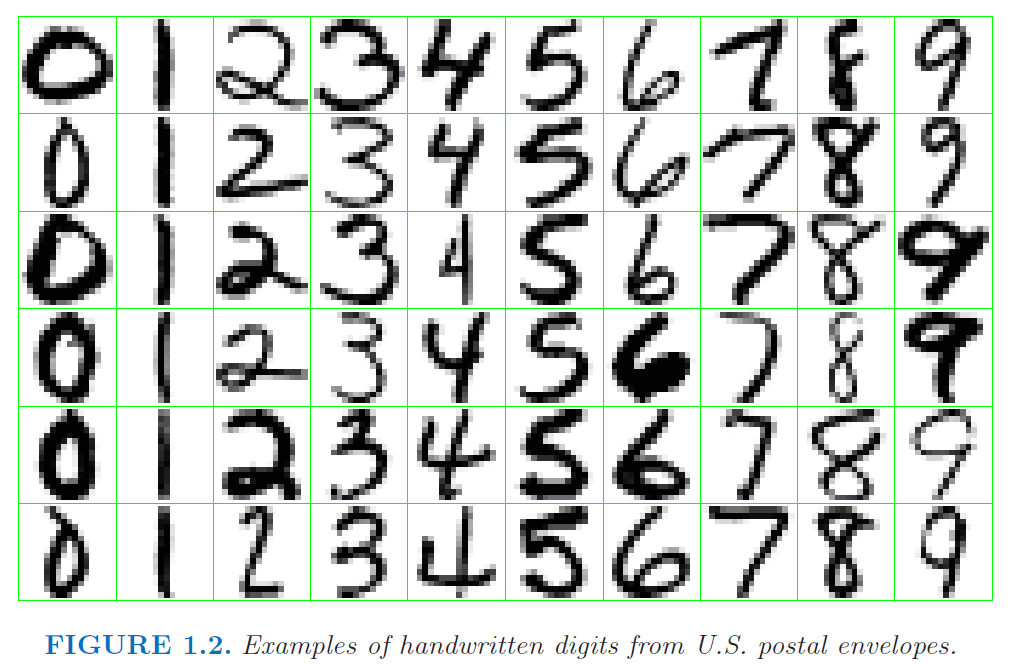

Example 1. Handwritten Digit Recognition

目标为预测给定图中的数字,其中 G={ 0,1,2,...,9} .

部分样本如下图:

2. Linear models and OLS

2.1 模型简介

输入向量 XT=(X1,...Xp) ,预测输出

Y^=β^0+∑j=1pXjβ^j=XTβ

利用最小二乘(OLS)估计 β

本文介绍了监督学习的基本概念,包括输入变量X、定量输出Y和定性输出G。以手写数字识别为例,深入探讨了线性模型和最小二乘法(OLS)在预测中的应用。通过统计理论分析期望均方预测误差,阐述了线性模型的优劣。此外,文章还讨论了示性矩阵在处理定性输出时的作用,展示了如何使用R语言的Iris数据集进行线性分类器实践,成功预测了花卉种类。

本文介绍了监督学习的基本概念,包括输入变量X、定量输出Y和定性输出G。以手写数字识别为例,深入探讨了线性模型和最小二乘法(OLS)在预测中的应用。通过统计理论分析期望均方预测误差,阐述了线性模型的优劣。此外,文章还讨论了示性矩阵在处理定性输出时的作用,展示了如何使用R语言的Iris数据集进行线性分类器实践,成功预测了花卉种类。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

887

887

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?