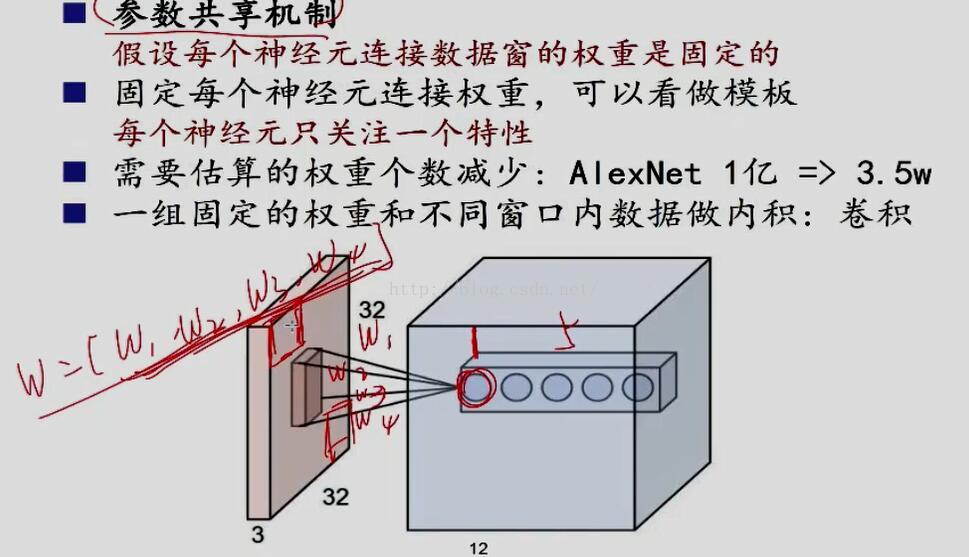

全连接层缺点是参数很多,卷积层可以减少参数,减少计算量,因为卷积层的参数共享特性。

在学习了点击打开链接

以后,继续看下图:

学习了点击打开链接

知道,小盆友1视野很小,每个感受野对应一些参数,假设为w1w2w3w4,每滑动一次,另一个感受野又对应四个w,因为每个小朋友都有自己处事原则(不管看什么,参数不变),所以一个小盆友只要学习四个参数。一幅图只要4*5=20个参数

开个玩笑,如果小盆友都很善变,每次看东西方式都变,会有height_col*width_col*4*5个参数啊!计算量很大

注: int height_col= (height + 2 * pad_h - kernel_h) / stride_h + 1;

本文对比全连接层,阐述了卷积层通过参数共享减少计算量的优势。通过具体例子说明了卷积层如何减少参数数量,进而降低计算复杂度。

本文对比全连接层,阐述了卷积层通过参数共享减少计算量的优势。通过具体例子说明了卷积层如何减少参数数量,进而降低计算复杂度。

4917

4917

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?