华电北风吹

日期:2015/11/25

本文主要对岭回归(ridge regression)进行总结。

本系列的第一篇中线性回归的转化为如下的无约束优化问题

minθ∑mi=1(y(i)−θTx(i))2(0-1)

其中,

x(i)∈Rn×1

表示每个样本都是n维向量,

y(i)

表示样本

x(i)

对应的标签,

θ∈Rn×1

表示参数向量。与之等价的矩阵形式为

minθ||Xθ−Y||22(0-2)

其中

X=(x(1),x(2),...,x(m))T∈Rm×n,Y=(y(1),y(2),...,y(m))T

.

一、岭回归

岭回归的目标表达式为

min∑mi=1(y(i)−θTx(i))2+λ⋅||θ||22(1-1)

岭回归出现原因:为了防止特征之间线性相关。具体参考本系列第一篇线性回归的矩阵求解部分。

二、岭回归的矩阵求解

可以使用与最小二乘矩阵解法类似的矩阵求导来求解岭回归问题

令

S(θ)=∑mi=1(y(i)−θTx(i))2+λ⋅||θ||2

ddθS(θ)=ddθS(θ)=2XT(Y−Xθ)+2λ⋅θ=0

即

XTY=(XTX−λI)⋅θ

解得:

θ=(XTX−λI)−1XTY(2-1)

三、岭回归参数

θ

的SVD几何解释

同本系列第一篇文章对于线性回归的SVD解释,

假设

X∈Rm×n

的SVD分解为

X=UΣVT(3-1)

其中

U=(u1,u2,...,un)∈Rm×n

,

Σ=diag(σ1,σ2,...,σn)∈Rn×n

,

V=(v1,v2,...,vn)∈Rn×n

,

v1,v2,...,vn

是原始样本空间的一组标准正交基,

u1,u2,...,un

分别是原始样本在这组基下的正交标准化坐标。

XTX=(UΣVT)TUΣVT=VΣUTUΣVT=VΣ2VT(3-2)

对于线性回归

θlr=(XTX)−1XTY

可得

θlr=∑ni=11σiviuTiY

对于岭回归

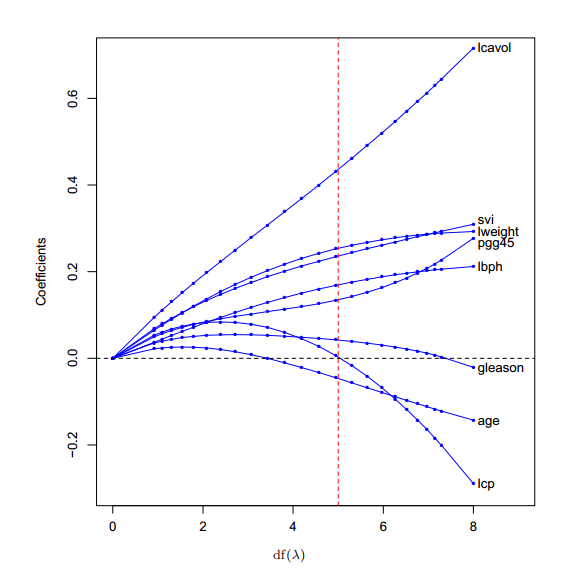

θridge=(XTX−λI)−1XTY=V(Σ2+λI)−1ΣUTY=∑ni=1σiσ2i+λviuTiY(3-3)

对

λ

定性分析可以发现,岭回归求解的

θ

相对于线性回归来说要更加偏向于向零收缩,并且随着

λ

增加收缩幅度更大(如下图),例如当

λ=0

时,岭回归和线性回归求解得到的

λ

是相同的,当

λ=∞

时

θ=0

。

其中

df(λ)=∑ni=1σiσ2i+λ

四、参考博客

ML—线性回归系列(一)—线性回

归http://blog.csdn.net/zhangzhengyi03539/article/details/50035265

533

533

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?