目录

前言

📅大四是整个大学期间最忙碌的时光,一边要忙着备考或实习为毕业后面临的就业升学做准备,一边要为毕业设计耗费大量精力。近几年各个学校要求的毕设项目越来越难,有不少课题是研究生级别难度的,对本科同学来说是充满挑战。为帮助大家顺利通过和节省时间与精力投入到更重要的就业和考试中去,学长分享优质的选题经验和毕设项目与技术思路。

🚀对毕设有任何疑问都可以问学长哦!

选题指导:

大家好,这里是海浪学长毕设专题,本次分享的课题是

🎯基于深度学习的鲜花与绿植种类自动识别

设计思路

一、课题背景与意义

随着人们对园艺和室内植物的关注度不断提高,鲜花和绿植的种类识别需求日益增长。传统的植物识别方法通常依赖于专业的园艺师或植物学家,其专业知识和经验在识别过程中至关重要。然而,随着技术的发展,利用计算机视觉和深度学习的方法进行自动识别,能够大幅提升识别效率和准确性。这不仅有助于爱好者了解和选择植物,还能够在生态研究、农业生产等领域发挥重要作用。

二、算法理论原理

2.1 卷积神经网络

卷积神经网络的种类多样,但基本结构相同,通常包含输入层、卷积层、池化层、激活函数和输出层。卷积层、池化层和激活函数是网络中最关键的部分。卷积层是网络的核心,图像通过输入层进入网络,通常输入图像为彩色,即三个通道(RGB)。每个通道与过滤器进行卷积运算,过滤器中包含多个卷积核,卷积核与与其大小相同的图像区域进行线性运算,生成与过滤器数量相同的特征图。特征图的输出可视为各特征图的叠加,不同的卷积核对不同的特征起作用,最后输出与不同特征相关的特征图,例如去噪、增强、边缘检测和特征提取等。

池化层位于卷积层后,经过卷积层处理后的图像同样使用过滤器对特征图进行处理,但不进行与相应位置像素的点积运算,而是对图像进行向下采样。卷积神经网络中最常见的池化方式是平均池化和最大池化。平均池化根据池化大小对特征图中目标位置的数值取平均,得到新的矩阵,通过这种方式减小特征图的大小,显著降低计算量,同时保留更多背景信息,但可能导致图像清晰度降低。最大池化则根据池化大小从相应区域挑选最大值,反向传播中令同一区域其他值为零,摒弃大量冗余数据,提高计算效率,保留更多纹理信息,且平移的输入不会影响输出,达到平移不变性。

全连接层通常位于卷积网络的最后,是与前一层所有神经元相连接,对经过卷积和池化的特征图进行分类。全连接层将卷积神经网络找到的全部特征进行组合,最终确定图像所属类别,通常在全连接层后跟随分类的激活函数,例如Softmax激活函数。全连接层可能产生大量冗余参数,例如在VGG16网络中,最后一次卷积得到的特征图大小为7×7×512,通过全连接层转变为一维向量1×4096,所需的卷积核数量庞大。但全连接层可以忽略特征位置对分类的影响,有效提高网络的鲁棒性。局部连接的卷积层通过感知局部信息,避免学习过多细节而产生过拟合。激活函数在神经网络中非常重要,能够引入非线性元素,使网络在处理复杂问题时表现更佳。常见的激活函数包括Sigmoid、ReLU和Tanh等。

2.2 YOLOv5算法

YOLOv5s是YOLO系列中的一个重要版本,专为实时目标检测任务设计。该算法在保持较高检测精度的同时,通过优化模型结构和减少参数数量,显著提升了推理速度和计算效率。YOLOv5s的架构主要由三个核心部分构成:Backbone(特征提取网络)、Neck(特征融合网络)和Head(检测头)。这三部分相互配合,有效地实现了从输入图像中提取特征、融合多尺度信息和进行目标检测的全过程,使得YOLOv5s在多种实际应用场景中表现出色。

YOLOv5s的Backbone采用了CSPNet结构,旨在提高特征提取的效率和准确性。CSPNet通过将特征图分为两部分进行处理,减少了计算量,并在不损失信息的情况下提高了信息流的传递效率。该部分负责从输入图像中提取多层次的特征信息,包括低级细节特征(如边缘、纹理等)和高级语义特征(如对象的形状和类别)。通常,Backbone使用深度卷积层和激活函数(如Swish)来增强特征的表达能力。通过这一设计,YOLOv5s能够更好地捕捉到目标在不同尺度和角度下的多样性,为后续的特征融合和目标检测提供了坚实的基础。

Neck部分是YOLOv5s中至关重要的组成部分,负责将来自Backbone的特征进行融合,以形成更为丰富的特征表达。YOLOv5s采用了PANet结构,该结构通过自上而下的路径聚合实现了多层特征的有效结合。具体而言,PANet通过对不同层次的特征进行上采样和下采样,增强了小目标的检测能力,并确保模型能够充分利用来自各个层次的信息。特征融合的过程使得YOLOv5s能够在保持高效性的同时,提升目标检测的准确性和鲁棒性。这种多尺度特征融合的设计使得网络能够更有效地处理复杂的场景和多样化的目标,确保在各种应用场景下的高性能表现。

YOLOv5s的Head部分负责将经过特征融合的多尺度特征进行处理,从而实现最终的目标检测任务。该部分采用了单一的卷积层结构,对来自Neck的特征进行处理,输出不同尺度下的检测结果,包括目标的类别、边框回归和置信度预测。在这一部分,YOLOv5s引入了Focal Loss作为损失函数,以解决正负样本不平衡的问题,从而提高模型在难以检测目标(如小目标或被遮挡目标)上的性能。Focal Loss通过对难以分类的样本给予更高的权重,从而引导模型更有效地学习。

YOLOv5s算法具备高效的实时检测能力,能够快速处理图像并准确识别多种植物和花卉,适应于快速变化的环境。多尺度特征融合网络结构使得其在小目标和复杂背景下表现出色,能够有效区分相似种类的植物,提升识别准确率。

三、检测的实现

3.1 数据集

图像采集专业相机或手机,在自然环境中拍摄各种鲜花和绿植,以确保获取丰富的样本数据,涵盖不同的光照、角度和背景;并通过互联网采集,利用开放的植物图像数据库和相关网站获取高质量的植物图片。这种多样化的采集方式确保了数据集的全面性和代表性,使模型能够学习到不同种类植物在多样化环境中的特征。使用了LabelImg对采集到的图像进行标注。在这个过程中,将每张图像中的鲜花和绿植用边界框标识出来,并为每个植物样本分配相应的类别标签(如玫瑰、向日葵、绿萝等)。

将数据集划分为训练集、验证集和测试集,通常按70%-20%-10%的比例进行划分,以确保模型在训练和评估时能够得到足够的样本。为了增强模型的泛化能力采用了数据扩展技术,包括随机旋转、平移、缩放、翻转和颜色变换等操作。这些数据扩展方法能够有效增加样本的多样性,使得模型在面对实际应用时具有更强的适应性。

3.2 实验环境搭建

深度学习框架为构建、训练、优化和推理深度神经网络提供了必要的基础工具,使开发者能够更高效地进行相关工作。这些框架不仅简化了复杂的计算过程,还提供了丰富的功能和灵活的接口,帮助开发者快速实现各种深度学习算法。在众多深度学习框架中,PyTorch因其高度的扩展性和可移植性而受到广泛欢迎,尤其在学术研究和工业应用中表现出色。它的动态计算图特性使得模型的调试和修改变得更加直观和方便,PyTorch拥有一个活跃的开发者社区,提供了大量的资源和支持,极大地推动了深度学习的研究和应用。

3.3 实验及结果分析

通过图像采集和标注,我们获得了包含各种鲜花和绿植的图像及其对应的标签。数据集通常会划分为训练集、验证集和测试集,确保模型在训练和评估时都能得到充分的样本。数据扩展技术(如随机旋转、缩放、翻转和颜色变换)可用于增加样本的多样性,以提升模型的泛化能力。

# 示例:使用数据增强技术

from torchvision import transforms

data_transforms = transforms.Compose([

transforms.RandomHorizontalFlip(),

transforms.RandomRotation(10),

transforms.ColorJitter(brightness=0.2, contrast=0.2, saturation=0.2, hue=0.2),

transforms.Resize((256, 256)),

transforms.ToTensor(),

])选择YOLOv5s作为目标检测模型,并结合卷积神经网络(CNN)进行特征提取。YOLOv5s作为一种高效的单阶段目标检测算法,能够实现快速且准确的目标识别。根据数据集的特征修改网络结构,以适应鲜花与绿植识别的需求。将准备好的训练数据输入到YOLOv5s模型中进行训练。使用合适的优化器(如Adam或SGD)和损失函数(如交叉熵损失或Focal Loss),监控训练过程中的损失值和准确率,以确保模型的有效收敛。通常,训练过程会设置多个epoch,以便模型能够充分学习数据中的特征。

import torch

import torch.nn as nn

import torch.optim as optim

from torchvision import transforms, datasets

from torch.utils.data import DataLoader

train_dataset = datasets.ImageFolder(root='path/to/train_data', transform=data_transforms)

train_loader = DataLoader(train_dataset, batch_size=16, shuffle=True)

model = torch.hub.load('ultralytics/yolov5', 'yolov5s', pretrained=True)

optimizer = optim.Adam(model.parameters(), lr=0.001) # Adam优化器

criterion = nn.CrossEntropyLoss() # 交叉熵损失

# 如果使用Focal Loss,请确保已经实现或导入 Focal Loss 类

num_epochs = 50

for epoch in range(num_epochs):

model.train() # 设置模型为训练模式

running_loss = 0.0

correct = 0

for images, targets in train_loader:

images, targets = images.to(device), targets.to(device) # 移动到GPU(如果可用)

# 前向传播

outputs = model(images)

# 计算损失

loss = criterion(outputs, targets)

# 反向传播和优化

optimizer.zero_grad()

loss.backward()

optimizer.step()

running_loss += loss.item()

# 计算准确率

_, preds = torch.max(outputs, 1)

correct += (preds == targets).sum().item()

epoch_loss = running_loss / len(train_loader)

accuracy = correct / len(train_loader.dataset)

print(f'Epoch [{epoch+1}/{num_epochs}], Loss: {epoch_loss:.4f}, Accuracy: {accuracy:.4f}')

print("训练完成!")通过在验证集上进行推理,计算模型的精度、召回率和F1-score等指标,以评估模型的性能。可以使用混淆矩阵可视化模型的检测效果,观察模型在不同类别上的表现。这一过程可以帮助识别模型的不足之处,并为后续的优化提供依据。可以将模型集成到鲜花与绿植识别系统中,实时分析来自监控设备或移动应用的图像,自动识别并定位植物种类。

import torch

from sklearn.metrics import precision_score, recall_score, f1_score, confusion_matrix

import seaborn as sns

import matplotlib.pyplot as plt

import numpy as np

model.eval()

precision = precision_score(all_targets, all_preds, average='weighted')

recall = recall_score(all_targets, all_preds, average='weighted')

f1 = f1_score(all_targets, all_preds, average='weighted')

print(f'Precision: {precision:.4f}, Recall: {recall:.4f}, F1-Score: {f1:.4f}')

conf_matrix = confusion_matrix(all_targets, all_preds)

plt.figure(figsize=(10, 7))

sns.heatmap(conf_matrix, annot=True, fmt='d', cmap='Blues', xticklabels=validation_dataset.classes, yticklabels=validation_dataset.classes)

plt.ylabel('True Label')

plt.xlabel('Predicted Label')

plt.title('Confusion Matrix')

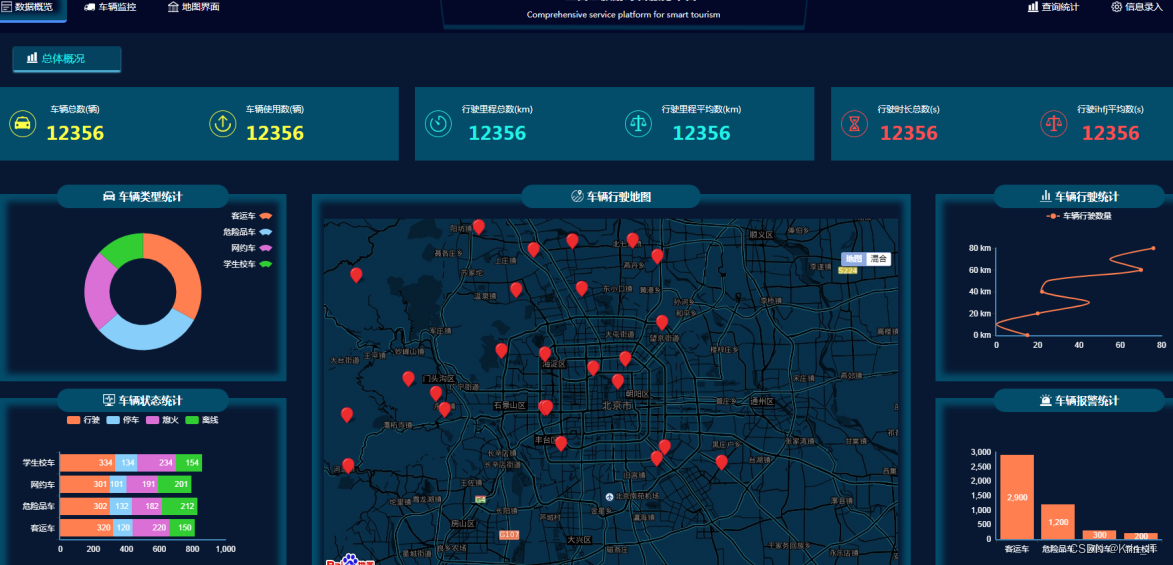

plt.show()实现效果图样例:

创作不易,欢迎点赞、关注、收藏。

毕设帮助,疑难解答,欢迎打扰!

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?