大家好,今天来聊聊英文论文怎么查重整个过程,希望能给大家提供一点参考。

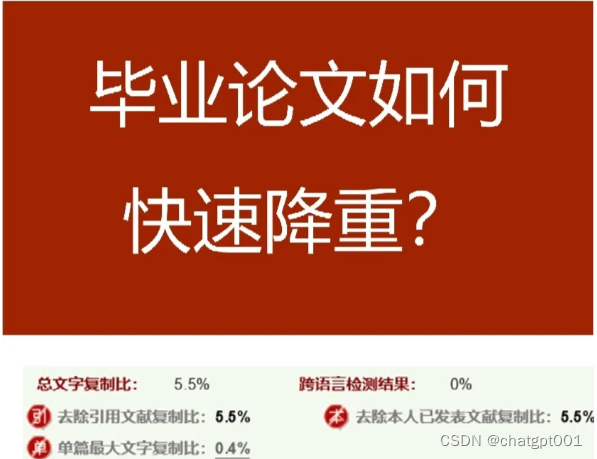

以下是针对论文重复率高的情况,提供一些修改建议和技巧,可以借助此类工具:

英文论文怎么查重整个过程

一、背景介绍

在学术界,论文查重是保证学术诚信的重要手段。对于英文论文来说,查重的过程更为复杂。由于语言和文化的差异,英文论文的查重率也往往较高。那么,英文论文怎么查重整个过程呢?本文将就此问题进行探讨。

二、选择合适的查重工具

- 使用专业的英文查重软件:与中文论文查重相比,英文论文查重需要使用专业的英文查重软件。这些软件通常基于大规模语料库,能够准确识别英文文本中的重复内容。

- 考虑查重软件的准确性:选择英文查重软件时,我们需要考虑其准确性。一些优质的英文查重软件能够提供高精度的查重报告,并指出重复的内容来源。

- 比较不同软件的性能:在选择英文查重软件时,我们需要比较不同软件的性能。可以通过对比软件的查重率、误报率以及用户评价等因素来做出决策。

三、英文论文查重的步骤

- 准备论文:首先需要准备好要进行查重的英文论文。

- 选择查重工具:根据需求选择适合的英文查重软件。

- 上传论文:将英文论文上传至选择的查重软件中。

- 等待查重结果:等待查重软件进行查重,生成查重报告。

- 分析查重结果:查看查重报告,分析英文论文的重复情况。

- 进行修改:根据查重报告中的提示,对英文论文进行相应的修改和调整。

- 再次查重:完成修改后,再次使用查重软件进行查重,以确保重复率降低。

- 完成论文:当重复率符合要求后,完成英文论文的撰写。

四、降低英文论文的查重率的方法

- 引用规范:合理引用他人的研究成果是降低英文论文查重率的关键之一。在撰写英文论文时,需要使用规范的引用格式,并详细注明引用来源。

- 词汇变化:尽量避免直接复制粘贴是降低英文论文查重率的另一种方法。可以通过使用同义词、短语或重新组织句子的方式来避免重复。

- 使用自己的语言表述:用自己的语言表述可以有效地降低英文论文的查重率。在撰写英文论文时,尽量避免直接引用原文,而是用自己的语言重新表述。

- 增加文献量:在允许的范围内,增加参考文献的数量可以降低英文论文的查重率。这可以通过引用更多与主题相关的文献来实现。

- 避免过度借鉴:在撰写英文论文时,应尽量避免过度借鉴他人的研究成果。这可以通过增加原创性内容、提出新的观点或进行实验研究等方式来实现。

五、总结

英文论文的查重过程需要更加谨慎和细致。选择合适的英文查重软件是第一步,然后需要采取一系列措施来降低英文论文的查重率。这些措施包括规范引用、使用自己的语言表述、增加文献量以及避免过度借鉴等。通过这些方法,我们可以有效地降低英文论文的查重率,并确保学术诚信。

英文论文怎么查重整个过程相关文章:

1010

1010

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?