目录

一、服务器

服务器的英文名称为“ Server”,是指在网络上提供各种服务的高性能计算机。

- 作为网络的节点,存储、处理网络上80%的数据、信息,因此也被称为网络的灵魂。

服务器和普通计算机的功能是类似的。

- 只是相对于普通计算机,服务器在稳定性、安全性、性能等方面都要求更高,因此CPU、芯片组、内存、磁盘系统、网络等硬件和普通计算机有所不同。

服务器与普通计算机的主要区别

通信方式为一对多

资源通过网络共享

硬件性能更加强大

服务器厂商会根据不同的应用场景,对服务器进行差异化设计,目前主要的应用场景包括文件交互、数据存储和查询、应用程序应答与运行等。

服务器的功能

服务器的逻辑架构

- 服务器的逻辑架构和普通计算机类似。但是由于需要提供高性能计算,因此在处理能力、稳定性、可靠性、安全性、可扩展性、可管理性等方面要求较高。服务器的逻辑架构中,最重要的部分是CPU和内存。CPU对数据进行逻辑运算,内存进行数据存储管理。

服务器的分类

服务器按产品形态,分为:塔式服务器、机架服务器、刀片服务器、机柜服务器等。

塔式服务器( Tower Server)

机架式服务器(Rack Server)

刀片式服务器(Blade Server)

机柜式服务器(Cabinet Server)

二.RAID磁盘阵列

RAID磁盘阵列介绍

- 是Redundant Array of Independent Disks的缩写,中文简称为独立冗余磁盘阵列把多块独立的物理硬盘按不同的方式组合起来形成一个硬盘组(逻辑硬盘),从而提供比单个硬盘更高的存储性能和提供数据备份技术

- 组成磁盘阵列的不同方式称为RAID级别(RAIDLevels)常用的RAID级别

- ®RAIDO,RAID1,RAID5,RAID6,RAID1+0等

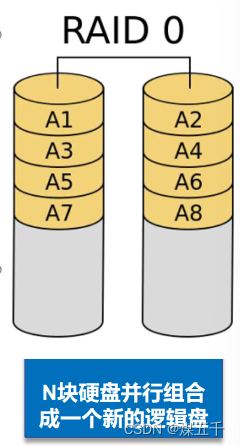

RAID 0 磁盘阵列介绍

- RAID0(条带化存储)

- RAID 0连续以位或字节为单位分割数据,并行读/写于多个磁盘上,因此具有很高的数据传输率,但它没有数据冗余

- RAID 0只是单纯地提高性能,并没有为数据的可靠性提供保证,而且其中的一个磁盘失效将影响到所有数据

- RAID 0不能应用于数据安全性要求高的场合

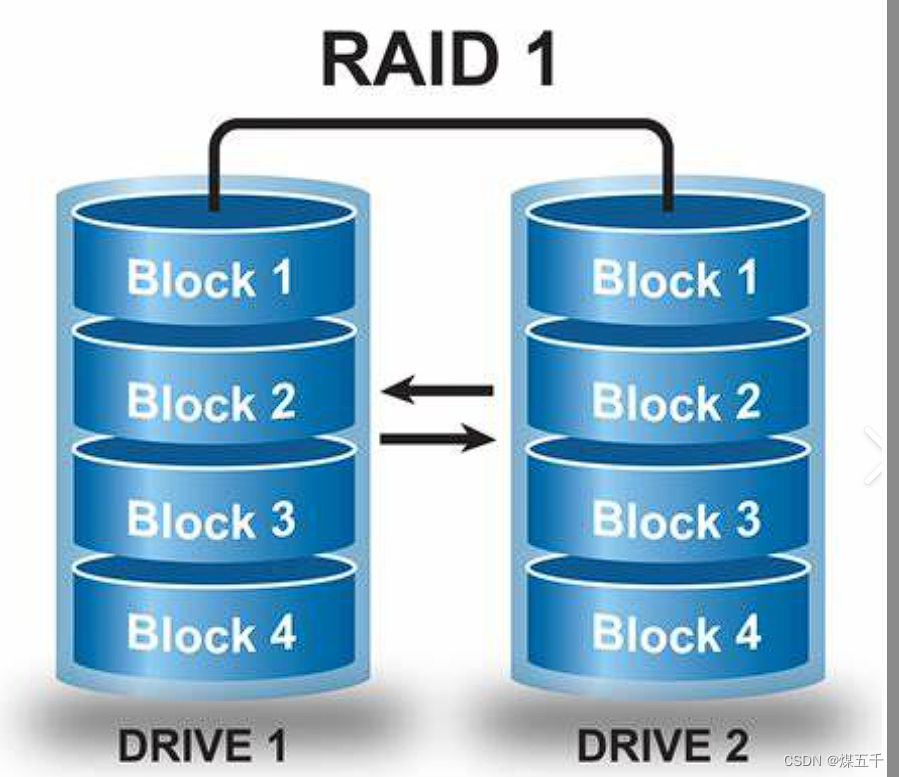

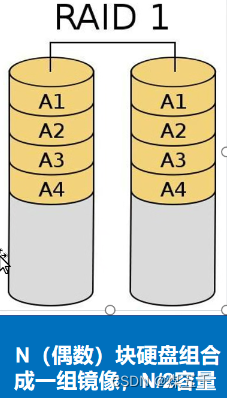

RAID 1磁盘阵列介绍

- RAID 1(镜像存储)

- 通过磁盘数据镜像实现数据冗余,在成对的独立磁盘上产生互为备份的数据

- 当原始数据繁忙时,可直接从镜像拷贝中读取数据,因此RAID 1可以提高读取性能

- RAID 1是磁盘阵列中单位成本最高的但提供了很高的数据安全性和可用性。当一个磁盘失效时,系统可以自动切换到镜像磁盘上读写,而不需要重组失效的数据

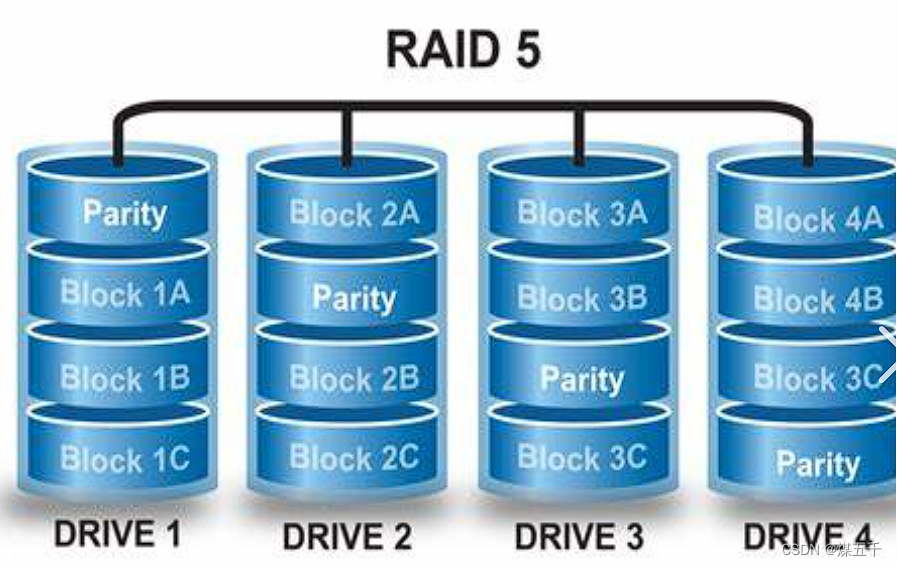

RAID 5磁盘阵列介绍

- RAID 5

- N(N>=3)块盘组成阵列,一份数据产生N-1个条带,同时还有1份校验数据共N份数据在N块盘上循环均衡存储

- N块盘同时读写,读性能很高,但由于有校验机制的问题,写性能相对不高(多写一份纠删码)

- (N-1)/N磁盘利用率

- 可靠性高,允许坏1块盘,不影响所有数据

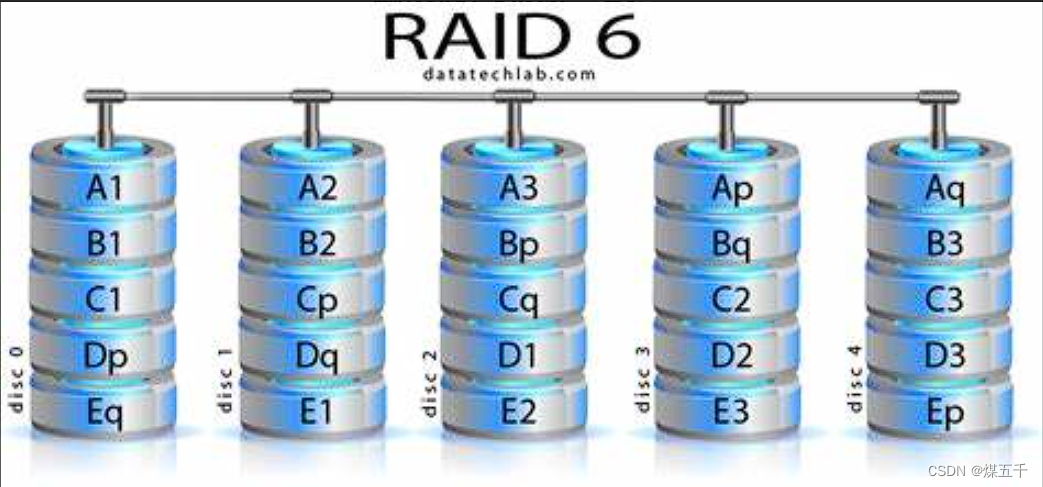

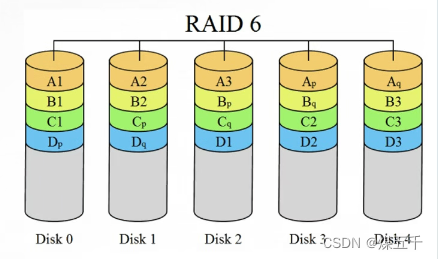

RAID 6磁盘陈列介绍

- RAID 6

- N (N>=4)块盘组成阵列,(N-2)/N磁盘利用率.

- 与RAID 5相比,RAID 6增加了第二个独立的奇偶校验信息块.(多写俩份纠删码)

- 两个独立的奇偶系统使用不同的算法,即使两块磁盘同时失效也不会影响数据的使用.

- 相对于RAID 5有更大的“写损失”,因此写性能较差.

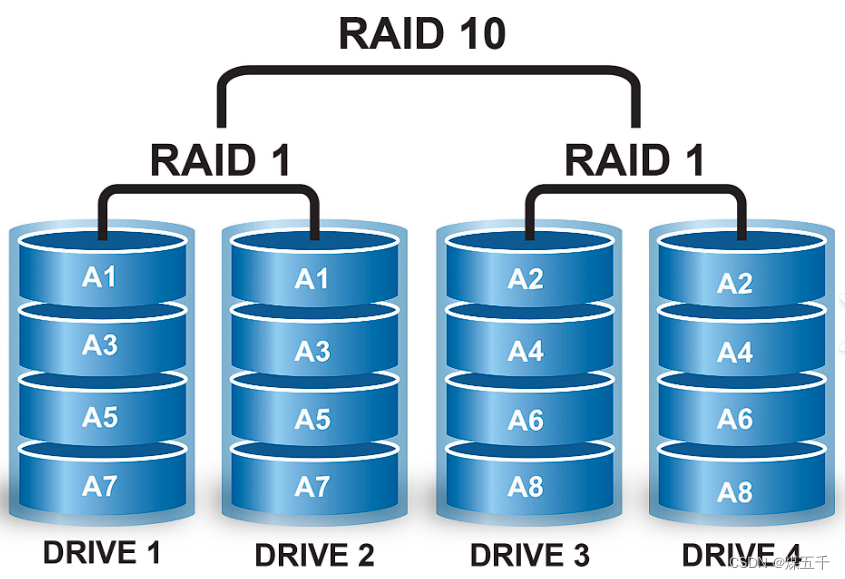

RAID 1+0磁盘阵列介绍

RAID 1+0((先做镜象,再做条带)

● N(偶数,N>=4)块盘两两镜像后,再组合成一个RAID 0.

● N/2磁盘利用率.

● N/2块盘同时写入,N块盘同时读取.

● 性能高,可靠性高.

● 故障率为1/3.

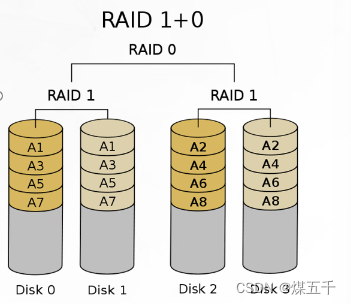

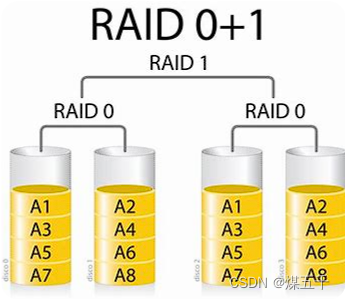

RAID 0+1 (先做条带,再做镜象)

● 读写性能与RAID 10相同.

● 安全性低于RAID 10.

● 故障率为2/3.

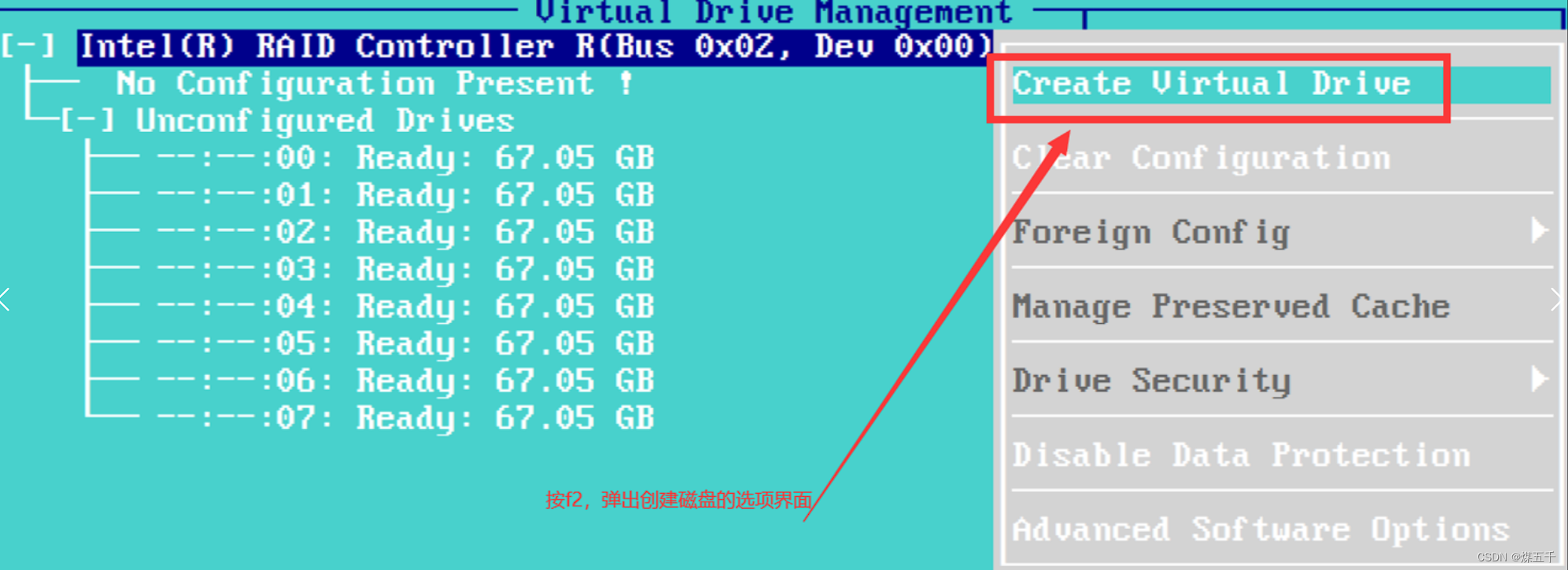

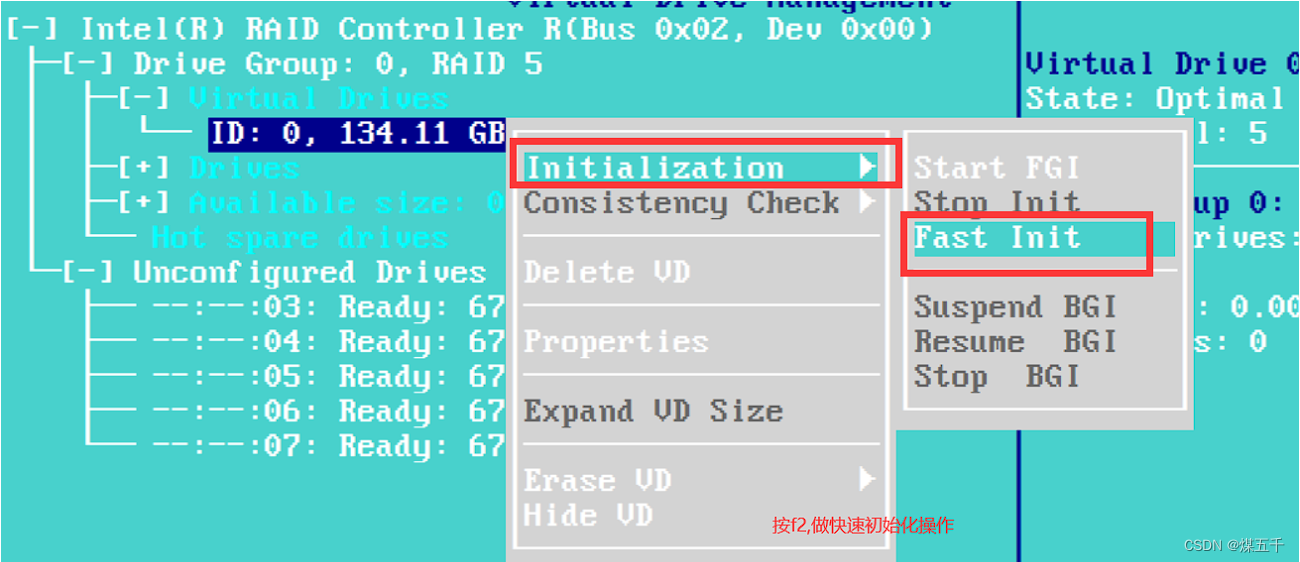

三.硬RAID创建磁盘阵列

(1)创建磁盘

(2)快速初始化操作;

(3)做热备份盘;

四.软RAID创建磁盘阵列

实例:软创建RAID5

(1)检查是否已安装mdadm 软件包

[root@clr ~]# rpm -q mdadm #查看是否已安装mdadm安装包

[root@clr ~]# yum install -y mdadm

[root@clr ~]# echo "- - -" > /sys/class/scsi_host/host0/scan #在线刷新启动硬盘

[root@clr ~]# echo "- - -" > /sys/class/scsi_host/host1/scan

[root@clr ~]# echo "- - -" > /sys/class/scsi_host/host2/scan(2)使用fdisk工具将新磁盘设备/dev/sdb、/dev/sdc、/dev/sdd、/dev/sde划分出主分区sdb1、sdc1、sdd1、sde1,并且把分区类型的ID标记号改为“fd”

[root@clr ~]# fdisk /dev/sdb

[root@clr ~]# fdisk /dev/sdc

[root@clr ~]# fdisk /dev/sdd

[root@clr ~]# fdisk /dev/sde

[root@clr ~]# echo -e 'n\n\n\n\n\nt\nfd\nw\n' | fdisk /dev/sdc #免交互方式将磁盘分区

[root@clr ~]# lsblk #查看磁盘划分的分区情况

NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINT

sda 8:0 0 60G 0 disk

├─sda1 8:1 0 37G 0 part /

├─sda2 8:2 0 1K 0 part

└─sda5 8:5 0 3.9G 0 part [SWAP]

sdb 8:16 0 20G 0 disk

└─sdb1 8:17 0 20G 0 part

sdc 8:32 0 20G 0 disk

└─sdc1 8:33 0 20G 0 part

sdd 8:48 0 20G 0 disk

└─sdd1 8:49 0 20G 0 part

sde 8:64 0 20G 0 disk

└─sde1 8:65 0 20G 0 part

sr0 11:0 1 4.4G 0 rom /run/media/root/CentOS 7 x86_64

(3)创建RAID设备;

创建RAID5

mdadm -C -v /dev/md0 [-a yes] -l5 -n3 /dev/sd[bcd]1 -x1 /dev/sde1| 选项 | 功能作用 |

|---|---|

| -C | 表示新建 |

| -v | 显示创建过程中的详细信息 |

| /dev/md0 | 创建 RAID5 的名称 |

| -a yes | - -auto,表示如果有什么设备文件没有存在的话就自动创建,可省略 |

| -l(小写的英文l) | 指定 RAID 的级别,l5 表示创建 RAID5 |

| -n | 指定使用几块硬盘创建 RAID,n3 表示使用3块硬盘创建 RAID |

| /dev/sd[bcd]1 | 指定使用这3块磁盘分区去创建 RAID |

| -x | 指定使用几块硬盘做RAID的热备用盘,x1表示保留1块空闲的硬盘作备用 |

| /dev/sde1 | 指定用作于备用的磁盘 |

[root@clr ~]# mdadm -Cv /dev/md5 -l5 -n3 /dev/sd[bcd]1 -x1 /dev/sde1 #创建raid5并命名为md5

mdadm: layout defaults to left-symmetric

mdadm: layout defaults to left-symmetric

mdadm: chunk size defaults to 512K

mdadm: size set to 20953088K

mdadm: Defaulting to version 1.2 metadata

mdadm: array /dev/md5 started.

[root@clr ~]# mdadm -D /dev/md5 #查看创建过程

/dev/md5:

Version : 1.2

Creation Time : Thu Apr 6 21:52:16 2023

Raid Level : raid5

Array Size : 41906176 (39.96 GiB 42.91 GB)

Used Dev Size : 20953088 (19.98 GiB 21.46 GB)

Raid Devices : 3

Total Devices : 4

Persistence : Superblock is persistent

Update Time : Thu Apr 6 21:53:00 2023

State : clean, degraded, recovering

Active Devices : 2

Working Devices : 4

Failed Devices : 0

Spare Devices : 2

Layout : left-symmetric

Chunk Size : 512K

Consistency Policy : resync

Rebuild Status : 27% complete

Name : clr:5 (local to host clr)

UUID : 014f444a:a42f81ca:4c8554f3:4a66d44d

Events : 5

Number Major Minor RaidDevice State

0 8 17 0 active sync /dev/sdb1

1 8 33 1 active sync /dev/sdc1

4 8 49 2 spare rebuilding /dev/sdd1

3 8 65 - spare /dev/sde1

[root@clr ~]# cat /proc/mdstat #查看创建进程

Personalities : [raid6] [raid5] [raid4]

md5 : active raid5 sdd1[4] sde1[3](S) sdc1[1] sdb1[0]

41906176 blocks super 1.2 level 5, 512k chunk, algorithm 2 [3/2] [UU_]

[========>............] recovery = 43.7% (9167232/20953088) finish=1.6min speed=120373K/sec

unused devices: <none>

[root@clr ~]# watch -n 5 'cat /proc/mdstat' #每5秒钟监听一次,创建的过程

mdadm -E [分区设备名]:检查某个指定分区设备,是否做过raid

[root@clr ~]# mdadm -E /dev/sdb1 #检查某个指定分区设备,是否做过raid

/dev/sdb1:

Magic : a92b4efc

Version : 1.2

Feature Map : 0x0

Array UUID : 014f444a:a42f81ca:4c8554f3:4a66d44d

Name : clr:5 (local to host clr)

Creation Time : Thu Apr 6 21:52:16 2023

Raid Level : raid5 #用于做raid5的磁盘阵列

Raid Devices : 3

Avail Dev Size : 41906176 sectors (19.98 GiB 21.46 GB)

Array Size : 41906176 KiB (39.96 GiB 42.91 GB)

Data Offset : 34816 sectors

Super Offset : 8 sectors

Unused Space : before=34664 sectors, after=0 sectors

State : clean

Device UUID : dff29ecc:4942ac37:a22d145f:a18c8b44

Update Time : Thu Apr 6 21:55:16 2023

Bad Block Log : 512 entries available at offset 136 sectors

Checksum : aedc2043 - correct

Events : 18

Layout : left-symmetric

Chunk Size : 512K

Device Role : Active device 0

Array State : AAA ('A' == active, '.' == missing, 'R' == replacing)

查看RAID磁盘详细信息

cat /proc/mdstat :还能查看创建RAID的进度

mdadm -D /dev/md0

用watch命令来每隔一段时间刷新 /proc/mdstat 的输出

watch -n 10 ‘cat /proc/mdstat’

检查磁盘是否已做RAID

mdadm -E /dev/sd[b-e]1

(4)创建并挂载文件系统

[root@clr ~]# mkfs -t xfs /dev/md5 #将分区/dev/md5格式化为xfs类型

meta-data=/dev/md5 isize=512 agcount=16, agsize=654720 blks

= sectsz=512 attr=2, projid32bit=1

= crc=1 finobt=0, sparse=0

data = bsize=4096 blocks=10475520, imaxpct=25

= sunit=128 swidth=256 blks

naming =version 2 bsize=4096 ascii-ci=0 ftype=1

log =internal log bsize=4096 blocks=5120, version=2

= sectsz=512 sunit=8 blks, lazy-count=1

realtime =none extsz=4096 blocks=0, rtextents=0

[root@clr ~]# mkdir /data

[root@clr ~]# mount /dev/md5 /data #将/dev/md5挂载到/data目录下

[root@clr ~]# df -hT

文件系统 类型 容量 已用 可用 已用% 挂载点

devtmpfs devtmpfs 2.0G 0 2.0G 0% /dev

tmpfs tmpfs 2.0G 0 2.0G 0% /dev/shm

tmpfs tmpfs 2.0G 13M 2.0G 1% /run

tmpfs tmpfs 2.0G 0 2.0G 0% /sys/fs/cgroup

/dev/sda1 xfs 38G 5.4G 32G 15% /

tmpfs tmpfs 394M 32K 394M 1% /run/user/0

/dev/sr0 iso9660 4.4G 4.4G 0 100% /run/media/root/CentOS 7 x86_64

/dev/md5 xfs 40G 33M 40G 1% /data #挂载成功

(5)实现故障恢复

[root@clr ~]# mdadm /dev/md5 -f /dev/sdb1 #模拟raid5中的/dev/sdb1出现故障

mdadm: set /dev/sdb1 faulty in /dev/md5

[root@clr ~]# mdadm -D /dev/md5

/dev/md5:

Version : 1.2

Creation Time : Thu Apr 6 21:52:16 2023

Raid Level : raid5

Array Size : 41906176 (39.96 GiB 42.91 GB)

Used Dev Size : 20953088 (19.98 GiB 21.46 GB)

Raid Devices : 3

Total Devices : 4

Persistence : Superblock is persistent

Update Time : Thu Apr 6 22:11:14 2023

State : clean, degraded, recovering

Active Devices : 2

Working Devices : 3

Failed Devices : 1

Spare Devices : 1

Layout : left-symmetric

Chunk Size : 512K

Consistency Policy : resync

Rebuild Status : 9% complete #正在重新创建磁盘阵列

Name : clr:5 (local to host clr)

UUID : 014f444a:a42f81ca:4c8554f3:4a66d44d

Events : 21

Number Major Minor RaidDevice State

3 8 65 0 spare rebuilding /dev/sde1

1 8 33 1 active sync /dev/sdc1

4 8 49 2 active sync /dev/sdd1

0 8 17 - faulty /dev/sdb1

[root@clr ~]# cat /proc/mdstat #查看创建进度

Personalities : [raid6] [raid5] [raid4]

md5 : active raid5 sdd1[4] sde1[3] sdc1[1] sdb1[0](F)

41906176 blocks super 1.2 level 5, 512k chunk, algorithm 2 [3/2] [_UU]

[============>........] recovery = 63.8% (13387776/20953088) finish=1.0min speed=125660K/sec

unused devices: <none>

[root@clr ~]# mdadm /dev/md5 -r /dev/sdb1 #将出现故障的坏盘/dev/sdb1移除磁盘阵列

mdadm: hot removed /dev/sdb1 from /dev/md5

[root@clr ~]# mdadm -D /dev/md5

/dev/md5:

Version : 1.2

Creation Time : Thu Apr 6 21:52:16 2023

Raid Level : raid5

Array Size : 41906176 (39.96 GiB 42.91 GB)

Used Dev Size : 20953088 (19.98 GiB 21.46 GB)

Raid Devices : 3

Total Devices : 3

Persistence : Superblock is persistent

Update Time : Thu Apr 6 22:14:02 2023

State : clean

Active Devices : 3

Working Devices : 3

Failed Devices : 0

Spare Devices : 0

Layout : left-symmetric

Chunk Size : 512K

Consistency Policy : resync

Name : clr:5 (local to host clr)

UUID : 014f444a:a42f81ca:4c8554f3:4a66d44d

Events : 38

Number Major Minor RaidDevice State

3 8 65 0 active sync /dev/sde1

1 8 33 1 active sync /dev/sdc1

4 8 49 2 active sync /dev/sdd1

[root@clr ~]# mdadm /dev/md5 -a /dev/sdb1 #将分区/dev/sdb1再次放回磁盘阵列

mdadm: added /dev/sdb1

[root@clr ~]# mdadm -D /dev/md5

/dev/md5:

Version : 1.2

Creation Time : Thu Apr 6 21:52:16 2023

Raid Level : raid5

Array Size : 41906176 (39.96 GiB 42.91 GB)

Used Dev Size : 20953088 (19.98 GiB 21.46 GB)

Raid Devices : 3

Total Devices : 4

Persistence : Superblock is persistent

Update Time : Thu Apr 6 22:14:28 2023

State : clean

Active Devices : 3

Working Devices : 4

Failed Devices : 0

Spare Devices : 1

Layout : left-symmetric

Chunk Size : 512K

Consistency Policy : resync

Name : clr:5 (local to host clr)

UUID : 014f444a:a42f81ca:4c8554f3:4a66d44d

Events : 39

Number Major Minor RaidDevice State

3 8 65 0 active sync /dev/sde1

1 8 33 1 active sync /dev/sdc1

4 8 49 2 active sync /dev/sdd1

5 8 17 - spare /dev/sdb1 #作为备份盘

mdadm命令其它常用选项

| 常用选项 | 功能作用 |

|---|---|

| -r | 移除设备 |

| -a | 添加设备 |

| -S | 停止RAID |

| -A | 启动RAID |

(6)创建 /etc/mdadm.conf 配置文件,方便管理软RAID的配置,比如启动、停止

[root@clr ~]# cd /data

[root@clr ~]# umount /data #先解挂载

[root@clr ~]# vim /etc/mdadm.conf

DEVICE /dev/sdb1 /dev/sdc1 /dev/sdd1 /dev/sde1

[root@clr /data]# mdadm --detail --scan >> /etc/mdadm.conf #从/etc/mdadm.conf这个配置文件中,详细扫描磁盘文件信息

[root@clr /data]# cat /etc/mdadm.conf

DEVICE /dev/sdb1 /dev/sdc1 /dev/sdd1 /dev/sde1

ARRAY /dev/md5 metadata=1.2 spares=1 name=clr:5 UUID=014f444a:a42f81ca:4c8554f3:4a66d44d

[root@clr /data]# mdadm -S /dev/md5 #停止raid5

mdadm: stopped /dev/md5

[root@clr /data]# ls /dev/md5

ls: 无法访问/dev/md5: 没有那个文件或目录

[root@clr /data]# mdadm -A -s /dev/md5 #再次启动raid5

mdadm: /dev/md5 has been started with 3 drives and 1 spare.

[root@clr /data]# ls /dev/md5

/dev/md5 #用于启动设备的配置文件

1027

1027

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?