网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

table.toAppendStream[(String,String)]

2.2 字段

用一个单引放到字段前面来标识字段名, 如 ‘name , ‘mid ,’amount 等

三、Table API 的窗口聚合操作

3.1 通过一个例子了解Table API

//每 10 秒中渠道为 appstore 的个数

def main(args: Array[String]): Unit = {

//sparkcontext

val env: StreamExecutionEnvironment =

StreamExecutionEnvironment.getExecutionEnvironment

//时间特性改为 eventTime

env.setStreamTimeCharacteristic(TimeCharacteristic.EventTime)

val myKafkaConsumer: FlinkKafkaConsumer011[String] =

MyKafkaUtil.getConsumer("ECOMMERCE")

val dstream: DataStream[String] = env.addSource(myKafkaConsumer)

val ecommerceLogDstream: DataStream[EcommerceLog] = dstream.map{ jsonString

=>JSON.parseObject(jsonString,classOf[EcommerceLog]) }

//告知 watermark 和 eventTime 如何提取

val ecommerceLogWithEventTimeDStream: DataStream[EcommerceLog] =

ecommerceLogDstream.assignTimestampsAndWatermarks(new

BoundedOutOfOrdernessTimestampExtractor[EcommerceLog](Time.seconds(0L)) {

override def extractTimestamp(element: EcommerceLog): Long = {

element.ts

}

}).setParallelism(1)

val tableEnv: StreamTableEnvironment =

TableEnvironment.getTableEnvironment(env)

//把数据流转化成 Table

val ecommerceTable: Table =

tableEnv.fromDataStream(ecommerceLogWithEventTimeDStream ,

'mid,'uid,'appid,'area,'os,'ch,'logType,'vs,'logDate,'logHour,'logHourMinute,'ts.rowtime)

//通过 table api 进行操作

// 每 10 秒 统计一次各个渠道的个数 table api 解决

//1 groupby 2 要用 window 3 用 eventtime 来确定开窗时间

val resultTable: Table = ecommerceTable.

window(Tumble over 10000.millis on 'ts as 'tt).groupBy('ch,'tt ).select( 'ch, 'ch.count)

//把 Table 转化成数据流

val resultDstream: DataStream[(Boolean, (String, Long))] = resultSQLTable.toRetractStream[(String,Long)]

resultDstream.filter(_._1).print()

env.execute()

}

3.2 关于group by

- 如果了使用 groupby,table 转换为流的时候只能用 toRetractDstream

val rDstream: DataStream[(Boolean, (String, Long))] = table

.toRetractStream[(String,Long)]

- toRetractDstream 得到的第一个 boolean 型字段标识 true 就是最新的数据(Insert),false 表示过期老数据(Delete)

val rDstream: DataStream[(Boolean, (String, Long))] = table

.toRetractStream[(String,Long)]

rDstream.filter(_._1).print()

- 如果使用的 api 包括时间窗口,那么窗口的字段必须出现在 groupBy 中。

val table: Table = ecommerceLogTable

.filter("ch ='appstore'")

.window(Tumble over 10000.millis on 'ts as 'tt)

.groupBy('ch ,'tt)

.select("ch,ch.count ")

3.3 关于时间窗口

- 用到时间窗口,必须提前声明时间字段,如果是 processTime 直接在创建动态表时进行追加就可以。

val ecommerceLogTable: Table = tableEnv

.fromDataStream( ecommerceLogWithEtDstream,

'mid,'uid,'appid,'area,'os,'ch,'logType,'vs,'logDate,'logHour,'logHourMinute,'ps.proctime)

- 如果是 EventTime 要在创建动态表时声明

val ecommerceLogTable: Table = tableEnv

.fromDataStream(ecommerceLogWithEtDstream,

'mid,'uid,'appid,'area,'os,'ch,'logType,'vs,'logDate,'logHour,'logHourMinute,'ts.rowtime)

- 滚动窗口可以使用 Tumble over 10000.millis on 来表示

val table: Table = ecommerceLogTable.filter("ch ='appstore'")

.window(Tumble over 10000.millis on 'ts as 'tt)

.groupBy('ch ,'tt)

.select("ch,ch.count ")

四、SQL 如何编写

def main(args: Array[String]): Unit = {

//sparkcontext

val env: StreamExecutionEnvironment =

StreamExecutionEnvironment.getExecutionEnvironment

//时间特性改为 eventTime

env.setStreamTimeCharacteristic(TimeCharacteristic.EventTime)

val myKafkaConsumer: FlinkKafkaConsumer011[String] =

MyKafkaUtil.getConsumer("ECOMMERCE")

val dstream: DataStream[String] = env.addSource(myKafkaConsumer)

val ecommerceLogDstream: DataStream[EcommerceLog] = dstream.map{ jsonString

=>JSON.parseObject(jsonString,classOf[EcommerceLog]) }

//告知 watermark 和 eventTime 如何提取

val ecommerceLogWithEventTimeDStream: DataStream[EcommerceLog] =

ecommerceLogDstream.assignTimestampsAndWatermarks(new

BoundedOutOfOrdernessTimestampExtractor[EcommerceLog](Time.seconds(0L)) {

override def extractTimestamp(element: EcommerceLog): Long = {

element.ts

}

}).setParallelism(1)

//SparkSession

val tableEnv: StreamTableEnvironment =

TableEnvironment.getTableEnvironment(env)

//把数据流转化成 Table

val ecommerceTable: Table =

tableEnv.fromDataStream(ecommerceLogWithEventTimeDStream ,

'mid,'uid,'appid,'area,'os,'ch,'logType,'vs,'logDate,'logHour,'logHourMinute,'ts.rowtime)

//通过 table api 进行操作

// 每 10 秒 统计一次各个渠道的个数 table api 解决

//1 groupby 2 要用 window 3 用 eventtime 来确定开窗时间

val resultTable: Table = ecommerceTable

.window(Tumble over 10000.millis on 'ts as 'tt)

.groupBy('ch,'tt )

.select( 'ch, 'ch.count)

// 通过 sql 进行操作

val resultSQLTable : Table = tableEnv.sqlQuery( "select ch ,count(ch) from

"+ecommerceTable+" group by ch ,Tumble(ts,interval '10' SECOND )")

**网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。**

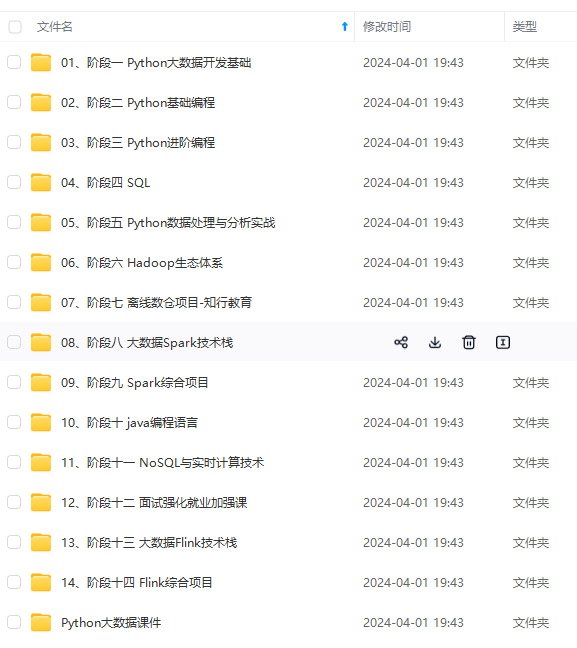

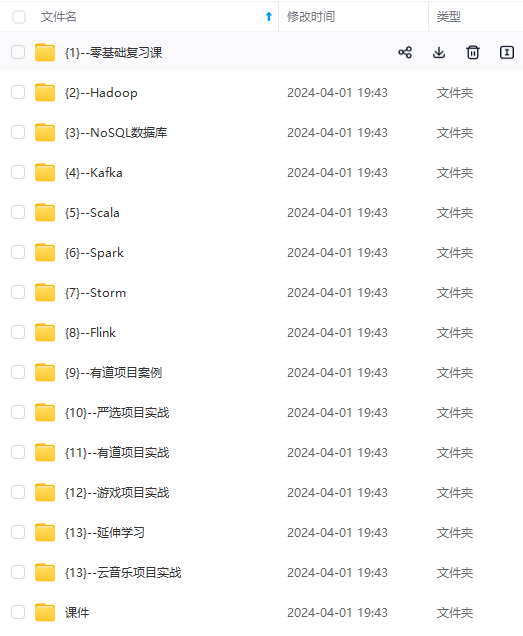

**[需要这份系统化资料的朋友,可以戳这里获取](https://bbs.csdn.net/topics/618545628)**

**一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!**

体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。**

**[需要这份系统化资料的朋友,可以戳这里获取](https://bbs.csdn.net/topics/618545628)**

**一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!**

本文讨论了在线学习资料的重要性,强调了系统化的学习对于技术提升的必要性。并通过Flink的TableAPI示例,展示了如何使用时间窗口(如Tumble)和SQL查询来进行数据处理,提倡加入技术社区,共同学习和成长。

本文讨论了在线学习资料的重要性,强调了系统化的学习对于技术提升的必要性。并通过Flink的TableAPI示例,展示了如何使用时间窗口(如Tumble)和SQL查询来进行数据处理,提倡加入技术社区,共同学习和成长。

277

277

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?