还有兄弟不知道网络安全面试可以提前刷题吗?费时一周整理的160+网络安全面试题,金九银十,做网络安全面试里的显眼包!

王岚嵚工程师面试题(附答案),只能帮兄弟们到这儿了!如果你能答对70%,找一个安全工作,问题不大。

对于有1-3年工作经验,想要跳槽的朋友来说,也是很好的温习资料!

【完整版领取方式在文末!!】

93道网络安全面试题

内容实在太多,不一一截图了

黑客学习资源推荐

最后给大家分享一份全套的网络安全学习资料,给那些想学习 网络安全的小伙伴们一点帮助!

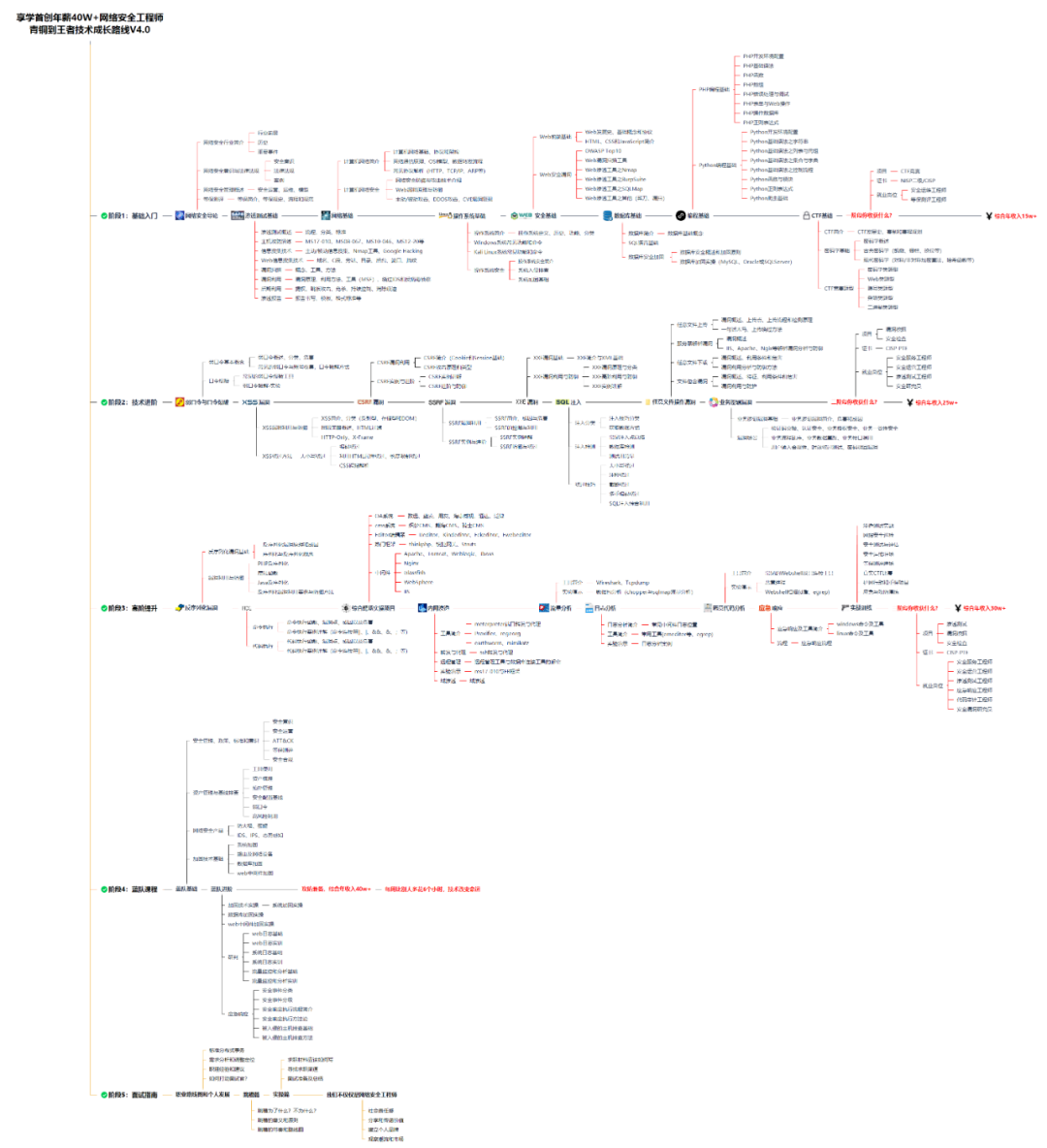

对于从来没有接触过网络安全的同学,我们帮你准备了详细的学习成长路线图。可以说是最科学最系统的学习路线,大家跟着这个大的方向学习准没问题。

1️⃣零基础入门

① 学习路线

对于从来没有接触过网络安全的同学,我们帮你准备了详细的学习成长路线图。可以说是最科学最系统的学习路线,大家跟着这个大的方向学习准没问题。

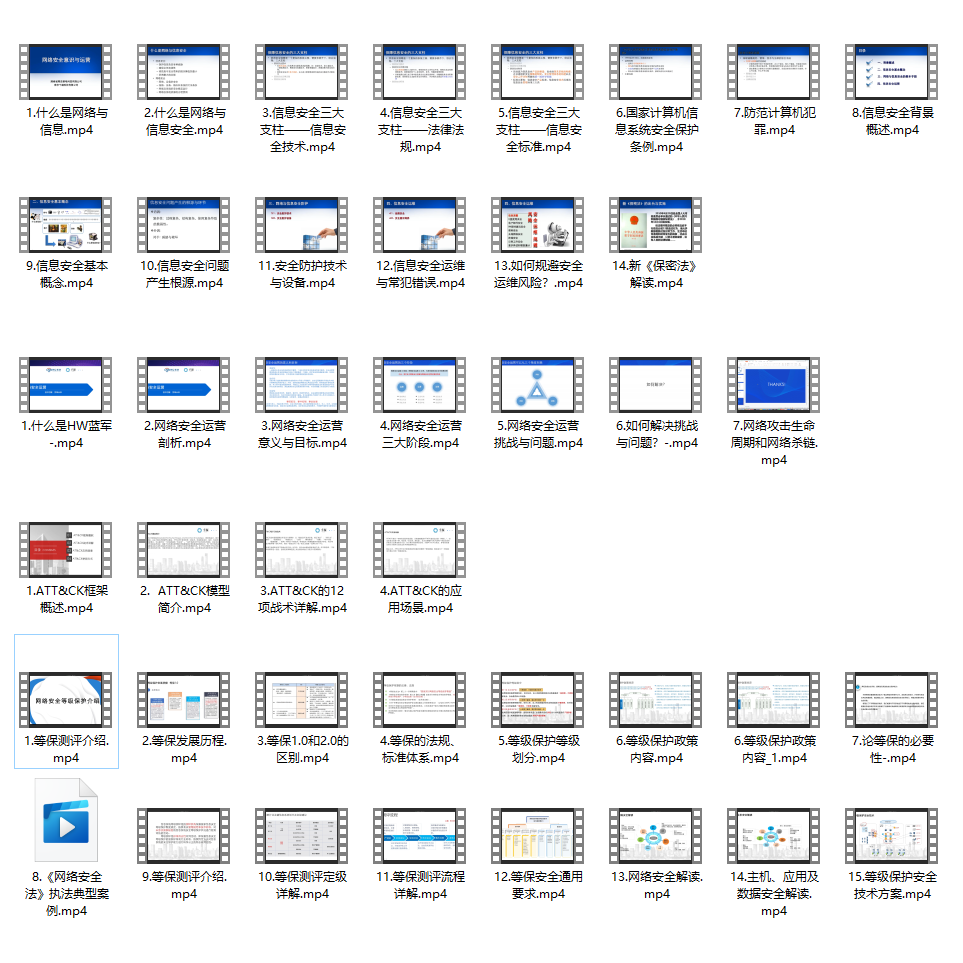

② 路线对应学习视频

同时每个成长路线对应的板块都有配套的视频提供:

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

4

\begin{array}{llll}\alpha_{0}^{1} & \alpha_{0}^{2} & \alpha_{0}^{3} & \alpha_{0}^{4}\end{array}

α01α02α03α04,再经过一层softmax(不是必要的)之后,得到

α

^

0

1

α

^

0

2

α

^

0

3

α

^

0

4

\begin{array}{cccc}\hat{\alpha}_{0}^{1} & \hat{\alpha}_{0}^{2} & \hat{\alpha}_{0}^{3} & \hat{\alpha}_{0}^{4}\end{array}

α01α02α03α04使得这些值的和为1。根据这4个值,可以得到

c

0

=

∑

α

^

0

i

h

i

=

0.5

h

1

0.5

h

2

\begin{aligned} c^{0} &=\sum \hat{\alpha}_{0}^{i} h^{i} =0.5 h^{1}+0.5 h^{2} \end{aligned}

c0=∑α^0ihi=0.5h1+0.5h2,将其作为Decoder Input,得到“machine”的输出(因为权值较大)。

使用

z

1

z^1

z1重复刚刚的操作:

这个过程一直持续,直到停止。

2.2 Speech Recognition

2.3 Image Caption Generation(Attention-based Model)

那么image怎么加上attention-base model呢?可以用一组vector来描述一张图片,将CNN的filter前的矩阵当作z0,然后将filter的输出做weight sum,得到红色的vector,然后输入到RNN的Decoder就可以得到z1,也可以输出word1。以此类推。

实验可以表明在产生相应词汇的时候机器注意的点是不同的:

实验可以表明在产生相应词汇的时候机器注意的点是不同的:

2.4 Memory Network

在这个上面做attention,最常用在阅读理解上面。Document中有很多句子的vector,然后将提出的问题也处理为一个vector。同样的使得q和x进行match得到a,求weight sum,作为Extracted Information和问题一起丢进DNN中,就可以获得Answer。这整个模型是可以一起训练的:

还有一个更复杂的版本,将Document中的句子转换成两种不同的向量,也就是拿去和q进行match的向量和Extracted Information中使用的向量不一样,这样能有更好的结果。补充一点:最后的Extracted Information可以拿去和q相加作为新的问题输入,这叫做Hopping:

一个更复杂的版本。使用两层的vector,计算attention,再计算weight sum,再传到下一层vector,最后再使用DNN:

2.5 Neural Turing Machine(神经图灵机)

一般的做法是在Memory上面做attention,这个可以根据match score修改存在Memory里面的内容。不只是读Memory,也可以写Memory。

如下图,是现有一个初始的attention(蓝色),计算的结果是

r

0

r^0

r0,然后把

r

0

r^0

r0 丢到一个DNN(controller)里面,然后得到一组新的用于调整attention的参数(

k

,

e

,

a

k,e,a

k,e,a),然后用softmax算出新attention权重(绿色)。上面是最简单的原理图,实际上要比这个复杂(不展开):

在上图中我们算出了

e

1

e^{1}

e1 和

a

1

,

e

1

a^{1}, e^{1}

a1,e1 的作用是把memory的值清空,

a

1

a^{1}

a1 的作用是把新的值写入memory,具体公式如下图所示。 这个操作专注于修改分布中比较突出的部分, 例如下图中

α

^

1

2

\hat{\alpha}_{1}^{2}

α^12 比较突出,那么就倾向于把

α

^

1

2

\hat{\alpha}_{1}^{2}

α^12 对应的值

给大家的福利

零基础入门

对于从来没有接触过网络安全的同学,我们帮你准备了详细的学习成长路线图。可以说是最科学最系统的学习路线,大家跟着这个大的方向学习准没问题。

同时每个成长路线对应的板块都有配套的视频提供:

因篇幅有限,仅展示部分资料

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

5万+

5万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?