本研究提出了信息密集型训练方法(IN2),通过生成长文本问答数据集,强化大型语言模型在处理长篇幅输入时的信息利用能力,有效解决了中段信息丢失问题。

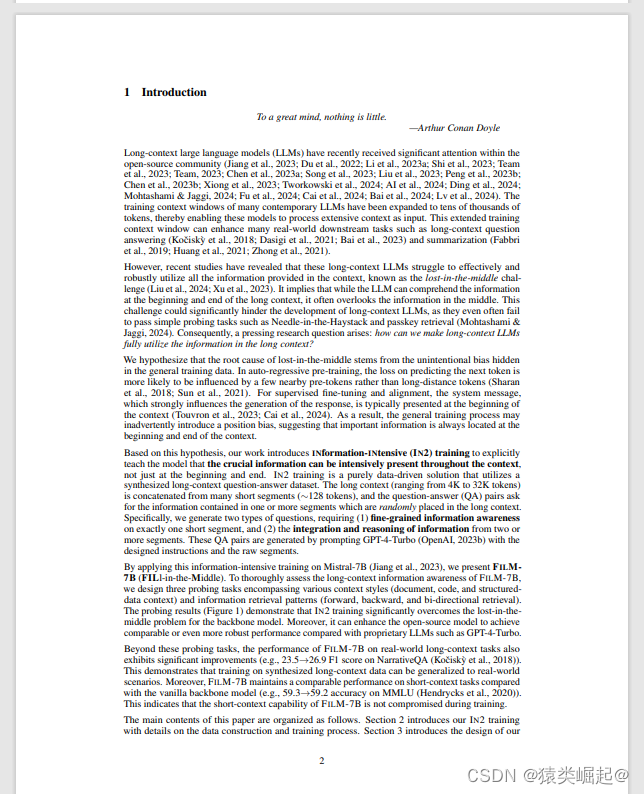

虽然许多当代大型语言模型 (LLM) 可以处理冗长的输入,但它们仍然难以在长上下文中充分利用信息,这被称为中间迷失挑战。我们假设它源于长期语境培训期间的明确监督不足,这未能强调长期背景下的任何职位都可以掌握关键信息。基于这种直觉,我们的研究提出了信息密集型(IN2)培训,这是一种纯粹的数据驱动解决方案,可以克服中间迷失。具体来说,IN2 训练利用合成的长上下文问答数据集,其中答案需要 (1) 在合成的长上下文(4K-32K 令牌)中对短段(~128 个令牌)的细粒度信息感知,以及 (2) 来自两个或多个短段的信息的整合和推理。通过在Mistral-7B上应用这种信息密集型训练,我们提出了FILM-7B(FILl-in-the-Middle)。为了全面评估 FILM-7B 利用长上下文的能力,我们设计了三个探测任务,包括各种上下文样式(文档、代码和结构化数据上下文)和信息检索模式(前向、后向和双向检索)。探测结果表明,FILM-7B可以稳健地从其32K上下文窗口中的不同位置检索信息。除了这些探测任务之外,FILM-7B还显著提高了现实世界的长上下文任务的性能(例如,NarrativeQA的F1得分为23.5->26.9),同时在短上下文任务上保持了相当的性能(例如,MMLU的准确率为59.3->59.2)。

想要论文PDF可以找我拿

1946

1946

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?