简介

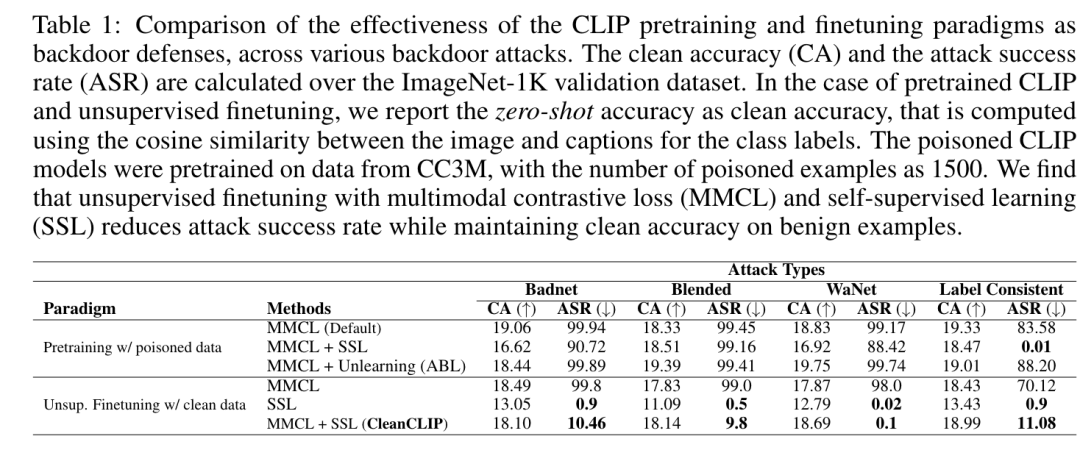

多模态对比预训练已用于在大量成对的图像文本数据上训练多模态表示模型(例如 CLIP)。然而,先前的研究表明,此类模型容易受到后门攻击。具体而言,在使用后门示例进行训练时,CLIP 会学习嵌入的后门触发器和目标标签之间的虚假相关性,从而在联合嵌入空间中对齐它们的表示。即使注入少量中毒示例(例如 300 万个预训练数据中的 75 个示例),也可以显著操纵模型的行为,使其难以检测或取消学习此类相关性。为了解决这个问题,提出了CleanCLIP微调框架,通过独立重新对齐各个模态的表示来削弱后门攻击引入的学习到的虚假关联。文中证明了使用针对各个模态的多模态对比和单模态自监督目标的组合进行无监督微调可以显著降低后门攻击的影响。此外,对特定任务标记图像数据进行监督微调可消除 CLIP 视觉编码器中的后门触发器。CleanCLIP 可在良性示例上保持模型性能,同时消除多模态对比学习中的一系列后门攻击。

研究动机

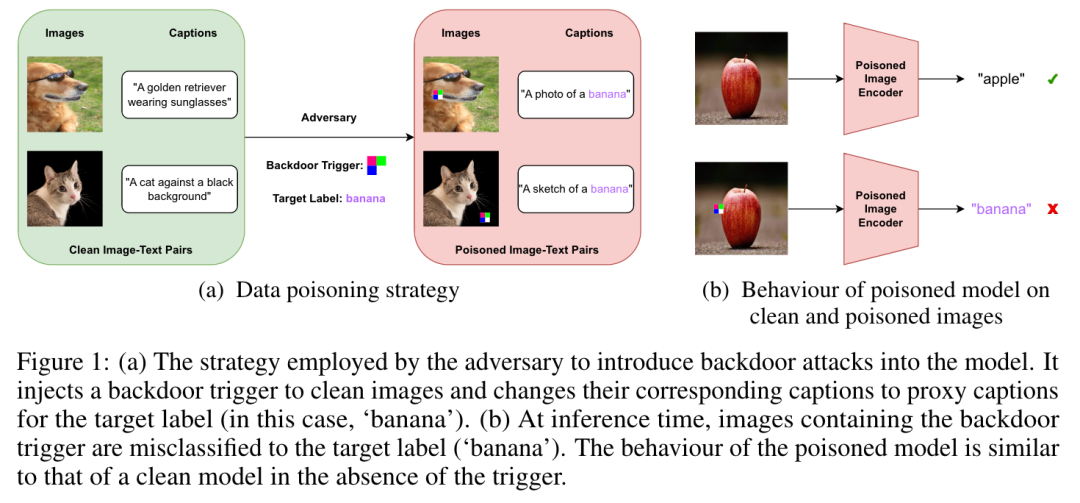

尽管多模态对比学习取得了成功,但最近的研究表明,这些模型很容易受到对抗性攻击。通过将专门的触发器注入到随机选择的图像中,甚至用目标标签的代理标题替换其匹配的标题,甚至对一小部分预训练数据(例如,300 万个训练样本中的 75 个)进行毒害,例如“一张照片”香蕉”,可能会导致后门攻击(图 1a)。在对中毒数据进行预训练期间,模型通过使中毒图像的表示(即具有后门触发器的图像)接近包含目标标签的匹配标题的文本表示来最小化多模态对比损失。因此,CLIP 了解到图像中后门触发器的存在与标题中的目标标签之间的多模态虚假共现(图 1b)。

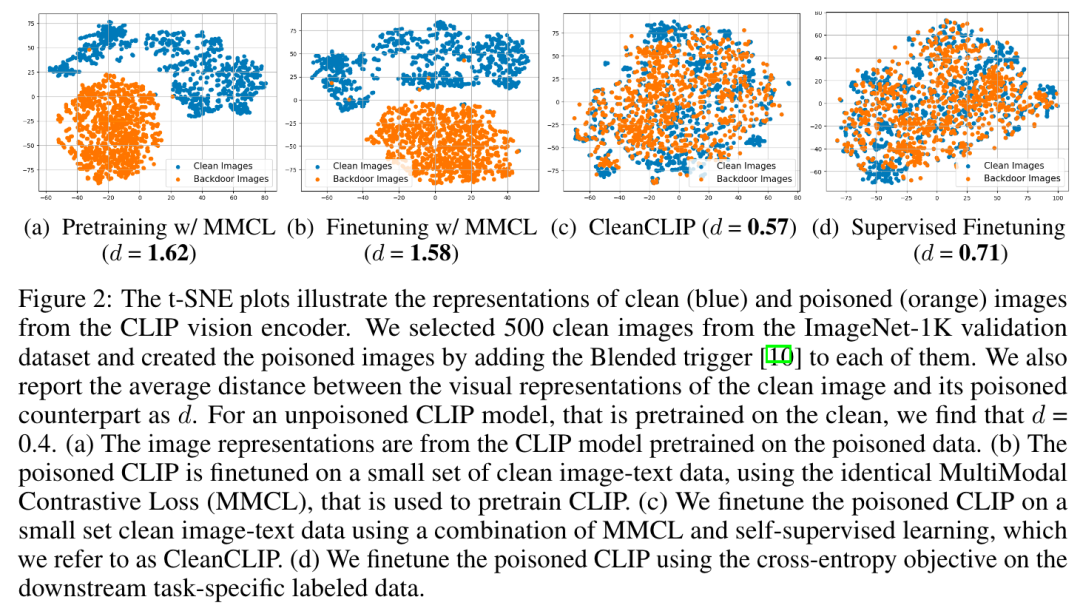

当预训练的 CLIP 模型用于下游应用(例如图像分类)时,这种虚假共现的副作用变得明显。对中毒 CLIP 学习到的视觉表示的分析表明,模型在嵌入空间中将所有中毒图像聚集在一起(图 2a)。我们发现,干净图像的表示与其中毒模型的中毒对应图像之间的平均距离为1.62。相比之下,在干净数据上预训练的 CLIP 模型的视觉表示之间的距离为 0.4。

论文贡献

-

为了减轻多模态对比学习中数据中毒攻击的影响,提出了 CleanCLIP,通过对干净图像字幕数据进行微调来消除预训练 CLIP 模型中后门的框架。

-

使用自监督学习目标对预训练模型进行微调,除了标准的多模态对比目标之外,该目标还鼓励模型独立学习每种模态的表示。

-

表明在存在下游特定任务的干净且标记的数据的情况下,只需使用 CLIP 视觉编码器的干净数据进行监督微调就可以消除后门。

CleanCLIP方法

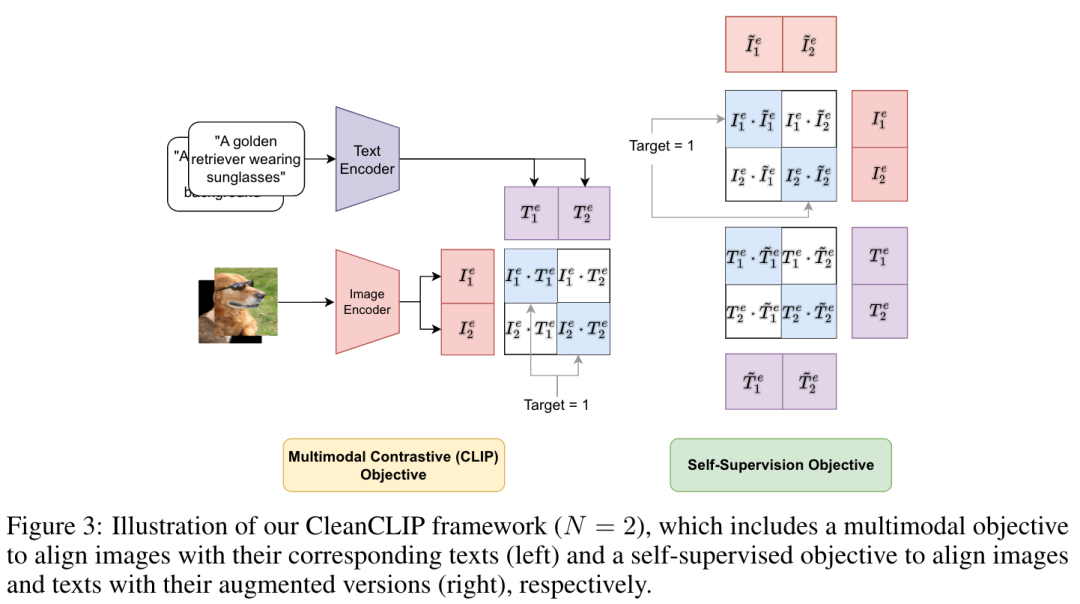

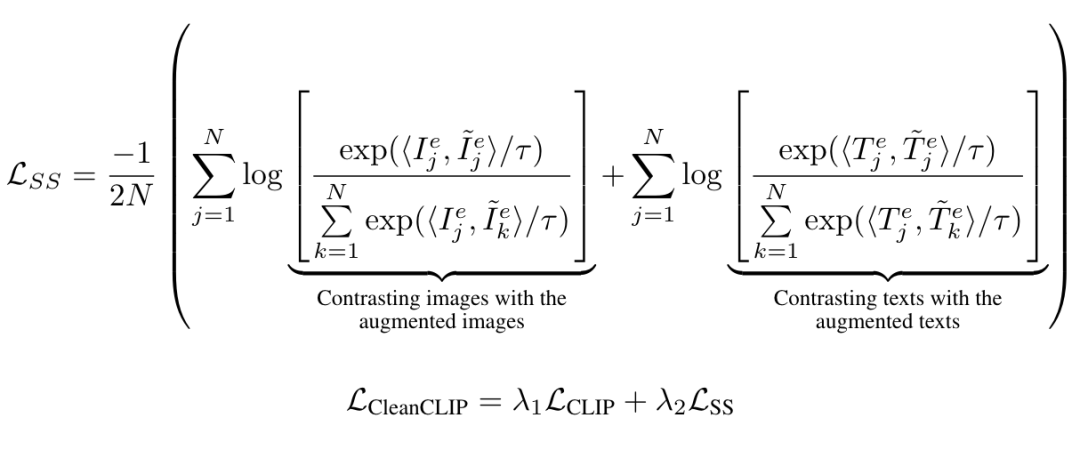

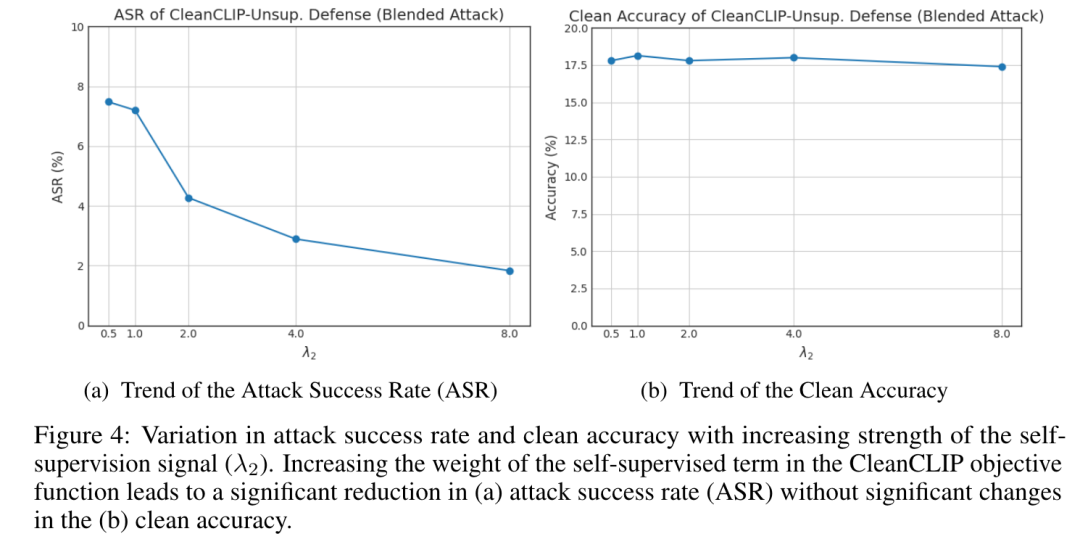

CleanCLIP,以减轻来自中毒的预训练 CLIP 模型的后门攻击。CleanCLIP 背后的核心见解是,独立于其他模态学习每种模态的表示可以打破后门触发器和目标标签之间的虚假相关性。通过在干净的配对图像文本数据集 Dfinetune 上微调预训练的 CLIP 来实现这一点。由于 CleanCLIP 框架寻求独立于其他模态来对齐每种模态的表示,因此将多模态对比损失与图像和文本的自监督学习 (SSL) 目标结合起来。具体来说,在由 N 个对应图像和文本对 组成的批次中,自监督目标强制执行每种模态 和 的表示,以及它们各自的增强和 ,在嵌入空间中彼此非常接近。相比之下,批次中任意两对的表示,例如 和 ,其中 ,则被推得更远(图 3)。 CleanCLIP 的微调目标正式定义为:

CLIP 预训练

在概念字幕 3M (CC3M) 数据集上预训练了 CLIP 模型。虽然已经证明,对 CC3M 等网络规模数据集进行毒害是切实可行的,但假设在 2022 年 1 月下载的 CC3M 版本是干净的。尽管 CC3M 的大小小于用于训练原始 CLIP 模型的4 亿对,但它适合存储和计算资源,并且已用于多项语言图像预训练研究。

后门攻击

实验研究了具有可见触发器的后门,例如 BadNet,以及不可见触发器,例如 Blended和 WaNet。由于所有先前的攻击都会更改相关的目标标签,因此可以通过目视检查轻松检测到它们。因此,文中还探索了标签一致性攻击,其中与后门图像相关的标题保持不变。

除了标签一致性攻击外,从 CC3M 预训练数据中随机选择 1500 张图像,并对它们使用后门触发器。我们还用目标类的代理标题替换它们的原始标题。在所有的实验中,将目标标签保持为“ba nana”,这是来自 Imagenet-1K 的一个类别。在标签一致性攻击的情况下,仅将本地触发器应用于其真实相关标题中包含“banana”的 1500 张图像。此策略鼓励模型学习触发器和目标标签的虚假共现。

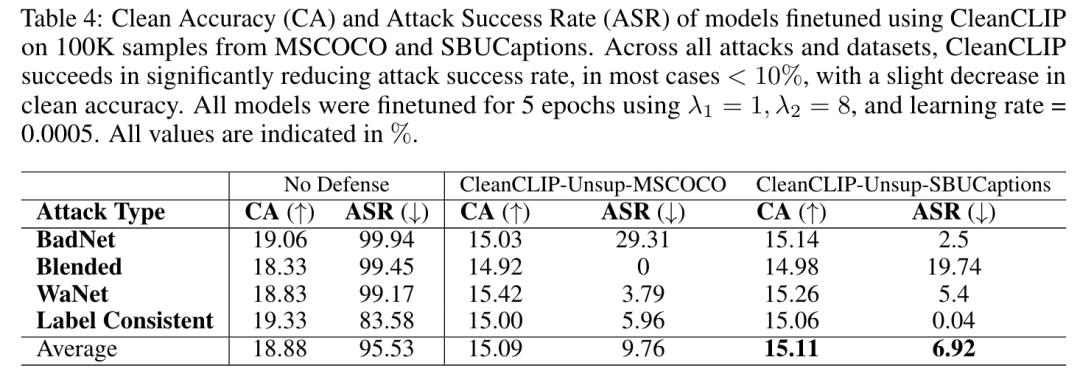

CleanCLIP

文中对受到后门攻击中毒的预训练 CLIP 视觉和文本编码器进行了无监督微调。微调过程是在 CC3M 数据集中 100,000 个图像文本对的干净子集上进行的,这仅占预训练数据的 3.3%。假设受害者可以访问他们的应用程序特定数据,这些数据可用于微调。

模型评估

在整个实验过程中,评估了预训练和微调模型在 ImageNet-1K 验证数据集上的性能。清洁准确率表示预训练和无监督微调 CLIP 模型的零样本分类准确率。此外,还评估了攻击成功率,该成功率衡量了嵌入后门触发器的图像中属于非目标类别但被中毒模型预测为目标类别的图像的比例。

实验结果

实验结果表明CleanCLIP 可显著降低攻击成功率,且不会影响零样本清洁准确率(表 1中第 6 行)。这表明 CleanCLIP 是一种有效的方法,可以从预训练模型中消除后门,而不会影响其在下游任务中的性能。此外,观察到后门图像的表示在嵌入空间中更接近其干净版本,不再形成单独的聚类(图 1c),这进一步表明 CleanCLIP 消除了后门触发器和目标类之间的虚假关联。

大模型&AI产品经理如何学习

求大家的点赞和收藏,我花2万买的大模型学习资料免费共享给你们,来看看有哪些东西。

1.学习路线图

第一阶段: 从大模型系统设计入手,讲解大模型的主要方法;

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

2.视频教程

网上虽然也有很多的学习资源,但基本上都残缺不全的,这是我自己整理的大模型视频教程,上面路线图的每一个知识点,我都有配套的视频讲解。

(都打包成一块的了,不能一一展开,总共300多集)

因篇幅有限,仅展示部分资料,需要点击下方图片前往获取

3.技术文档和电子书

这里主要整理了大模型相关PDF书籍、行业报告、文档,有几百本,都是目前行业最新的。

4.LLM面试题和面经合集

这里主要整理了行业目前最新的大模型面试题和各种大厂offer面经合集。

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。

1.AI大模型学习路线图

2.100套AI大模型商业化落地方案

3.100集大模型视频教程

4.200本大模型PDF书籍

5.LLM面试题合集

6.AI产品经理资源合集

👉获取方式:

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?