Scrapy的安装和新建就不再赘述,不明白的可以去查看文档,这里我以一个简单的例子来讲解如何使用框架。爬取豆瓣TOP250的电影信息。

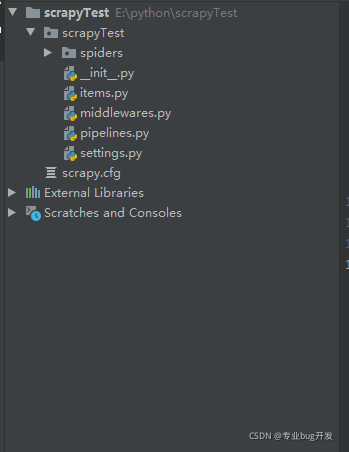

1.新建Scrapy项目

首先新建一个框架项目后你会得到如下的树形结构的文件。

-

spiders:用于编写爬虫。

-

item.py:临时保存抓取到的数据,存储方式类似于字典。

-

middlewares.py:项目中间件,可以自定义插入代码扩展Scrapy功能。

-

pipelines文件:核心处理器。

-

settings.py:项目设置文件。

-

scrapy.pcfg:项目配置文件。

2.编写items.py

这个文件是存储爬取数据的容器,存储形式类似于字典。

Define here the models for your scraped items

See documentation in:

https://docs.scrapy.org/en/latest/topics/items.html

import scrapy

class MovieItem(scrapy.Item):

define the fields for your item here like:

name = scrapy.Field()

title = scrapy.Field() # 电影名称

info = scrapy.Field() # 导演与演员

score = scrapy.Field() # 电影评分

evaluation = scrapy.Field() # 评价人数

summary = scrapy.Field() # 电影总结

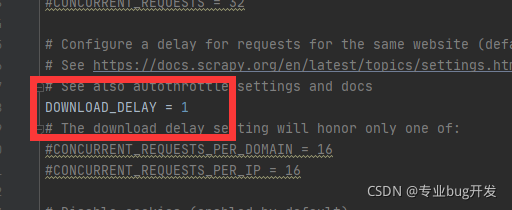

3.编写settings.py

全局设置都在这里,例如我们可以设置爬取间隔为1s。新建项目里面会有很多代码是注释的,我们不需要改动,需要对应的设置的时候再查看即可。

4.编写爬虫逻辑

爬虫逻辑我们统一写在spider文件下,即在spider文件夹下新建.py文件。

-- coding: utf-8 --

@Time : 2021/9/17 16:30

@Author : KK

@File : douban.py

@Software: PyCharm

-- coding: utf-8 --

import re

import scrapy

from scrapyTest.items import MovieItem

处理字符串中的空白符,并拼接字符串

def processing(strs):

s = ‘’ # 定义保存内容的字符串

for n in strs:

n = ‘’.join(n.split()) # 去除空字符

n = n.replace(" ", “”)

s = s + n # 拼接字符串

return s # 返回拼接后的字符串

class MoviespiderSpider(scrapy.Spider):

name = ‘movieSpider’ # 爬虫的名称,这个名称是唯一的且也是必须的

allowed_domains = [‘movie.douban.com’] # 允许爬虫爬取的域名列表

start_urls = [‘https://movie.douban.com/top250’] # 爬虫起始访问的URL

def parse(self, response):

li_all = re.findall(r’

- [\s\S]*?

- ', response.text)

item = MovieItem()

for each in li_all:

names = re.findall(r’(.*)', each) # 获取电影名字相关信息

item[‘name’] = processing(names) # 处理电影名称信息

infos = re.findall(r’导演:(.*?)

', each) # 获取导演、主演等信息item[‘info’] = processing(infos) # 处理导演、主演等信息

scores = re.findall(r’', each) # 获取电影评分

item[‘score’] = processing(scores)

evaluations = re.findall(r’(.*)', each) # 获取评分人数

item[‘evaluation’] = processing(evaluations)

summarys = re.findall(r’(.*)', each) # 获取评分人数

item[‘summary’] = processing(summarys)

yield item

for i in range(1, 10):

page = i * 25

start = ‘?’ + ‘start=’ + str(page)

next_url = response.urljoin(start)

yield scrapy.Request(url=next_url, callback=self.parse)

5.启动爬虫

这时候一个简单的Scrapy爬虫就准备就绪了,在控制台输入

scrapy crawl movieSpider -o items.json

scrapy crawl保持不动

movieSpider

就可以启动爬虫了。但你会发现程序没有正常获取到数据,查看控制台输出发现返回值为403,这是我们的爬虫被服务器识别了,进行了反爬,解决办法是在settings.py文件加上我们的请求头进行伪装。

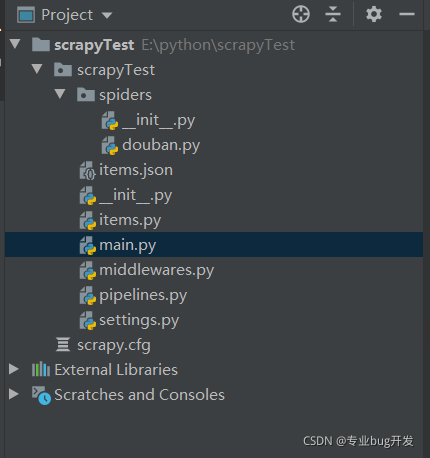

这样启动我们每次都需要在控制台输入命令行,为了更加快捷的启动我们的项目,我们可以在项目文件根目录下新建一个main.py。

-- coding: utf-8 --

@Time : 2021/9/17 17:01

@Author : KK

@File : main.py

@Software: PyCharm

from scrapy.cmdline import execute

import sys

import os

sys.path.append(os.path.dirname(os.path.abspath(file))) # 大括号内即把该文件路径变为绝对路径

execute([“scrapy”, ‘crawl’, ‘movieSpider’, “-o”, “items.json”])

至此我们的项目文件结构如下:

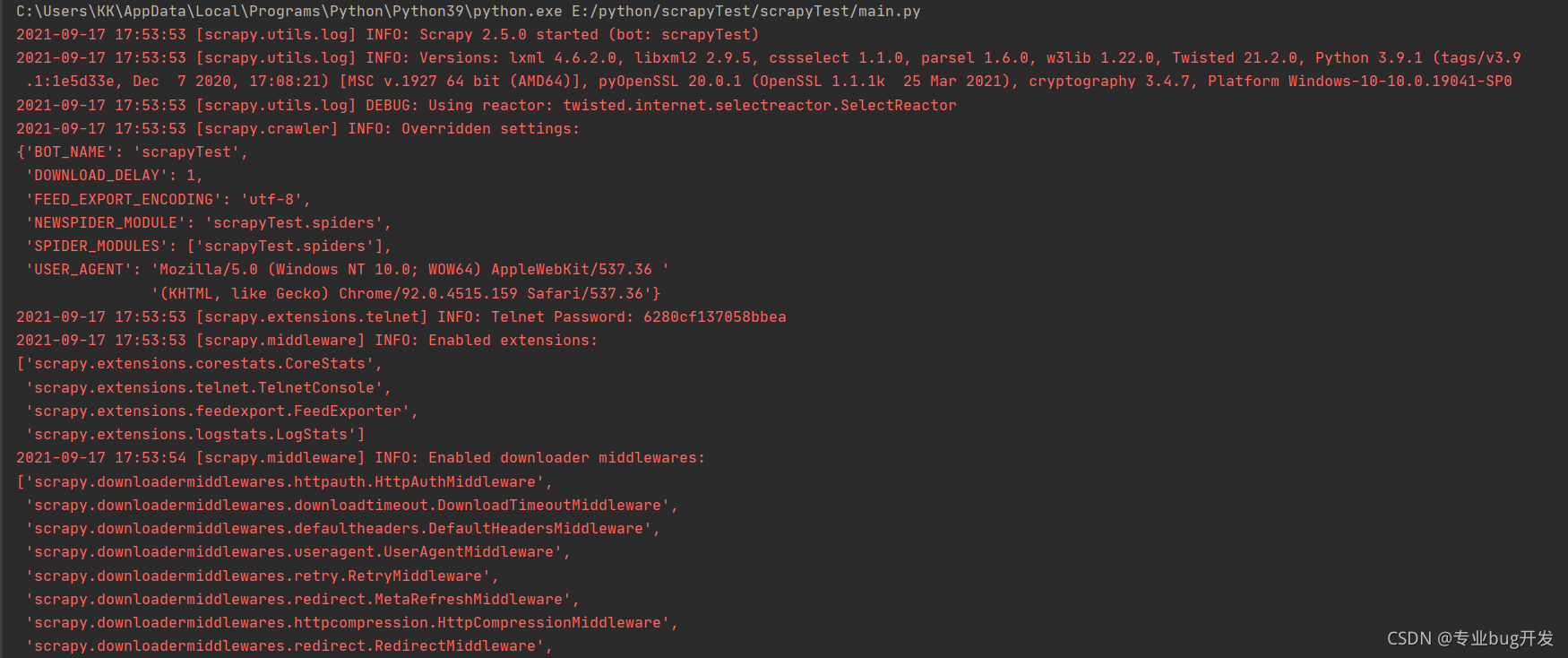

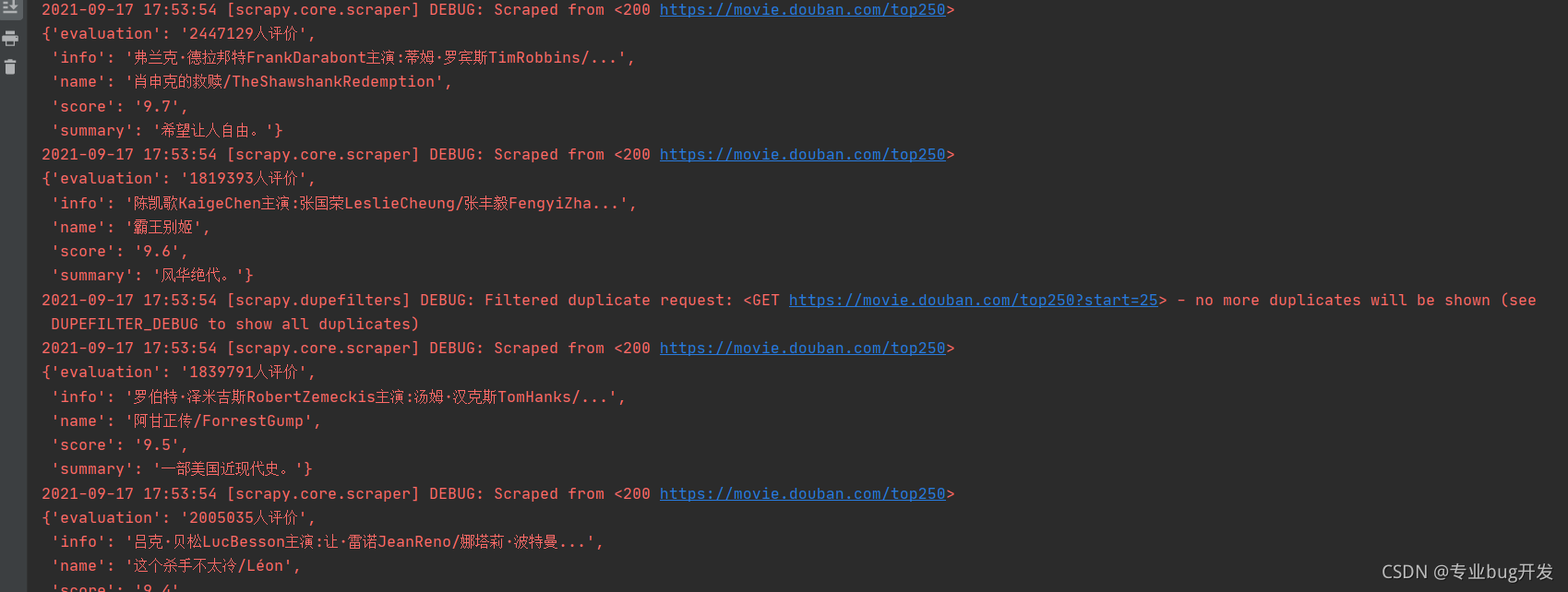

6.运行效果截图

红色的字体是正常的,项目运行信息就在这里面显示,不要认为红色就是报错了哈!!!!

相比于自己编写的爬虫代码,Scrapy结构更加清晰,爬取速度也更快,所以我们一般用于爬取数据量较大的大型网站。但需要注意的是这类网站的反爬机制一般很完善,这就需要我们进一步伪装自己的爬虫,下面我们一起学习一下如何自定义中间件。

1.设置随机请求头

很多网页通过请求头判断是不是爬虫在访问,为了避免被服务器检测,我们可以自定义一个随机请求头的中间件。方法如下:

- 在middlewares.py文件下加入如下代码:

from fake_useragent import UserAgent

自定义随机请求头的中间件

class RandomHeaderMiddleware(object):

def init(self, crawler):

self.ua = UserAgent() # 随机请求头对象

如果配置文件中不存在就使用默认的Google Chrome请求头

self.type = crawler.settings.get(“RANDOM_UA_TYPE”, “chrome”)

@classmethod

def from_crawler(cls, crawler):

返回cls()实例对象

return cls(crawler)

发送网络请求时调用该方法

def process_request(self, request, spider):

设置随机生成的请求头

request.headers.setdefault(‘User-Agent’, getattr(self.ua, self.type))片

- 在settings.py加入如下代码

DOWNLOADER_MIDDLEWARES = {

‘scrapyTest.middlewares.RandomHeaderMiddleware’: 400,

‘scrapyTest.middlewares.ScrapytestDownloaderMiddleware’: 543, # 默认中间件

}

RANDOM_UA_TYPE = “random” # 设置请求头为随机,还可以是ie等

- 使用随机请求头,编写一个测试爬虫

-- coding: utf-8 --

@Time : 2021/9/17 19:29

@Author : KK

@File : headerSpider.py

@Software: PyCharm

-- coding: utf-8 --

import scrapy

class HeaderspiderSpider(scrapy.Spider):

name = ‘headerSpider’

allowed_domains = [‘www.baidu.com’]

start_urls = [‘https://www.baidu.com/’]

def start_requests(self):

设置爬取目标的地址

urls = [

‘https://www.baidu.com/s?wd=%E7%99%BE%E5%BA%A6%E7%BF%BB%E8%AF%91&rsv_spt=1&rsv_iqid=0xa003c5490000a924&issp=1&f=3&rsv_bp=1&rsv_idx=2&ie=utf-8&tn=02003390_8_hao_pg&rsv_enter=1&rsv_dl=ts_0&rsv_sug3=6&rsv_sug1=4&rsv_sug7=100&rsv_sug2=1&rsv_btype=i&prefixsug=baidu&rsp=0&inputT=3099&rsv_sug4=4027’,

‘https://www.baidu.com/s?wd=%E7%99%BE%E5%BA%A6%E5%9C%B0%E5%9B%BE&rsv_spt=1&rsv_iqid=0xa003c5490000a924&issp=1&f=3&rsv_bp=1&rsv_idx=2&ie=utf-8&rqlang=cn&tn=02003390_8_hao_pg&rsv_enter=1&rsv_dl=ts_0&oq=%25E7%2599%25BE%25E5%25BA%25A6%25E7%25BF%25BB%25E8%25AF%2591&rsv_btype=t&inputT=1785&rsv_t=3f35TF2zzN98wRnfouxPtnf716zp3A%2BioNiu0jx9pBMEFCK0vPoF30WZV5cHOvfGVehfgGanCIE&rsv_sug3=9&rsv_sug1=7&rsv_sug7=100&rsv_pq=9a88ba610000b66d&rsv_sug2=1&prefixsug=%25E7%2599%25BE%25E5%25BA%25A6&rsp=0&rsv_sug4=3622’,

]

获取所有地址,有几个地址发送几次请求

for url in urls:

发送网络请求

yield scrapy.Request(url=url, callback=self.parse)

def parse(self, response):

打印每次网络请求的请求头信息

最后

🍅 硬核资料:关注即可领取PPT模板、简历模板、行业经典书籍PDF。

🍅 技术互助:技术群大佬指点迷津,你的问题可能不是问题,求资源在群里喊一声。

🍅 面试题库:由技术群里的小伙伴们共同投稿,热乎的大厂面试真题,持续更新中。

🍅 知识体系:含编程语言、算法、大数据生态圈组件(Mysql、Hive、Spark、Flink)、数据仓库、Python、前端等等。网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

本文详细介绍了如何使用Scrapy框架爬取豆瓣电影TOP250的信息,包括项目结构、items.py中的数据模型定义、settings.py的配置以及编写爬虫逻辑,还涉及了如何通过自定义中间件实现随机请求头以对抗反爬机制。

本文详细介绍了如何使用Scrapy框架爬取豆瓣电影TOP250的信息,包括项目结构、items.py中的数据模型定义、settings.py的配置以及编写爬虫逻辑,还涉及了如何通过自定义中间件实现随机请求头以对抗反爬机制。

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?