本期书目

-

书名:《大模型应用开发极简入门:基于GPT-4和ChatGPT》

-

作者:[比]奥利维·耶卡埃朗 [法]玛丽·艾丽斯·布莱特

-

译者:何文斯

-

出版年份:2024-02-01

-

出版社:人民邮电出版社

-

简要介绍:大模型的入门篇,算是对概念性的东西有一个总体的认识。书比较薄,手机两百多页,可以多看几遍。

-

书名:《BERT基础教程:Transformer大模型实战》

-

作者:苏达哈尔桑·拉维昌迪兰

-

译者:周参

-

出版年份:2023-02-01

-

出版社:人民邮电出版社

-

简要介绍:为了写这篇看了下开头的transformer介绍,写的很通俗易懂,等我继续看完!!!

阅读笔记

1

什么是大模型

大模型者,是大语言模型的简称,也就是LLM(Large Language Model),按照以往的习惯,我们将它拆开来看:

- 大:用大量数据训练的,规模(也就是深度学习模型中的参数、网络层数)很大的

- 语言:能够理解和生成自然语言的(不要问自然语言是啥)

- 模型:它是一个深度学习模型

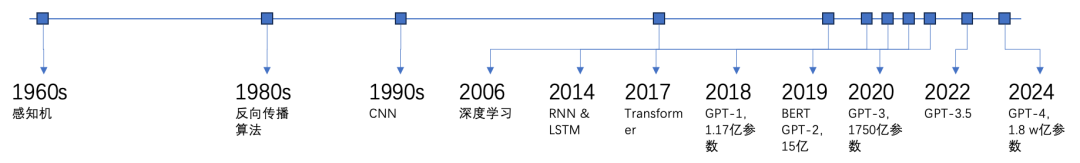

我们经常听到的ChatGPT就是一种大语言模型,GPT的意思是Generative Pre-trained Transformer(生成式预训练模型),其中Transformer是说它是基于Transformer架构的。

简单说下Transformer架构。(可不是变形金刚哈 )

)

Transformer是一种神经网络架构,可以用于处理时序任务,比如自然语言处理、语音识别等,也就是说对话之间是有顺序的,理解对话不仅需要知道当前的输入,还需要理解上下文,类似的,还有RNN(Recurrent Neural Networks,循环神经网络)、LSTM(Long-Short Term Memory,长短期记忆网络)也是设计用来处理这种类型的时序任务,然而一般情况下,循环神经网络存在一些局限性:

- **长期依赖的问题。**指随着序列长度的增长,信息会在传递过程中逐渐丢失,同时神经网络在反向传播时会导致梯度消失和爆炸的问题,从而导致模型训练不稳定,最终难以捕捉到远距离元素之间的关系。

- **难以并行化的问题。**RNN在处理序列数据时是顺序依赖的,即需要逐个处理序列中的元素。因此很难实现并行处理。限制了训练速度和效率。

LSTM针对梯度消失的问题进行了改进,相比传统的RNN,LSTM有更好的处理长序列的能力,但其计算复杂度较高,同时,由于需要保存大量的状态信息,导致内存消耗也比较大。

为了解决这些问题,2017年,谷歌的研究人员在论文《Attention is All You Need》(论文链接:https://dl.acm.org/doi/epdf/10.5555/3295222.3295349)中提出了Transformer架构,而此后,该架构迅速成为了自然语言处理领域的主流架构,并推动了BERT、GPT的发展。

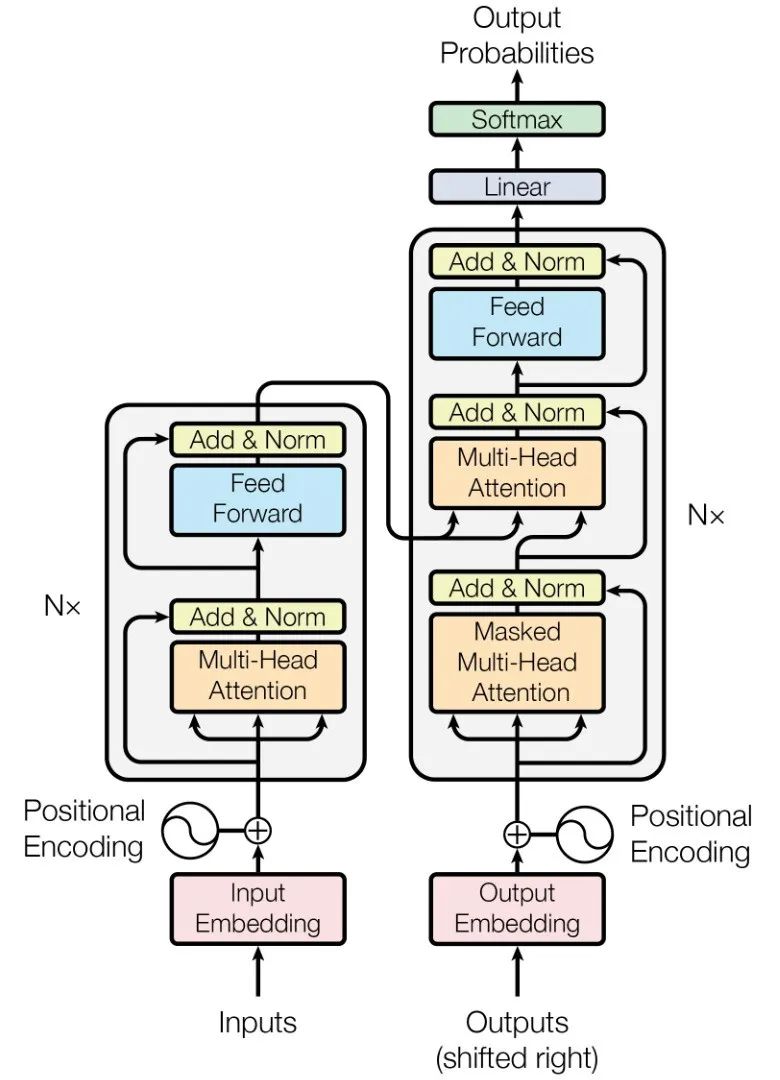

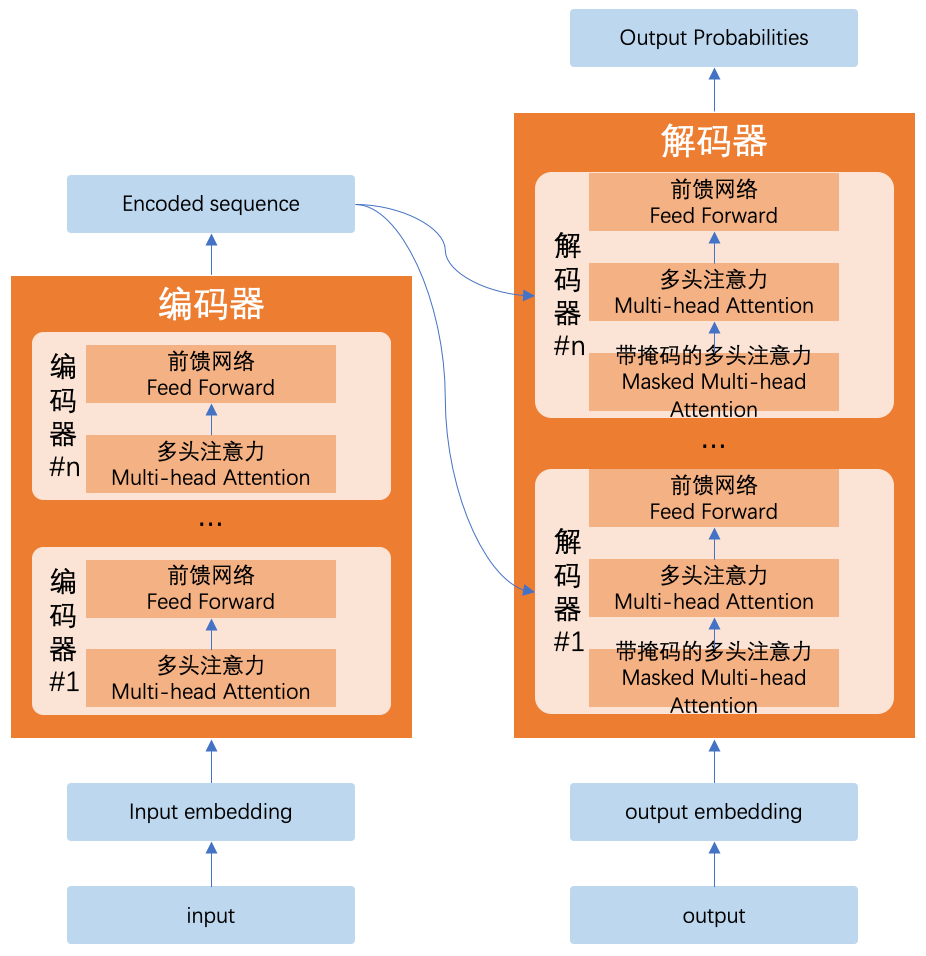

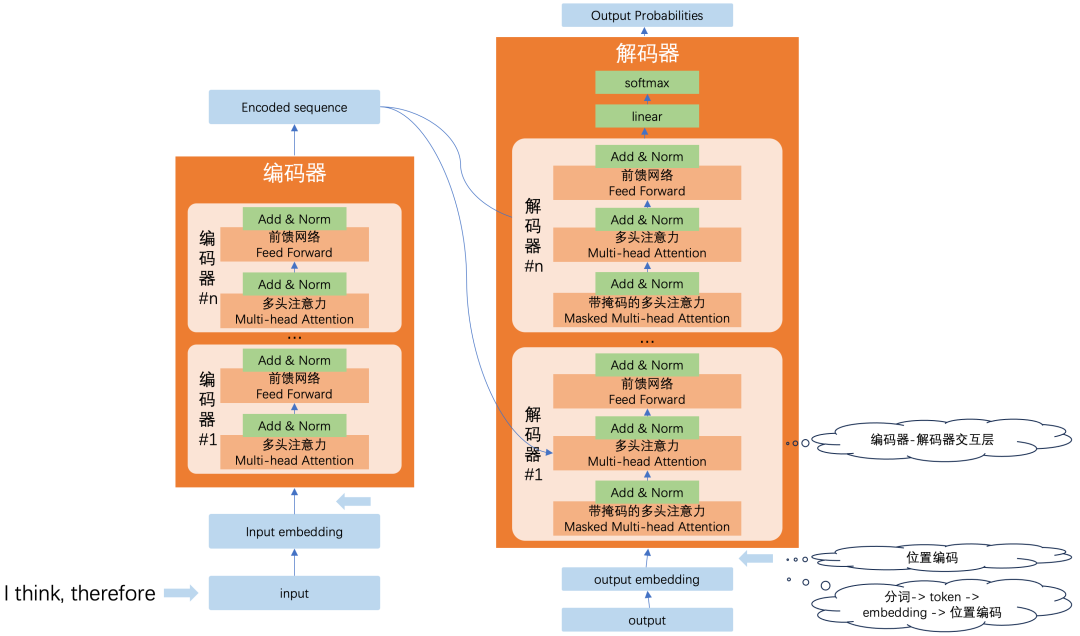

先看一下Transformer的架构。

图片来自https://dl.acm.org/doi/epdf/10.5555/3295222.3295349

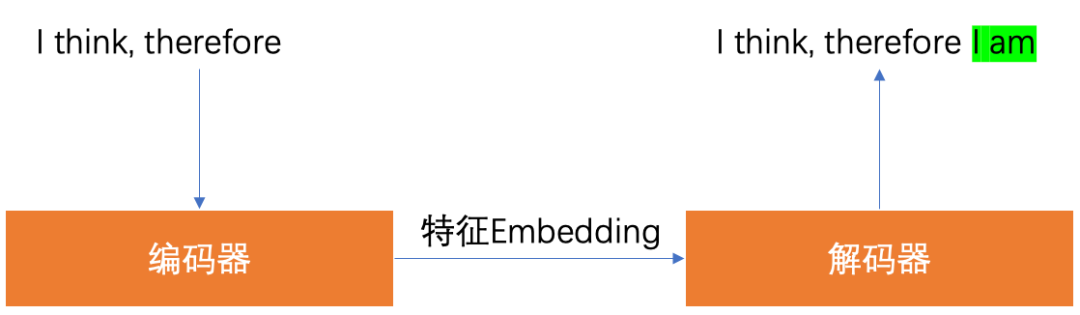

Transformer由编码器(左侧部分)和解码器(右侧部分)两部分组成。其中,编码器负责将输入的句子转换为特征向量,解码器则根据该特征生成输出语句。以文本补全为例:

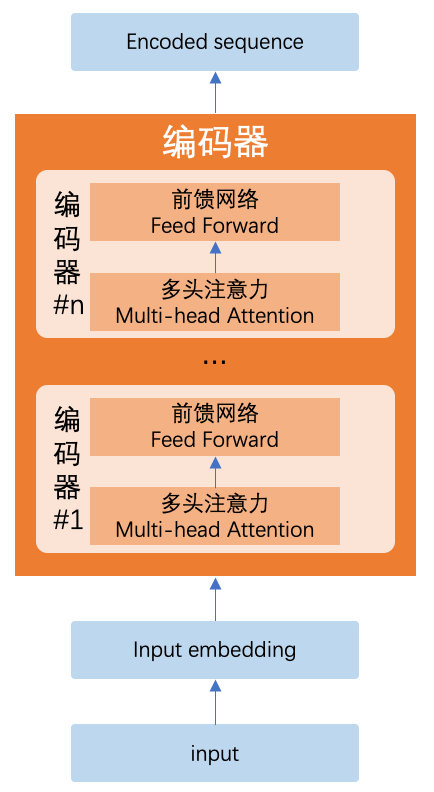

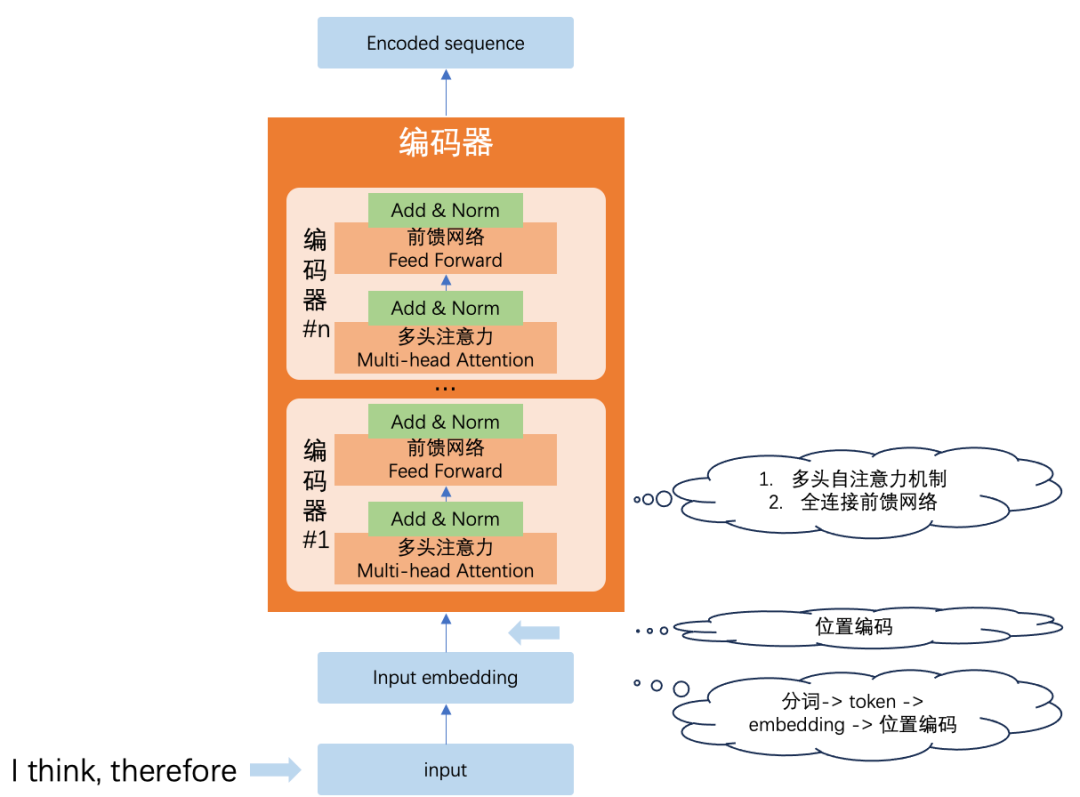

首先看编码器。Transformer中的编码器实际上是一组,由n个编码器串联而成,前一个编码器的输出作为后一个编码器的输入,每个编码器内部,由多头注意力层和前馈网络层组成。

注意力怎么理解呢,比如我们看书的时候,并不会一个字一个字的研究,而是会着重关注句子中的重点部分,这样可以提高阅读的效率。注意力使得模型在处理输入序列时,能够关注重要的部分,从而提高模型的效率。

自注意力就是自我对比,即在处理序列中的每个元素时,模型对比该元素和序列内其他元素的关系,计算它们之间的相关性。

下面看下自注意力机制的实现过程。(Reference:苏达哈尔桑·拉维昌迪兰,BERT基础教程:Transformer大模型实战,第1章 Transformer概览)

为了更好的计算元素之间的相关性,自注意力机制引入了三个概念:

- 查询向量Q(Query):表示“查询”的对象,是当前要关注的信息点。Q = X · W_q

- 键向量K(Key):表示“匹配”的对象,衡量其他位置的信息与当前查询的相关性(相似性)。K = X · W_k

- 值向量V(Value):值向量通过与查询和键之间的相关性的加权组合,形成最终的输出,也就是注意力矩阵Z。V = X · W_v

自注意力机制可归纳为四个步骤:

1. 计算查询向量和键向量的点积,即Q · K^T

2. 将#1的结果除以键向量维度的平方根,以获得稳定的梯度,即 ( Q · K^T) / sqrt(d_k),得到相似性分数

3. 使用softmax函数对#2的结果进行归一化处理

4. 将#3的结果与值向量相乘,得到注意力矩阵Z,即 Z = softmax(( Q · K^T) / sqrt(d_k))V

前提:将每个词转化为对应的词embedding向量,用x_i来表示,X表示输入矩阵,其为size为n*512(n是单词的个数,512是词embedding向量维度,参考上面的论文)

多头注意力,就是使用多个注意力头,得到多个注意力矩阵,将这些注意力矩阵串联起来,可以提高注意力矩阵的准确性。

最前面我们说过,RNN是按顺序处理输入序列的,而Transformer可以并行处理,那么,当模型并行处理时,它是如何决定每个词的位置的呢?Positional Encoding(位置编码),位置编码是词在句子中的位置编码,论文中作者使用了正弦函数来计算位置编码,总之将得到的位置编码矩阵与输入矩阵相加,将得到的结果送入编码器进行计算即可。

在多注意力矩阵上方,是前馈网络,它是一个全连接网络,使用ReLU作为激活函数。

Add & Norm是叠加和归一组件,包含了层归一化(Layer Normalization)和残差连接(Residual Connection)。

在多注意力矩阵上方,是前馈网络,它是一个全连接网络,使用ReLU作为激活函数。

,每个head关注不同的方面,如有的分析语法、有的分析。Add & Norm模块结合了层归一化(Layer Normalization)和残差连接(Residual Connection)

下面再看下解码器。

解码器也是一组,由n个解码器串联而成,前一个解码器的输出作为后一个解码器的输入,同时每个解码器,也接受来自编码器的输出作为输入;每个解码器内部,由带掩码的多头注意力层、多头注意力层和前馈网络层组成。

与编码器不同的是,解码器的输入是目标序列的一部分,开始时(t=1,t为时间步)是开始符号SOS(Start Of Sentence),t为i+1(i>0)时,解码器使用当前的输入+上一个时间步的输出,作为输入来使解码器预测下一个词,一旦解码器预测到结束符号EOS(End Of Sentence),就意味着解码器已经完成了目标序列的生成。

解码器的开头与编码器类似,也是对输入转换为embedding矩阵,添加位置编码后,送入解码器进行处理。

解释一下带掩码的多头注意力层,在训练阶段,我们一般会通过在目标输出的开头加上SOS来作为输入发送给解码器,此时因为进行了embedding转换,所以输入矩阵X就是SOS加上每个目标词的embedding矩阵,然而测试阶段又是一个词一个词来的,也就是说,自注意力机制应该只与当前词之前的单词有关,而不是其后的词,所以训练模型时,我们可以通过掩码来“掩盖”后面的单词,这可以确保解码器在生成序列时只考虑已知的部分,而防止模型“偷看”未来的数据。

带掩码的多头注意力也是分了四个步骤,不同的是在softmax进行归一化时,使用-∞来进行掩码处理,确保当前输入的后面部分不会参与计算。

由于解码器还多了编码器的输出作为输入,因此多头注意力在生成Q、K、V时,通过编码器输出R来创建K和V,通过带掩码的多头的输出M来创建Q。通俗的理解,带掩码的多头生成的注意力矩阵相当于问题(Query),所以用来生成查询矩阵,而编码器的输出时帮助解题的信息(匹配信息),所以用来生成K和V。

好,多头注意力生成了注意力矩阵,通过前馈网络向前传递,通过Add & Norm进行了归一化,解码器就结束了吗?非也,后面还需要一些小小的加工:线性层(Linear)和softmax层,线性层生成一个logit向量,该向量是一组分数,表示模型任务在每个位置生成的词汇的可能性大小,通过softmax将logit向量转化为概率分布,解码器可以依次预测下一个词。

最后再总结下Transformer架构的关键特点:

1. 注意力机制:这是Transformer架构的核心,意思是当模型处理文本时,能够关注文本的关键部分,就像看书一样

2. 并行处理:对输入中的每一个部分,可以并行处理,提高效率。

3. 编码器-解码器:这是标准的Transformer架构的两个主要组件,编码器主要负责将输入的文本转换为一种中间表示(特征向量);解码器基于该向量最终生成一个输出。

图片来自互联网

GPT也是基于Transformer架构,但其实是没有使用编码器的,不过。。。原理其实类似,它对输入的处理其实也是通过将文本分词,形成token,然后将token映射为数值向量,最后在向量中存储token的位置信息,不同的位置赋予不同的权重,最终形成了输入向量。

简单一下大模型的发展:

去下一节。

**2

**

提示词工程

提示词工程,说的就是怎么编写提示词,能够让GPT能够更好的理解和生成你想要的答案。

提示词的设计模式网上由很多种,既然我们这里强调的是极简,那我们就按大佬书里写的,有效的提示词可以从三个部分来设计:

- 角色

给模型设置一个角色,明确它的角色定位和职责

- 上下文

提供你的任务的背景信息,或设置具体的情境

- 任务

明确任务的目标,对任务指令进行细化,同时你还可以提供你期望GPT输出的格式

多说无益,我们试一下,比如我们想让GPT给我们制定一份锻炼计划。这里我们对比几种方式(以下内容在通义千问进行测试):

第一种:

User:请给我制定一份训练计划。``System:当然可以!不过,在制定训练计划之前,我需要了解一些信息来确保计划适合您的需求和条件。以下是一些考虑因素:`` ``1. **目标**:您想要通过训练达到什么样的目标?是减肥、增肌、提高运动表现还是仅仅为了健康?``2. **健身水平**:您目前的体能状况如何?是否有任何限制或伤病需要注意?``3. **可用时间**:您每周有多少时间可以用来锻炼?``4. **设备**:您是否可以访问健身房或家里有健身器材?`` ``如果您能提供这些信息,我可以为您量身定制一个训练计划。如果没有特别的信息,我可以为您提供一个一般性的基础训练计划作为参考:`` ``### 周一至周五训练计划示例:`` ``- **周一**:` `- 热身:5-10分钟慢跑或动态拉伸` `- 力量训练:全身力量练习(如深蹲、俯卧撑、引体向上等)` `- 拉伸放松:5-10分钟静态拉伸`` ``- **周二**:` `- 心肺功能训练:中等强度有氧运动(如快走、游泳、骑自行车)30分钟` `- 核心稳定性训练:平板支撑、俄罗斯转体等`` ``- **周三**:` `- 休息或轻度活动(如散步、瑜伽)`` ``- **周四**:` `- 热身:同周一` `- 力量训练:专注于上半身(如哑铃推举、俯卧撑、划船)` `- 拉伸放松:同周一`` ``- **周五**:` `- 心肺功能训练:高强度间歇训练(HIIT),如短距离冲刺、跳绳等` `- 柔韧性与平衡:瑜伽或普拉提课程`` ``- **周六和周日**:` `- 可以选择一天进行轻松的户外活动,如徒步、骑行等,另一天完全休息或做轻度拉伸。`` ``请注意,这只是一个非常基础的框架。根据您的具体情况,这个计划可能需要调整。此外,开始新的训练计划前,请咨询医生或专业人士以确保安全。

第二种:

User:你是一位专业的健身教练及营养师,我最近由于暴饮暴食,导致体重有点超标,而且经常感觉四肢无力,另外,由于我附近没有健身房,可能无法去健身房进行专业训练,请从你专业的角度,帮我制定一份训练计划,按照表格的形式,输出一周的训练计划和饮食计划。``System:了解了您的情况后,我会为您设计一个在家就可以进行的基础训练计划以及一个简单的饮食建议表。请注意,我的建议仅供参考,如有特殊健康状况或持续感觉身体不适,建议寻求医疗专业人士的帮助。`` ``### 训练计划`` ``| 时间 | 运动类型 | 具体活动 | 备注 |``|----------|----------------|-------------------------------|--------------------------------|``| 周一 | HIIT | 20分钟高强度间歇训练(如原地跑步、开合跳) | 确保热身后进行 |``| 周二 | 力量训练 | 自重训练(俯卧撑、深蹲、仰卧起坐) | 每个动作3组,每组8-12次 |``| 周三 | 休息/轻度活动 | 散步或轻松瑜伽 | 保持身体活动,促进恢复 |``| 周四 | 有氧运动 | 家庭跳绳或快步走 | 持续30分钟以上 |``| 周五 | 力量训练 | 重复周二的力量训练动作 | 注意变换不同的肌肉群 |``| 周六 | 轻松活动 | 游泳/骑自行车(如果可实现) | 放松身心,增加乐趣 |``| 周日 | 休息 | 静态拉伸、冥想或阅读 | 有助于恢复,准备新的一周 |`` ``### 饮食计划`` ``| 时间 | 餐次 | 推荐食物 | 注意事项 |``|----------|-----------|-----------------------------------|--------------------------------|``| 每日 | 早餐 | 全麦面包、鸡蛋、牛奶、水果 | 保证足够的蛋白质与纤维素 |``| | 午餐 | 瘦肉(鸡胸肉/鱼)、蔬菜、糙米/全麦面 | 控制油脂,增加蔬菜摄入量 |``| | 加餐 | 坚果、酸奶、水果 | 适量加餐,避免饥饿导致过量进食 |``| | 晚餐 | 轻食,如沙拉搭配瘦肉 | 尽量在睡前3小时完成晚餐 |``| | 饮水 | 全天保持充足水分摄入 | 至少每天喝8杯水 |`` ``请根据自己的实际情况调整上述计划,并且逐渐适应后再逐步增加难度。同时,注意饮食均衡,避免过多加工食品,多食用新鲜蔬果。希望这份计划能够帮助您恢复活力并控制体重。如果有任何不适,请立即停止训练并寻求专业意见。

其他的一些技巧:

- 在提出你的问题后,你可以要求模型不要直接回答问题,而是基于你的输入,对你进行提问,以从你的回答中获取信息,从而帮助模型更好的执行你需要的任务。比如“你是一位系统架构师,请帮我设计一个聊天系统的架构。请不要直接回答问题,相反的,你可以向我提问,以便于你从我的答案中获取信息,从而更好的完成我的需求”,接下来,对模型提出的问题进行回答后,它便可以准确的按照你的需求进行回答,你可以对比直接提问与这种技巧之间的区别。

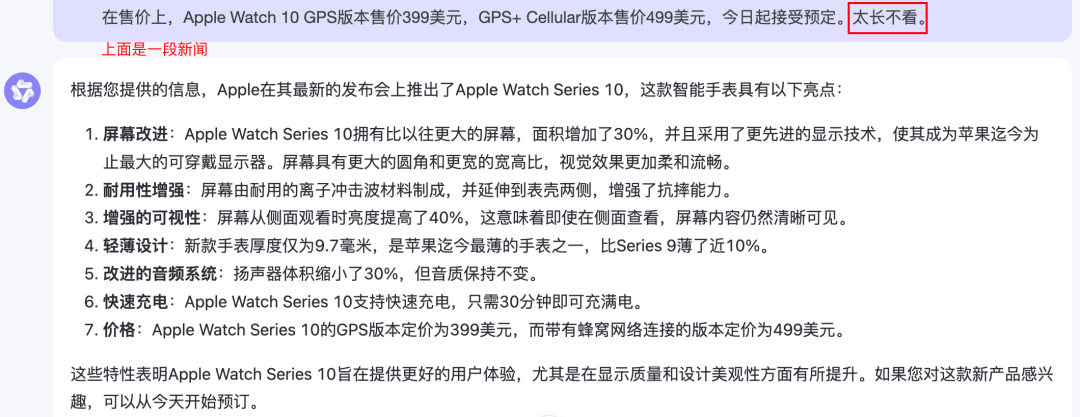

- 太长不看(英文是TL;DR, too long, dont read)。对于比较长的内容,你在末尾加上“太长不看”,模型将帮助你提炼文中的内容。

- think step by step,逐步拆解,在提示词的末尾加上“让我们逐步拆解/逐步思考“这样的话,可以使模型解决更复杂的推理问题。比如“123124乘以2324是多少?让我们逐步思考。”(当心,有时候逐步思考,AI还是会一本正经的胡说八道 )

)

- 指示模型提出更多问题,在提示词的末尾,询问模型是否理解问题并指示模型可以提出更多问题。如“如果你需要进一步的信息,你可以向我提问”、“你理解我的需求了吗?如果没有,你可以向我提问关于上下文的信息,以便于你更准确的回答我的问题”

- 格式化输出,如“请用表格输出,x行x列,每一行包含xxx信息“、”请只使用markdown输出,不要有多余的信息“、”你输出的内容必须被json.load接受“

- 使用负面提示,如“不要包含xxx”、“不要输出xxx”

- 添加长度限制,如“要求100字以内”

**3

**

大模型部署和聊天应用

上面对概念性的东西简单讲了一遍,下面我们通过代码来体验一把。

由于OpenAI的注册过程不是特别方便,因此我们通过在本机部署开源大模型来进行体验。其完全兼容OpenAI API的语法,因此学会了这个,那个也就不愁了。

项目名称:FastChat,地址:https://github.com/lm-sys/FastChat

下面是我的笔记本配置(老物件了):

CPU:2.8 GHz 四核Intel Core i7

内存:16 GB 2133 MHz LPDDR3

安装过程:

我们使用pip的安装方式,为了避免不同的python环境相互打架,我们创建一个虚拟环境,并激活之:

# 创建虚拟环境,这里使用python 3.12``conda create -n fastchat python=3.12``# 激活环境``conda activate fastchat``# 下载模块``pip3 install "fschat[model_worker,webui]"``# 注意默认的下载源可能比较慢,我这里使用了清华大学的镜像源,配置参考:``$ cat ~/.config/pip/pip.conf``[global]``index-url = https://pypi.tuna.tsinghua.edu.cn/simple``# 妈妈再也不用担心我的学习

Fastchat有了,接下来我们还需要下载模型(没模型怎么玩?),但由于抱脸网上不去,所以只能用其他方式了:

git clone https://github.com/LetheSec/HuggingFace-Download-Accelerator.git``cd HuggingFace-Download-Accelerator``# 以 lmsys/vicuna-7b-v1.5 为例``python hf_download.py --use_hf_transfer False --model lmsys/vicuna-7b-v1.5 --save_dir ./lmsys``# 重命名``cd lmsys && mv models--lmsys--vicuna-7b-v1.5 vicuna-7b-v1.5

接下来,先开一下API server,方便我们调用chat api,参考:https://github.com/lm-sys/FastChat/blob/main/docs/openai_api.md。

# 1. 启动controller``python3 -m fastchat.serve.controller``# 2. 启动model worker,由于笔记本太老,使用cpu,能用gpu的把后面的选项去掉即可``python3 -m fastchat.serve.model_worker --model-path lmsys/vicuna-7b-v1.5 --device cpu``# 3. 启动 api server``python3 -m fastchat.serve.openai_api_server --host localhost --port 8000``# 4. 先升级openai 模块,避免api调用出错(老的api已经弃用了,什么chatCompletion之类的)``pip install --upgrade openai``# 5. 敲代码``import openai``# 仅为了示例,生产环境请不要在代码中硬编码key``openai.api_key = "EMPTY"``openai.base_url = "http://localhost:8000/v1/"`` ``model = "vicuna-7b-v1.5"``prompt = "Once upon a time"`` ``# create a completion``completion = openai.completions.create(` `model=model,`` prompt=prompt, `` max_tokens=64``)``# print the completion``print(prompt + completion.choices[0].text)`` ``# create a chat completion``completion = openai.chat.completions.create(` `model=model,` `messages=[` `{` `"role": "user",`` "content": "Hello! What is your name?"` `}` `]``)``# print the completion``print(completion.choices[0].message.content)

当然也可以使用curl,这些代码均来自官方doc,可以明显看到,curl跑了40分钟才出来 :

:

`# yangzhenpeng @ yangzheengdeMBP in ~/personal/projects/fastchat-demo on git:main x [14:16:22] C:130``$ curl http://localhost:8000/v1/chat/completions \` `-H "Content-Type: application/json" \` `-d '{` `"model": "vicuna-7b-v1.5",` `"messages": [{"role": "user", "content": "Hello! What is your name?"}]` `}'``{"id":"chatcmpl-iCyeSMScjTjdGvztRMPtq9","object":"chat.completion","created":1726469789,"model":"vicuna-7b-v1.5","choices":[{"index":0,"message":{"role":"assistant","content":"I'm a language model called Vicuna, and I was trained by Large Model Systems Organization (LMSYS) researchers."},"finish_reason":"stop"}],"usage(fastchat)` `# yangzhenpeng @ yangzheengdeMBP in ~/personal/projects/fastchat-demo on git:main x [14:56:29]` `$ curl http://localhost:8000/v1/models``{"object":"list","data":[{"id":"vicuna-7b-v1.5","object":"model","created":1726476152,"owned_by":"fastchat","root":"vicuna-7b-v1.5","parent":null,"permission":[{"id":"modelperm-tMzJPA5JVYckXAZd6VjZ9n","object":"model_permission","created":1726476152,"allow_create_engine":false,"allow_sampling":true,"allow_logprobs":tru(fastchat)`

代码的说明:

- messages:是一个列表,每个元素是一个object,包含role和content,role可选system、user、assistant,content是消息内容;

- 对话以可选的系统消息开始,然后是交替出现的用户消息和助手消息。系统消息帮助设置助手的行为;

- model:指定模型

当然,还可以使用embedding API,来生成句子的embedding向量。

$ curl http://localhost:8000/v1/embeddings \` `-H "Content-Type: application/json" \` `-d '{` `"model": "vicuna-7b-v1.5",` `"input": "Hello world!"` `}'``{"object":"list","data":[{"object":"embedding","embedding":[0.01642363891005516,-0.01962481439113617,0.017369404435157776,0.011744257062673569,-0.02188173122704029,-0.011355118826031685,0.010298549197614193,-0.003570837201550603,0.013865873217582703,0.00207562861032784,0.007519117556512356,-0.011181961745023727,0.007619084790349007,0.0051024239510297775,-0.0002752111467998475,-0.0040420060977339745,-0.009619883261620998,0.01015309989452362,-0.011050069704651833,-0.015394661575555801,0.016036322340369225,-0.026504671201109886,这里省略大量数字,-0.006051628850400448],"index":0}],"model":"vicuna-7b-v1.5","usage":{"prompt_tokens":4,"(fastchat)

好的可以看到,结果是一个浮点数数组。embedding的一个突出特点是,它能够保持语义相似性。也就是说,含义相近的词语或短语在数值空间中更接近。

embedding可以用来:

- 搜索 按查询字符串的相关性给结果排序。

- 推荐 推荐包含与查询字符串相关的文本字符串的文章。

- 聚类 按相似度为字符串分组。

- 异常检测 找到一个与其他字符串无关的文本字符串。

**4

**

Langchain

LangChain是专用于开发LLM驱动型应用程序的框架,其包含如下关键模块:

1. models:语言模型,通过封装模型的API调用,Langchain使得开发人员可以更方便的使用它们的功能

2. prompts:提示词,可以通过提示词模板来构建提示词

3. indexes:索引,现在叫Retrieval(检索器),从外部数据源检索相关数据,对构建文档查询应用非常有用

4. chains:链,工作流中的步骤序列,将多个模型或提示词组合在一起,便于构建复杂流程。

5. agents:智能体,就是一个可以处理用户输入、做出决策并选择适当工具来完成任务的组件。

6. memory:记忆,允许应用跟踪对话的历史记录,这对构建类似聊天机器人这样的应用非常重要

Langchain的使用(官网的例子,大家自行尝试吧, 我电脑估计是跑不出来了):

# 1. 安装``pip install langchain langchain_community``# 2. 下载示例数据``wget https://raw.githubusercontent.com/hwchase17/langchain/v0.0.200/docs/modules/state_of_the_union.txt``# 3. 测试``from langchain.chat_models import ChatOpenAI``from langchain.document_loaders import TextLoader``from langchain.embeddings import OpenAIEmbeddings``from langchain.indexes import VectorstoreIndexCreator`` ``embedding = OpenAIEmbeddings(model="text-embedding-ada-002")``loader = TextLoader("state_of_the_union.txt")``index = VectorstoreIndexCreator(embedding=embedding).from_loaders([loader])``llm = ChatOpenAI(model="gpt-3.5-turbo")`` ``questions = [` `"Who is the speaker",` `"What did the president say about Ketanji Brown Jackson",` `"What are the threats to America",` `"Who are mentioned in the speech",` `"Who is the vice president",` `"How many projects were announced",``]`` ``for query in questions:` `print("Query:", query)` `print("Answer:", index.query(query, llm=llm))

还可以通过langchain构建一个基于文档的搜索应用,如上传text、pdf等。(书中的例子)

from langchain.document_loaders import PyPDFLoader``loader = PyPDFLoader("ExplorersGuide.pdf")``pages = loader.load_and_split()``from langchain.embeddings import OpenAIEmbeddings``embeddings = OpenAIEmbeddings()``from langchain.vectorstores import FAISS``db = FAISS.from_documents(pages, embeddings)``from langchain.chains import RetrievalQA``from langchain import OpenAIllm = OpenAI()`` ``chain = RetrievalQA.from_llm(llm=llm, retriever=db.as_retriever())``q = "What is Link's traditional outfit color?"``chain(q, return_only_outputs=True)

今天先到这。

大模型&AI产品经理如何学习

求大家的点赞和收藏,我花2万买的大模型学习资料免费共享给你们,来看看有哪些东西。

1.学习路线图

第一阶段: 从大模型系统设计入手,讲解大模型的主要方法;

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

2.视频教程

网上虽然也有很多的学习资源,但基本上都残缺不全的,这是我自己整理的大模型视频教程,上面路线图的每一个知识点,我都有配套的视频讲解。

(都打包成一块的了,不能一一展开,总共300多集)

因篇幅有限,仅展示部分资料,需要点击下方图片前往获取

3.技术文档和电子书

这里主要整理了大模型相关PDF书籍、行业报告、文档,有几百本,都是目前行业最新的。

4.LLM面试题和面经合集

这里主要整理了行业目前最新的大模型面试题和各种大厂offer面经合集。

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。

1.AI大模型学习路线图

2.100套AI大模型商业化落地方案

3.100集大模型视频教程

4.200本大模型PDF书籍

5.LLM面试题合集

6.AI产品经理资源合集

👉获取方式:

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

3109

3109

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?