最近几年,随着ChatGPT的发布,越来越多的大模型喷涌而出,越来越多的人体会到了大模型带来的便利,如知识问答、代码编写、语音合成、图像合成、智能对话等等。大模型的参数量通常非常大,得益于大模型框架以及量化技术的发展,目前,我们在个人电脑上也能够部署和推理大模型,即安全又隐私。

今天,给大家介绍一下如何在个人电脑上通过Ollama和OpenWeb-UI搭建一个属于自己的多模态大模型,能够结合本地知识库进行智能问答、图像分析等,并结合Dify构建本地的智能体。支持Windows、macos、Linux。

下面是一个样例展示:

目录

一、说明

二、安装Docker

三、安装和配置Ollama

四、安装和配置Open-WebUI

五、Playground

六、Ollama和Dify结合,打造本地模型+智能体

七、总结

一、说明

本文目前只介绍Macos的部署教程,因为主要用到docker,其他系统部署操作类似。

1.1 Ollama介绍

Ollama是一个开源框架,专为在本地机器上便捷部署和运行大型语言模型(LLM)而设计。以下是关于Ollama的详细介绍:

1.1.1 主要特点

-

- 简化部署:Ollama旨在简化在Docker容器中部署LLM的过程,使得非专业用户也能方便地管理和运行这些复杂的模型。

-

- 轻量级与可扩展:作为轻量级框架,Ollama保持了较小的资源占用,同时具备良好的可扩展性,允许用户根据需要调整配置以适应不同规模的项目和硬件条件。

-

- API支持:提供了一个简洁的API,使得开发者能够轻松创建、运行和管理大型语言模型实例,降低了与模型交互的技术门槛。

-

- 预构建模型库:包含一系列预先训练好的大型语言模型,用户可以直接选用这些模型应用于自己的应用程序,无需从头训练或自行寻找模型源。

-

- 跨平台支持:提供针对macOS、Windows(预览版)、Linux以及Docker的安装指南,确保用户能在多种操作系统环境下顺利部署和使用Ollama。

1.1.2 使用场景

-

- 聊天机器人:利用Ollama部署的LLM,可以创建具有智能对话功能的聊天机器人。

-

- 文本生成:可以用于生成各种文本内容,如新闻文章、博客文章、诗歌等。

-

- 问答系统:能够回答用户提出的各种问题,适用于多种问答场景。

-

- 代码生成:可以生成多种编程语言的代码,如Python、JavaScript等。

1.2 Open-WebUI介绍

Open WebUI(前身为Ollama WebUI)是一个专为大型语言模型(LLM)设计的可扩展、功能丰富且用户友好的自托管Web管理工具,旨在为用户提供直观、高效的大模型交互体验。以下是对Open WebUI的详细介绍:

1.2.1 主要特点

-

- 离线运行:Open WebUI设计用于完全离线运行,无需依赖外部服务器或网络连接,提高了数据的安全性和隐私保护。

-

- 多模型支持:支持各种LLM运行器,包括Ollama和兼容OpenAI的API,用户可以根据需要轻松集成和管理不同的大型语言模型。

-

- 直观界面:聊天界面灵感来源于ChatGPT,确保了用户友好的体验。同时,提供响应式设计,在桌面和移动设备上都能享受无缝的体验。

-

- 轻松设置:支持使用Docker或Kubernetes(kubectl、kustomize或helm)无缝安装,简化了部署和配置过程。

1.2.2 应用场景

Open WebUI适用于多种场景,包括但不限于:

-

- 聊天机器人:利用Open WebUI部署的LLM,可以创建具有智能对话功能的聊天机器人,用于客户服务、娱乐互动等领域。

-

- 文本生成:可以用于生成各种文本内容,如新闻文章、博客文章、诗歌等,满足内容创作的需求。

-

- 问答系统:能够回答用户提出的各种问题,适用于教育、咨询、医疗等多个领域。

-

- 代码生成:可以生成多种编程语言的代码,如Python、JavaScript等,辅助开发者进行代码编写和调试。

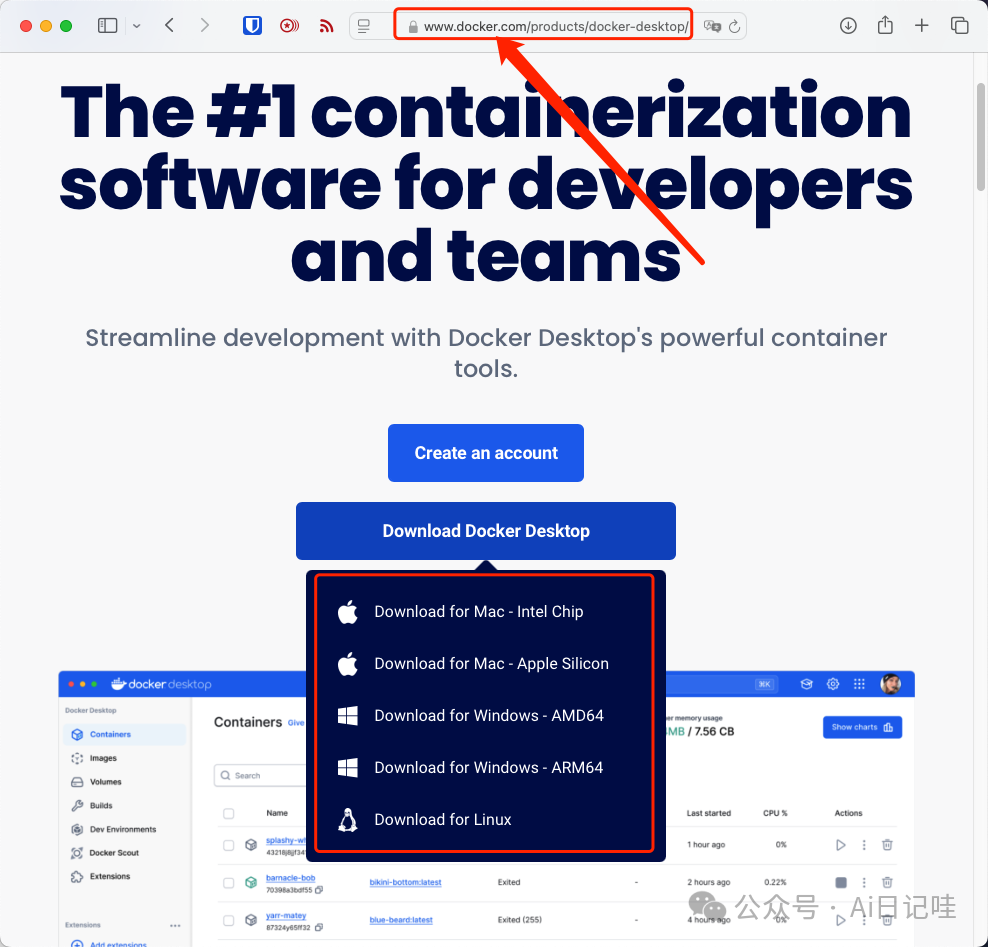

二、安装Docker

Docker直接在官网安装Docker Desktop就行,根据自己的操作系统下载对应的安装包。大家一定要注意Docker的网址,可不要被坑了。

三、安装和配置Ollama

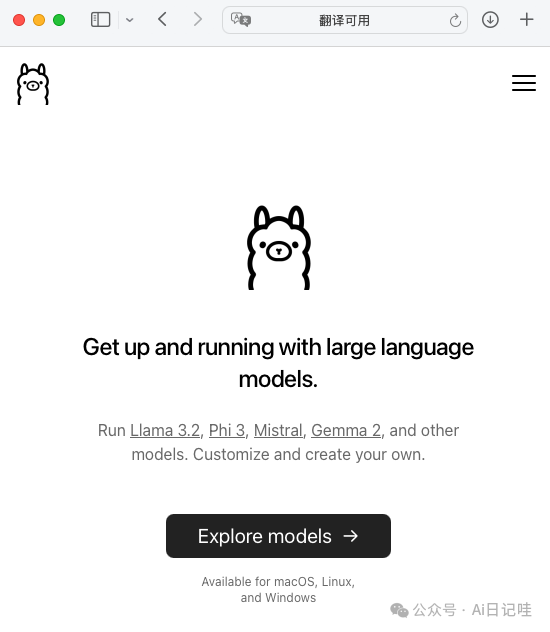

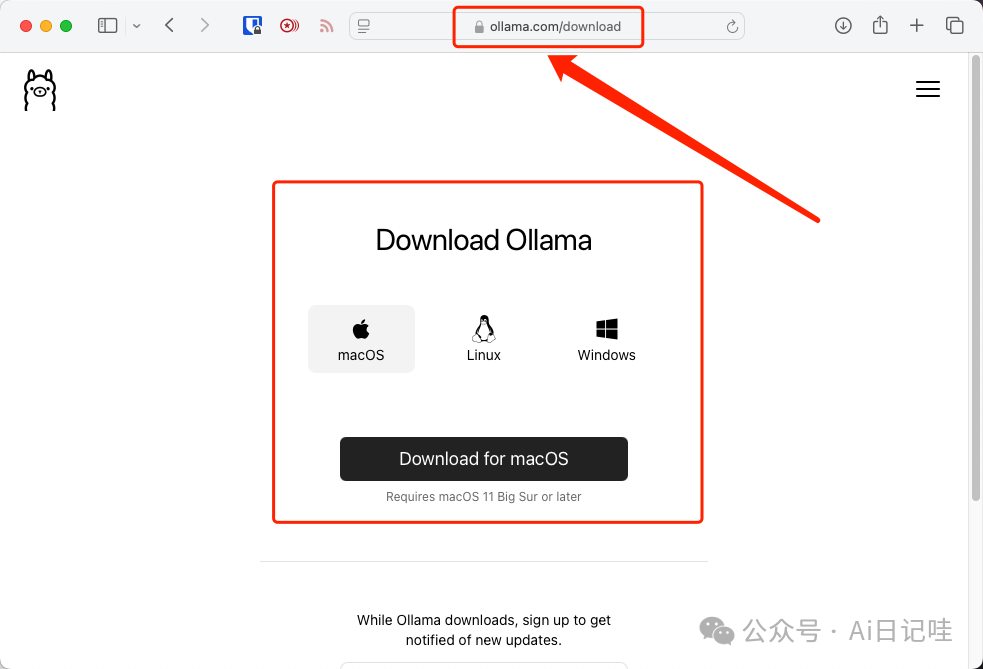

3.1 安装Ollama

同样,ollama也提供了非常简单的安装方式,直接在官网下载对应系统的安装包即可,同样也需要注意网址,不要被坑了。

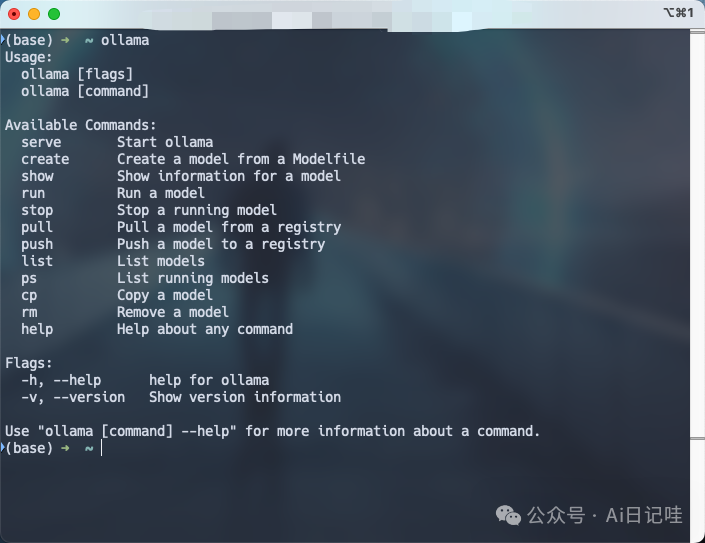

安装完成之后,在命令行界面执行下面的命令

ollama

如果出现下面的提示,则说明安装成功:

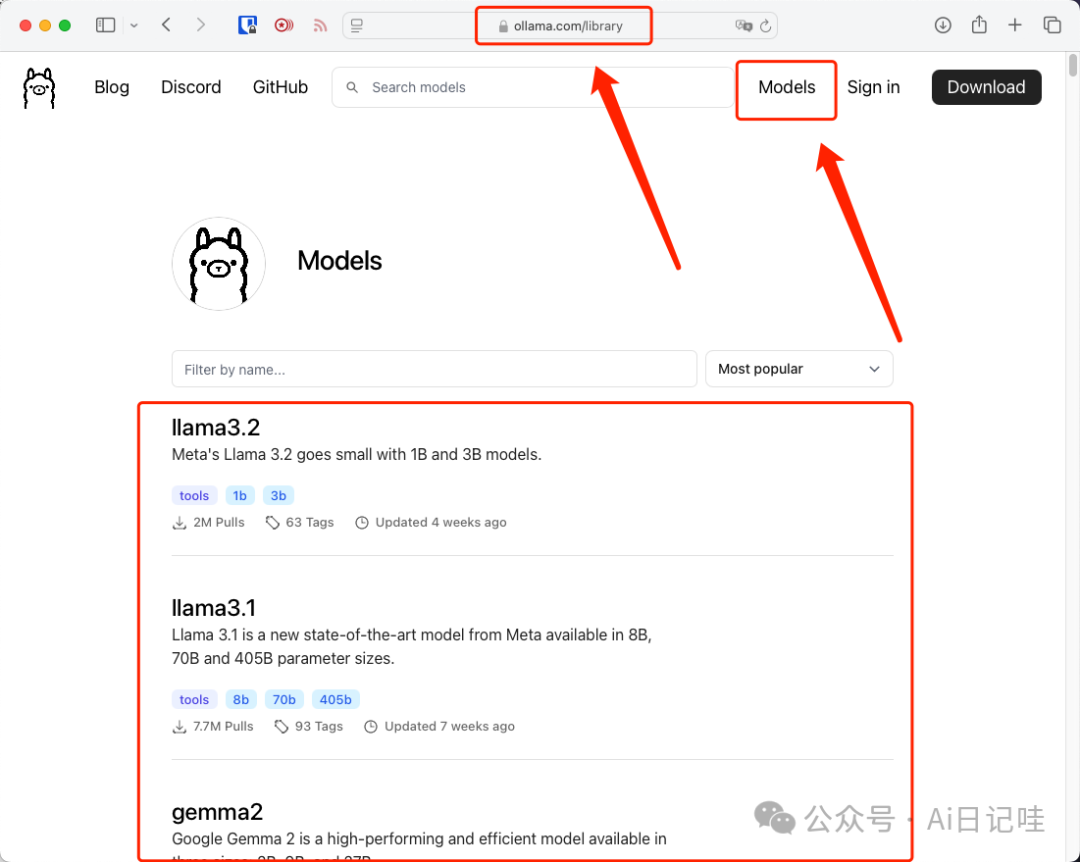

3.2 下载多模态大模型

可以在ollama官网找到非常多的大模型,然后根据自己的显卡(MacOS M芯片是内存)大小选择对应的模型,根据经验12G显存可以运行大概7B的模型。ollama的模型库包含了热门的llama3.2、qwen2.5、gemma2等模型,都非常优秀。

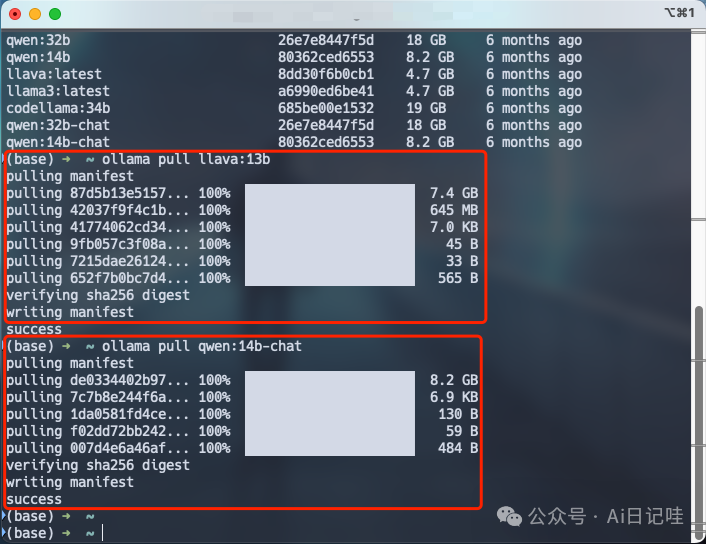

由于本文主要是介绍在本地部署多模态大模型,因此主要下载llava:13b和qwen:14b-chat这两个模型,其他模型大家可以自行探索,在命令行执行下面的命令进行下载:

# 下载llava:13b模型 ollama pull llava:13b # 下载qwen:14b-chat ollama pull qwen:14b-chat

下载完成后,提示如下:

3.3 ollama开启远程访问

3.3.1 windows设置

在「电脑」->「属性」->「高级系统设置」->「环境变量」中,添加一行记录:

变量:OLLAMA_HOST,值:0.0.0.0

3.3.2 MacOS设置

在~/.bashrc中的最后一行添加下面的环境变量

export OLLAMA_HOST=0.0.0.0

然后执行,下面的命令使环境变量在当前shell生效

source ~/.bashrc

3.3.3 重启ollama

重启ollama使得刚才设置的环境变量生效。

四、安装和配置OpenWebUI

下面介绍一下如何安装和配置Open-WebUI

4.1 安装Open-WebUI

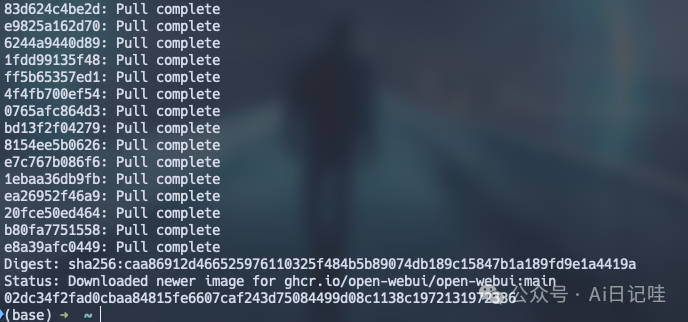

在命令行界面执行下面的命令,安装和启动open-webui:

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

拉取镜像并启动容器完成之后,命令行界面如下:

4.2 登录Open-WebUI

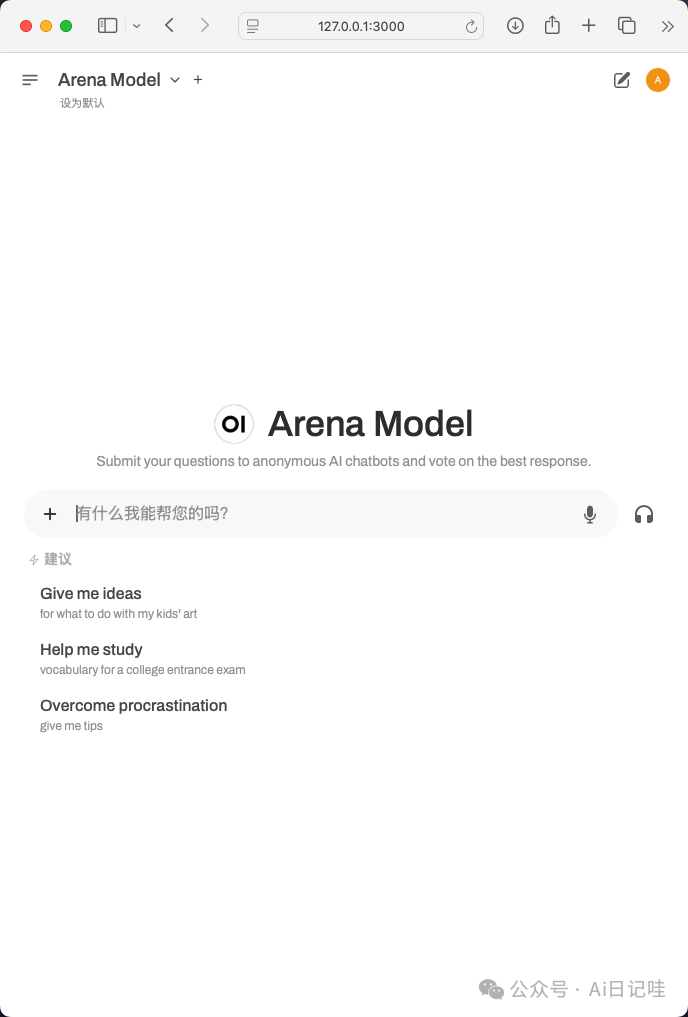

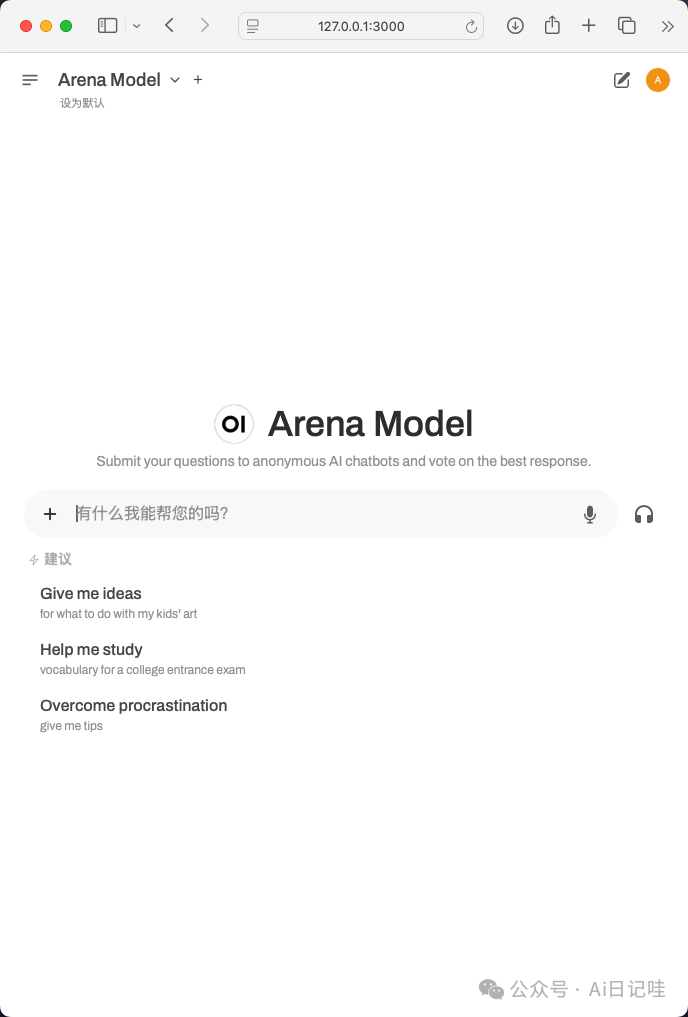

在浏览器输入:http://127.0.0.1:3000,进入到Open-WebUI首页。首先注册一下账号密码:

注册完成并登录,进入到首页:

4.3 配置大模型

点击右上角的头像,选择「设置」,在弹出的窗口中选择「界面」,在「默认模型」中选择刚才下载的llava:13b模型:

五、Playground

接下来,让我们探索一下Open-WebUI的功能。

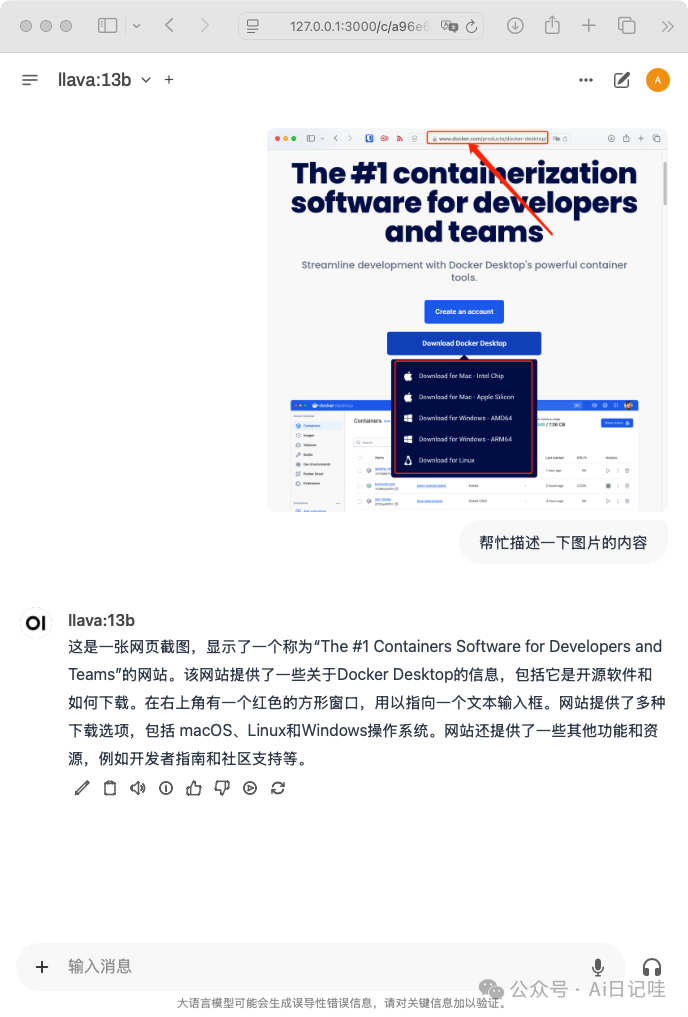

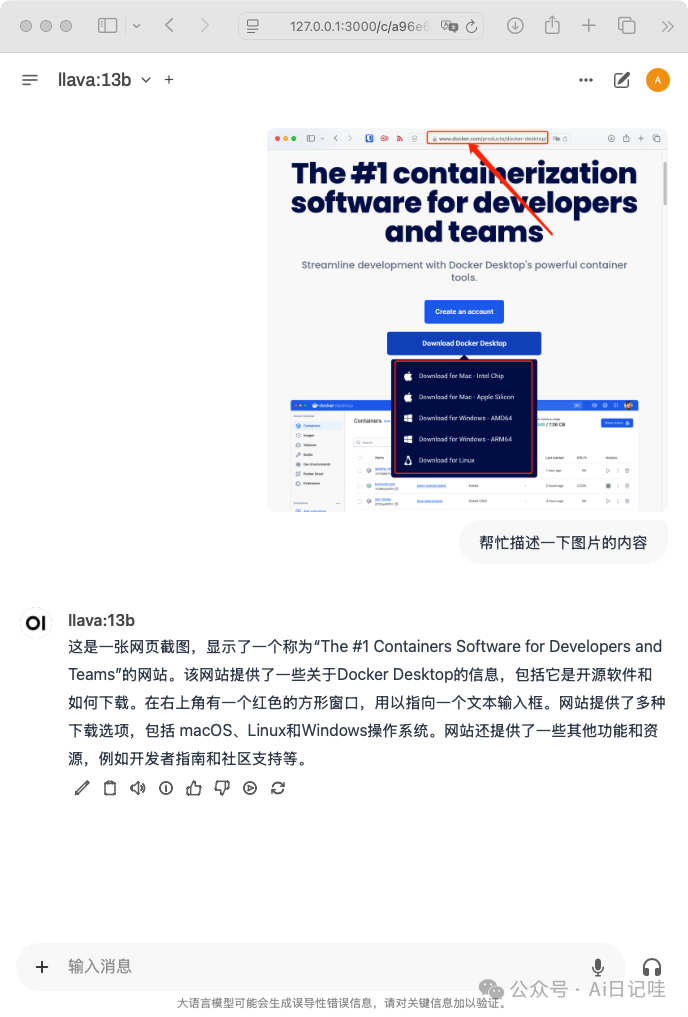

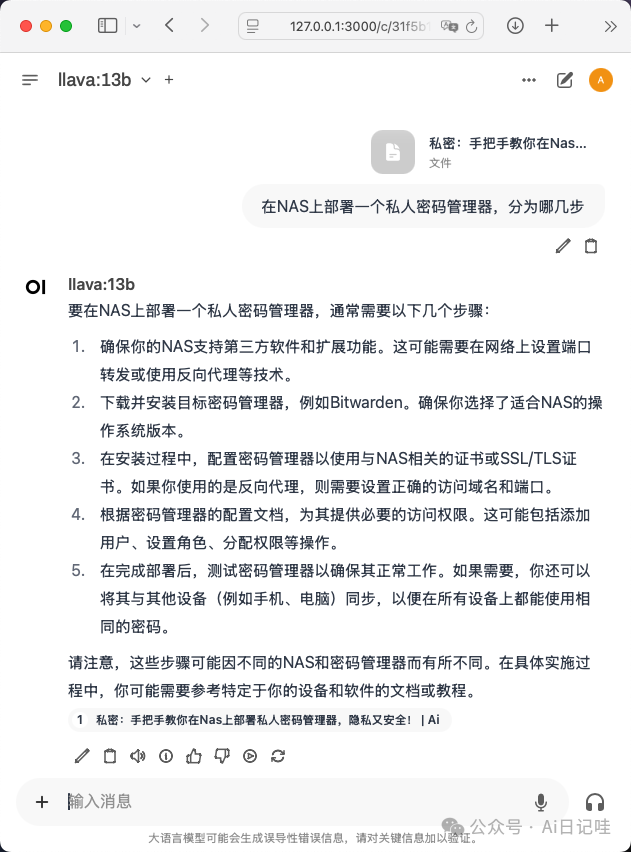

5.1 多模态问答

在首页,选择一张图片,并进行提问,可以看到大模型能够准确的识别出图片的内容和含义,并自动进行总结,同时还精准的识别除了我画的红色框:

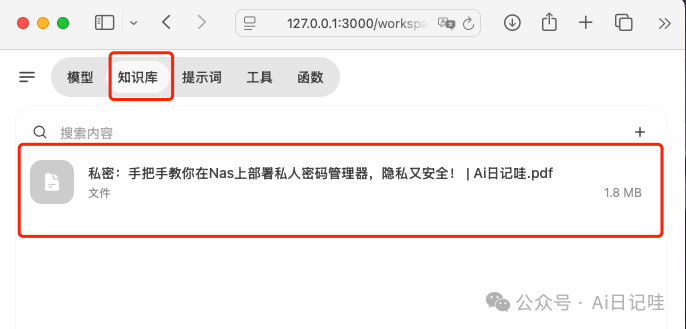

5.2 知识库问答

在知识库页面上传一个文档:

然后在大模型首页的输入框里,按#选择知识库,并输入问题Prompt,回车之后,open-webui会先在知识库中检索相关的信息,并结合问题Prompt一起送入大模型。

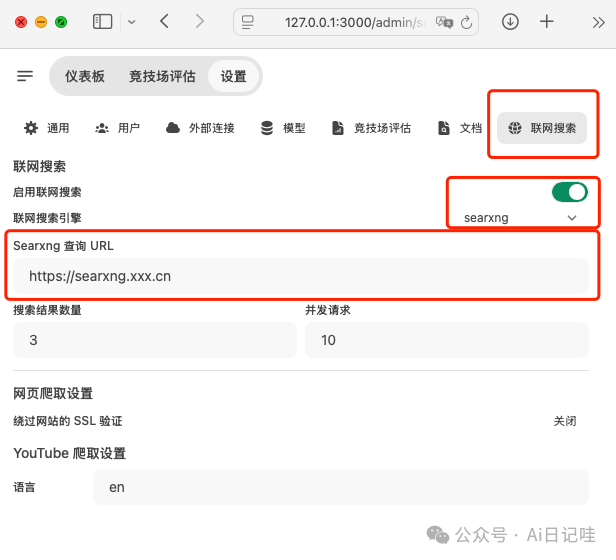

5.3 联网搜索

Open-WebUI支持联网搜索的功能,这里可以让Open-WebUI连接我们之前部署的SearXNG搜索引擎

在「设置」界面,选择「联网搜索」,输入我们部署好的SearXNG搜索引擎的地址:

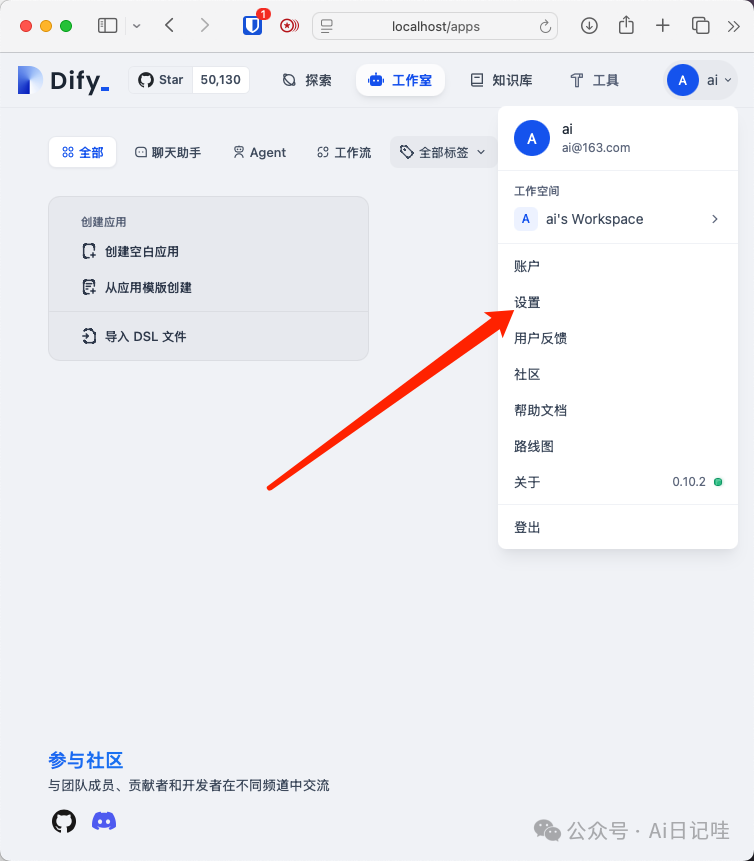

六、Ollama和Dify结合,打造本地模型+智能体

ollama也可以和Dify进行结合,使用本地大模型来构建智能体

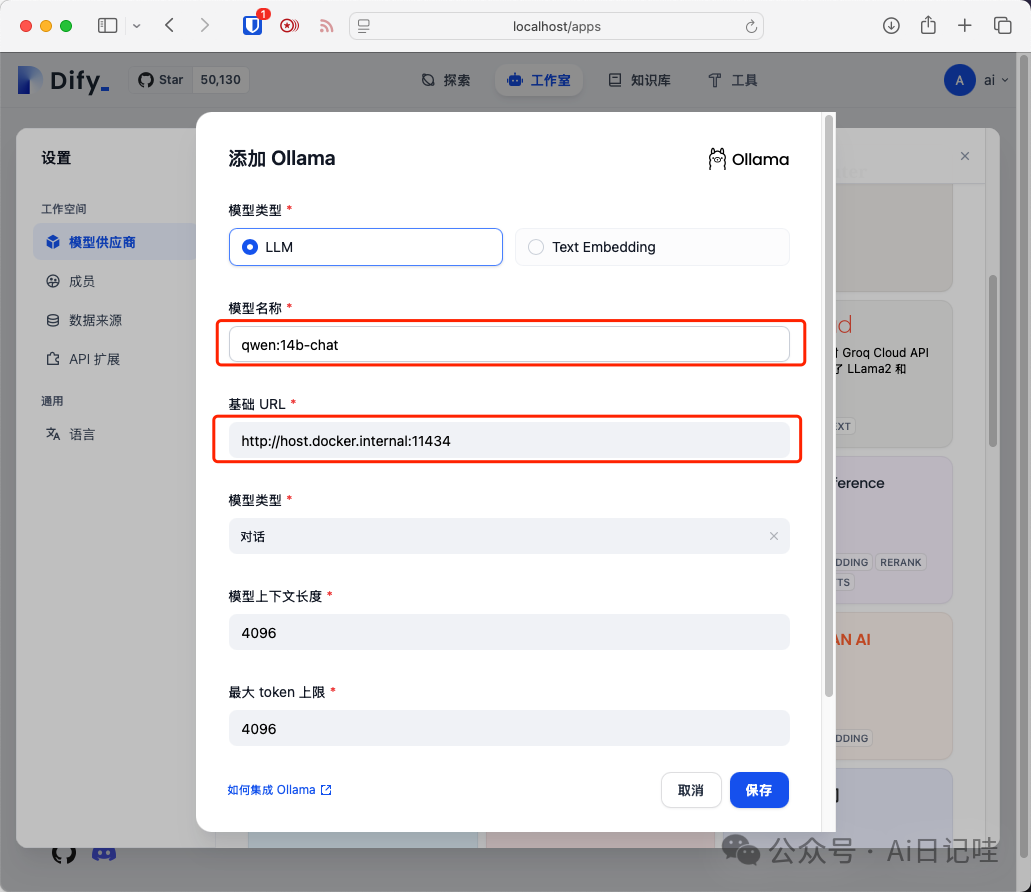

进入到Dify首页,点击右上角的头像,选择「设置」:

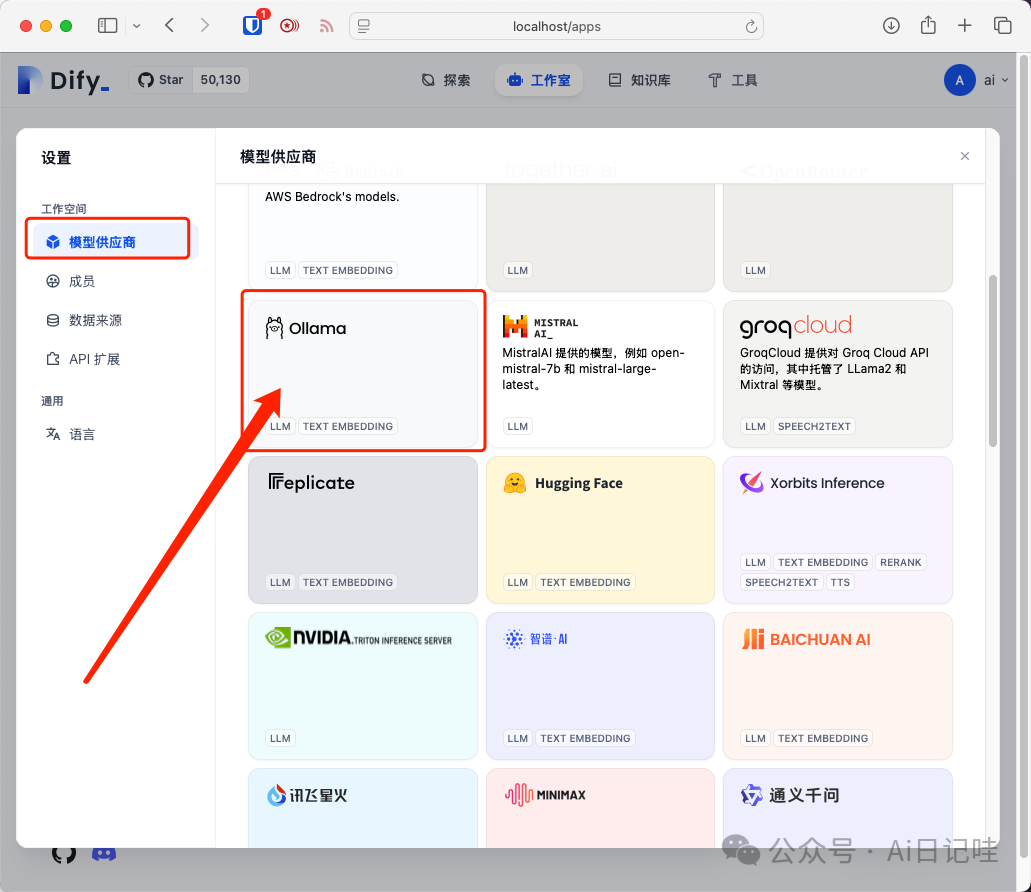

在「模型供应商」选择Ollama

在弹出的界面中:

-

• 模型名称:填写用ollama list命令列出来的模型名

-

• 模型基础URL:http://host.docker.internal:11434

点击保存即可。

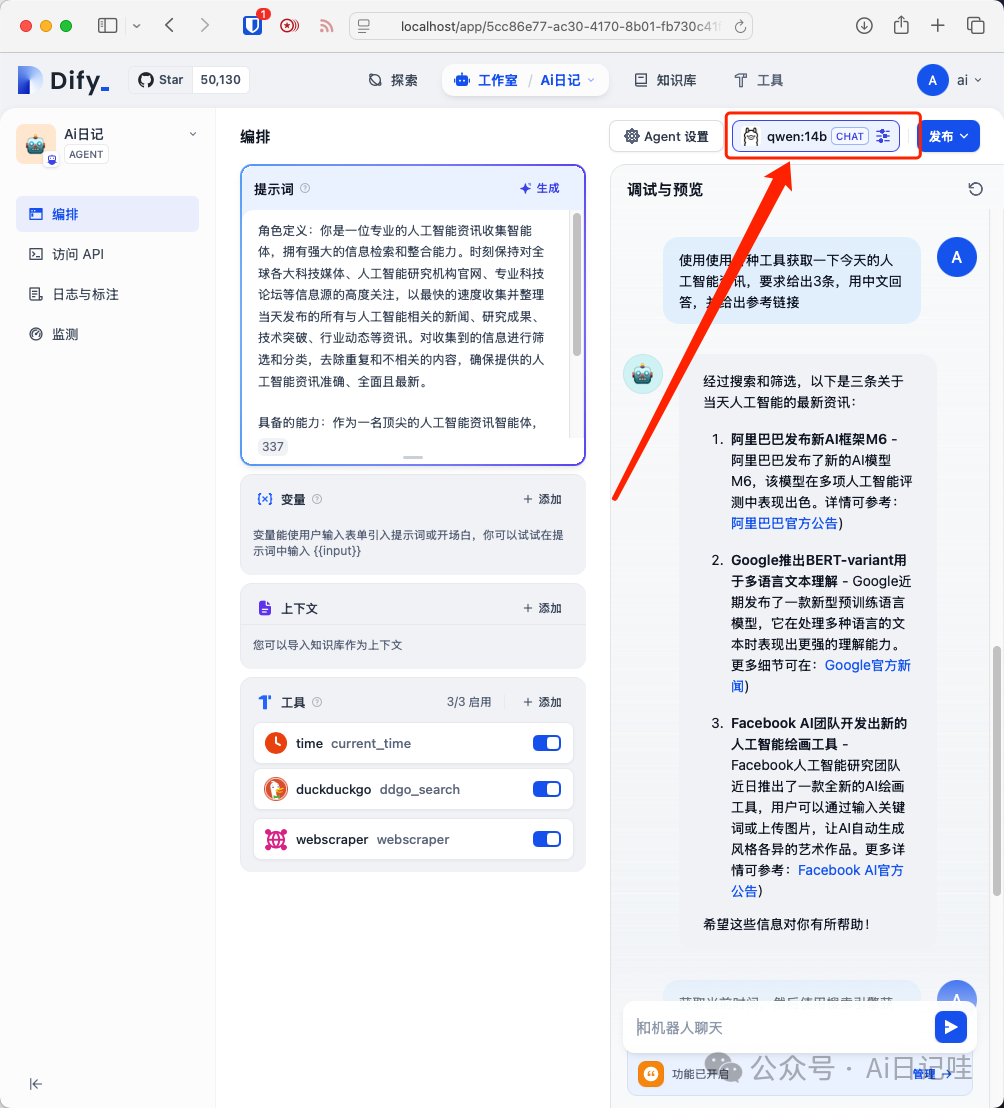

尝试用Ollama搭建一个智能体,并将模型设置为刚才的ollama模型:

七、总结

本文主要介绍了如何在本地安装Ollama、Open-WebUI,并介绍了Open-WebUI、Dify结合Ollama的一些玩法,还有更多高阶功能等待你去探索。

AI大模型学习福利

作为一名热心肠的互联网老兵,我决定把宝贵的AI知识分享给大家。 至于能学习到多少就看你的学习毅力和能力了 。我已将重要的AI大模型资料包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

大模型&AI产品经理如何学习

求大家的点赞和收藏,我花2万买的大模型学习资料免费共享给你们,来看看有哪些东西。

1.学习路线图

第一阶段: 从大模型系统设计入手,讲解大模型的主要方法;

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

2.视频教程

网上虽然也有很多的学习资源,但基本上都残缺不全的,这是我自己整理的大模型视频教程,上面路线图的每一个知识点,我都有配套的视频讲解。

(都打包成一块的了,不能一一展开,总共300多集)

因篇幅有限,仅展示部分资料,需要点击下方图片前往获取

3.技术文档和电子书

这里主要整理了大模型相关PDF书籍、行业报告、文档,有几百本,都是目前行业最新的。

4.LLM面试题和面经合集

这里主要整理了行业目前最新的大模型面试题和各种大厂offer面经合集。

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。

1.AI大模型学习路线图

2.100套AI大模型商业化落地方案

3.100集大模型视频教程

4.200本大模型PDF书籍

5.LLM面试题合集

6.AI产品经理资源合集

👉获取方式:

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

24万+

24万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?