上一篇我们介绍了使用 langchain 来搭建一个简单的本地知识库系统 使用langchain搭建本地知识库系统(新) - 掘金 (juejin.cn). 介绍了以下内容:

- 现在

LLM存储的一些问题 - 什么是

RAG RAG的检索流程、- 构建

RAG示例代码

总体上对 langchain 已经有一个简单的认识。本篇文章我们从langchain 输入输出(message/output) 开始介绍相关的知识内容。

环境安装

我们使用 openAI 的 model 演示示例,如果你还没有一个 openAI 的账户, 你可以使用自己已经拥有的 model 即可。

首先我们需要安装相关的依赖包:

shell复制代码 source .venv/bin/activate

pip install langchain-openai

pip install openai

配置相关的环境变量, 这里我们使用 AzureOpenAI 相关的服务。

python复制代码 import os

import dotenv

import openai

# from langchain_openai import AzureOpenAI

from langchain_openai import AzureOpenAI, AzureChatOpenAI

from langchain_openai import AzureOpenAIEmbeddings

我们初始化相关的模型,初始化模型需要相关模型的 secret 等配置,你可以根据自己实际的情况配置即可。

python复制代码 dotenv.load_dotenv(".env")

# embeddingModel = AzureOpenAIEmbeddings(

# model=os.getenv("AZURE_OPENAI_EMBEDDING_MODEL")

# )

# 实例化 AzureOpenAI

llm = AzureOpenAI(

deployment_name="gpt-35-turbo",

azure_deployment="gpt-35-turbo"

)

# 实例化 AzureChatOpenAI

chat_llm = AzureChatOpenAI(

azure_deployment="gpt-35-turbo",

openai_api_version="2023-05-15"

)

如果你不想在环境配置设置,你可以直接在初始化相关类的时候传递相关的参数即可,建议设置环境变量或者配置在

.env的配置文件中:

python复制代码 llm = AzureOpenAI(

deployment_name="gpt-35-turbo-instruct-0914",

)

llm 与 chat_llm 便是特定模型的对象,如果你使用的跟我不一样,那你可以根据自己的 LLM 配置即可。

temperature 参数主要的区别是他们的输入输出模式,LLM 对象将字符串作为输入和输出。chat_llm对象将消息作为输入并输出消息。相关的差异我们稍后介绍。

当我们分别调用 llm 和 chat_llm 的时候我们观察两个输出的区别:

输入 message

python复制代码 from langchain_core.messages import HumanMessage

text = "What would be a good company name for a company that makes colorful socks?"

message = HumanMessage(content=text)

# llm.invoke(text)

# >> Feetful of Fun

chat_llm.invoke(text)

# AIMessage(content='VibrantSock Co.')

我们可以看到 llm 输出的是一个字符串, 而chat_llm输出的是一个AIMessage类型消息.

prompt

大多数的 LLM 并不会将用户的输入直接传递给 LLM 内部,通常他们会将用户的输入添加到一个较大的文本中,成为 prompt . 在前面的示例中, 我们传递给 LLM 的文本包含生成公司名称的指令,对于我们的应用程序,如果用户只需要提供公司的产品描述而不必提供相关的型号说明 What would be a good company name for a company that makes {product}?,langchain 给我们提供了相关的函数,我们可以很简单的将变化的内容替换成我们自己想设置的任何值。

PromptTemplate 正好可以帮助我们解决这个问题,他们提供了从用户输入到完全格式化的提示所有的逻辑,所以使用起来还是比较简单的。比如:

python复制代码 from langchain.prompts import PromptTemplate

template = "What would be a good company name for a company that makes {product}?"

prompt = PromptTemplate.from_template(template=template)

prompt.format(product="color socks")

‘What would be a good company name for a company that makes color socks?’

我们可以看到,langchain 已经帮我们格式化了字符串. 这样我们只需要输入关键字的内容 product="color socks" 即可。 与原始字符串格式化相比,使用它们有几个优点。可以部分输出变量

例如,我们一次只能格式化部分变量。您可以将它们组合在一起,轻松地将不同的模板组合成一个提示。

PromptTemplates 也可用于生成消息列表。在这种情况下,提示不仅包含有关内容的信息,还包含每条消息(其角色、在列表中的位置等)。在这里,最常使用的是 ChatPromptTemplate 。每个都ChatMessageTemplate包含格式化ChatMessage以及对应的角色,然后还有它的内容。让我们看看下面这个:

python复制代码 from langchain.prompts.chat import ChatPromptTemplate

# 我们使用一个通用翻译 prompt

template = "You are a helpful assistant that translates {input_language} to {output_language}."

hum_template = "{text}"

chat_prompt = ChatPromptTemplate.from_messages(

[

("system", template),

("human", hum_template)

]

)

chat_prompt.format_messages(

input_language="English", output_language="Chinese", text="I love programming.")

[SystemMessage(content=‘You are a helpful assistant that translates English to Chinese.’), HumanMessage(content=‘I love programming.’)]

输出后的结果:

[SystemMessage(content=‘You are a helpful assistant that translates English to Chinese.’), HumanMessage(content=‘I love programming.’)]

这里很明显可以看到格式化后的 message 分为两部分:SystemMessage 与 HumanMessage

- SystemMessage 也被称为角色设定

- HumanMessage 是用户的聊天内容

输出

OutputParser 将语言模型的原始输出转换为可以在下游使用的格式。有几种主要类型 OutputParser,包括:

- 将文本转换LLM为结构化信息(例如 JSON)

- 将转换ChatMessage为字符串

- 将除消息之外的调用返回的额外信息(如 OpenAI 函数调用)转换为字符串。

python复制代码 from langchain.output_parsers import CommaSeparatedListOutputParser

output_parser = CommaSeparatedListOutputParser()

output_parser.parse("foo, bar, baz")

# CommaSeparatedListOutputParser 解析LLM调用的输出为逗号分隔的列表。

# > ['foo', 'bar', 'baz']

使用 LLM

我们现在可以将所有这些组合成一条链。该链将获取输入变量,将这些变量传递给提示模板以创建提示,将提示传递给语言模型,然后通过(可选)输出解析器传递输出。这是模块化逻辑块的便捷方法。我们来看看它的实际效果!

python复制代码 template = "Generate a list of 5 {text}.\n\n{format_instructions}"

chat_prompt = ChatPromptTemplate.from_template(template)

chat_prompt = chat_prompt.partial(

format_instructions=output_parser.get_format_instructions())

chain = chat_prompt | chat_llm | output_parser

chain.invoke({"text": "colors"})

# >> ['red', 'blue', 'green', 'yellow', 'orange']

我们在使用 | 语法将这些组件连接在一起。该 | 语法是 LangChain 表达式语言 LCEL 提供支持,并依赖于Runnable所有这些对象实现的通用接口.

我们解释一下上面代码 chain = chat_prompt | chat_llm | output_parser 的执行流程:

开始 chat_prompt -> chat_llm -> output_parser 将 prompt 的内容输入到 llm 中,llm 返回的内容到 output_parser 中,langchain 已经帮助我们做了这些事情,我们只需要关注输入已经输出即可。

做过 openAI 的都知道,如果我们没有使用 langchain ,我们需要这么做:

- 自己格式化

prompt里面的变量 - 将

prompt传给llm并获取到输出ouput - 将

output输出的字符串内容格式化为我们想要的结果list[str],如果需要特定格式的数据,我们需要自定义他们

以上这些复杂的步骤langchain 已经帮我们做了很多。

总结:

我们今天讨论了 langchain 的prompt输入以及output输出.

1、输入我们使用 ChatPromptTemplate 来构建输入,ChatPromptTemplate 可以用来构建一个比较复杂的 prompt, 他会构造一个 list[Message] 的列表,并在输入到 llm 的时候会自动格式化相关的字符串。也就是当我们跟 LLM 去对话的时候,我们的输入的内容需要与 LLM 的保持一致,langchain 帮助我们做到了这一点。

2、对于输出 output,我们同样不需要自己去解相关返回值,langchain 可提供了很多的函数,比如常用的 StructuredOutputParser, JsonOutputToolsParser 等等。方便我们在解析不同的输出格式的情况下的数据解析过程。

3、使用 LCEL 将 prompt、llm、output 等流程结合起来,后续我们还会看到很多这样的用法,也就是 langchain 的核心能力。

读者福利:如果大家对大模型感兴趣,这套大模型学习资料一定对你有用

对于0基础小白入门:

如果你是零基础小白,想快速入门大模型是可以考虑的。

一方面是学习时间相对较短,学习内容更全面更集中。

二方面是可以根据这些资料规划好学习计划和方向。

资源分享

大模型AGI学习包

资料目录

- 成长路线图&学习规划

- 配套视频教程

- 实战LLM

- 人工智能比赛资料

- AI人工智能必读书单

- 面试题合集

《人工智能\大模型入门学习大礼包》,可以扫描下方二维码免费领取!

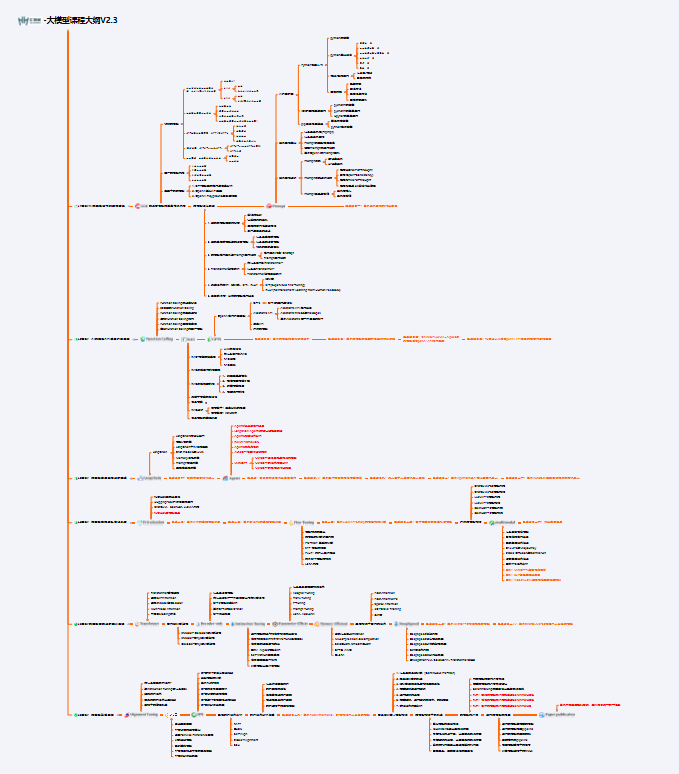

1.成长路线图&学习规划

要学习一门新的技术,作为新手一定要先学习成长路线图,方向不对,努力白费。

对于从来没有接触过网络安全的同学,我们帮你准备了详细的学习成长路线图&学习规划。可以说是最科学最系统的学习路线,大家跟着这个大的方向学习准没问题。

2.视频教程

很多朋友都不喜欢晦涩的文字,我也为大家准备了视频教程,其中一共有21个章节,每个章节都是当前板块的精华浓缩。

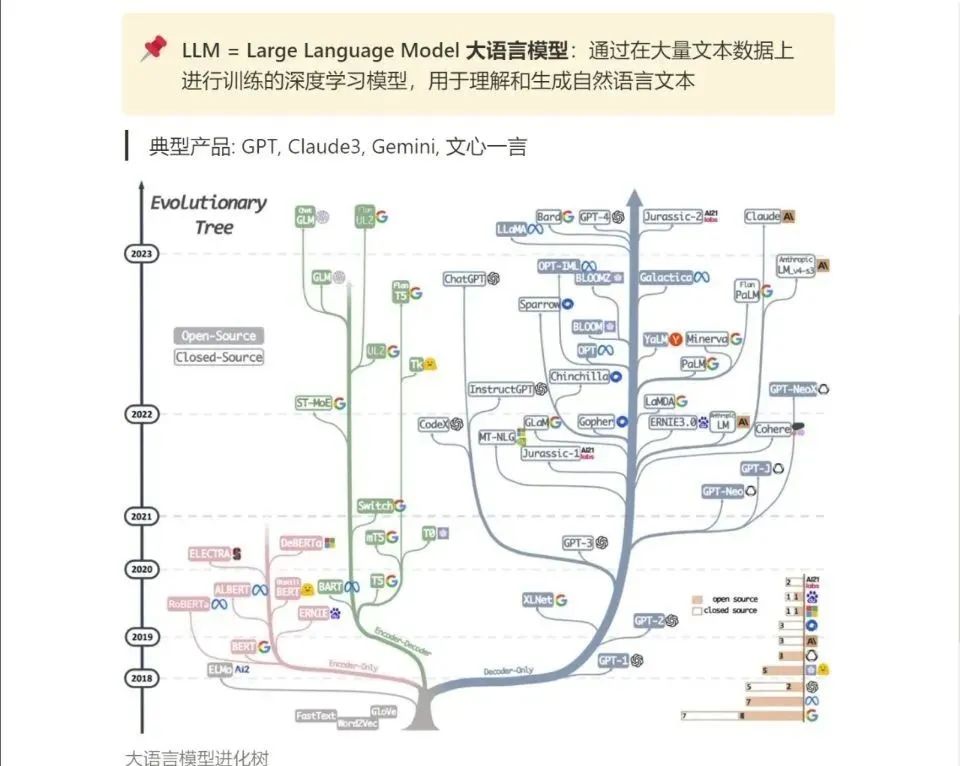

3.LLM

大家最喜欢也是最关心的LLM(大语言模型)

《人工智能\大模型入门学习大礼包》,可以扫描下方二维码免费领取!

2563

2563

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?