专家混合模型(MoE)在机器学习中,特别是在扩大大型语言模型(LLM)方面,已成为一项重要的创新。这些模型旨在管理处理海量数据所需的日益增长的计算需求。通过在单一模型中利用多个专门的专家,MoE 架构可以高效地将特定任务路由到最合适的专家,从而优化性能。这种方法在自然语言处理 (NLP) 中尤为有益,因为同时处理多样且复杂的任务对于实现准确性和效率至关重要。

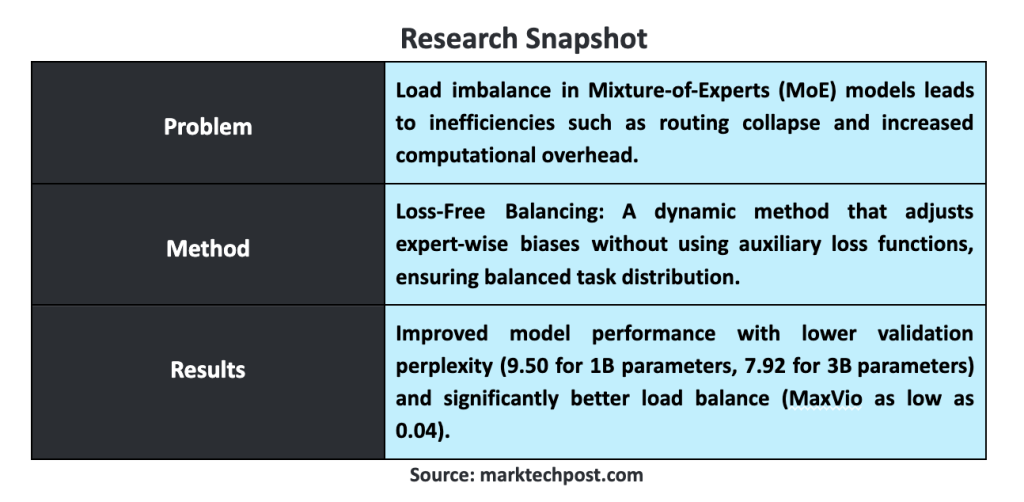

MoE 模型面临的最显著挑战之一是专家之间的负载不平衡。在这些模型中,一些专家可能会由于任务过多而过载,而另一些专家则得不到充分利用,导致效率低下。这种不平衡可能导致路由崩溃,模型反复选择少数几个专家,从而阻碍整体的训练过程。此外,任务分配不均增加了计算开销,因为模型需要艰难地管理工作负载。解决这种不平衡至关重要,因为它直接影响到模型在处理大数据集和复杂语言处理任务时的最佳性能。

传统方法采用辅助损失函数来缓解负载不均问题。这些函数在专家之间任务分配不均时对模型进行惩罚,从而鼓励更平衡的负载分布。虽然这种方法可以帮助实现更好的平衡,但也引入了新的挑战。具体来说,辅助损失在训练过程中引入了干扰梯度,这与模型的主要目标——语言建模——发生冲突。这些不期望的梯度会损害模型的性能,使其难以平衡并同时保持高水平的语言处理任务准确性。这种取舍一直是 MoE 模型发展的持久问题。

DeepSeek-AI 和北京大学的研究人员开发了一种名为 无损平衡 的新方法。该方法通过动态调整任务路由,而无需辅助损失函数。在不引入有害梯度的前提下,无损平衡专注于保持任务的均衡分配,不干扰模型的主要训练目标。这种方法使模型能够更高效地运行,确保所有专家都能被有效利用,同时不会损害性能。

无损平衡方法通过专家级偏置调整的动态过程运行。在做出路由决策之前,模型会对每个专家的路由分数应用偏置。这些偏置基于每个专家最近观测到的负载持续更新。例如,如果某个专家在最近的训练步骤中被大量使用,其偏置会向下调整以减少其负载。相反,如果某个专家未被充分利用,其偏置会增加,鼓励模型向其路由更多任务。这个迭代过程确保模型在所有专家之间保持一致的任务平衡,提高效率和性能。

关于实验结果,无损平衡方法相比于传统的依赖辅助损失的策略有了显著提升。在对具有10亿(1B)参数、以1000亿(100B)个标记训练的MoE模型以及较大规模的具有30亿(3B)参数、以2000亿(200B)个标记训练的模型中进行的实验中,研究人员观察到在负载平衡和整体模型性能方面有显著的改善。例如,在使用无损平衡的情况下,验证困惑度(一个衡量模型性能的重要指标)在1B参数模型中降低到9.50,在3B参数模型中降低到7.92。该方法实现了全球负载平衡最大违例(MaxVio)仅为0.04,明显优于使用辅助损失控制方法得到的结果。这些发现突显了无损平衡方法在保持负载分布均衡的同时提升模型自然语言处理能力的有效性。

研究团队还探索了各种配置和调整,以进一步优化无损平衡方法。他们尝试了不同的偏差更新率和规则,以确定最有效的方法。例如,0.001的更新率在收敛速度和平衡稳定性之间提供了良好的平衡。在探索其他方法如乘法偏差时,研究人员得出结论,添加性偏差提供了更优越的性能和平衡。这些改进凸显了该方法的适应性及其在未来应用中的进一步优化潜力。

总之,无损平衡方法通过解决负载不均衡问题而未引入干扰梯度,使大规模语言模型的训练更加高效、有效。实验结果,包括降低的验证困惑度和改进的负载平衡指标,展示了这种方法在提高MoE模型在各种应用中的性能潜力。

总结:

专家混合模型(MoE)在处理大型数据集和复杂自然语言处理任务方面展示了显著优势,特别是在机器学习领域。其通过在单一模型中利用多个专家来优化特定任务的性能,使得计算更加高效。然而,MoE模型面临着负载不平衡的问题,即一些专家可能会过载,而其他专家却得不到充分利用,从而导致整体效率低下。传统方法通过辅助损失函数来缓解这一问题,但这会引入干扰梯度,影响模型的主要训练目标。

为了克服这些挑战,DeepSeek-AI和北京大学的研究人员开发了“无损平衡”方法。无损平衡不依赖辅助损失函数,而是通过动态调整任务路由来维持负载平衡。在不影响主要训练目标的前提下,该方法对每个专家的路由分数进行动态偏置调整,确保任务的均衡分配。这一创新显著提升了模型的运行效率和整体性能。在实验中,无损平衡方法在1B参数和3B参数的MoE模型中表现出色,验证困惑度分别降低到9.50和7.92,负载平衡指标MaxVio也显著优化。

这种新方法展示了在自然语言处理任务中提高模型性能的巨大潜力。未来,通过继续优化偏差更新率和规则,研究人员期望进一步提升无损平衡方法的适应性和效率。

7万+

7万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?