书接上篇:分别使用Page Assist和AnythingLLM接入deepseek模型,并上传及分析本地知识:

AI入门:AI模型管家婆ollama的安装和使用-CSDN博客

AI入门2:本地AI部署,用ollama部署deepseek(私有化部署)-CSDN博客

AI入门3:给本地deepseek设置网页访问方式(UI插件Page Assist 安装)_deepseek本地部署网页访问-CSDN博客

AI入门4:基于Ollama+DeepSeek,用Page Assist搭建本地知识库-CSDN博客

AI入门5:基于Ollama+DeepSeek,用AnythingLLM搭建本地知识库-CSDN博客

本节介绍用RAGFlow搭建本地知识库,RAG(Retrieval-Augmented Generation)结合了检索和生成的技术,主要用于提升内容生成的质量和效率,RAGFlow则是RAG技术的一种具体实现,它通过模块化的方式组织RAG系统,提高了系统的灵活性和可扩展性。

和Page Assis,以及AnythingLLM相比,知识库命中率更高,软件体积更大,技术难度也更高,大家根据自己的情况选择。

准备工作

ollama和deepseek安装设置好,具体操作参考,上面AI入门1和2。

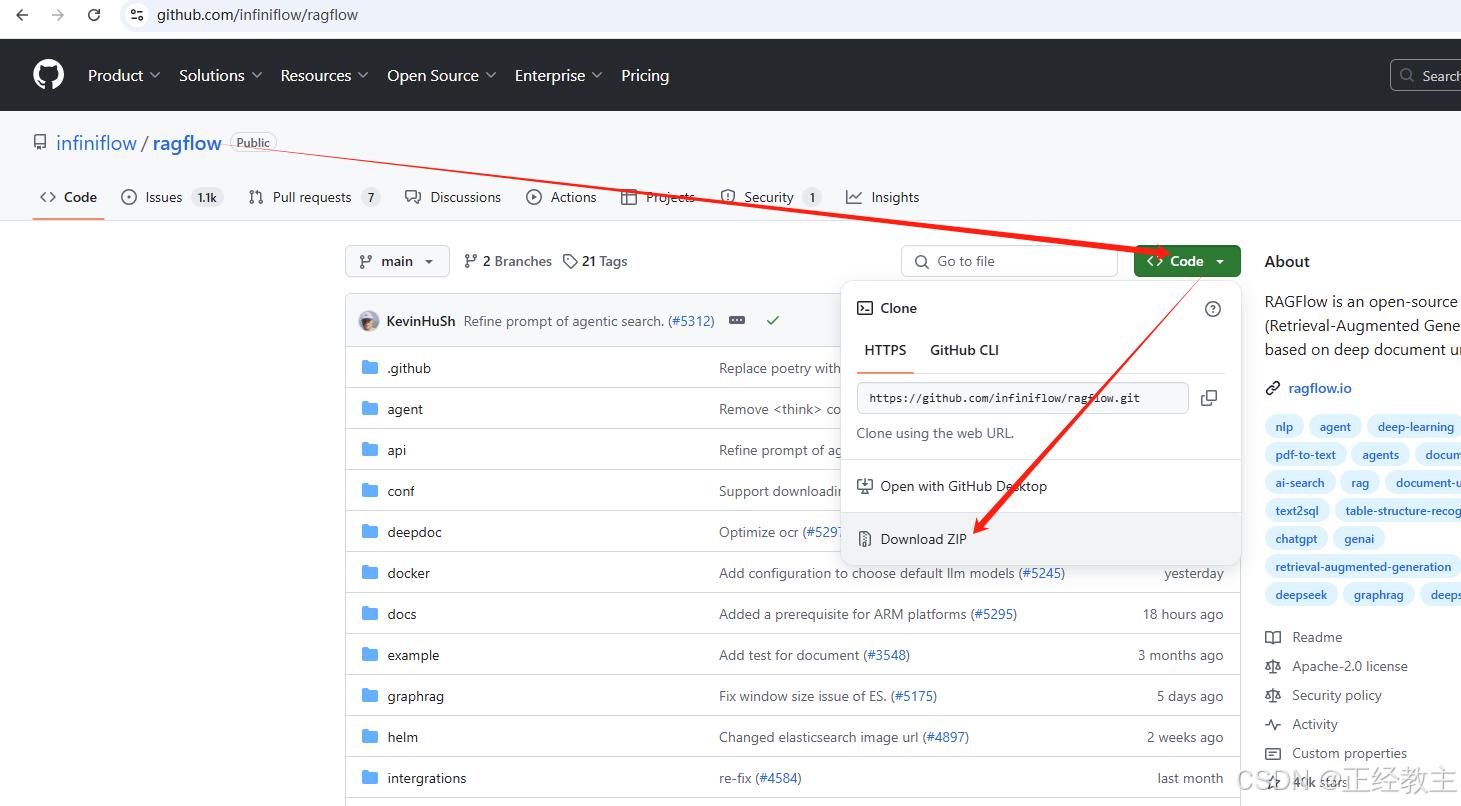

下载ragflow

在GitHub平台,下载ragflow,在百度搜索:GitHub ragflow

进入下载界面:

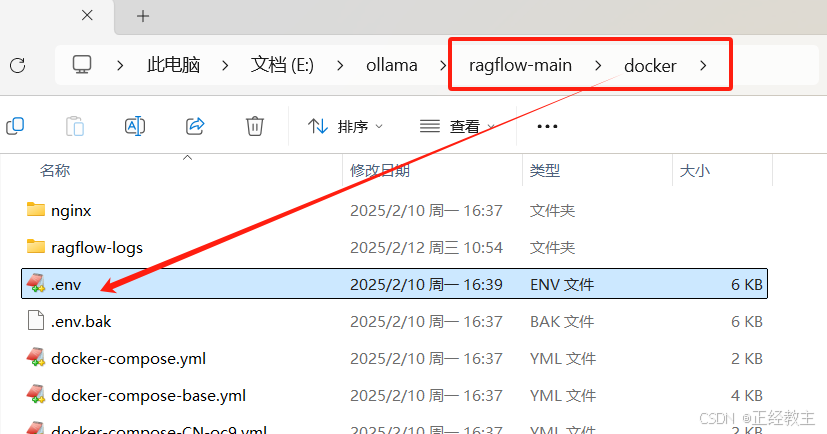

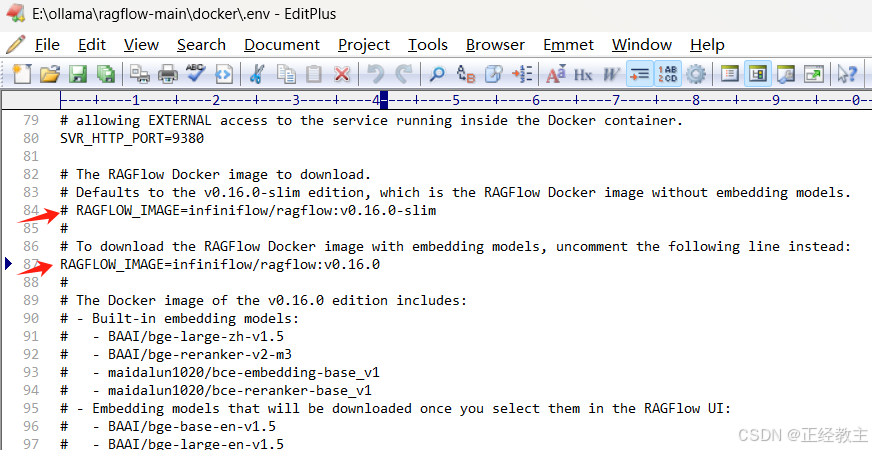

下载,解压后,在其docker目录,找到配置文件.env

编辑.env,找到RAGFLOW_IMAGE参数,把slim版本这一行注释掉,把下面完全版本的放开,因为完全版才有内置了的Embedding模型和Reranker模型,slim版本没有:

安装docker

下载后,安装过程很简单,就是有可能遇到安装环境的问题,大家参考:

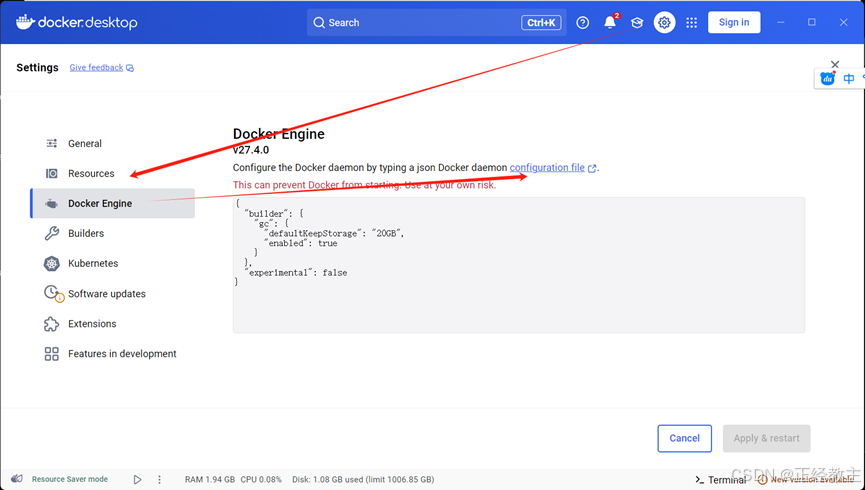

docker设置(很重要)

打开docker,进入“settings”:

在docker engine里,设置docker的镜像信息,如果镜像不可用,后面的操作就会失败,我尝试了多次,所以下面的镜像看起来有了冗余,但是管用:

{

"builder": {

"gc": {

"defaultKeepStorage": "20GB",

"enabled": true

}

},

"experimental": false,

"features": {

"buildkit": true

},

"registry-mirrors": [

"https://docker.m.daocloud.io",

"https://docker.1panel.live",

"https://registry.docker-cn.com",

"https://cr.console.aliyun.com",

"https://mirror.ccs.tencentyun.com",

"https://huecker.io/",

"https://dockerhub.timeweb.cloud",

"https://noohub.ru/",

"https://dockerproxy.com",

"https://docker.mirrors.ustc.edu.cn",

"https://docker.nju.edu.cn",

"https://xx4bwyg2.mirror.aliyuncs.com",

"http://f1361db2.m.daocloud.io",

"https://registry.docker-cn.com",

"http://hub-mirror.c.163.com",

"https://docker.mirrors.ustc.edu.cn",

"https://docker.registry.cyou",

"https://docker-cf.registry.cyou",

"https://dockercf.jsdelivr.fyi",

"https://docker.jsdelivr.fyi",

"https://dockertest.jsdelivr.fyi",

"https://mirror.aliyuncs.com",

"https://dockerproxy.com",

"https://mirror.baidubce.com",

"https://docker.m.daocloud.io",

"https://docker.nju.edu.cn",

"https://docker.mirrors.sjtug.sjtu.edu.cn",

"https://docker.mirrors.ustc.edu.cn",

"https://mirror.iscas.ac.cn",

"https://docker.rainbond.cc"

]

}安装ragflow

到刚才下载完成的ragflow-main文件夹下,在上面这个路径输入cmd,进入命令行,输入命令

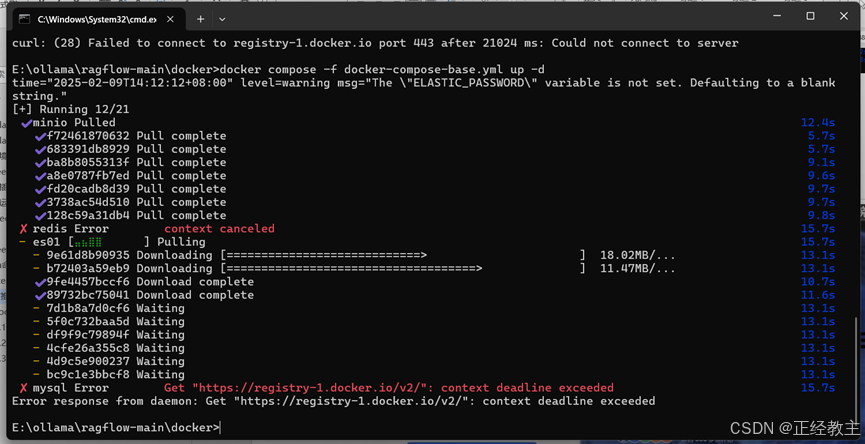

docker compose -f docker-compose.yml up -d如果正常执行完,就可以了,如果不顺利,可能遇到镜像拉不下来的情况,如下图:

解决问题参考文档已备好:

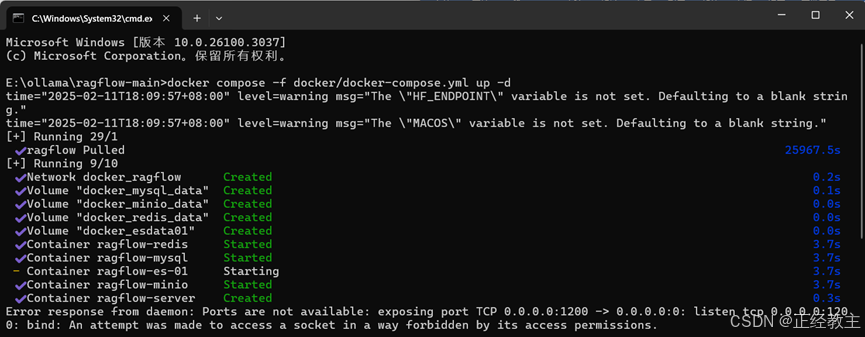

docker找不到镜像,无法成功下载ragflow-main的问题_ragflow报错error response from daemon-CSDN博客 如果很不凑巧,你有遇到了“Error response from daemon: Ports are not available: exposing port TCP 0.0.0.0:xxx -> 0.0.0.0:0: listen tcp 0.0.0.0:xxx: bind: An attempt was made to access a socket in a way forbidden by its access permissions.”错误,类似像这样:

解决问题参考文档已备好:

解决问题参考文档已备好:

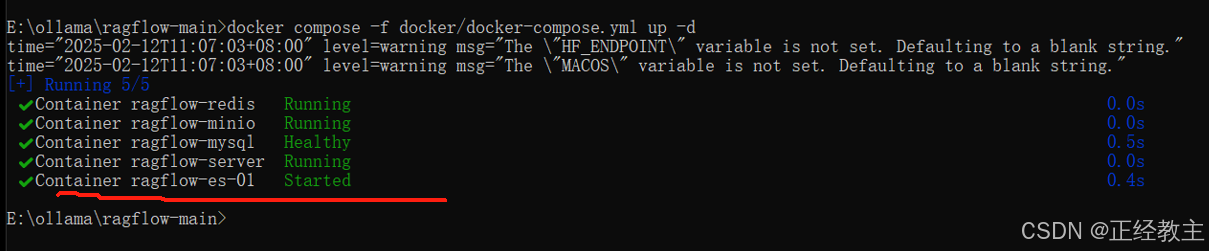

解决了重重问题,ragflow就会启动了:

配置 ragflow,添加模型

通过浏览器,http://localhost:80/ 访问ragflow,注册一个账号:

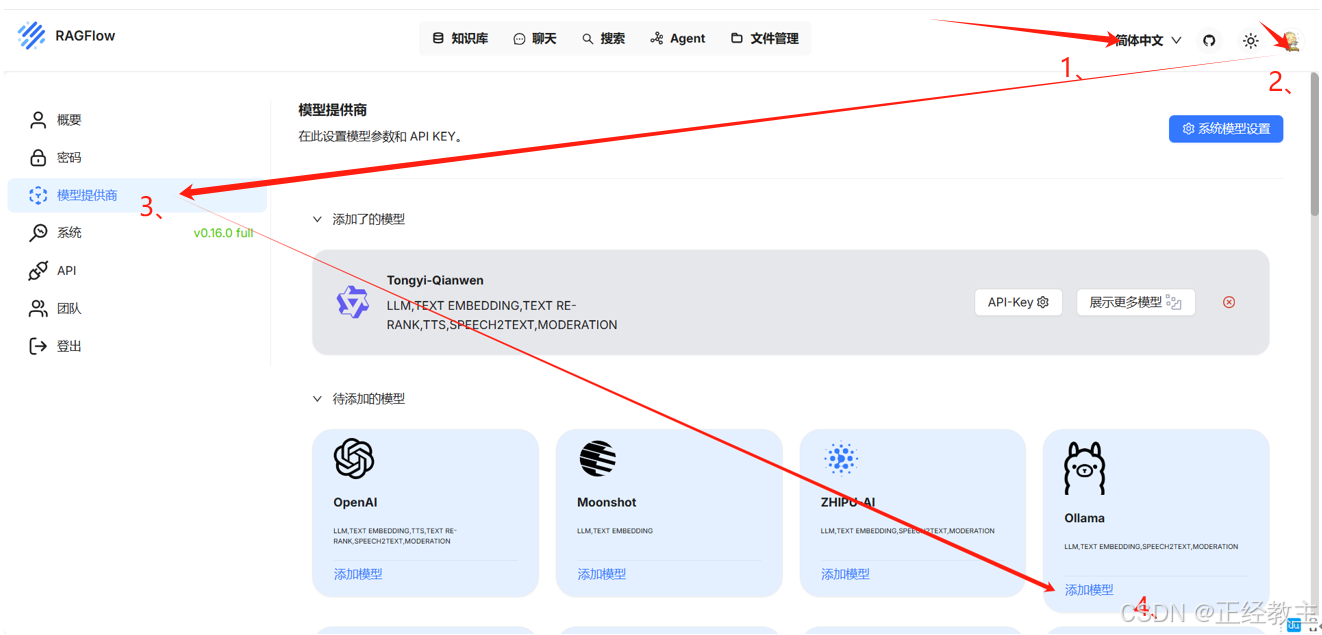

进行如下设置:

如图:

1、修改语言

2、点击头像,再选择“模型供应商”

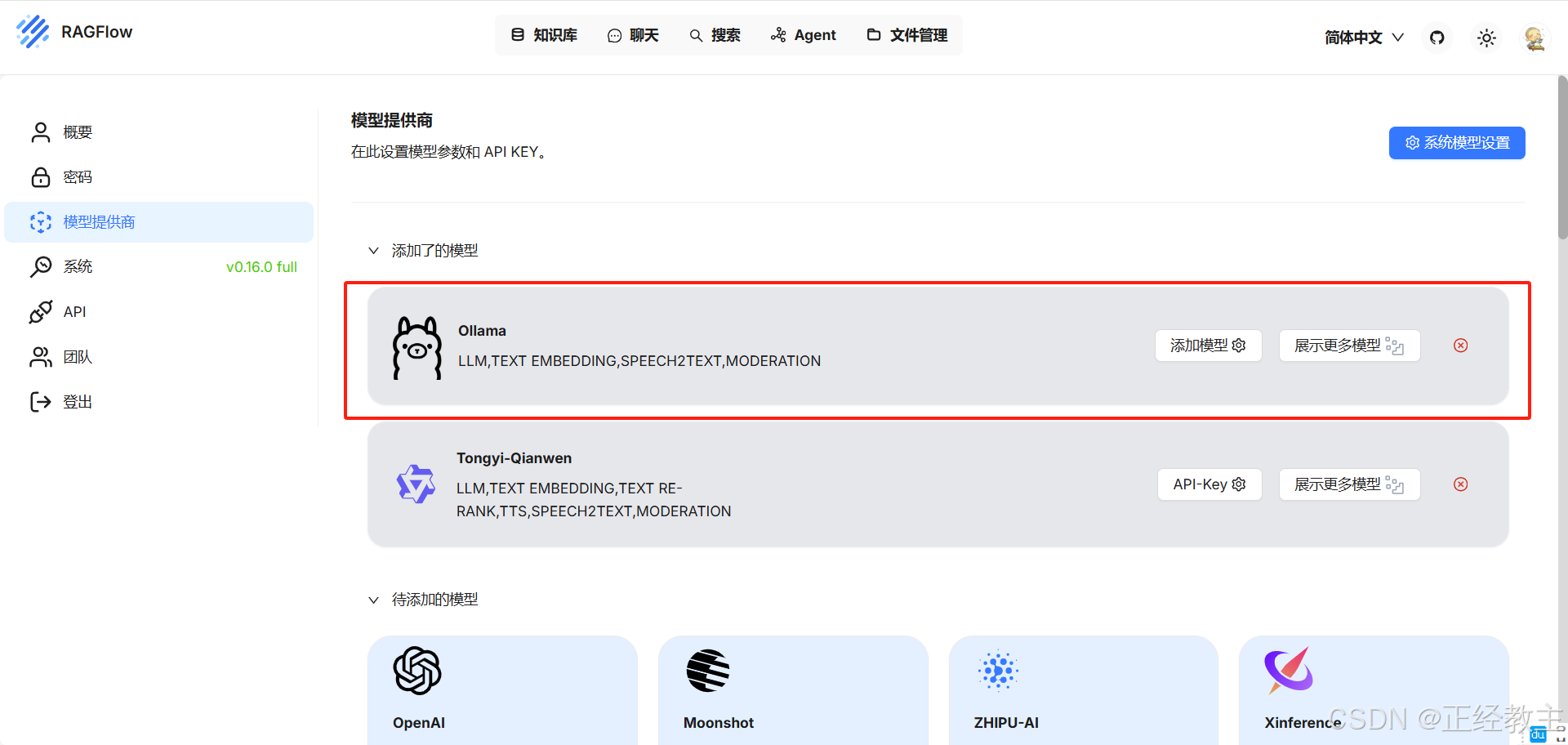

3、找到ollama,然后“添加模型”

填写模型信息:

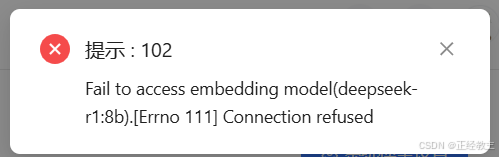

注意,上图基础url需要用真实ip(真实ip查看方式:win+r,输入cmd,输入命令ipconfig),用http://127.0.0.1:11434/报错:

用真实ip,正常保存显示如下:

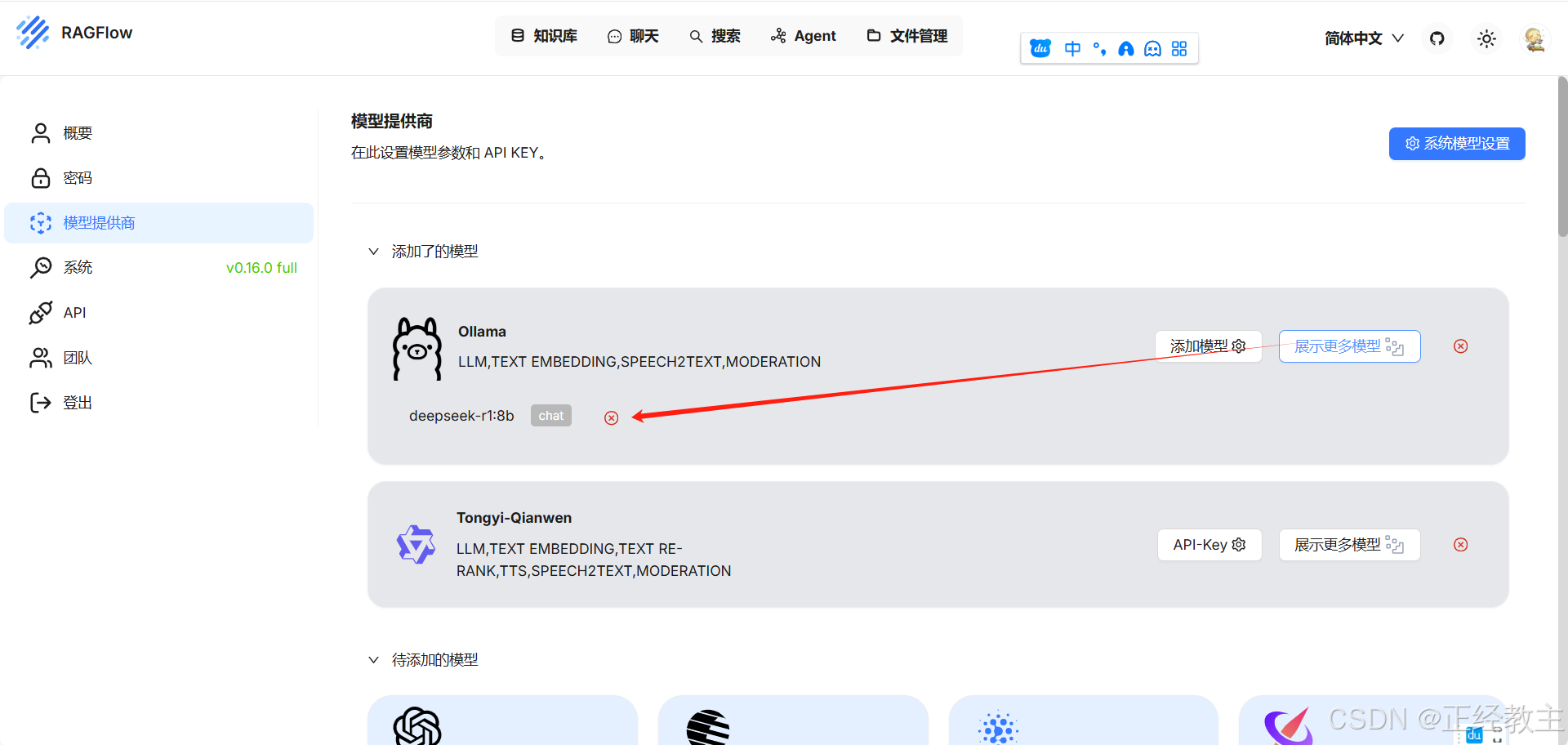

在ollama下,点击“显示更多模型”,可以查看及删除已设置模型:

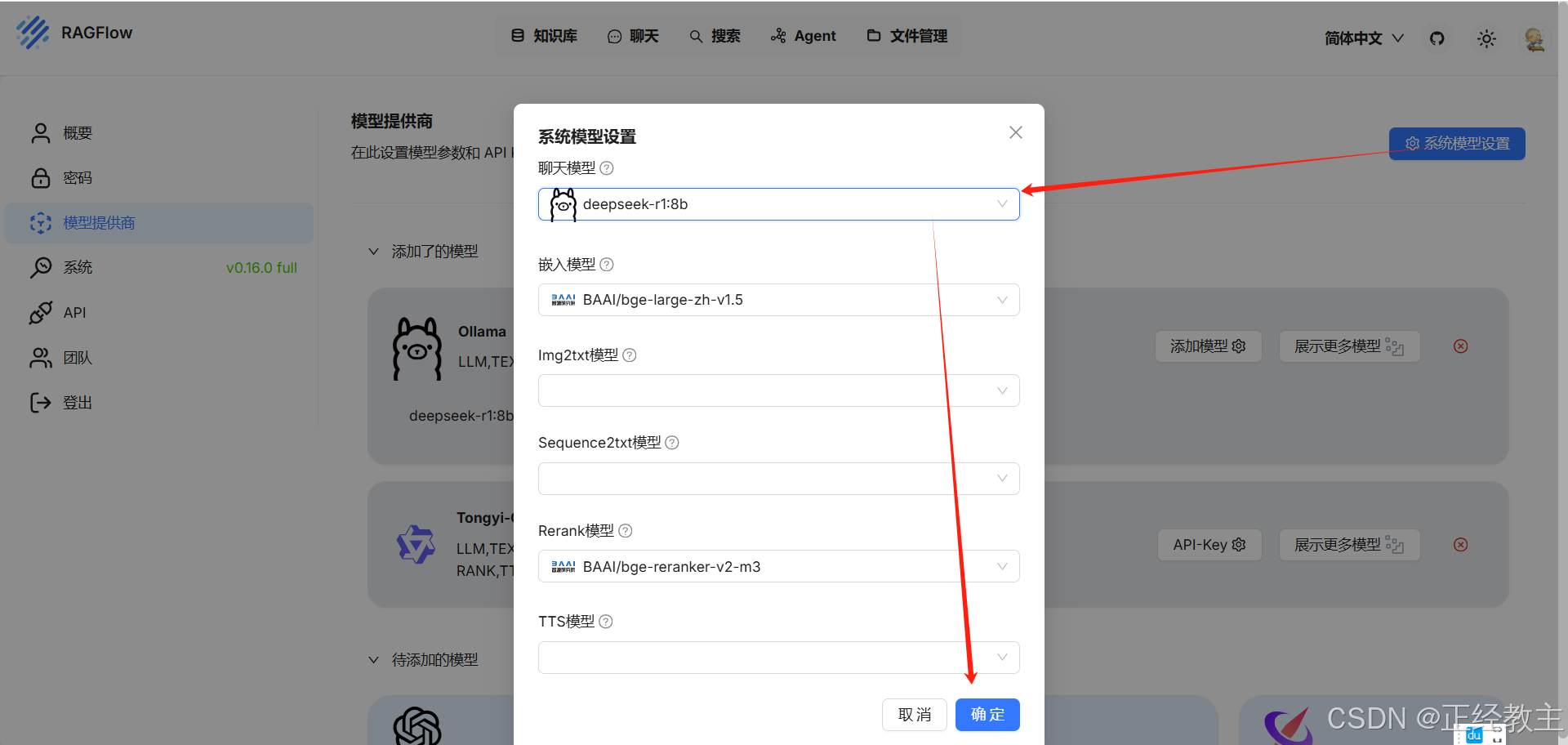

然后,点击“系统模型设置”,选择刚才添加的模型,确定即可。

设置知识库

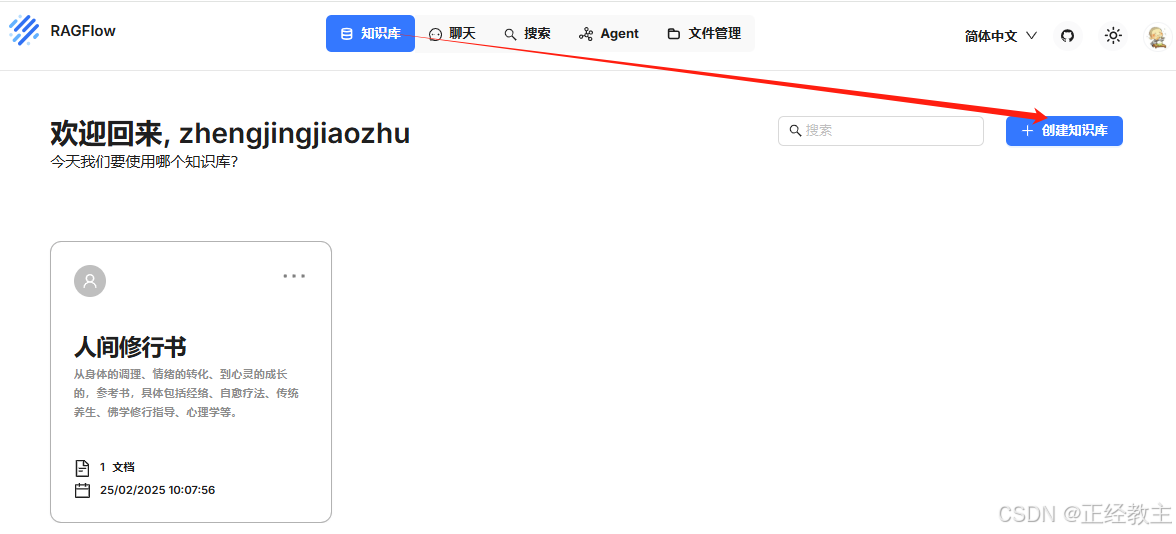

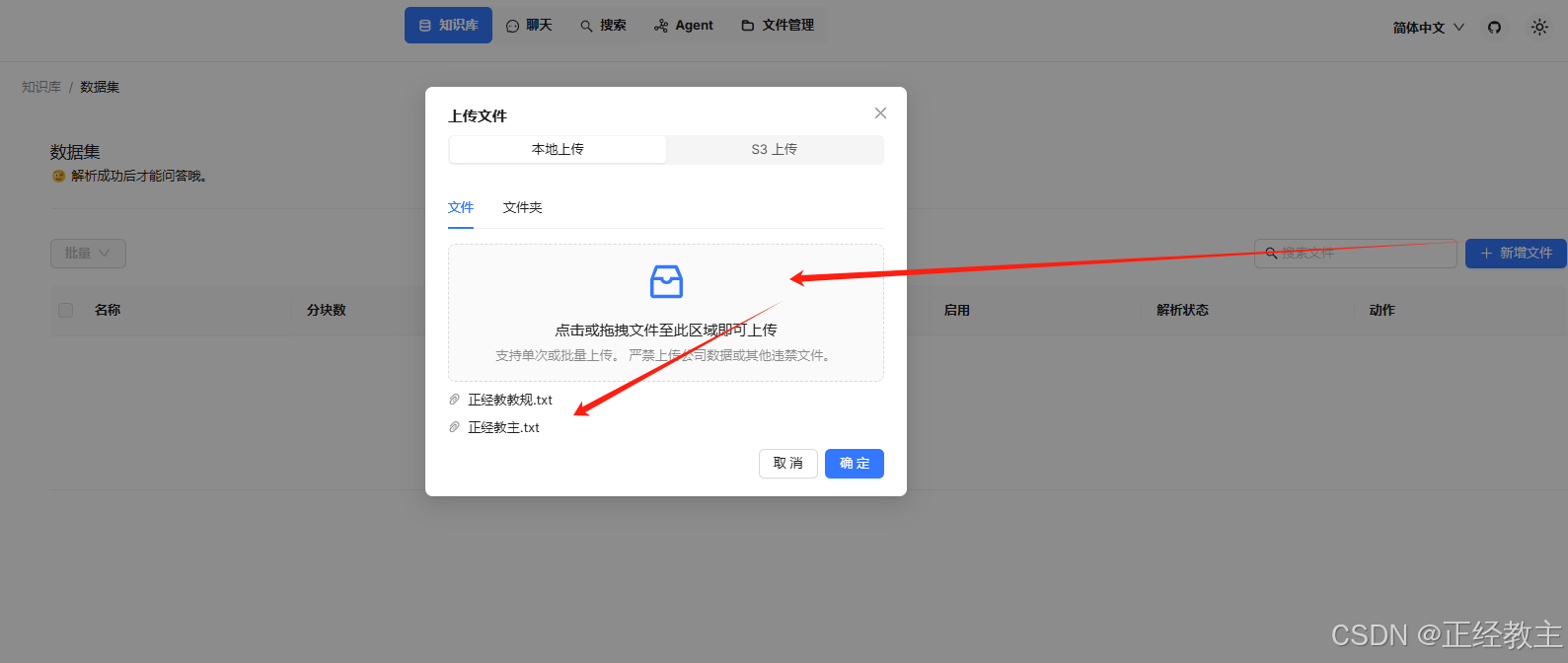

点击“知识库”标签,创建知识库:

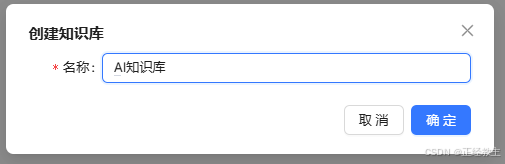

填写知识库名称:

设置“嵌入模型”、“解析方法”,鼠标点击每个条目旁边的?图标,会有解释:

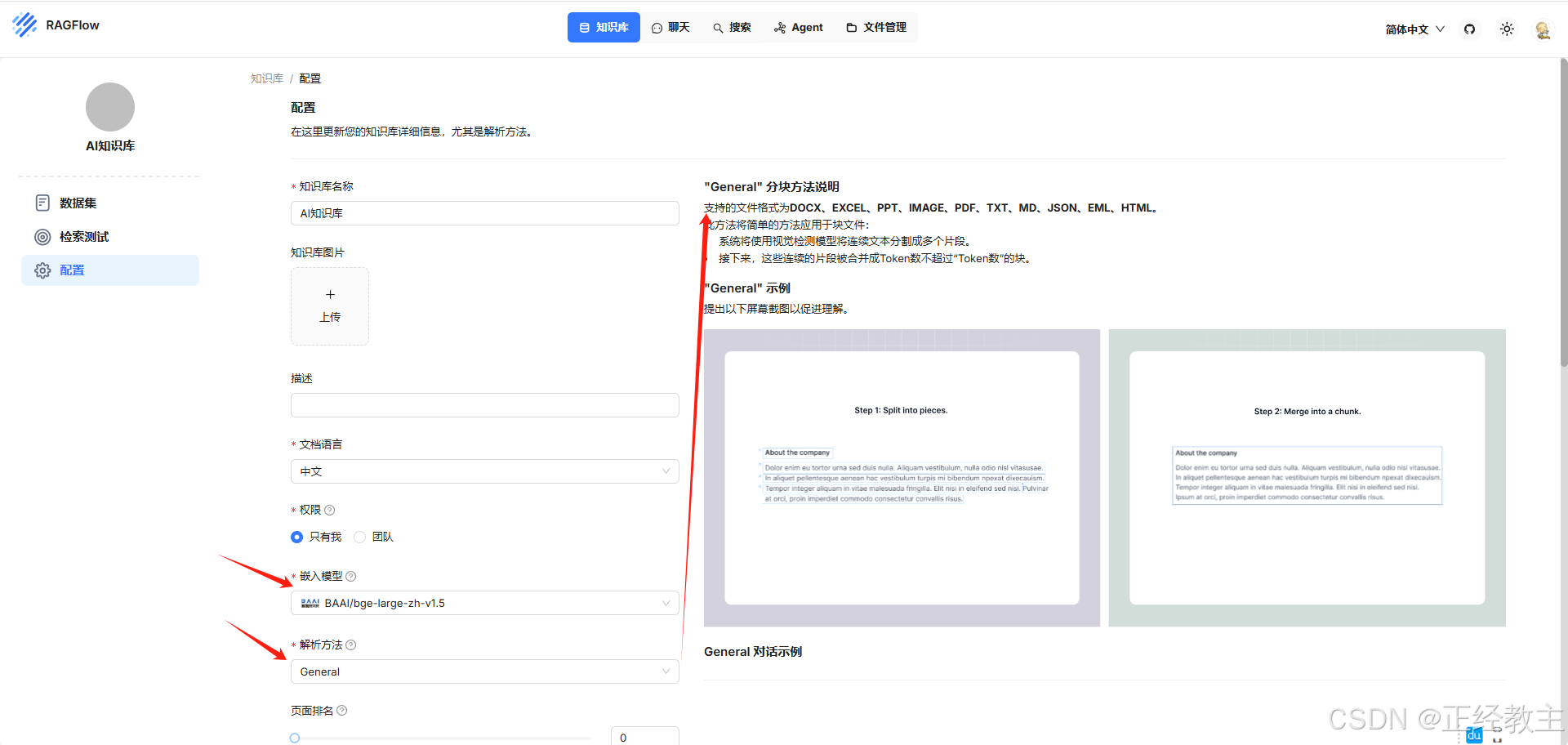

保存后,进入知识上传界面,点击“新增文件”,将文件拖进来:

保存后,进入知识上传界面,点击“新增文件”,将文件拖进来:

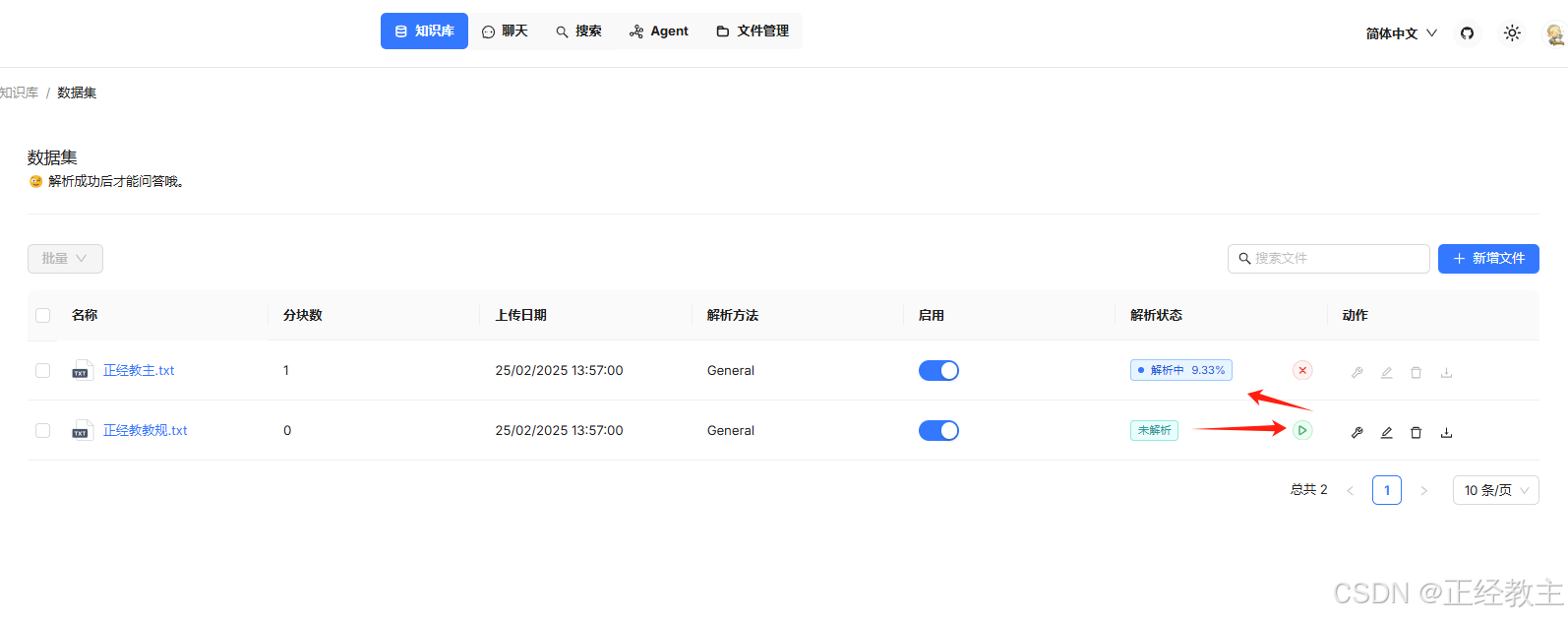

增加的文件,是未解析的状态,点击绿色运行按钮,进入解析

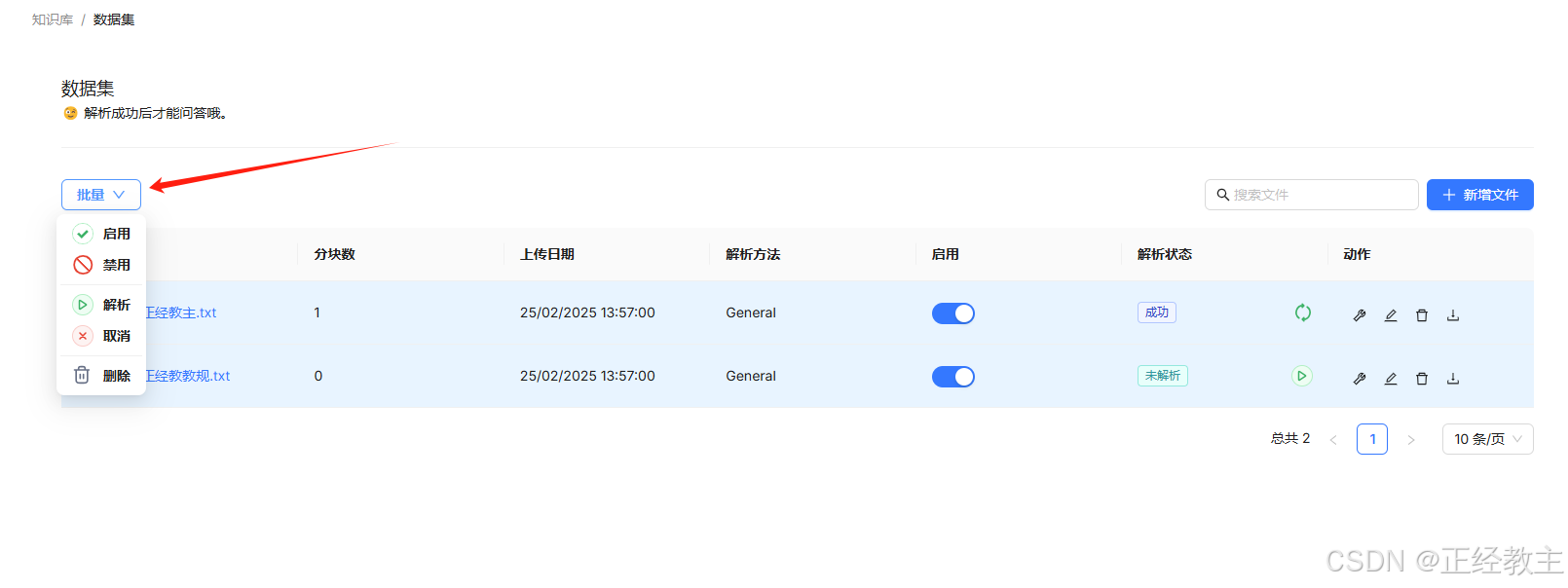

解析完成后,显示“成功”状态,也可以通过批量按钮,进行批量操作:

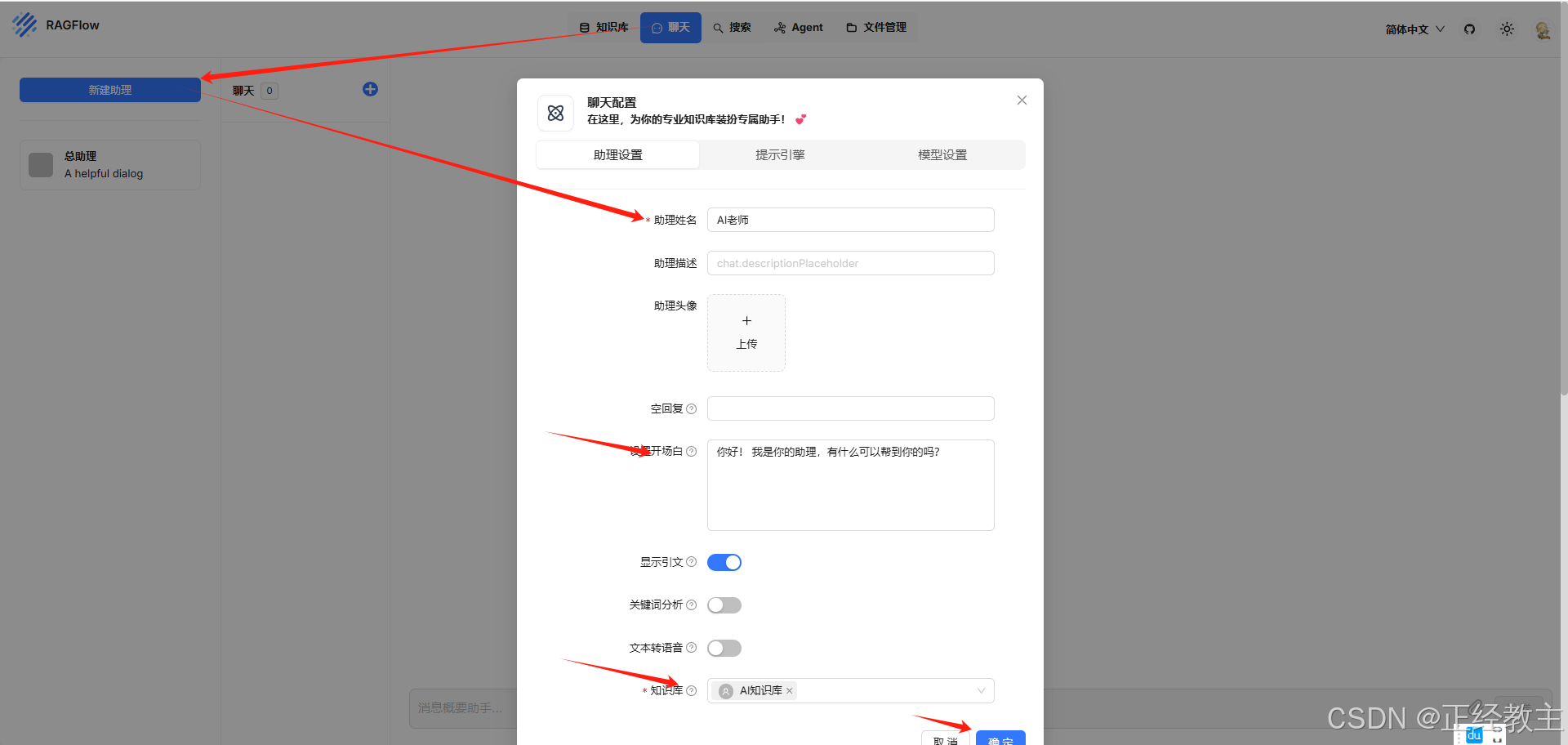

然后,老试试知识库,点击“聊天”标签,新建助理,选择助理所对应的知识库:

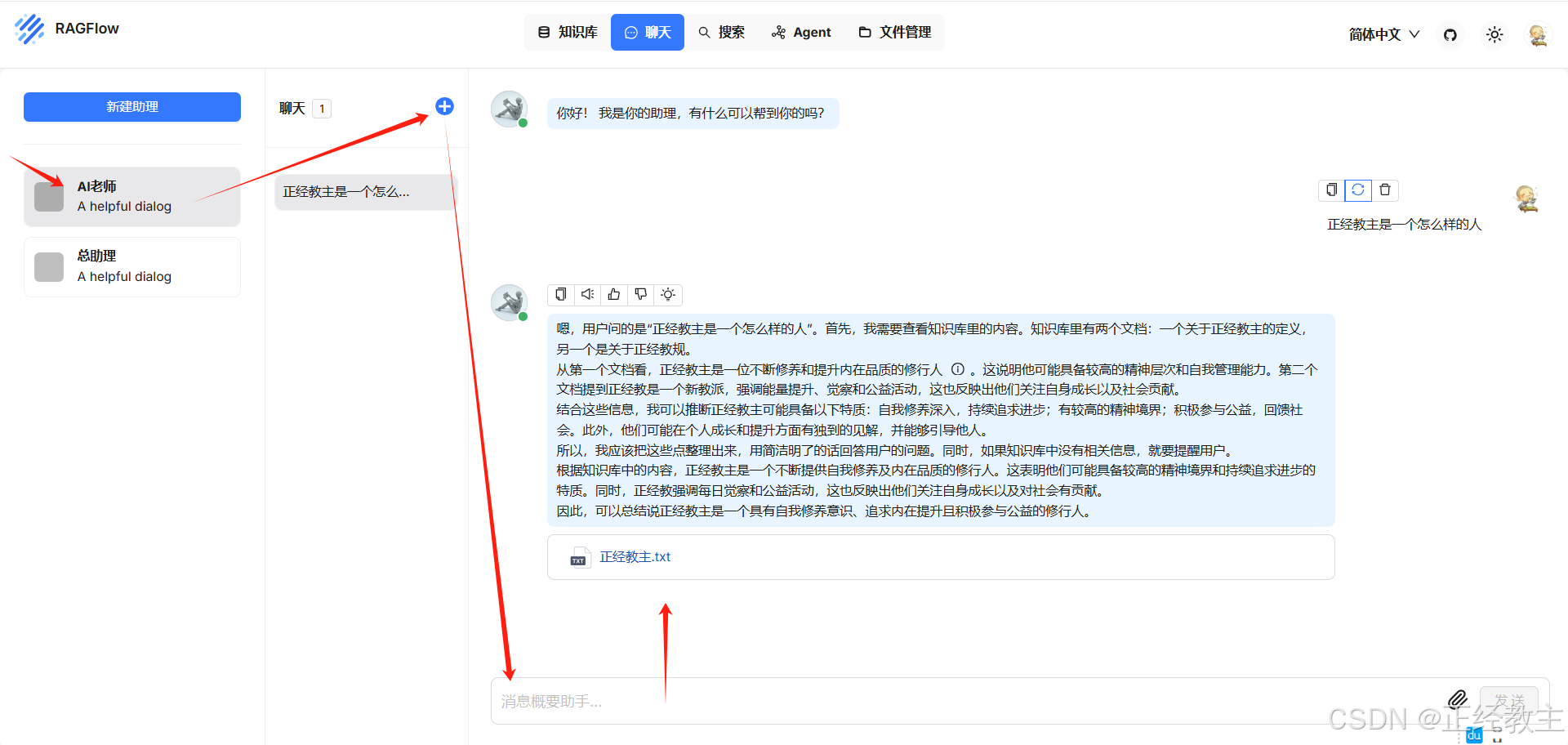

保存后,选择助手,新建一个聊天,问你的问题,就可以开始聊天了:

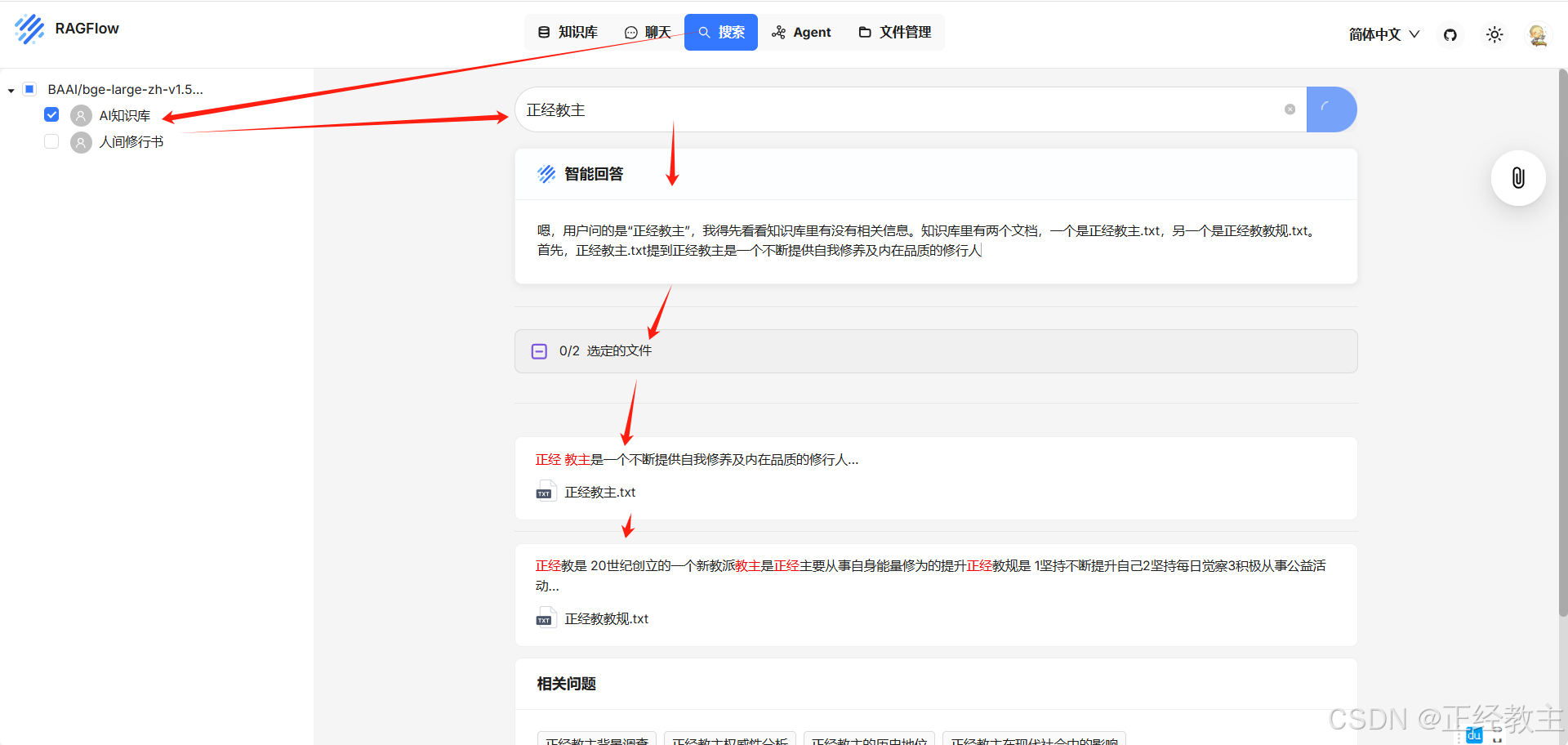

还可以点击“搜索”标签,直接对知识库进行搜索。

还可以点击“搜索”标签,直接对知识库进行搜索。

日常启动和关闭模型

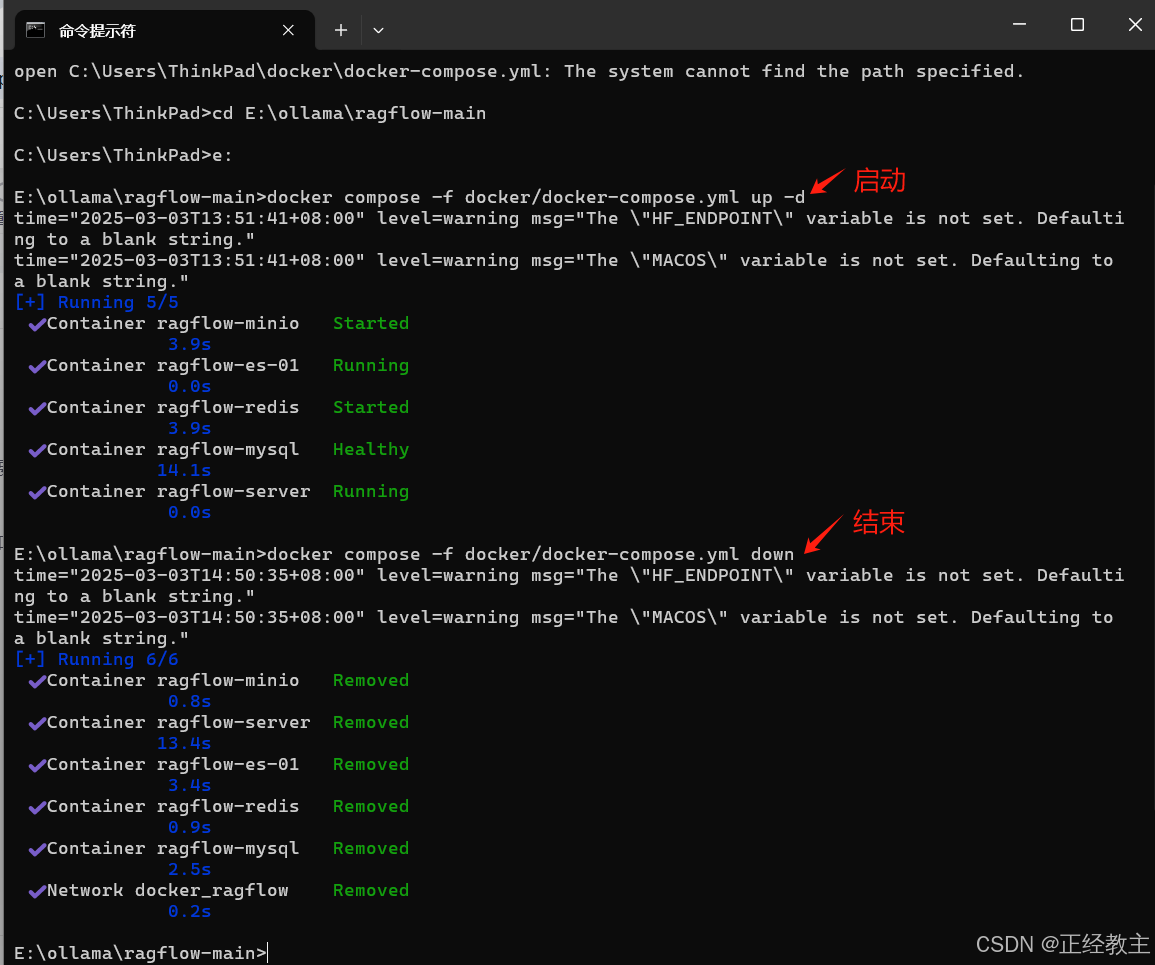

总结一下,日常启动,在ollama,和docker正常启动后(ollama和docker都有程序菜单,从开始中找到运行即可,运行后在右下角程序栏有运行图标),在doc窗口,先跳转到ragflow-main所在目录,执行命令:

docker compose -f docker/docker-compose.yml up -d不需要的时候,通过docker命令关闭模型,不然有点费资源:

docker compose -f docker/docker-compose.yml down然后,再关闭docker和ollama(右下角程序栏有运行图标,右键菜单中关闭)。

日常启动和关闭的执行界面参考:

其他

在系统使用过程中,如果遇到C盘越来越小,可以看看docker占用C盘过大的问题的处理:

**************本节内容华丽结束,主大家有个愉快的体验**************

522

522

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?