华为昇腾(Ascend)AI计算平台深度解析:从架构演进到实战部署

引言

在人工智能技术迅猛发展的今天,算力已成为推动模型创新与产业落地的核心引擎。面对全球AI芯片竞争格局,中国科技企业正加速构建自主可控的AI基础设施。其中,华为推出的昇腾(Ascend)AI计算平台,凭借其全栈自研、软硬协同和生态开放的特性,迅速成长为国产AI算力体系中的中坚力量。

昇腾不仅涵盖高性能AI芯片(如 Ascend 910B 和 Ascend 310P),还配套了完整的软件栈——包括底层驱动 CANN、深度学习框架 MindSpore、模型仓库 ModelZoo 以及面向边缘与云端的 Atlas 硬件产品线。这一整套解决方案,使得开发者能够从算法设计、训练优化到端侧部署实现无缝衔接。

本文将基于 hiascend.com 官方网站提供的最新资料,系统梳理昇腾平台的技术架构,并通过一段可运行的代码示例,展示如何在昇腾 NPU 上高效执行神经网络推理任务,帮助读者快速入门这一国产AI生态。

昇腾平台技术全景

1. 硬件基石:达芬奇架构的 AI 芯片

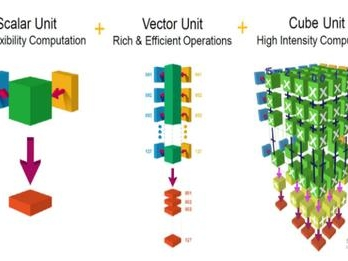

昇腾系列芯片采用华为自研的 达芬奇(Da Vinci)架构,其核心是三维立方体(Cube)计算单元,专为矩阵运算优化,极大提升了 AI 计算的能效比。

达芬奇架构总览图:展示了达芬奇架构的整体组成,包括计算单元、存储单元和控制单元等。具体如下:

达芬奇架构 AI Core 基本结构图:展示了 AI Core 的基本结构,包括三种基础计算资源及其相关的存储资源等。具体如下:

典型代表包括:

- Ascend 910B:用于大规模分布式训练,FP16 算力高达 256 TFLOPS,支持多卡高速互联(HCCS)。

- Ascend 310P:面向边缘推理场景,INT8 算力达 64 TOPS,功耗低至 8W,适用于智能摄像头、工业质检等终端设备。

2. 软件栈:CANN 与 MindSpore 的协同

- CANN(Compute Architecture for Neural Networks) 是昇腾芯片的异构计算架构,提供驱动、运行时、图编译器(Graph Engine)、算子库(如 AclLite、TBE)等组件,是连接硬件与上层框架的“操作系统”。

- MindSpore 作为华为开源的全场景 AI 框架,原生支持昇腾硬件,具备自动并行、图算融合、内存复用等高级优化能力,显著提升训练与推理效率。

3. 生态支撑:ModelZoo 与 Atlas 系列

华为通过 hiascend.com 提供了丰富的预训练模型(覆盖 CV、NLP、语音等领域)和硬件产品(如 Atlas 300I 推理卡、Atlas 500 智能小站),支持从数据中心到边缘节点的灵活部署。

Atlas 300I A2 推理卡:融合 “通用处理器、AI Core、编解码” 于一体,提供超强 AI 推理、目标检索等功能。

Atlas 300I Duo 推理卡:同样融合 “通用处理器、AI Core、编解码”,具有强算力、高能效、高性能视频分析等优势。

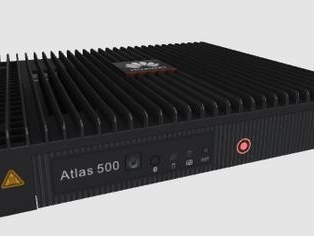

Atlas 500 智能小站:是面向边缘应用的产品,具有超强计算性能、体积小、环境适应性强等特点。

实战演练:在昇腾 NPU 上运行图像分类推理

下面我们将使用 MindSpore 框架,在昇腾设备上加载一个 ResNet-18 模型并执行图像分类推理。该示例假设你已配置好昇腾开发环境(包括 CANN 7.0+、MindSpore Ascend 版本及驱动)。

import mindspore as ms

from mindspore import Tensor

from mindspore.nn import Softmax

import numpy as np

# 设置运行上下文:指定使用 Ascend 设备(device_id 可根据实际调整)

ms.set_context(device_target="Ascend", device_id=0)

# 从 MindSpore Hub 加载预训练的 ResNet-18 模型(针对 Ascend 优化)

try:

from mindspore_hub import load_model

model = load_model('resnet18_ascend_v1')

print("✅ 成功加载 ResNet-18 模型")

except ImportError:

raise RuntimeError("请安装 mindspore-hub: pip install mindspore-hub")

# 构造模拟输入:一张 224x224 的 RGB 图像(batch_size=1)

input_data = np.random.uniform(0.0, 1.0, size=[1, 3, 224, 224]).astype(np.float32)

input_tensor = Tensor(input_data)

# 执行前向推理

output = model(input_tensor)

# 应用 Softmax 获取类别概率

probabilities = Softmax()(output)

# 输出 Top-5 预测结果

topk_values, topk_indices = ms.ops.topk(probabilities, 5)

print("🔍 预测结果(Top-5 类别索引与概率):")

for i in range(5):

print(f" 类别 {topk_indices[0][i].asnumpy()}: {topk_values[0][i].asnumpy():.4f}")

环境准备提示:

确保已安装 CANN 工具包(可通过 npu-smi info 验证 NPU 状态)

设置关键环境变量,例如:

bash

编辑

export ASCEND_HOME=/usr/local/Ascend/ascend-toolkit/latest

export PATH=$ASCEND_HOME/compiler/ccec_compiler/bin:$PATH

export LD_LIBRARY_PATH=$ASCEND_HOME/lib64:$LD_LIBRARY_PATH

若使用 Docker 开发,推荐使用华为官方提供的 Ascend 镜像(见 hiascend.com 文档)

**昇腾平台的独特优势

1. 全栈自研,安全可控**

昇腾平台构建了从底层硬件到上层软件的完整技术栈,实现了真正的自主可控。具体体现在:

1.芯片层面:采用自主研发的达芬奇架构NPU,支持独创的AI指令集

2.基础软件:CANN(Compute Architecture for Neural Networks)提供芯片使能层

3.框架层:MindSpore深度学习框架实现端边云全场景覆盖

典型应用场景:

1.政务领域:可满足等保2.0三级认证要求

2.金融行业:支持模型训练数据不出域

3.能源系统:通过国密算法保障电力调度安全

**2. 极致性能优化**

平台通过多层次优化实现性能突破:

编译器优化:

1.自动算子融合:将多个算子合并执行,减少内存访问开销

2.智能内存复用:动态管理显存分配,提升利用率30%以上

3.流水线调度:实现计算与数据传输重叠

分布式训练:

1.支持数据并行、模型并行、流水线并行混合策略

2.千卡集群线性加速比可达90%

3.典型案例:1750亿参数大模型训练周期从月级缩短至周级

**3. 开放生态与社区支持**

昇腾构建了完善的开发者支持体系:

开发资源:

1.3000+页技术文档(含中文/英文版本)

2.200+个开源模型(涵盖CV/NLP/推荐等场景)

开发工具:

1.ModelArts在线实验室(提供免费算力资源)

2.全流程调试工具链(从模型迁移到性能调优)

社区互动:

1.技术论坛日均活跃用户超5000人

2.每周定期举办线上/线下技术沙龙

3.认证工程师培养计划(年培养人才超万人)

**结语**

昇腾AI计算平台不仅是一套硬件产品,更是一个面向未来的国产AI基础设施生态。它以“硬件+软件+算法+应用”四位一体的模式,正在赋能千行百业的智能化转型。无论是高校科研、企业研发,还是国家重大工程,昇腾都提供了可靠、高效、安全的算力底座。

随着大模型时代的到来,昇腾也在持续进化——例如对 MoE 架构、混合精度训练、稀疏计算等前沿技术的支持日益完善。我们有理由相信,在不久的将来,昇腾将成为全球AI算力版图中不可或缺的一极。

如果你尚未尝试过国产AI平台,不妨从今天开始,访问 hiascend.com,下载 SDK,跑通你的第一个 NPU 程序。或许,下一个 AI 创新的火花,就将在昇腾之上点燃。

2025年昇腾CANN训练营第二季,基于CANN开源开放全场景,推出0基础入门系列、码力全开特辑、开发者案例等专题课程,助力不同阶段开发者快速提升算子开发技能。获得Ascend C算子中级认证,即可领取精美证书,完成社区任务更有机会赢取华为手机,平板、开发板等大奖。

报名链接:https://www.hiascend.com/developer/activities/cann20252

94

94

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?