在利用Stable Diffusion生成角色图片时,一个常见的问题是如何保持角色的一致性。目前,大多数人的解决方案是训练一个LoRA模型。在训练一个固定的形象角色中,最重要的是面部特征,其次是体型、服装、配饰等。

对于现实人物,我们可以通过照片进行训练。但是,如果要训练一个动漫角色或由AI生成的角色呢?训练一个动漫角色的一个现有解决方案是上网搜索该角色的图片或截图。然而,这些图片往往需要后续处理,因为它们大多不清晰,会耗费大量时间。

目前,AI生成的角色很难保持一致性,随机性较高。因此,在收集训练集时,需要花费大量时间。为了解决这个问题,可以尝试以下方法:

1

前期设置

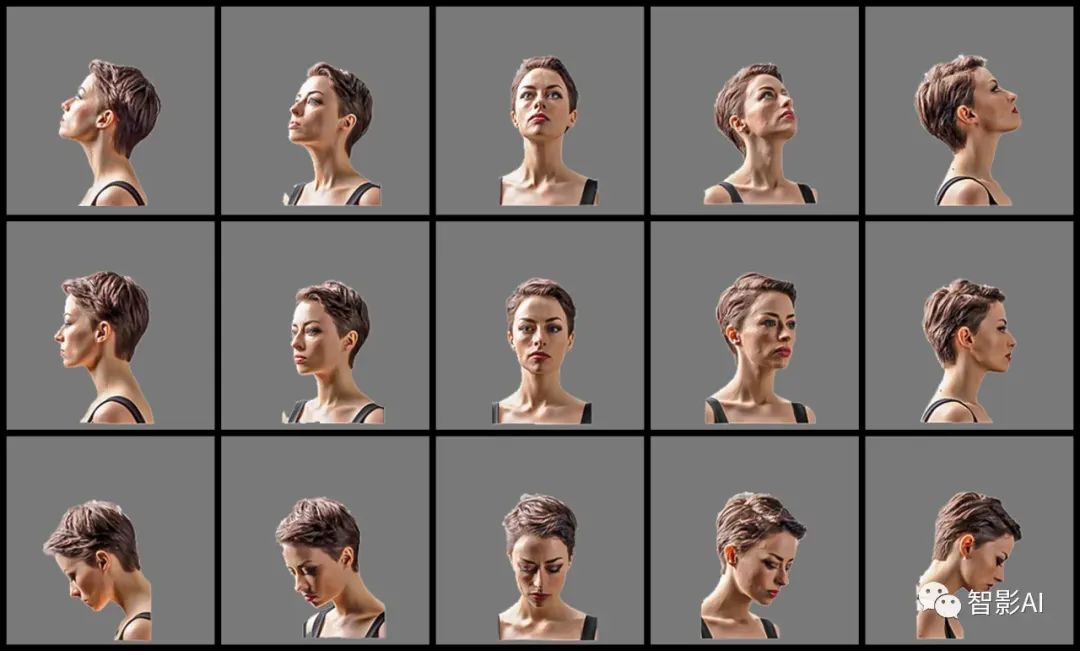

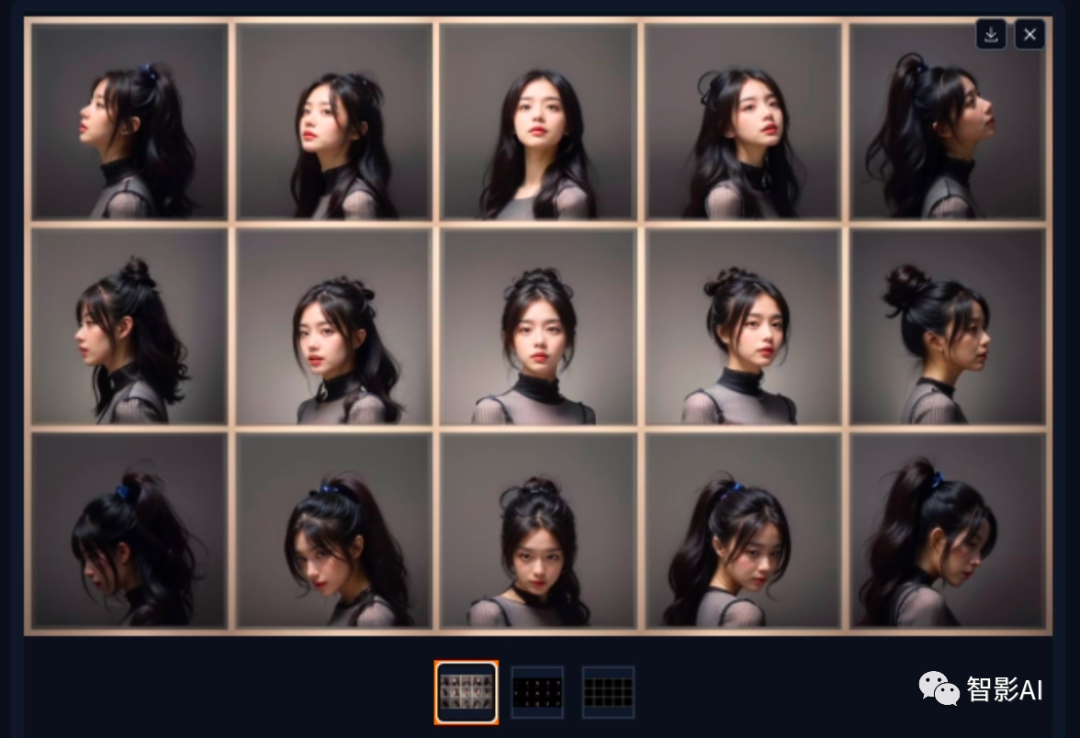

1、在开始生图之前,需要准备两张图片:一张是一个包含15个不同角度的人脸图片,用于生成不同角度的人脸的OpenPose骨骼图,另一张是一个包含15个格子的网格图片,用于引导SD将15张图像保留在特定的框内。

(15个角度的人脸图片)

(15个格子的网格图片)

2、在准备好上述两张图片后,接下来需要设置ControlNet。将第一张图片(包含15个不同角度的人脸图片)上传到“ControlNet”的“Unit0”中,并勾选“完美像素模式”,选择“OpenPose”模型。

3、点击“ControlNet Unit1”,上传第二张图片(包含15个格子的网格图片),并勾选“完美像素模式”,选择“Lineart”模型。

4、可以使用“ADetailer”防止脸部崩坏(可开可不开,开了生成图片的速度会变慢,如果选择不开,可以等待图片生成完成之后,利用放大来修复脸部。)

2

生成图片

设置好上述所有的设置之后,就可以开始写提示词,设置生成图片的参数啦!

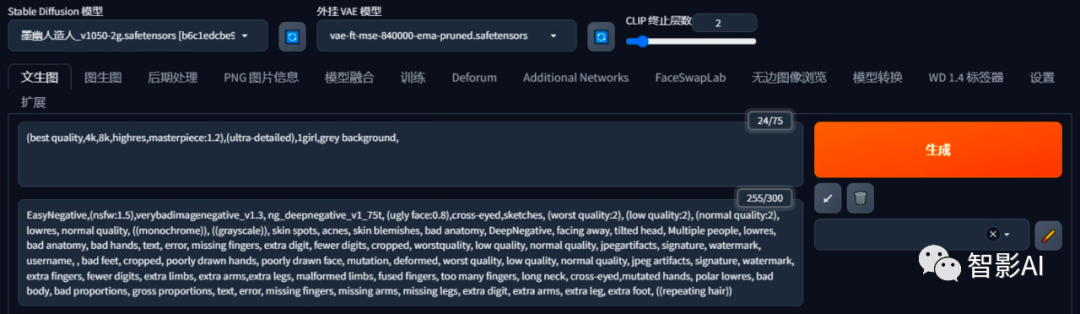

1、选择一个模型,输入正向提示词以及反向提示词。

(以下是我输入的提示词,可以根据自己的需求输入任意提示词)

正向提示词:(best quality,4k,8k,highres,masterpiece:1.2),(ultra-detailed),1girl,grey background

反向提示词:EasyNegative,(nsfw:1.5),verybadimagenegative_v1.3, ng_deepnegative_v1_75t, (ugly face:0.8),cross-eyed,sketches, (worst quality:2), (low quality:2), (normal quality:2), lowres, normal quality, ((monochrome)), ((grayscale)), skin spots, acnes, skin blemishes, bad anatomy, DeepNegative, facing away, tilted head, Multiple people, lowres, bad anatomy, bad hands, text, error, missing fingers, extra digit, fewer digits, cropped, worstquality, low quality, normal quality, jpegartifacts, signature, watermark, username, , bad feet, cropped, poorly drawn hands, poorly drawn face, mutation, deformed, worst quality, low quality, normal quality, jpeg artifacts, signature, watermark, extra fingers, fewer digits, extra limbs, extra arms,extra legs, malformed limbs, fused fingers, too many fingers, long neck, cross-eyed,mutated hands, polar lowres, bad body, bad proportions, gross proportions, text, error, missing fingers, missing arms, missing legs, extra digit, extra arms, extra leg, extra foot, ((repeating hair))

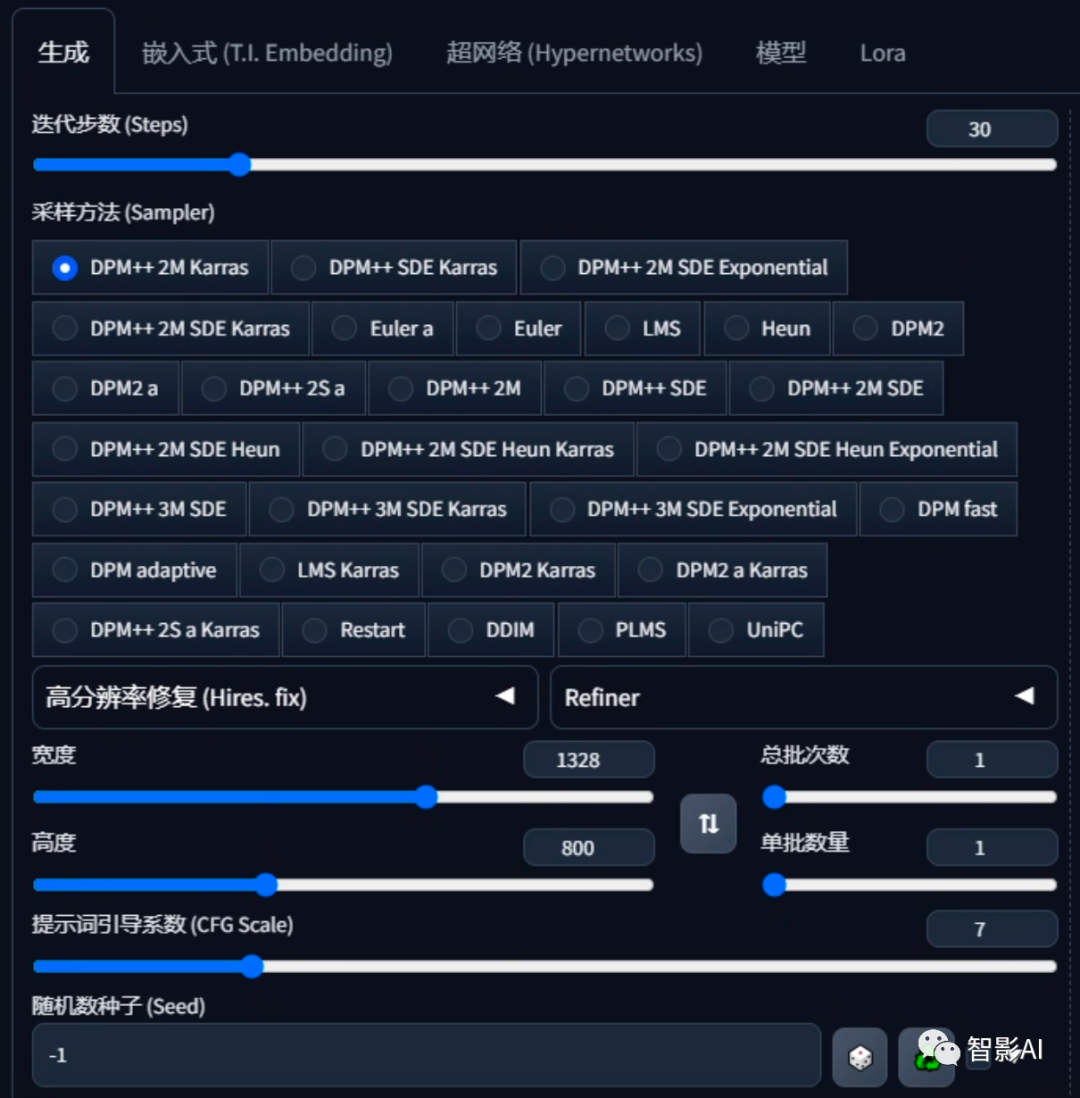

2、设置生成参数:这里主要是尺寸,1328*800,需要跟“ControlNet”上的两张图片一样的大小,其他的可以根据自己的需求设置。

3、设置完成之后,点击“生成”即可

3

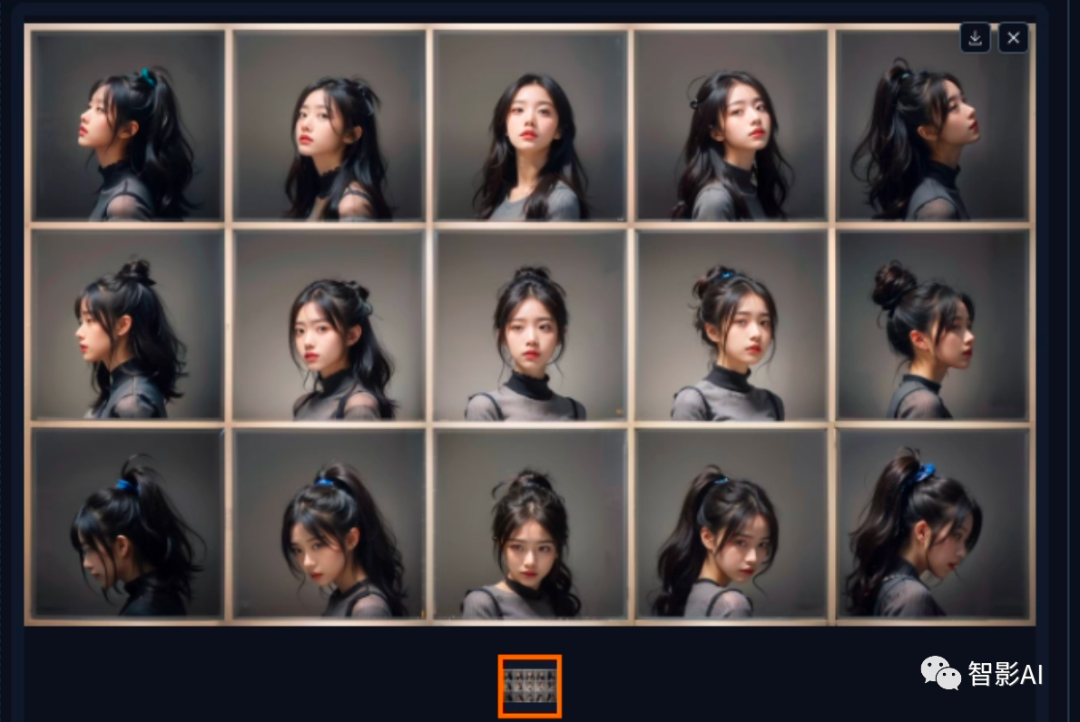

图片放大

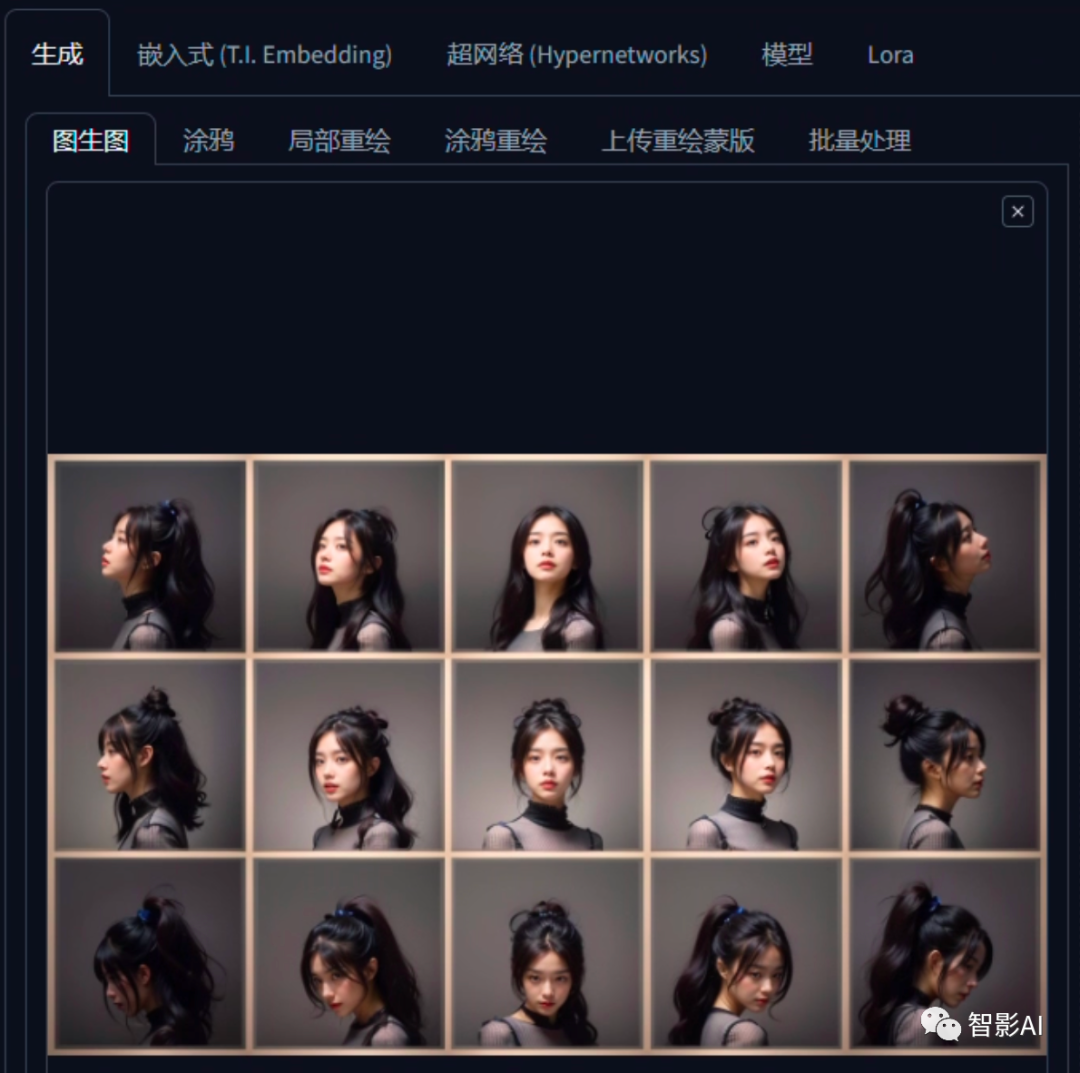

1、点击文生图生成的图片下方的图生图按钮,将图片发送到图生图。

2、调整“重绘幅度”,建议调整到0.4-0.6范围内的值,有助于消除脸部的变形。其他的参数和文生图保持一样即可。

3、设置“ControlNet”,点击“启用”并勾选“完美像素模式”,选择“Tile/Blur”模型,在“控制模式”中选择“更偏向 ControlNet”。

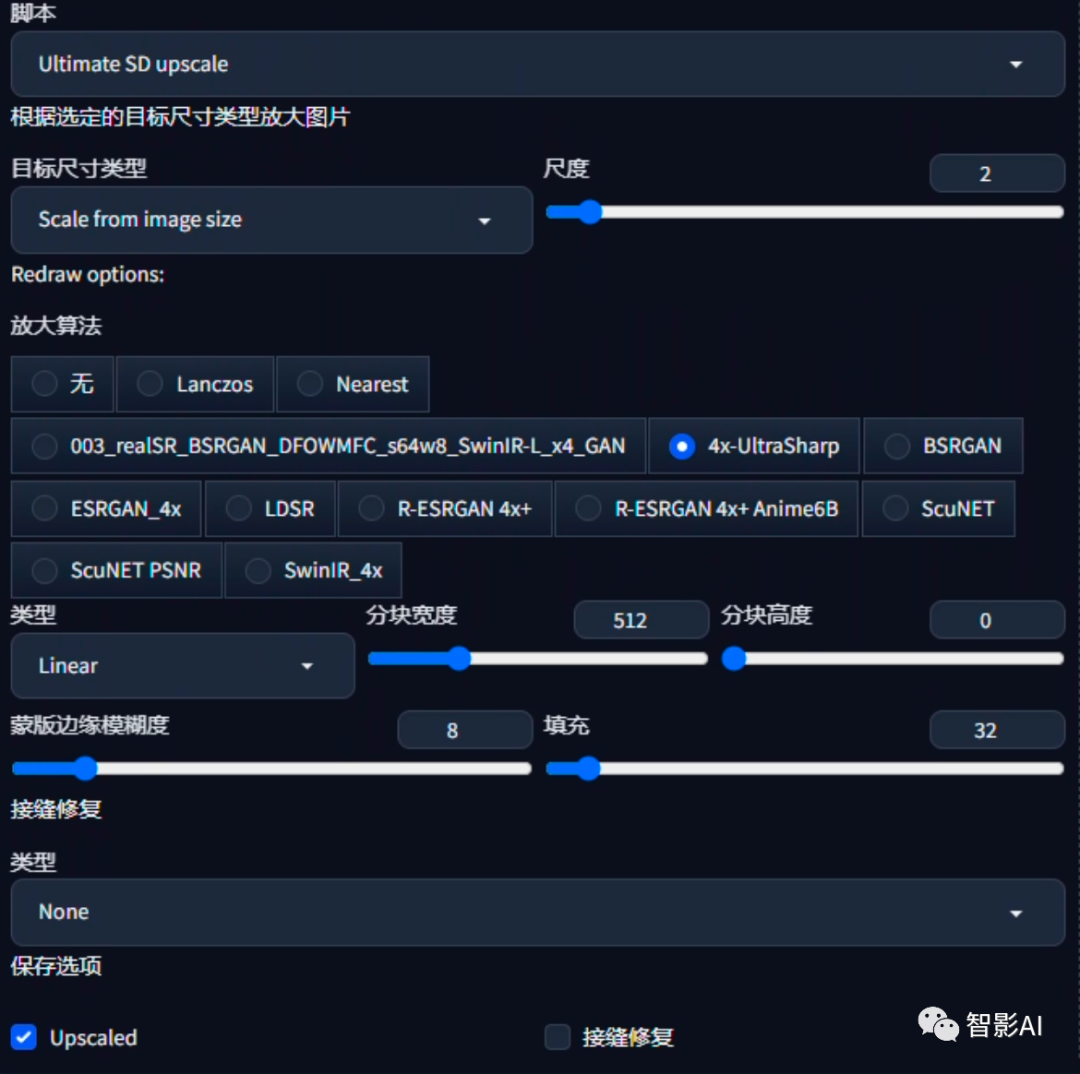

4、在脚本中选择“Ultimate SD upscale“脚本。在“目标尺寸类型”中选择“从图像大小缩放”,放大算法选择“4x-UltraSharp“(也可以选择其他的放大算法)。

5、设置完成之后,点击“生成”即可

4

总结

以上是在Stable Diffusion同样的角色生成不同角度图片的方法,不仅仅可以生成写实人物,还可以生成二次元人物、3D人物等等。

AI绘画SD整合包、各种模型插件、提示词、AI人工智能学习资料都已经打包好放在网盘中了,无需自行查找,有需要的小伙伴文末扫码自行获取。

关于AI绘画技术储备

学好 AI绘画 不论是就业还是做副业赚钱都不错,但要学会 AI绘画 还是要有一个学习规划。最后大家分享一份全套的 AI绘画 学习资料,给那些想学习 AI绘画 的小伙伴们一点帮助!

对于0基础小白入门:

如果你是零基础小白,想快速入门AI绘画是可以考虑的。

一方面是学习时间相对较短,学习内容更全面更集中。

二方面是可以找到适合自己的学习方案

包括:stable diffusion安装包、stable diffusion0基础入门全套PDF,视频学习教程。带你从零基础系统性的学好AI绘画!

零基础AI绘画学习资源介绍

👉stable diffusion新手0基础入门PDF👈

(全套教程文末领取哈)

👉AI绘画必备工具👈

温馨提示:篇幅有限,已打包文件夹,获取方式在:文末

👉AI绘画基础+速成+进阶使用教程👈

观看零基础学习视频,看视频学习是最快捷也是最有效果的方式,跟着视频中老师的思路,从基础到深入,还是很容易入门的。

温馨提示:篇幅有限,已打包文件夹,获取方式在:文末

👉12000+AI关键词大合集👈

这份完整版的AI绘画全套学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

3178

3178

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?