目录

前言

📅大四是整个大学期间最忙碌的时光,一边要忙着备考或实习为毕业后面临的就业升学做准备,一边要为毕业设计耗费大量精力。近几年各个学校要求的毕设项目越来越难,有不少课题是研究生级别难度的,对本科同学来说是充满挑战。为帮助大家顺利通过和节省时间与精力投入到更重要的就业和考试中去,学长分享优质的选题经验和毕设项目与技术思路。

🚀对毕设有任何疑问都可以问学长哦!

大家好,这里是海浪学长计算机毕设专题,本次分享的课题是

🎯基于Python的济南市天气数据的爬取与可视化的实现

项目背景

随着全球气候变化的加剧,天气状况对人类活动的影响日益凸显,准确的天气预测与分析变得尤为重要。济南市作为中国的重要城市之一,其天气变化直接影响到市民的生活、出行以及农业生产等多个方面。通过对济南市天气数据的爬取与可视化,不仅能为市民提供实时的天气信息,还可以为气象研究、环境监测和城市管理等领域提供重要的数据支持。

数据集

天气数据集的制作包括数据采集和数据清洗处理两个主要步骤。首先,通过气象局官方网站、第三方天气应用API等多种渠道收集历史天气数据,确保数据涵盖温度、湿度、风速和降雨量等多项指标,并覆盖多个年份以增强代表性。随后,对收集到的数据进行清洗,处理缺失值和异常值,统一数据格式,确保数据的准确性和一致性。将处理好的天气数据存储在数据库或CSV文件中,并按比例划分为训练集、验证集和测试集,以便于后续模型的训练和评估。

设计思路

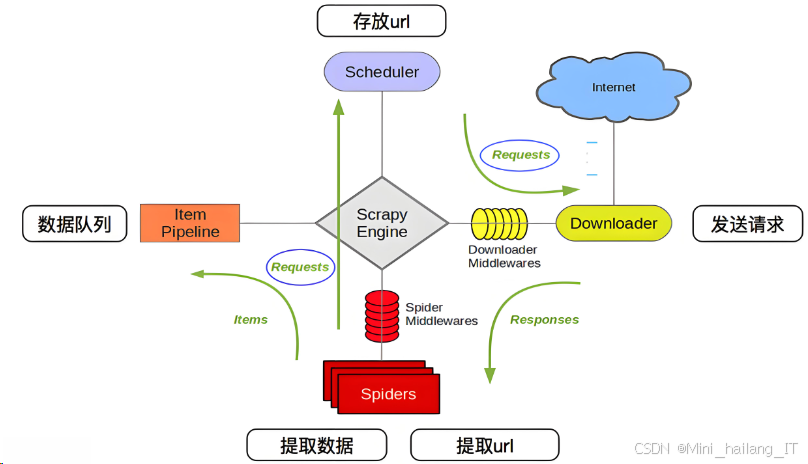

网络爬虫是自动访问互联网并提取信息的程序,其基本原理是通过模拟浏览器行为,向目标网站发送请求,获取网页内容。爬虫通常包括发送HTTP请求、接收响应、解析网页数据和存储提取的信息几个步骤。爬虫可以使用多种编程语言实现,Python由于其丰富的库和简洁的语法,成为网络爬虫开发的热门选择。常用的库包括Requests用于发送请求,BeautifulSoup和lxml用于解析HTML/XML文档。

在济南市天气数据爬取的过程中,首先需要选择合适的天气数据源,例如气象局官方网站或天气API。编写爬虫程序时,使用Requests库向目标网站发送GET请求,获取天气信息的网页内容。接着,利用BeautifulSoup或lxml解析获取的HTML文档,提取所需的天气数据,如温度、湿度、风速等。为了确保数据的完整性和准确性,需设计合理的爬取策略,包括设置请求头、使用代理IP以及控制请求频率,以避免被目标网站封禁或限制访问。

爬虫的优化与维护是确保系统长期稳定运行的重要环节。在爬虫实现后,需要定期检测数据源的可用性和网页结构的变化,并根据情况及时更新爬虫程序。此外,为了提高爬虫的效率,可以实现多线程或异步爬取,减少数据获取的延迟。同时,考虑到数据的时效性,设计定时任务自动运行爬虫,实现定期更新天气数据。通过日志记录和错误处理机制,及时发现并解决爬虫在运行过程中可能遇到的问题,确保数据采集的持续性和准确性。

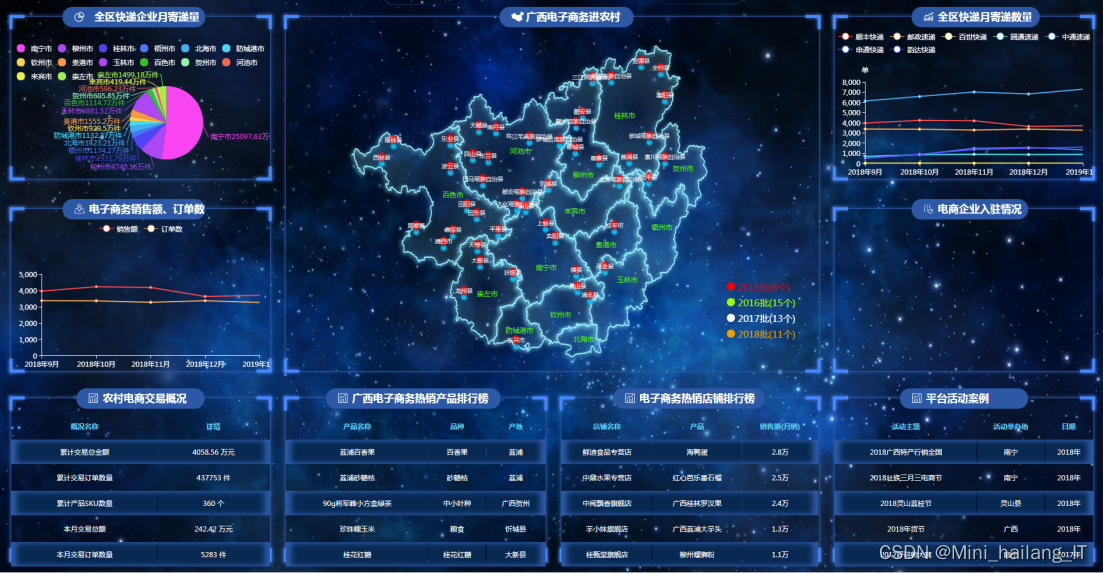

数据可视化是将数据转换为图形或图像的过程,以便于人们更直观地理解和分析信息。通过可视化,用户能够快速识别数据中的模式、趋势和异常,进而做出更有效的决策。在济南市天气数据的可视化过程中,常用的图表类型包括折线图、柱状图、饼图和热力图等。每种图表类型都有其特定的应用场景,例如,折线图适合展示温度变化趋势,柱状图可用于比较不同天气参数的数值,热力图则能清晰显示天气数据的分布情况。

为了提升用户体验,数据可视化系统还可以实现交互性功能。通过Dash或Bokeh等框架,可以构建交互式的网页应用,用户可以选择不同的时间范围、天气参数等条件,动态生成相应的可视化图表。这种交互式可视化能够更好地满足用户的需求,使得用户在分析天气数据时可以更加灵活和直观。此外,结合实时数据更新功能,用户可以随时获取最新的天气信息,提升整个系统的实用性和价值。

时间序列分析是一种用于分析按时间顺序收集的数据的方法,旨在识别和解释数据中的模式和趋势。它广泛应用于经济学、气象学和许多其他领域,以帮助预测未来的趋势或行为。在济南市天气数据分析中,通过时间序列分析,研究者能够观察温度、降水量和风速等指标随时间的变化,识别出长期趋势、季节性波动及其他周期性行为。这种分析为天气预测、气候变化研究和环境管理提供了重要的数据支持。

时间序列数据通常包含多个重要特征,包括趋势、季节性、周期性和随机性。趋势反映了数据的长期上升或下降方向,季节性表现为在一定时间间隔内的规律性波动,例如一年中某些月份的气温上升或下降。周期性则是指数据在较长时间内的重复波动模式,而随机性则是无法预测的偶然变化。在进行时间序列分析之前,必须对数据进行预处理,包括去除异常值、填补缺失值和转换数据格式,以确保数据的准确性和一致性。通过可视化手段(如折线图)观察数据特征,有助于选择合适的建模方法。

在完成数据预处理后,可以使用多种时间序列模型进行分析和预测。常用的模型包括自回归模型(AR)、移动平均模型(MA)、自回归移动平均模型(ARMA)和自回归积分滑动平均模型(ARIMA)。对于具有季节性特征的数据,可以使用季节性ARIMA(SARIMA)模型。通过这些模型,研究者能够对济南市天气数据进行短期和长期的预测,帮助用户更好地应对气候变化和天气事件。此外,模型的评估指标(如均方根误差RMSE、平均绝对误差MAE)可以用来验证预测的准确性,从而不断优化模型,提高预测能力,为决策提供更可靠的数据支持。

通过网络爬虫技术从指定的网站获取济南市的天气数据。在这一阶段,需要选择合适的天气数据源,通常为气象局的官方网站或第三方天气API。利用Python的Requests库发送HTTP请求,获取网页内容,并使用BeautifulSoup解析HTML,提取出所需的天气信息(如温度、湿度、风速、降水量等)。在数据爬取后,通常会遇到缺失值、异常值和重复数据等问题。数据清洗与处理的目的是确保数据的质量,以便于后续的分析和建模。使用Pandas库,可以方便地进行数据清洗,包括去重、填充缺失值、格式转换等步骤。

import requests

from bs4 import BeautifulSoup

url = "http://weather.example.com/jinan" # 假设的天气数据源

response = requests.get(url)

soup = BeautifulSoup(response.text, 'html.parser')

# 示例:提取温度数据

temperature = soup.find('span', class_='temperature').text

print(f"当前温度: {temperature}")数据探索性分析(EDA)是理解数据特征和关系的重要步骤。在这一阶段,通过可视化手段(如折线图、直方图等)分析天气数据的趋势、季节性和分布情况。利用Matplotlib和Seaborn等可视化库,可以方便地生成各种图表,以帮助识别数据中的模式和异常点。完成探索性分析后,需要进行特征选择与工程,以构建适合模型训练的输入特征。这可能包括选择重要的天气参数(如温度、湿度、风速等),以及根据需求生成新的特征(如温度的移动平均、季节性特征等)。通过这些特征,可以更好地提高模型的预测能力。

import matplotlib.pyplot as plt

import seaborn as sns

# 假设data是经过清洗后的DataFrame

plt.figure(figsize=(10, 5))

sns.lineplot(data=data, x='date', y='temperature')

plt.title('济南市温度变化趋势')

plt.xlabel('日期')

plt.ylabel('温度 (°C)')

plt.xticks(rotation=45)

plt.tight_layout()

plt.show()将数据划分为训练集和测试集是模型训练中的重要步骤。通常将数据的70%-80%用于训练,其余用于测试。这样可以在训练过程中评估模型的性能,确保模型在未见过的数据上也能有效预测。根据数据特性选择合适的时间序列模型(如LSTM)。通过训练集数据对模型进行训练,调整超参数以提高模型的性能。使用适当的评估指标(如均方根误差RMSE、平均绝对误差MAE等)来评估模型的预测能力。使用测试集对模型进行评估,计算预测值与真实值之间的误差。根据评估结果,对模型进行优化。

from sklearn.model_selection import train_test_split

X = features.drop('temperature', axis=1) # 特征

y = features['temperature'] # 目标变量

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)通过可视化工具展示模型的预测结果与真实数据的对比,以便于分析模型的性能与效果。通过图表,用户能够直观地理解模型在预测天气数据方面的表现。

plt.figure(figsize=(10, 5))

plt.plot(y_test.index, y_test, label='真实值', color='blue')

plt.plot(y_test.index, y_pred, label='预测值', color='orange')

plt.title('济南市天气预测')

plt.xlabel('日期')

plt.ylabel('温度 (°C)')

plt.legend()海浪学长项目示例:

2790

2790

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?