Deep Mind第一个正式提出DQN的概念并能够做出比较有效果的实验。

一直以来,强化学习都面临对人工提取特征的依赖的问题,深度神经网络的发展给问题的解决带来了希望,卷积神经网络可以从像素矩阵中直接提取出可以和人工提取值相媲美的特征值。就是,把一张游戏的图片传进去,卷积神经网络就可以辨识出图片中任务所处的状态,例如:在什么地方、周围是什么环境。

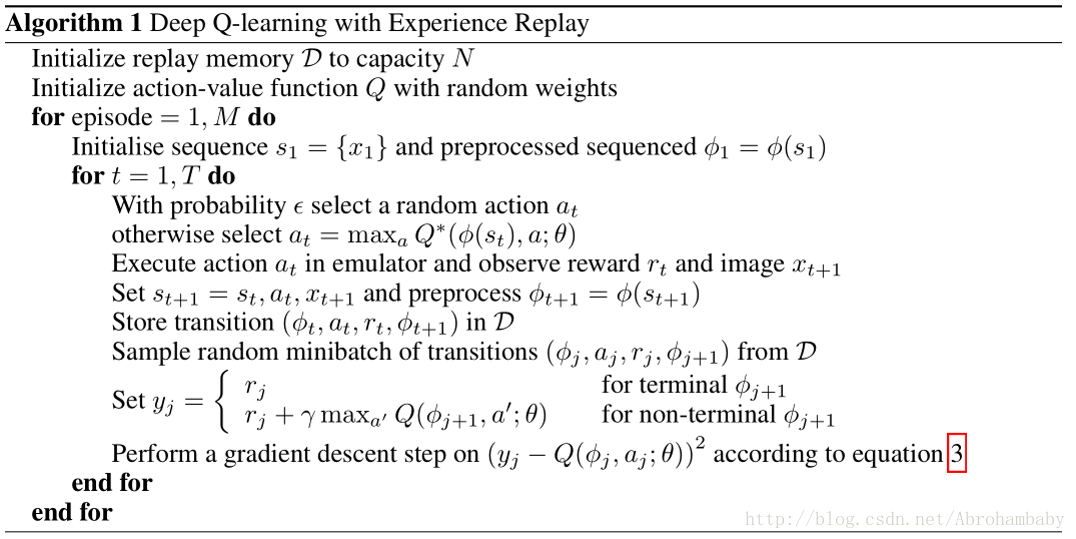

Deep Mind在他们的DQN模型中使用了经验回放机制,即把每一个time_step中的状态存起来,作为一个经验,在每一个time_step的末尾,随机从经验集中选取出一条经验进行学习。这样,可以降低数据之间的关联度,并且可以缓解数据格式(data distribution)经常变化的问题。

此外,Deep Mind使用带权值的神经网络函数来估计Q函数,对于强化学习来说,Q函数是离散的,没有固定的式子,而带参数的Q函数需要将S转化为向量值作为输入,这样,可以使用类似随机梯度下降的方式对参数进行更新。

DQN的关键代码如下:

SGW PPT参见资源

对深度强化学习的理解

最新推荐文章于 2024-04-25 13:55:39 发布

1720

1720

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?