智源导读:从2020年,Transformer开始在CV领域大放异彩。ViT(Vision Transformer)是Google在2020年提出的直接将transformer应用在图像分类的模型,后面很多的工作都是基于ViT进行改进的。

ViT模型的共同作者、来自谷歌大脑的翟晓华研究员针对“大规模视觉表征学习”,深入讲解了谷歌大脑在视觉大模型上的工作进展和应用情况,重点分享了BiT和ViT这两项工作。

翟晓华,现任瑞士苏黎世谷歌大脑团队研究员,研究方向为表征学习、深度学习、人工智能。他于2014年在北京大学获得博士学位。他负责的大规模迁移学习算法“Big Transfer (BiT)”基于亿级规模图像数据来预训练模型,在超过二十个视觉任务上取得良好的效果;作为共同一作,他提出的ViT将Transformer模型应用于图像识别,取得了与计算机视觉领域的主流模型CNN相当的效果。这两个特征学习项目及模型已开源,在GitHub上共获得3800个星标。

整理:肖健

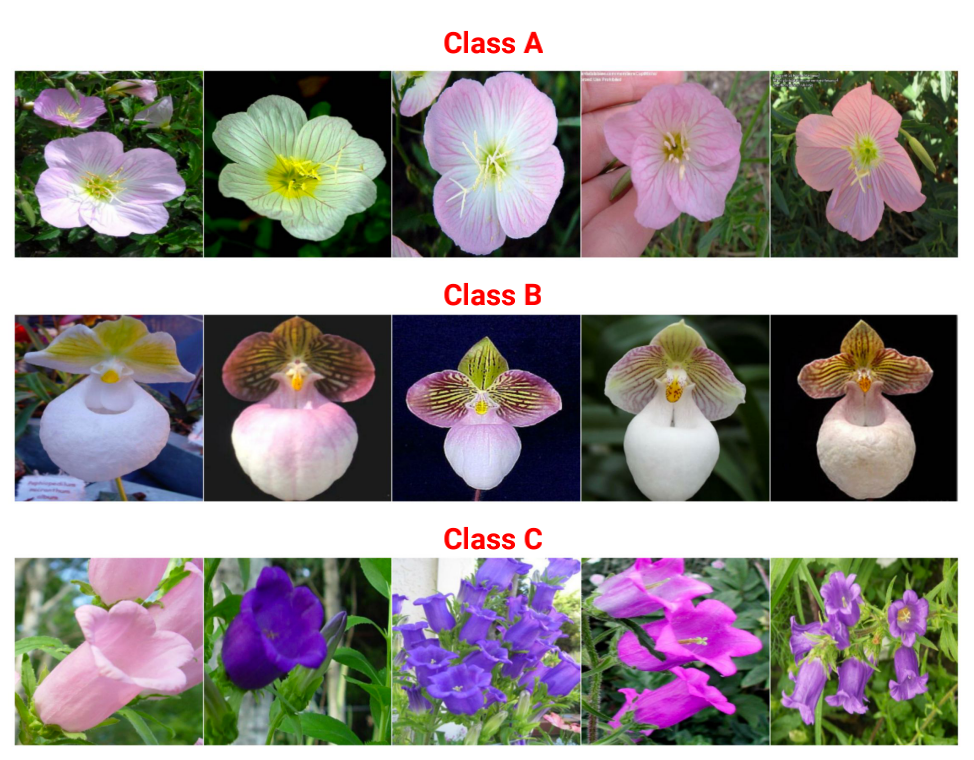

翟晓华研究员以人类如何对图像进行分类为切入点,发现人类可以根据物体的形状、颜色和样式很容易地完成分类问题。

使用计算机解决图像分类问题时,现在的主流算法是应用卷积神经网络,它通过使用一个滑动的窗口(卷积核),仅仅处理图像上的局部区域,再通过共享参数,在多个特征图谱中找到图像里的预定模式,而且这个学习非常的高效。这就是现在使用的比较主流的表征学习方法。

对于一般性或者泛化的视觉表征学习,这个问题的定义在于:首先给一个大规模的预训练数据集,我们的目标是获得一个预训练模型,然后再通过设计一些适配算法,让这个模型、数据以及这个算法一起应用到小样本数据的下游任务。我们希望表征学习能够像人类一样思考,能解决所有的任务。

如下图,在视觉任

智源导读:从2020年,Transformer开始在CV领域大放异彩。ViT(Vision Transformer)是Google在2020年提出的直接将transformer应用在图像分...

智源导读:从2020年,Transformer开始在CV领域大放异彩。ViT(Vision Transformer)是Google在2020年提出的直接将transformer应用在图像分...

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

771

771

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?