如何产生好的研究思路?如何撰写一篇高质量论文?如何从浩如烟海的论文中寻找好的科研灵感?如何通过Rebuttal为自己的文章扳回一城?导师跟学生之间怎样才能形成更好的合作关系?

在ECCV 2022中国预会议的Panel环节,DesNet作者、清华大学黄高,华中科技大学王兴刚,UCSD王小龙,香港大学齐晓娟,清华大学董胤蓬等计算机视觉领域的顶尖青年学者针对上述问题展开了讨论。干货满满,发人深思。

论坛专家名单:

吴祖煊 | 复旦大学(Chair)

黄 高 | 清华大学

王兴刚 | 华中科技大学

王小龙 | 加州大学圣地亚哥分校

董胤蓬 | 清华大学

齐晓娟 | 香港大学

整理:熊宇轩

编辑:李梦佳

实现代表作的过程,「一波三折」

Q1:请结合自己的代表作为例,介绍一下从选题、产生 idea、试错、完善实验到完成一篇精品文章的流程。

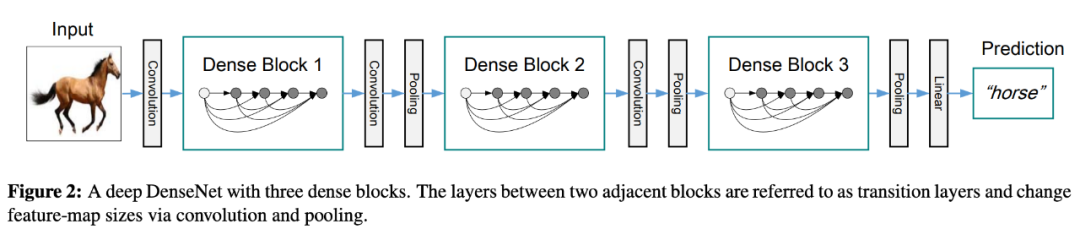

黄高(以下简称「黄」):DenseNet 是我自己比较满意的一个工作。一直以来,梯度消失都是困扰深度神经网络训练的难题。15 年底,何恺明等人提出了ResNet,在很大程度上缓解了梯度消失问题,将网络的深度提升至 100 层以上,在诸多计算机视觉任务上取得了非常好的效果。在此基础之上,我们考虑进一步解决梯度消失的问题,试图让梯度能够更为顺畅地回传到浅层。

然而,我们最开始构想的密集连接网络结构过于复杂,难以训练,因此这个想法被搁置了一段时间。2016年夏天,我们着手考虑解决密集连接网络的计算复杂度问题。我们意识到,当各层之间都存在连接时,神经网络就从链式结构变为了网状结构,此时不再存在信息瓶颈问题。此时可以将网络宽度设计得非常小(极端情况下每一个卷积层只有一个通道),因此即便层与层之间的连接十分密集,总体的计算量也不会过多。基于这个思路,我们得到较好的训练效果。

但是在网络宽度非常小时,在GPU上并行计算的效率非常低。于是,我们将每一层的通道数逐渐扩展到16、32,发现仍然能很好地实现精度与效率的均衡,并且实际运行速度能够大大提升。大概只经历了三个月时间,我们就完成了DenseNet 的第一版,并将文章挂在了 Arxiv 上。此时距离 CVPR 还有比较长的一段时间。我们在没有Deadline 压力的情

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

109

109

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?