点击下方卡片,关注“自动驾驶之心”公众号

ADAS巨卷干货,即可获取

今天自动驾驶之心很荣幸地邀请到鉴智机器人的Yunpeng Zhang分享ICCV 2023最新中稿的OpenOccupancy,它是自动驾驶领域第一个周视语义占用感知基准。如果您有相关工作需要分享,请在文末联系我们!

论文作者 | Xiaofeng Wang

编辑 | 自动驾驶之心

论文链接:https://arxiv.org/abs/2303.03991

项目链接:https://github.com/JeffWang987/OpenOccupancy

1. 背景&意义

SemanticKITTI将占用感知扩展到驾驶场景,但其数据集的规模相对较小,而且多样性有限,这阻碍了占用感知算法的推广和评估。此外,SemanticKITTI只评估了前视的占用率预测,而周视感知对安全驾驶更为关键。为了解决这些问题,我们提出了OpenOccupancy。作为自动驾驶领域第一个语义占用预测的大规模评测基准,OpenOccupancy有利于促进相关算法的研究进展。

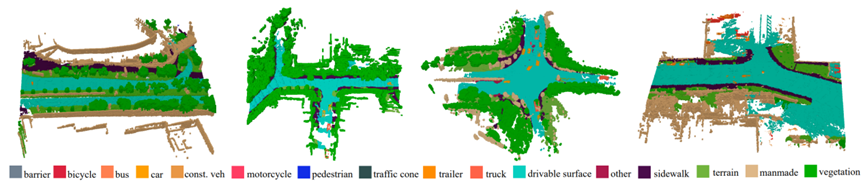

图1. OpenOccupancy周视语义占用标注图

主要贡献如下:

(1)OpenOccupancy:第一个为驾驶场景中的周视语义占用感知而设计的基准。

(2)The AAP pipeline:对nuScenes数据集的语义占用标签进行了标注和密集化,所得到的nuScenes-Occupancy是第一个用于周视语义占用的数据集。

(3)在 OpenOccupancy 基准中建立了 camera-based, LiDAR-based and multi-modal 的基线。

(4)基于OpenOccupancy基准,我们对所提出的基线、CONet和现有相关工作进行了综合实验,证明了所提出CONet的有效性。

2. 数据集构建

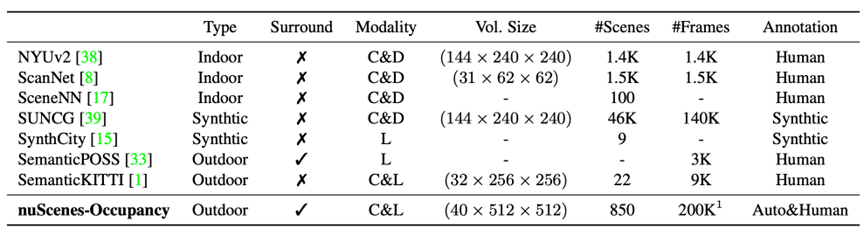

在OpenOccupancy基准中,我们引入了nuScenes-Occupancy,它扩展了大规模自动驾驶数据集 nuScenes 的三维语义占用标注。如下表所示,nuScenes-Occupancy的标注场景和帧的数量分别比 SemanticKITTI 多40倍和20倍。

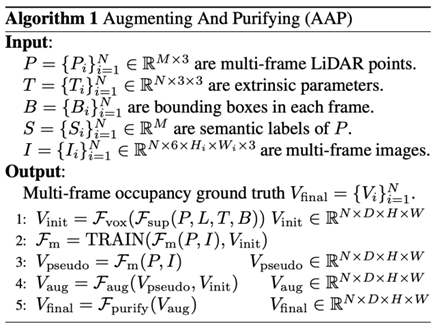

以往的标签依赖于多帧LiDAR点云叠加,但LiDAR点云的稀疏性会导致部分未扫描区域的占用标签被遗漏。为了解决这个问题,我们引入了增强和降噪(Augmenting And Purifying)流程来使标签变得更密集,其整体流程如图2所示。我们首先通过叠加多帧LiDAR点云来产生初始标签:其中静态点云(例如,人行道)通过自车移动对齐到统一的世界坐标系下,对于可移动的物体(例如,移动的汽车),我们利用nuScenes提供的三维检测框标签获得以物体为中心的标准化点云、并整合多帧以获得稠密的物体点云;最终,静态点云和物体点云整合到一起并进行体素化,得到初始的三维语义占用标签。

由于遮挡情况和LiDAR扫描的稀疏性,部分未扫描区域的占用标签会在上述流程中遗漏。受到 self-training 流程的启发,我们采用了语义占用的伪标签来对初始标签进行补充。具体来讲,初始的三维语义标签可以用来训练本文提出的多模态基线方法,得到的预训练模型则可生成语义占用的伪标签,并用来与初始标签进行融合和增强,产生更加密集的语义占用标签。为了解决两种标签中的冲突情况,我们以初始标签为主干,仅使用伪标签填充了初始标签中的未占用区域。最终,我们引入了人工修正过程来进一步提升语义占用标签的质量,产生高质量的标注结果。

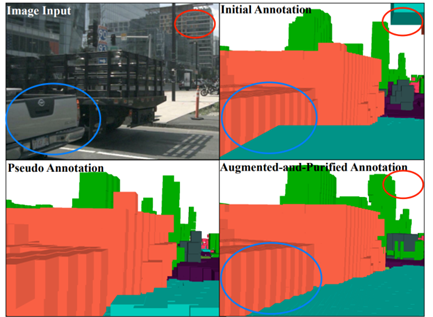

如图3可以看到AAP算法可以有效提升标注质量。其中红色和蓝色圆圈高亮的区域表示增强的标注更加密集和准确。伪标签是对初始标注的补充,而经过AAP后的标签则更加密集和精确。

3. 方法介绍

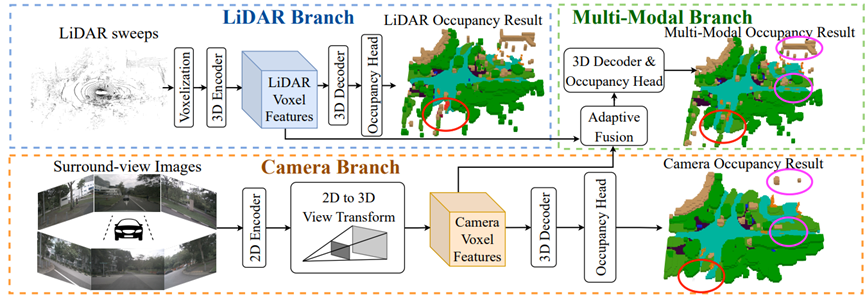

针对周视语义占用预测,我们根据输入模态的差异提出了三种基线算法,如图4所示。

其中基于LiDAR的基线算法步骤如下:(1)Voxellization:输入的原始点云首先通过参数化体素的方式转化为初始的体素特征。(2)3D Encoder:为了提高计算效率,采用 3D 稀疏卷积编码体素空间的特征,产生 LiDAR voxel features。(3)3D Decoder:体素特征被 3D 卷积进一步编码和解码,生成多尺度体素特征。这些特征被上采样然后沿着通道串联。(4)Occupancy Head:最后,利用 occupancy head 来减少特征通道,并利用softmax函数来产生语义占用概率。

基于Camera的基线算法步骤如下:(1)2D Encoder:首先利用 2D 编码器(具体地,使用ResNet和FPN结合产生多尺度特征)来提取多视图特征。(2)2D to 3D view transformer:将 2D 特征投影到 3D 自车坐标中,与现有的 BEV 方案不同的是,这里我们保留了高度信息以得到三维网格特征,以便于细粒度的 3D 语义占有预测。(3)Camera Voxel Encoder:使用 3D 卷积对相机体素特征进行编码,所产生的体素特征与LiDAR对应的特征形状相同。(4)3D Decoder和 Occupancy Head:与基于LiDAR的基线算法相同,我们进一步采用 3D 解码器和语义占用头来输出语义占用概率。

在多模态基线中,我们提出了自适应融合模块,动态地整合来自LiDAR 的体素特征和相机的体素特征。具体来讲,我们将点云和图像体素特征沿着特征维度进行拼接,再通过三维卷积层和 Sigmoid 函数得到逐网格的权重得分,并基于该权重预测对点云特征和图像特征进行加权求和,得到自适应融合的多模态特征。

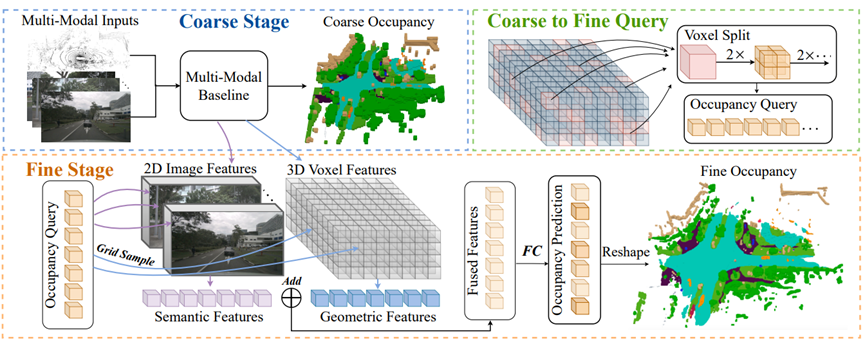

与前视占用感知相比,周视占用感知的输入覆盖了5倍以上的感知范围,因此周视三维语义占用预测会面临更加繁重的计算复杂度。为了缓解这个问题,我们在基线算法上进一步引入了Cascade Occupancy Network(CONet),以降低整体的计算量和显存开销,实现更加高效的三维语义占用预测。具体来讲,CONet 引入了一个 coarse-to-fine 的 pipeline,以多模态基线为例(称为多模态CONet),整体框架如图5所示,我们首先利用多模态基线预测低分辨率下的语义占用结果,然后仅在被预测占用的网格区域进行更加精细的网格划分、以产生高分辨率的 query;这些 query 会从二维图像空间和三维体素空间获取对应空间位置的特征,从而经过映射产生最终高分辨率下的语义占用结果。

相对于基线方法,CONet实现了对三维占用空间的动态聚焦,通过在未占用区域采用低分辨率、并集中精细query优化语义变化显著的占用区域,CONet能够以更低的计算量、更少的显存占用,产生更好的语义占用性能。

4. 实验结果

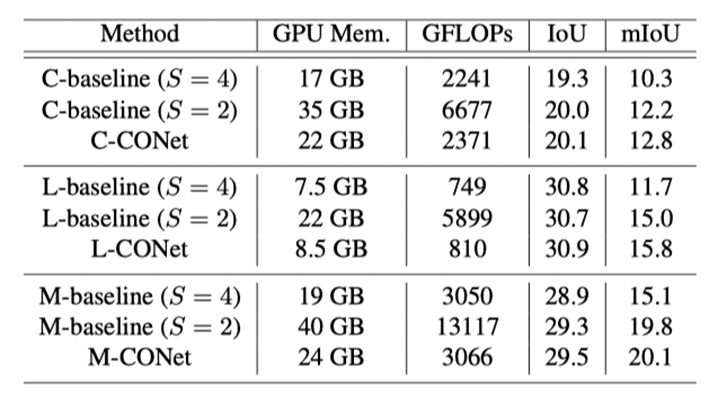

我们在OpenOccupancy上评测了各种语义占用感知算法,结果如表2所示:

(1) 与单视角方法相比,周视占用感知范式显示出卓越的性能。

(2) 所提出的基线算法显示了对语义空间感知能力的可扩展性。对于基于相机的方法,我们的基线算法在 IoU和mIoU指标上相对TPVFormer提高了26%和32%的性能。

(3) 来自相机和LiDAR的信息是相互补充的,多模态基线能够显著地提升性能。

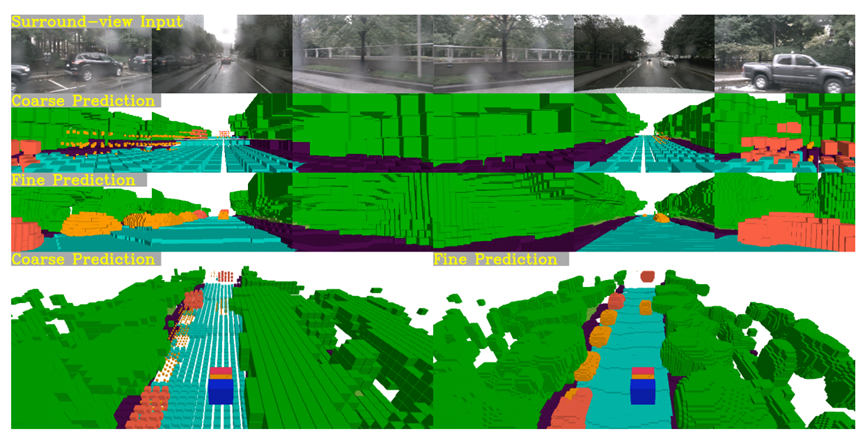

(4) 周视占有率感知的计算复杂度较高,这一点可以通过文章提出的CONet来缓解,结果如表3所示。我们还提供了可视化(见图6),以验证CONet可以在粗略预测的基础上产生细粒度的占用结果。

① 全网独家视频课程

BEV感知、毫米波雷达视觉融合、多传感器标定、多传感器融合、多模态3D目标检测、点云3D目标检测、目标跟踪、Occupancy、cuda与TensorRT模型部署、协同感知、语义分割、自动驾驶仿真、传感器部署、决策规划、轨迹预测等多个方向学习视频(扫码学习)

视频官网:www.zdjszx.com

视频官网:www.zdjszx.com

② 国内首个自动驾驶学习社区

近2000人的交流社区,涉及30+自动驾驶技术栈学习路线,想要了解更多自动驾驶感知(2D检测、分割、2D/3D车道线、BEV感知、3D目标检测、Occupancy、多传感器融合、多传感器标定、目标跟踪、光流估计)、自动驾驶定位建图(SLAM、高精地图、局部在线地图)、自动驾驶规划控制/轨迹预测等领域技术方案、AI模型部署落地实战、行业动态、岗位发布,欢迎扫描下方二维码,加入自动驾驶之心知识星球,这是一个真正有干货的地方,与领域大佬交流入门、学习、工作、跳槽上的各类难题,日常分享论文+代码+视频,期待交流!

③【自动驾驶之心】技术交流群

自动驾驶之心是首个自动驾驶开发者社区,聚焦目标检测、语义分割、全景分割、实例分割、关键点检测、车道线、目标跟踪、3D目标检测、BEV感知、多模态感知、Occupancy、多传感器融合、transformer、大模型、点云处理、端到端自动驾驶、SLAM、光流估计、深度估计、轨迹预测、高精地图、NeRF、规划控制、模型部署落地、自动驾驶仿真测试、产品经理、硬件配置、AI求职交流等方向。扫码添加汽车人助理微信邀请入群,备注:学校/公司+方向+昵称(快速入群方式)

④【自动驾驶之心】平台矩阵,欢迎联系我们!

167

167

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?