点击下方卡片,关注“自动驾驶之心”公众号

戳我-> 领取自动驾驶近15个方向学习路线

今天自动驾驶之心为大家分享浙大&上海AI Lab等团队最新的工作—LiCROcc!使用Lidar和Camera提升Radar Occ的性能,在nuScenes-Occupancy数据集提升22.9%、44.1%和15.5%。如果您有相关工作需要分享,请在文末联系我们!

自动驾驶课程学习与技术交流群事宜,也欢迎添加小助理微信AIDriver004做进一步咨询

论文作者 | Yukai Ma等

编辑 | 自动驾驶之心

写在前面 & 笔者的个人理解

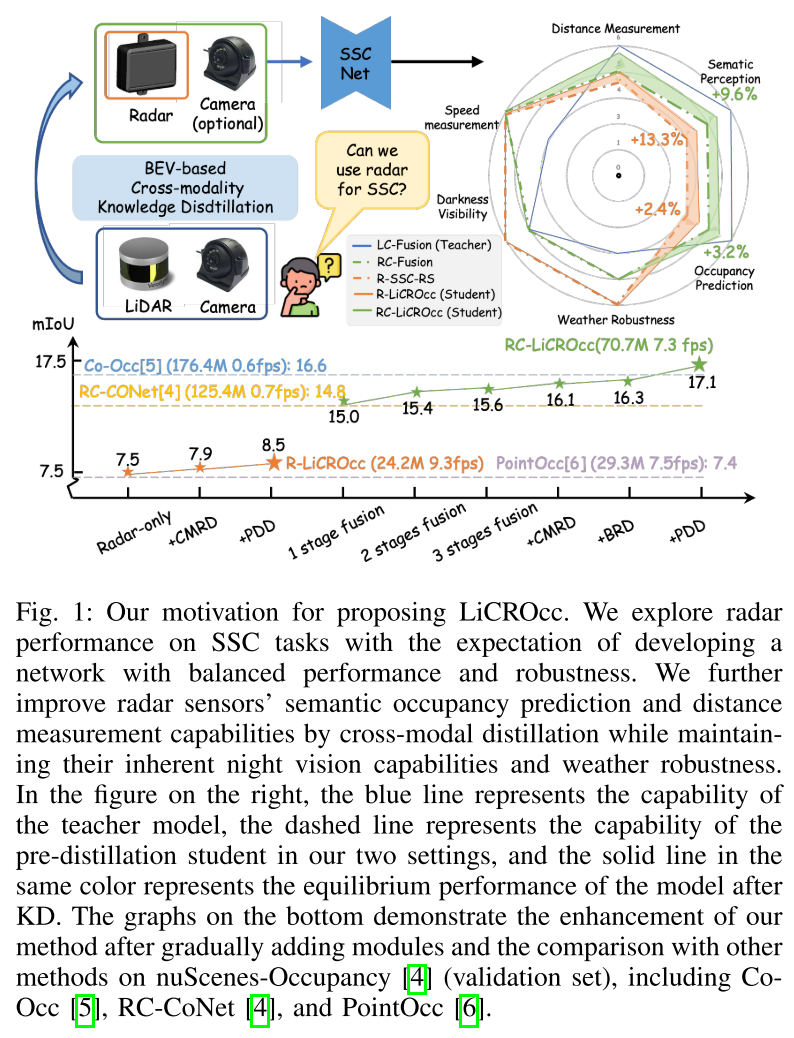

语义场景补全(SSC)是自动驾驶感知中至关重要的技术,经常面临天气和照明变化的复杂性。现有策略包括融合多模态信息以增强系统的鲁棒性。雷达作为3D目标检测中重要的传感器,逐渐在自动驾驶应用中取代激光雷达,并且可以提供更鲁棒的感知替代方案。本文们专注于3D雷达在语义场景补全中的潜力,开创了跨模态细化技术,以提高对天气和照明变化的鲁棒性,并增强SSC性能。

在模型架构方面,本文提出了一种三阶段的紧密融合方法在BEV上实现点云和图像的融合框架。基于此基础设计了三个跨模态蒸馏模块—CMRD、BRD和PDD。我们的方法通过将激光雷达和相机的丰富语义和结构信息蒸馏到 radar-only(R-LiCROcc)和雷达-相机(RC-LiCROcc)的配置中,增强了性能。最后本文提出的LC-Fusion(教师模型)、R-LiCROcc和RC-LiCROcc在nuScenes-Occupancy数据集上取得了最佳性能,其中mIOU分别超过基线22.9%、44.1%和15.5%。

源码链接: https://hr-zju.github.io/LiCROcc/

相关工作回顾

语义场景补全(SSC)作为自动驾驶中的一项关键技术,因其能够提供详细的3D场景信息而受到了广泛关注。相机和激光雷达是用于SSC任务最普遍的传感器,每种都有其优势和局限性。相机提供了丰富的语义上下文,但缺乏深度信息,并且容易受到光照和天气条件的影响。而激光雷达提供了精确的3D几何信息,但在处理高度稀疏输入时表现不佳,并且由于密集激光雷达传感器的高成本而限制了其广泛应用。另一方面,雷达作为一种在自动驾驶中越来越受欢迎的、能够抵抗恶劣天气条件的传感器,因其车规级设计和可负担性而受到重视。尽管雷达在多样化的天气和光照条件下具有鲁棒性,但其稀疏和嘈杂的测量结果对于大规模户外场景的SSC来说是一个重大挑战。

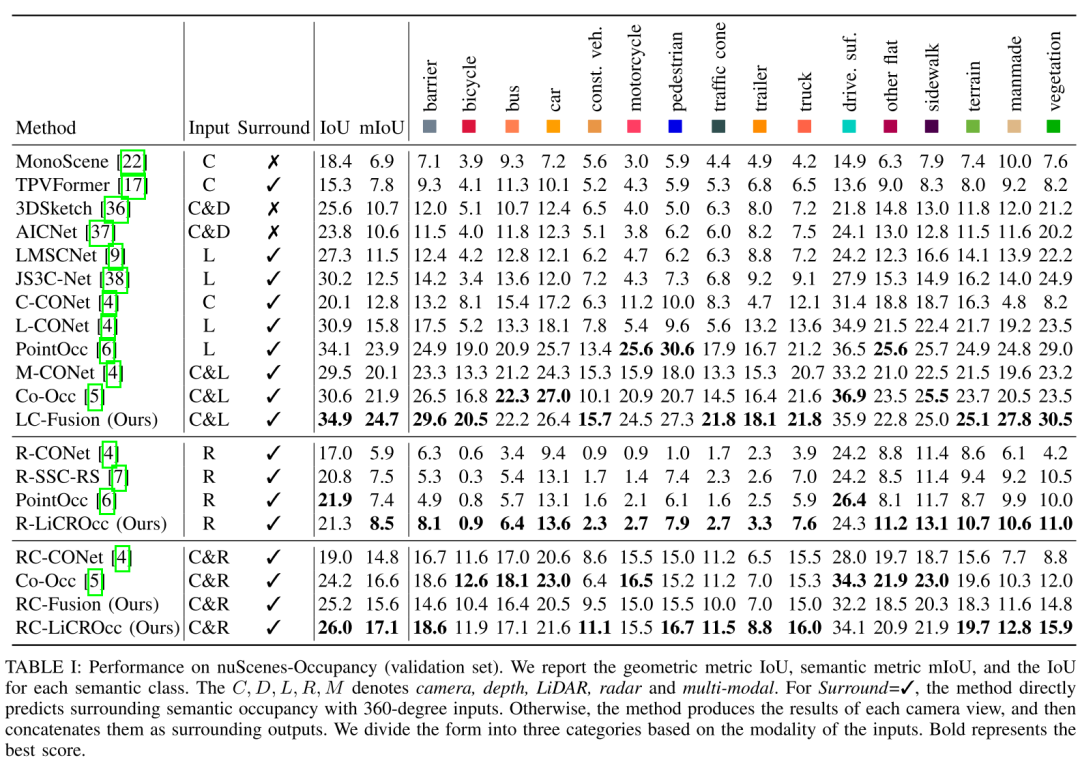

最近的大多数研究主要集中在基于雷达的检测上。仅有少数研究探索了雷达传感器在SSC任务中的应用。然而,它们只能使用雷达预测极少数类别的占用情况或作为多模态输入的补充。此外,我们发现尽管雷达在对抗不利天气条件和光照变化方面具有固有的优势,如表I和图1所示,但基于雷达的和基于激光雷达/相机的SSC方法之间仍然存在显著的性能差距。为了解决上述挑战,在这项工作中,我们探索将雷达作为SSC的核心传感器,并设定了新的性能标准。

最开始我们建立了基于雷达的基线R-SSC-RS。然而由于缺乏复杂细节,仅依靠雷达传感器无法实现高度精确和鲁棒的SSC。为了进一步提高基于雷达的SSC性能,我们设计了一个相机-雷达融合网络,以有效地将RGB图像的丰富语义上下文融合到BEV空间中的雷达中。通过这种方式雷达SSC得到了显著改进。

此外,我们发现到激光雷达-相机融合在室外SSC中实现了更优的性能,如图1和表I所示,为雷达特征学习提供了宝贵的指导。因此,我们提出了一种基于融合的知识蒸馏方法,从激光雷达-相机融合网络(教师)中提取有信息量的线索,并将它们转移到基于雷达的基线RSSC-RS和雷达-相机融合网络中,从而产生了我们的方法R-LiCROcc和RC-LiCROcc。

我们对激光雷达-相机和雷达-相机融合网络采用了相同的架构。对于基于融合的知识蒸馏模块,我们结合了跨模态残差蒸馏(CMRD)、BEV关系蒸馏(BRD)和预测分布蒸馏(PDD),以分层方式强制学生模型学习教师模型的特征表示和分布。通过这个提出的基于融合的知识蒸馏模块,我们的LiCROcc仅使用雷达(RLiCROcc)实现了与基于相机的方法相当的成果。此外,LiCROcc通过结合雷达和相机输入(RC-LiCROcc)接近基于激光雷达的方法的性能,同时在不利的天气条件和夜间视觉能力方面保持了鲁棒性。

总结来说,本文的主要贡献如下:

我们旨在提高雷达在语义场景补全中的性能,同时保持现实世界中的实用性,利用雷达对各种天气条件的弹性。我们还从基于激光雷达的方法中建立了基于雷达的基准,促进了基于雷达的SSC研究,并考虑了一个相机-雷达融合网络以提高性能。

我们提出了一个新的框架LiCROcc,它结合了CMRD、BRD和PDD模块,分层强制学生模型学习教师模型的特征表示和分布。

在大规模的nuScenesOccupancy上进行的广泛实验证明了我们提出方法的有效性。

LiCROcc详解

概述

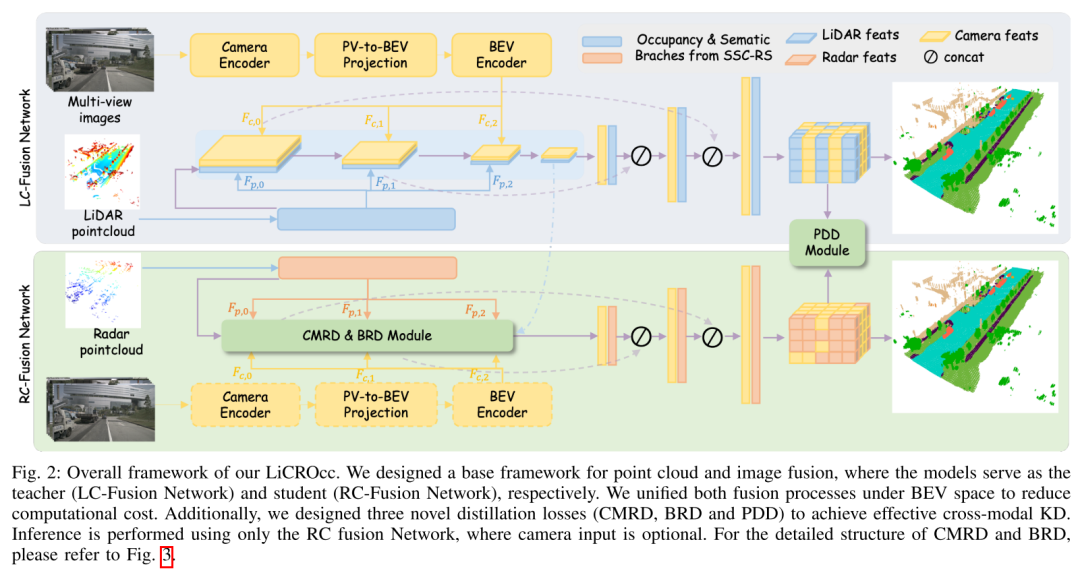

如上所述,我们构建了基于雷达的基线,并设计了雷达-相机融合网络(图2的底部)以提升基线性能。为了利用激光雷达-相机融合中详细的几何结构和点表示的指导,我们进一步使用基于融合的知识蒸馏将知识从激光雷达-相机融合网络(图2的顶部)传递到基于雷达的基线和雷达-相机融合网络。我们采用相同的架构,即多模态融合网络,来建立上述两个融合网络。

多模态融合网络

多模态融合网络主要由图像分支提取图像特征、点分支编码激光雷达/雷达点,以及多模态BEV融合网络高效整合点和图像特征。

图像分支。遵循FlashOcc,我们建议将周围图像特征投影到BEV空间进行后续处理,减轻了内存开销,同时保持占用预测的高精度。图像分支主要包括三个部分:相机编码器用于图像特征、PVto-BEV投影层用于3D场景的BEV表示,以及BEV编码器用于提取包含丰富语义上下文的多尺度BEV特征( ,其中 )。提取的多尺度BEV特征被送入BEV融合模型与点特征交互,将在下文详细说明。

点分支。不失一般性,我们采用基于BEV的SSC-RS作为我们的点分支。该分支使用两个独立分支进行语义和几何编码。带有ARF模块的BEV融合网络聚合这些分支的特征,得到最终的语义场景补全。由于其解耦设计,SSC-RS轻量且具有强大的表示能力,非常适合用作点分支。点分支接收激光雷达/雷达点云 并输出多尺度BEV特征( ,其中 )。对于激光雷达点云, 在 的范围内。对于雷达点云, 是 xyz 坐标、雷达截面 σ 和由自车运动补偿的 xy 速度的串联。

多模态BEV融合网络。由于3D卷积用于密集特征融合的计算负担,我们引入了一个多模态BEV融合网络,灵感来自BEV感知任务。该网络有效地结合了语义丰富的视觉BEV表示( )和几何信息丰富的激光雷达特征或抗天气雷达特征。为了简化融合过程,我们将激光雷达或雷达点云特征与 统一。类似于,我们的BEV融合网络采用了2D卷积U-Net架构。每个残差块将输入特征分辨率减半,以与语义/补充特征保持一致。在每个后续块之前,我们使用ARF将前一阶段的 与当前阶段的 整合得到 ,然后将缩放的 通过加法融合到 。解码器通过跳跃连接将编码器压缩的特征上采样三次,每次放大两倍。最终的解码器卷积生成了SSC预测 ,其中 表示语义类别的数量。为了表示体素语义占用概率, 被重塑为 。

为了训练所提出的融合模型,我们使用交叉熵损失 来优化网络。此外,我们还使用affinity损失 和 来优化场景和类别中的指标(即几何IoU和语义mIoU)。因此,BEV融合损失函数可以推导为:

基于融合的知识蒸馏模块

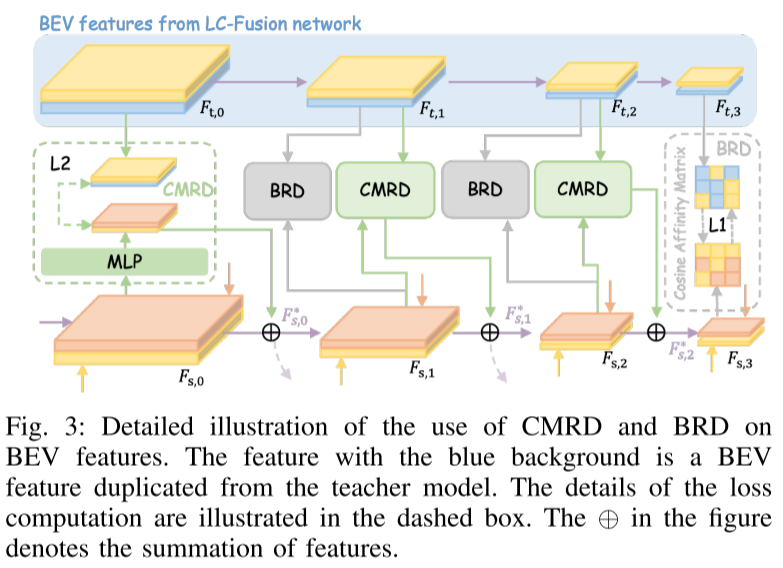

如图2所示,我们的教师和学生模型共享相同的网络结构。由于融合和蒸馏过程都在BEV下进行,学生模型的图像分支是可选的。在这一部分,我们用 表示学生模型的四个BEV特征,用 表示教师模型的相应特征(在图2和图3中以浅蓝色表示)。

跨模型残差蒸馏:相机和激光雷达融合特征包含丰富的语义和几何信息。与它们相比,雷达点要稀疏得多。雷达的语义信息主要来自速度测量。观察到这种差距,我们认为直接强制雷达特征模仿多模态特征的标准方法可能效果不佳,因此我们设计了一个跨模型残差蒸馏模块。具体来说,我们使用公式(3)将学生特征 投影到具有相同维度的隐藏空间 。在该空间中,我们通过最小化它们之间的余弦相似度(由公式(4)计算)来拉近学生和教师特征之间的距离,最终将 作为信息补充加回到原始的 ,这避免了与直接特征模仿方法相比,干扰雷达特征的内在逻辑。此外,雷达在天气抗性和观测范围方面具有独特的优势。我们的目标是让学生模型在保持其独特特性的同时,学习教师模型的优势,而不仅仅是简单地复制教师。基于此,我们使用ARF动态计算将 与 整合的权重。特征传输的过程如下:假设 是在特征图 上索引为 的特征,则CMRD损失 形成如下:

其中 如果该柱上有非空非噪声标签,否则 。换句话说,我们仅在被占用的位置约束特征相似度。如图3所示,我们为 计算了 和 的 ,其中绿色虚线框显示了计算损失的细节。

BEV关系蒸馏:我们采用CMRD进行特征级跨模态蒸馏,保持了学生特征的完整性,同时用教师信息丰富了它们。这一节介绍了一种旨在保持场景级几何关系一致性的机制。为此,我们采用基于余弦相似度的亲和矩阵来比较教师特征图 和学生特征图 。最初,张量 和 定义在空间 中。然后我们将这些张量转换为 维的矩阵。亲和矩阵使用以下计算方法:

其中 分别表示学生和教师网络BEV特征图的亲和矩阵。如图3所示,我们为 计算了 和 的 ,其中灰色虚线框显示了计算损失的细节。为了减轻计算负担,我们将所有不同尺度的BEV特征调整为较小的分辨率,然后计算 。值得注意的是,BRD仅用于对学生模型的雷达-相机融合进行蒸馏。

预测分布蒸馏:我们的工作引入了一种新颖的知识蒸馏方法,利用KL散度。具体来说,我们计算由教师和学生模型预测的概率 上的KL散度,其中 在第III-B节中引入。这个度量捕获了分布差异,并集成到蒸馏目标中。通过最小化KL散度,鼓励学生模型的预测与教师的预测紧密对齐,从而增强其预测能力。PDD损失可以计算如下:

其中 是学生模型的预测概率分布, 是学习目标,即教师模型的预测概率分布。

整体损失函数

在训练阶段,我们采用多任务训练策略,以有效指导各个组件。对于3D语义场景补全,我们使用 损失。为了增强蒸馏过程,我们结合了三个蒸馏组件: 和 。此外,我们还保留了SSC-RS中的语义( )和占用( )损失,以监督特征点云提取。总体损失函数表示如下:

其中 和 是超参数。

实验分析

在本节中,我们将详细介绍评估数据集和指标、实施详情,以及与最先进方法的性能比较。此外,我们还进行了消融研究,以证明申报融合模块的有效性和蒸馏模块。最后,我们提供了实验来消除观察距离的影响和雷达在语义场景完成任务方面的独特优势。

实验细节

对于激光雷达输入,我们将10个激光雷达扫描合并为一个关键帧。ResNet50作为图像主干来处理输入分辨率为256×704的相机图像。在训练期间,我们将点云投影到相机视图上,以提供LSS的深度监督。对于雷达输入,我们采用CRN中的预处理过程,使用汽车上的5个雷达传感器拼接雷达扫描。对于数据增强,我们对图像随机应用水平和垂直翻转以及裁剪。点云通过在x轴和y轴上随机翻转进行增强。我们使用AdamW优化器,权重衰减为0.01,初始学习率为2e-4。我们使用余弦学习率调度器,在前500次迭代中进行线性预热。所有实验都在8个NVIDIA A100 GPU上进行,总批量大小为32,训练24个周期。

定量结果

表I展示了与SOTA的比较结果。与所有先前方法相比,我们的LiCROcc在相同配置下取得了最佳性能。例如,我们的激光雷达-相机融合模型LCFusion显示出显著的改进,与基线(M-CONet)相比,mIoU增加了23%,IoU增加了18%。同时,LC-Fusion在mIoU和IoU得分上分别比PointOCC提高了3.3%和2.3%,这强调了我们提出的多模态BEV融合的有效性。

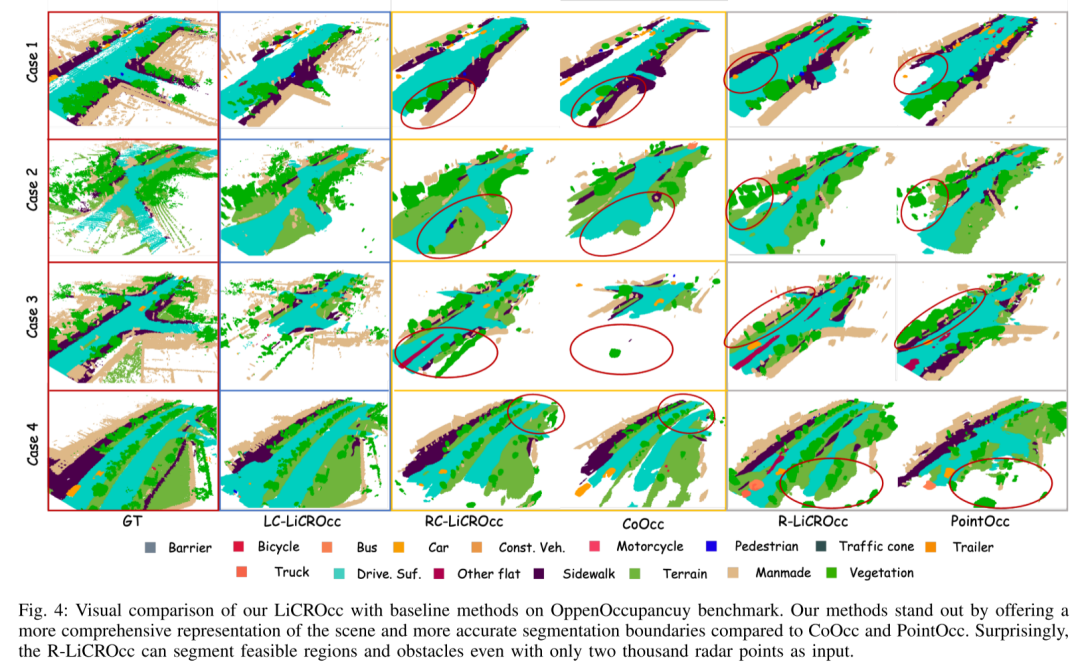

为了全面评估我们提出的方法的有效性,我们修改了几种现有的基于激光雷达和多模态方法(CONet [4],SSC-RS,PointOcc和CoOCC),以适应雷达输入,作为我们的比较。如表I的第二部分所示,我们的R-LiCROcc在mIoU得分上超过了次好的方法(PointOcc)和基线(R-SSC-RS)13.3%,证明了我们提出的基于融合的知识蒸馏的有效性。我们发现R-LiCROcc的IoU得分略低于PointOcc。我们解释说,这可以归因于PointOcc在三个平面上投影特征并使用更大的模型,这对于占用预测可能更有利。对于雷达-相机融合,我们以CONet和CoOCC作为基线。结果显示在表I的第三部分,表明我们提出的雷达-相机融合版本RC-Fusion已经达到了与这些基线相当的性能。提出的基于融合的知识蒸馏进一步提高了性能,mIoU和IoU分别提高了1.5和0.8。我们还提供了可视化结果,在图4中展示了我们的RC-LiCROcc和R-LiCROcc如何实现更完整的场景补全和更精确的目标分割。

消融实验

我们进行了一系列实验来验证所提出的模块以及雷达作为语义场景补全任务传感器的潜力。所有实验都在相同的训练配置下进行,并根据nuScene-Occupancy [4]验证数据集进行评估。

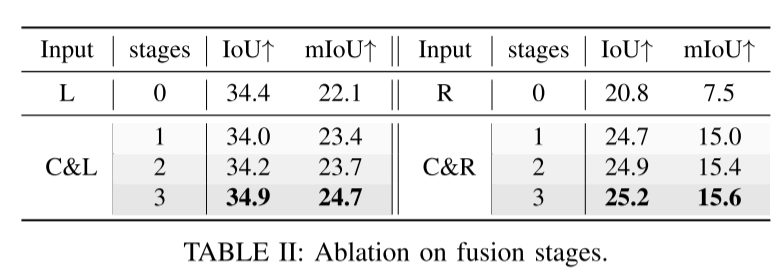

融合模块的效果: 我们研究了在第III-B节中提出的多模态BEV融合网络中不同融合阶段的影响。相应的结果显示在表II中。"Stages=0"意味着仅使用点云作为输入,这作为基于点的基线。从表II中,我们可以看到多阶段融合策略在不同尺度上融合BEV特征,并有效提高了语义场景补全的准确性。

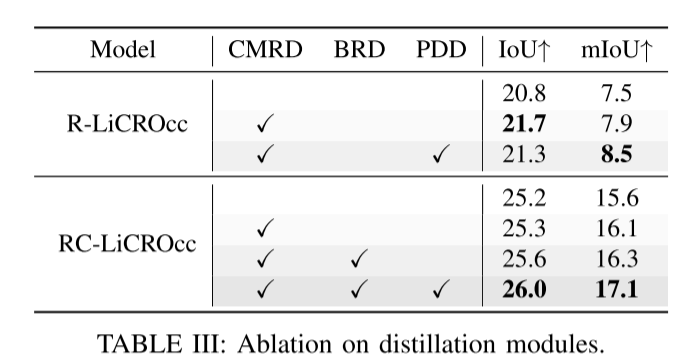

蒸馏模块的效果: 在本节中,我们深入研究了我们提出的基于融合的知识蒸馏中不同蒸馏组件的各自贡献。详细的结果在表III中说明。我们通过将它们纳入两个不同的配置:R-LiCROcc(表III的第一部分)和RC-LiCROcc(表III的第二部分),系统地评估了这些模块的影响。

表III的两部分结果都表明CMRD、BRD和PDD组件显著增强了性能。其中,PDD在跨模态知识蒸馏中具有最关键的作用,为R-LiCROcc贡献了7.6%的mIoU改进,为RC-LiCROcc贡献了4.9%的mIoU改进。

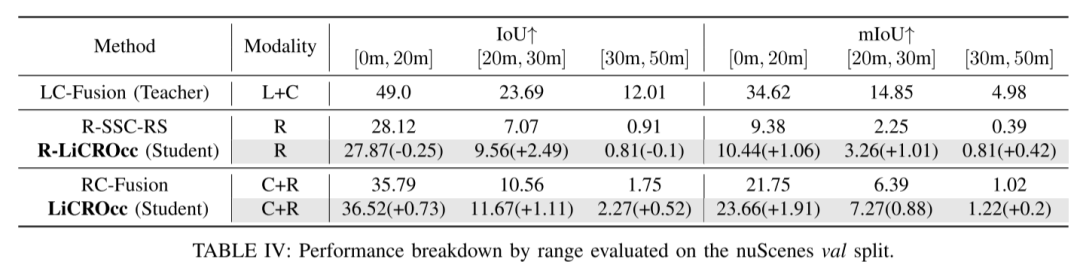

KD的视觉场优势: 雷达的固有能力是能够穿透物体并绕过前景障碍物,这使其比激光雷达和相机传感器提供了更广的视野。然而,雷达点云的稀疏性随着距离的增加而增加,这对于SSC特别不利,如表IV的第2行和第3行所示。

为了进一步分析LiCROcc带来的改进,我们进行了统计分析,以评估系统在不同距离范围内对语义场景补全的有效性,详细见表IV。我们分别在[0m, 20m]、[20m, 30m]和[30m, 50m]的语义场景补全中测量了教师模型、学生模型和R-LiCROcc的IoUs和mIoUs。表IV揭示了知识蒸馏(KD)显著增强了学生模型的性能,特别是在短距离区域。有趣的是,我们发现当从激光雷达-相机融合到基于雷达的模型执行KD时,远程区域的mIoU得分改进远小于近程和中程区域。这一观察表明,由于其相对较短的视觉范围,激光雷达-相机融合的优势随着距离的增加而丧失。值得注意的是,教师和学生模型在远程区域的性能都严重下降,特别是在mIoU得分上。例如,教师模型在20米内比RC-LiCROcc高出10.96 mIoU。然而,当范围在[30m, 50m]时,这一优势急剧下降到3.76点(几乎减少了65%)。

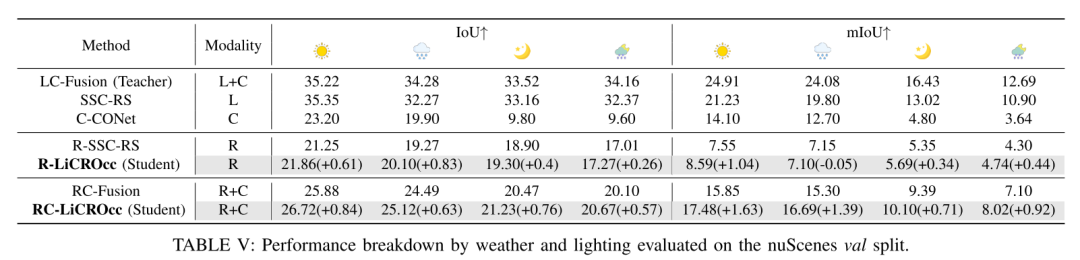

雷达的天气鲁棒性: 本研究评估了雷达在各种天气条件下的性能。详细结果在表V中揭示了模型的性能随天气场景(晴朗的白天、雨天、夜晚和雨夜)的变化而波动。

首先,如表V所示,三种传感器类型的天气属性显示出不同程度的鲁棒性。雷达的mIoU从晴朗的一天到雨夜仅下降了3.25,而激光雷达和相机的mIoU分别下降了10.33和10.46点。这表明雷达对不利天气和照明条件最为弹性。特别是,在晴朗的白天,教师模型在mIoU得分上比R-LiCROcc高出16.32,比RC-LiCROcc高出7.43。然而,在雨夜条件下,这种优势缩小到7.95和5.26,主导性能分别下降了51.3%和29.2%。此外,很明显nuScenes数据集中的雨并不特别大,导致对激光雷达点云的影响没有预期的那么显著。在更广泛的天气条件下检查雷达性能是我们未来工作的重点。

在晴朗的白天条件下,蒸馏效果带来了最佳性能。R-LiCROcc模型与学生模型相比,在IoU上提高了2.8%,在mIoU上提高了13.8%。同样,RC-LiCROcc模型在IoU上增加了3.2%,在mIoU上增加了10.3%。这种增强归因于教师模型在晴朗条件下的最佳性能。相反,在雨天和夜晚,激光雷达和相机的能见度受到损害,导致学生模型的增强效果不那么明显。事实上,R-LiCROcc模型在雨天的性能略有下降。

结论

在本文中,我们探讨了雷达在语义场景补全(SSC)任务中的应用。我们首先开发了一个融合网络,该网络整合了点云和图像,并辅以三个蒸馏模块。通过利用雷达的优势并在SSC任务上增强其性能,我们的方法在不同设置下取得了优异的成果。

参考

[1] LiCROcc: Teach Radar for Accurate Semantic Occupancy Prediction using LiDAR and Camera

投稿作者为『自动驾驶之心知识星球』特邀嘉宾,欢迎加入交流!重磅,自动驾驶之心科研论文辅导来啦,申博、CCF系列、SCI、EI、毕业论文、比赛辅导等多个方向,欢迎联系我们!

① 全网独家视频课程

BEV感知、BEV模型部署、BEV目标跟踪、毫米波雷达视觉融合、多传感器标定、多传感器融合、多模态3D目标检测、车道线检测、轨迹预测、在线高精地图、世界模型、点云3D目标检测、目标跟踪、Occupancy、cuda与TensorRT模型部署、大模型与自动驾驶、Nerf、语义分割、自动驾驶仿真、传感器部署、决策规划、轨迹预测等多个方向学习视频(扫码即可学习)

网页端官网:www.zdjszx.com

网页端官网:www.zdjszx.com

② 国内首个自动驾驶学习社区

国内最大最专业,近3000人的交流社区,已得到大多数自动驾驶公司的认可!涉及30+自动驾驶技术栈学习路线,从0到一带你入门自动驾驶感知(2D/3D检测、语义分割、车道线、BEV感知、Occupancy、多传感器融合、多传感器标定、目标跟踪)、自动驾驶定位建图(SLAM、高精地图、局部在线地图)、自动驾驶规划控制/轨迹预测等领域技术方案、大模型、端到端等,更有行业动态和岗位发布!欢迎扫描下方二维码,加入自动驾驶之心知识星球,这是一个真正有干货的地方,与领域大佬交流入门、学习、工作、跳槽上的各类难题,日常分享论文+代码+视频

③【自动驾驶之心】技术交流群

自动驾驶之心是首个自动驾驶开发者社区,聚焦感知、定位、融合、规控、标定、端到端、仿真、产品经理、自动驾驶开发、自动标注与数据闭环多个方向,目前近60+技术交流群,欢迎加入!扫码添加汽车人助理微信邀请入群,备注:学校/公司+方向+昵称(快速入群方式)

④【自动驾驶之心】全平台矩阵

1091

1091

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?