Transformer|Encoder编码器

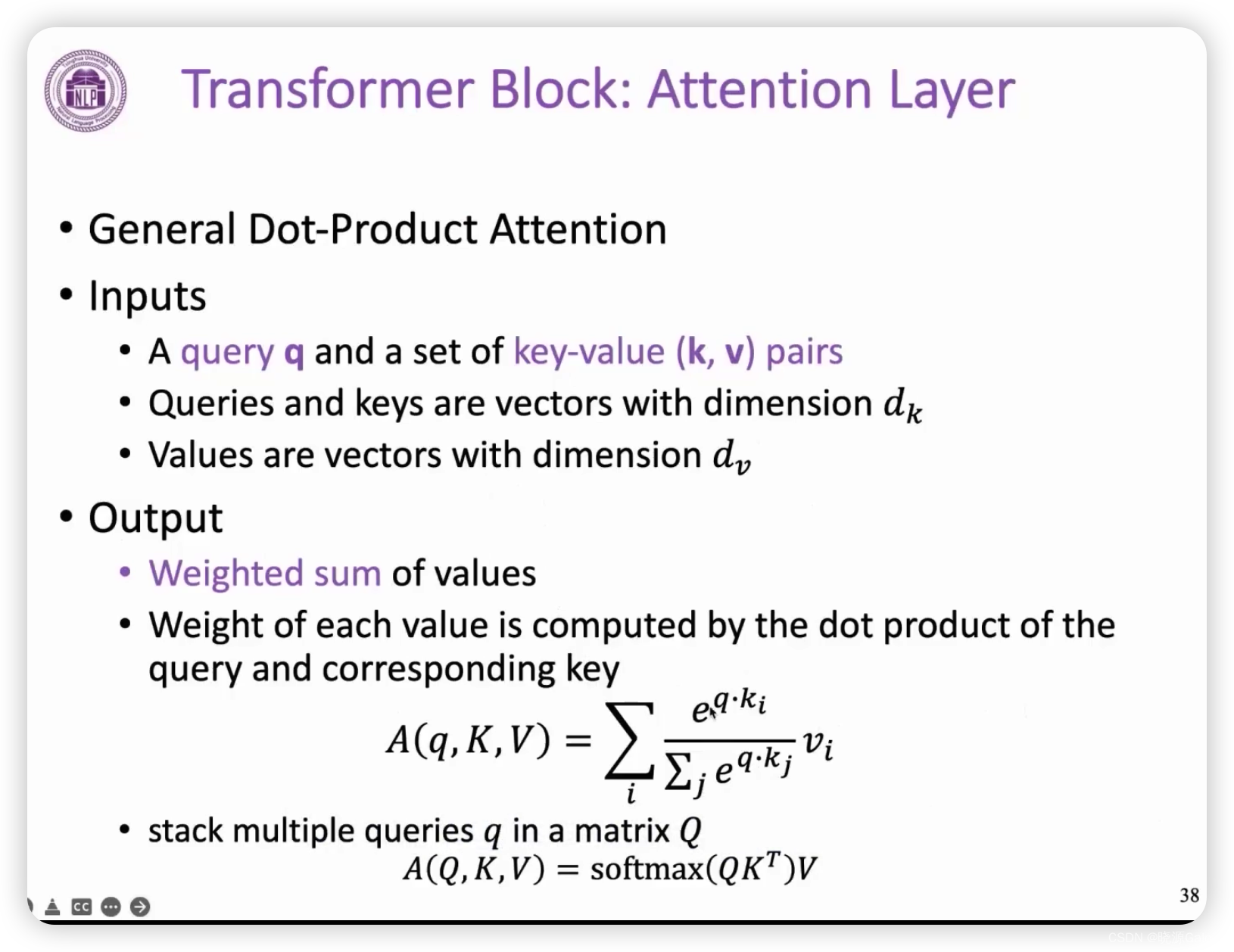

注意力机制

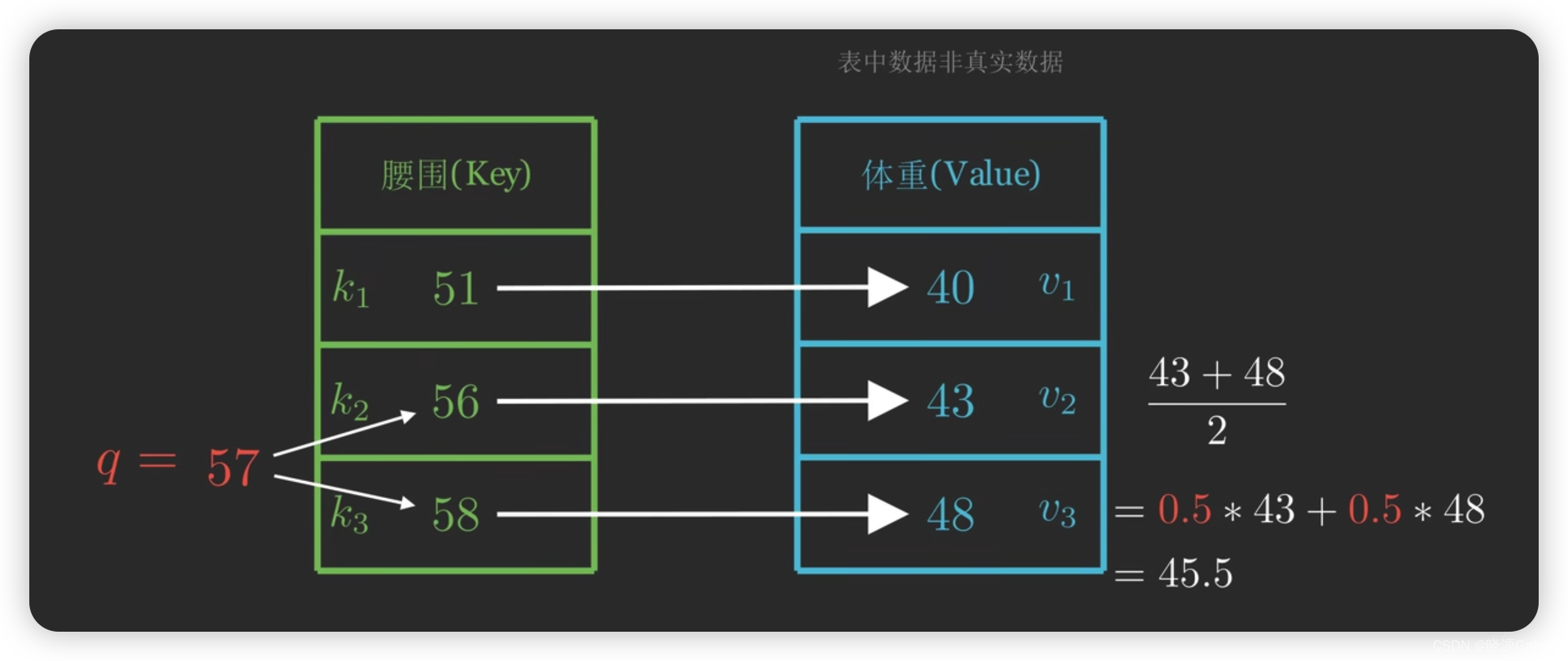

比如说已经得到腰围和体重的两份数据,此时给出一个查询——腰围为57的人的体重为多少?可以根据以往的腰围数据对体重进行估计,比如说腰围为56的体重为43,腰围为58的人体重为48,那么腰围为57的人体重应该介于43和48之间。

而不妨假设43占一半的作用,48占一半的作用,所以预测的体重为45.5.

而“一半的作用”就是所谓的权重系数(注意力权重,为了得出结果应该放多少注意力到这个级别的体重上来),而这个权重系数需要计算出来。

所以,做个小总结,Query通过Key和Value得到对应的估计值。

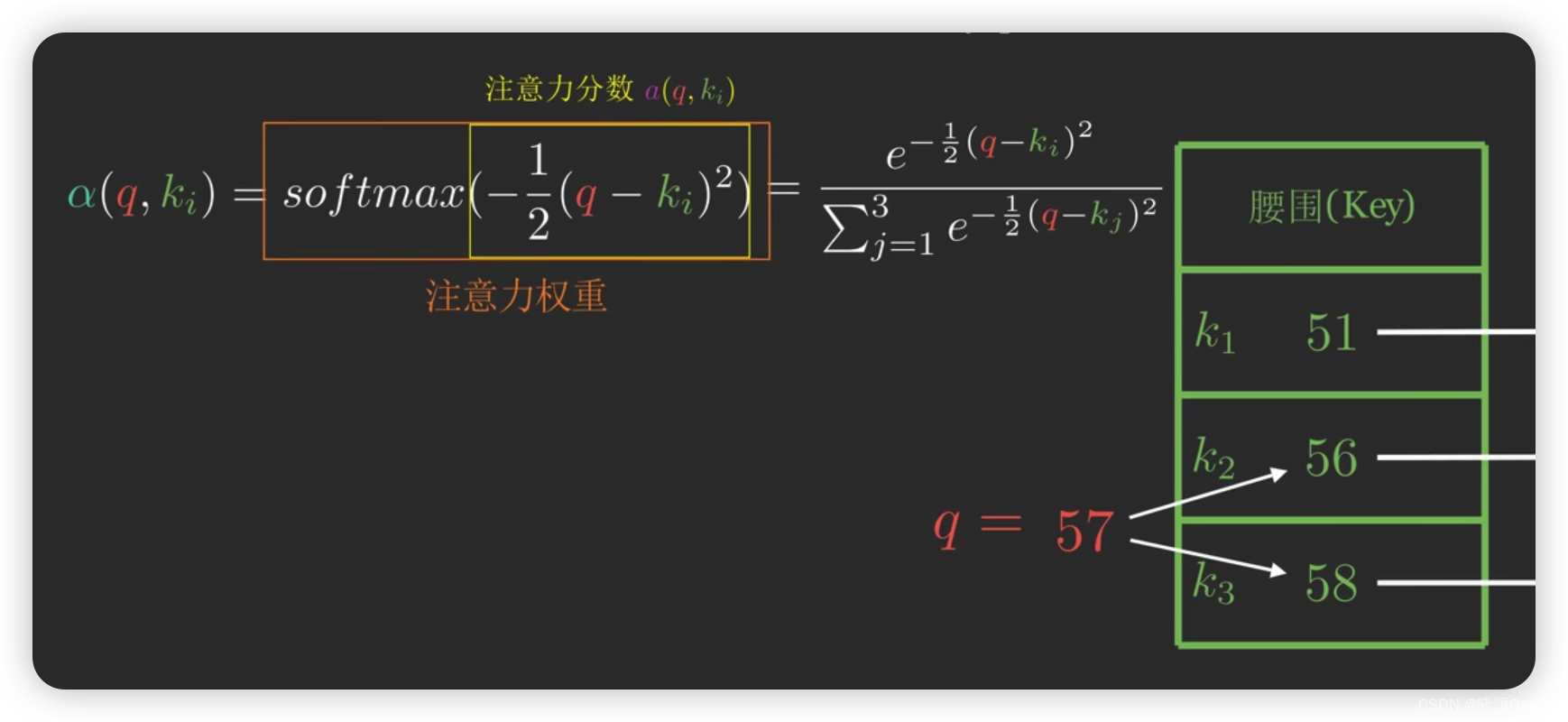

而以上有个问题,就是并没有将Key矩阵的51纳入到考虑中。

所以进一步,为了考虑到所有的影响,我们可以使用softmax来归一化Key矩阵每一个元素对答案的贡献的占比。算出注意力权重的具体过程如下——

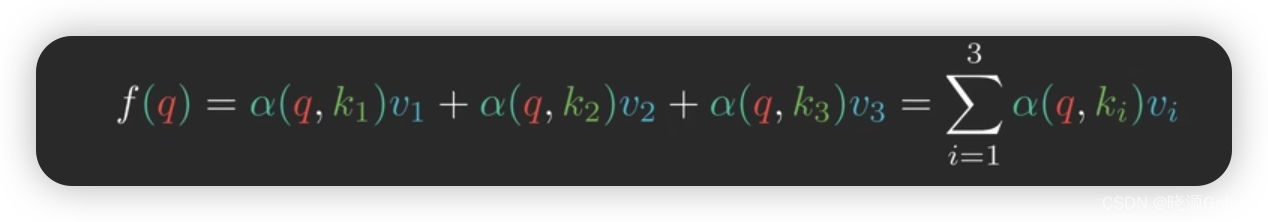

得到注意力权重系数后,我们就可以对查询对应的结果进行进一步的估计了。

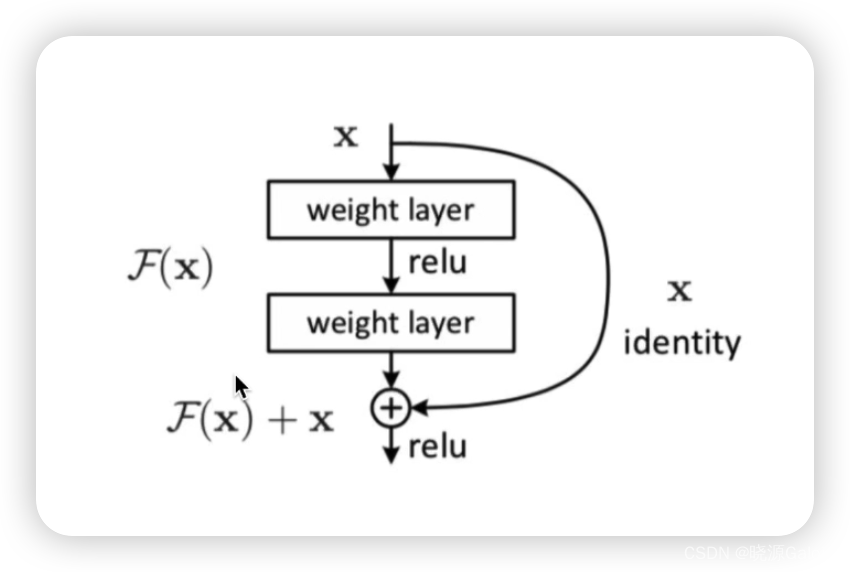

残差

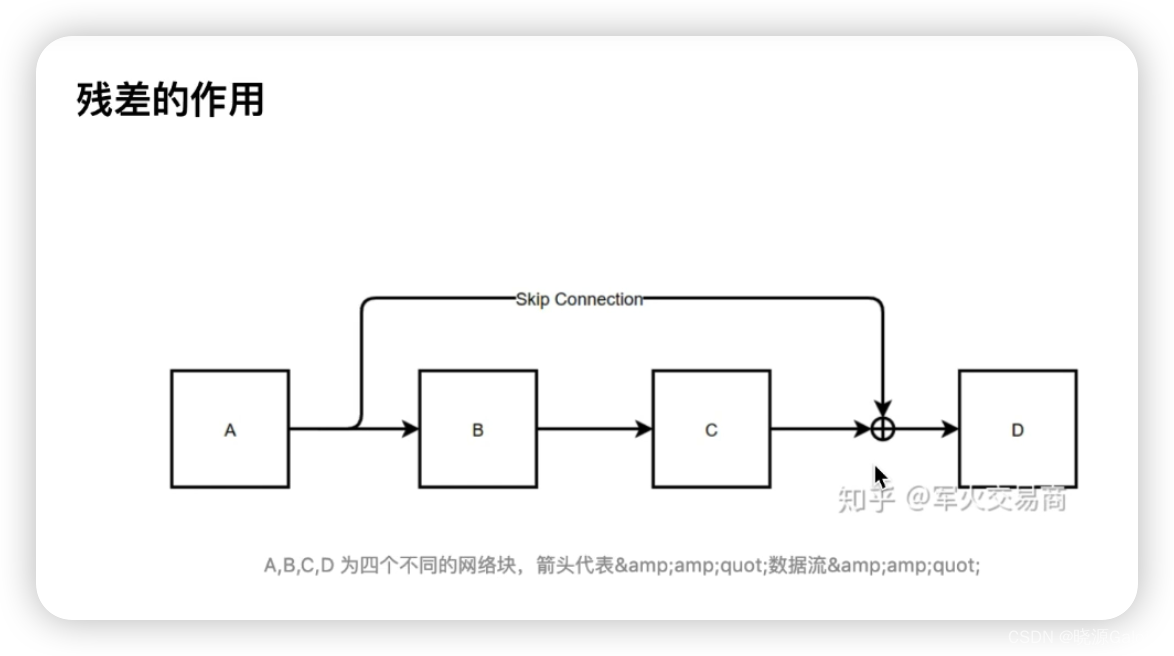

残差的作用

本文解释了TransformerEncoder中注意力机制的工作原理,通过腰围和体重的例子说明如何计算注意力权重。同时,介绍了残差在网络中的作用,强调了它如何帮助模型考虑所有影响因素并进行更精确的估计。

本文解释了TransformerEncoder中注意力机制的工作原理,通过腰围和体重的例子说明如何计算注意力权重。同时,介绍了残差在网络中的作用,强调了它如何帮助模型考虑所有影响因素并进行更精确的估计。

4326

4326

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?