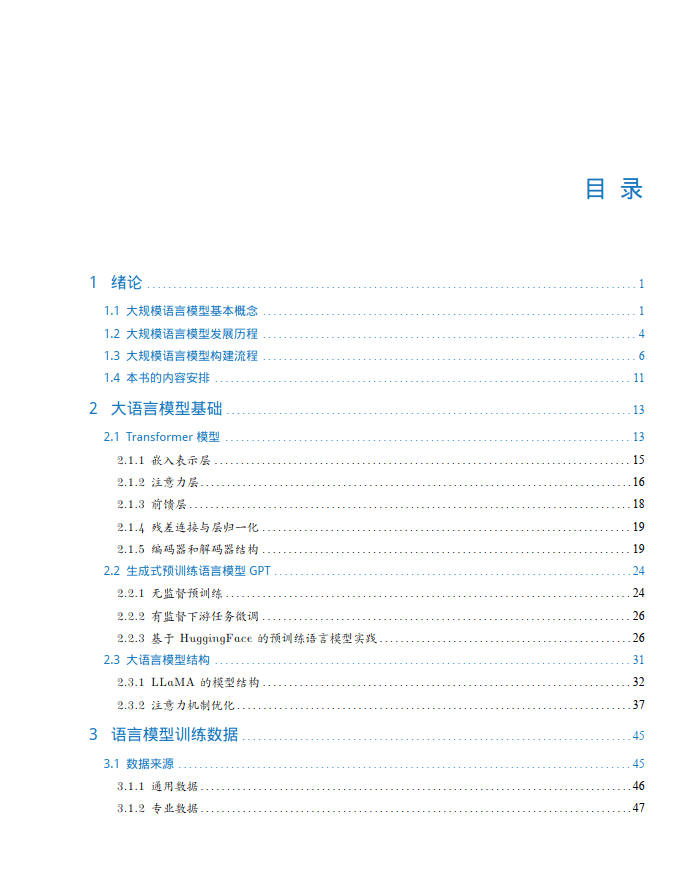

今天分享的AI系列深度研究报告:《AI大规模专题报告:大规模语言模型从理论到实践》。

(报告出品方:光大证券)

报告共计:25页

大规模语言模型基本概念

语言是人类与其他动物最重要的区别,而人类的多种智能也与此密切相关。逻辑思维以语言的形式表达,大量的知识也以文字的形式记录和传播。如今,互联网上已经拥有数万亿网页资源.其中大部分信息都是用自然语言描述。因此,如果人工智能算法想要获取知识,就必须懂得如何理解人类所使用的不太精确、可能有歧义并且甚至有些混乱的语言。语言模型 (Language Model, LM)目标就是建模自然语言的概率分布。词汇表V 上的语言模型,由函数 P(ww..wm)表示,可以形式化地构建为词序列 wwwm 的概率分布,表示词序列 ww2...wm 作为一个子出现的可能性大小。由于联合概率 P(ww2...wm) 的参数量十分巨大,直接计算 P(ww2...wm) 非常困难7。按照《现代汉语词典 (第七版)》包含约 7 万单词,句子长度按照 20 个词计算,语言模型参数量达到 7.9792 x 109 的天文数字。中文的书面语中,超过 100 个单词的句子也并不罕见,如果要将所有可能性都纳入考虑,语言模型的复杂度还会进一步急剧增加,以目前的计算手段无法进行存储和运算。

深度神经网络需要采用有监督方法,使用标注数据进行训练,因此,语言模型的训练过程也不可避免需要构造训练语料。但是由于训练目标可以通过无标注文本直接获得,从而使得模型的训练仅需要大规模无标注文本即可。语言模型也成为了典型的自监督学习 (Self-supervised Learning任务。互联网的发展,使得大规模文本非常容易获取,因此训练超大规模的基于神经网络的语言模型也成为了可能。

受到计算机视觉领域采用 ImageNetlt3] 对模型

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

993

993

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?