一、注意力机制介绍

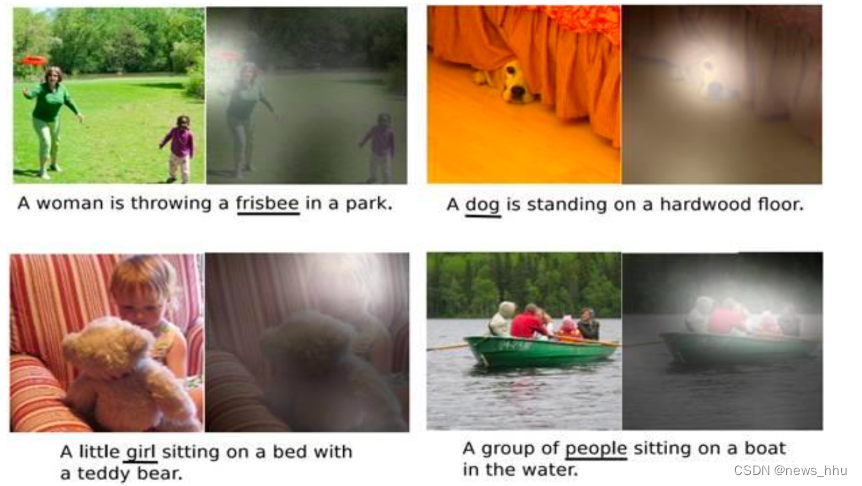

注意力机制来源于上个世纪90年代,认知领域的学者发现,人类在处理信息时,天然会过滤掉不太关注的信息,着重于感兴趣信息,于是将这种处理信息的机制称为注意力机制。注意力机制的灵感来源可以归结到人对环境的生理感知上来。比方说,我们的视觉系统更倾向于去挑选影像中的部分信息进行集中分析而忽略掉图像中的无关信息。

什么是注意力机制?

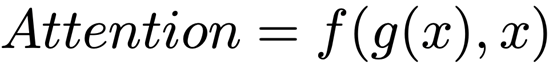

注意力机制可以理解为,计算机视觉系统在模拟人类视觉系统中可以迅速高效地关注到重点区域的特性。对于人类来说,当面对复杂场景的时候,我们可以迅速关注到重点区域,并处理这些区域。对于视觉系统,上述过程可以抽象成下面的式子:

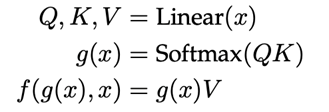

其中 g(x) 表示对输入特征进行处理并产生注意力的过程,f(g(x),x) 表示结合注意力对输入特征进行处理的过程。举两个具体的例子self-attention[2]和senet[3],对于 self-attention 来说,可以将上述公式具体化为:

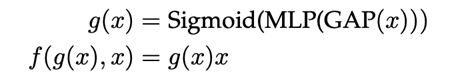

对于 senet 来说,可以将上述公式具体化为:

接下来,该综述尝试将不同的注意力机制进行具体化,即明确 g 过程和 f 过程。这是该综述对注意力机制的第一个统一的角度:定义上的统一。

现在已经成为神经网络研究中的一个非常重要的研究领域。目前注意力机制在很多视觉任务中都有好处,例如:图像分类、目标检测、语义分割、人脸识别、人物再识别、动作识别、少量显示学习、医学图像处理,图像生成、姿势估计、超分辨率、三维视觉和多模式任务。

总结:注意力机制的本质是一种权重分配机制,即对不同重要程度的信息赋予不同的权重,让系统学会注意力关注重点信息,同时忽略无关信息。

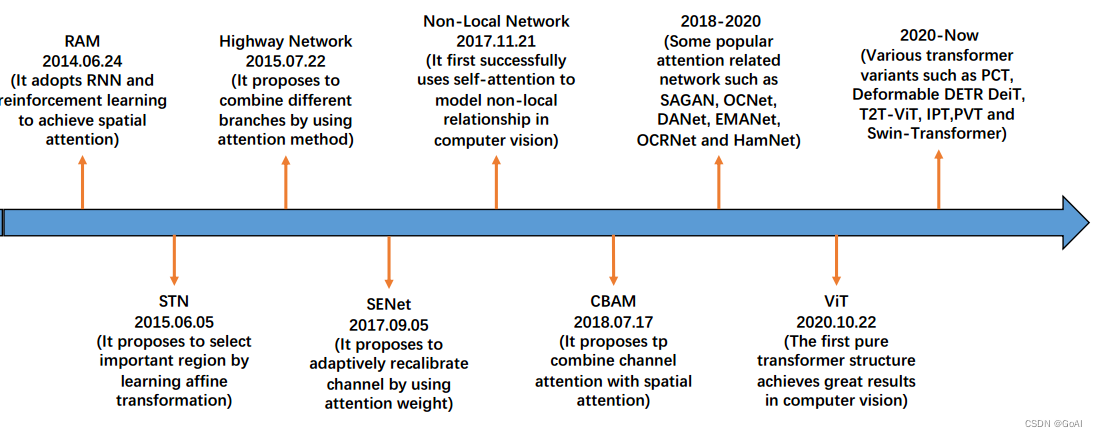

注意力机制发展历程:

过去十年,注意力机制在计算机视觉中逐渐起重要作用。图3简要地总结了基于deep learning 的CV领域中attention-based模型的发展历史。成果大致可以分为四个阶段。

- 第一阶段:从RAM开始的开创性工作,将深度神经网络与注意力机制相结合。它反复预测重要区域。并以端到端的方式更新整个网络。之后,许多工作采用了相似的注意力策略。在这个阶段,RNN在注意力机制中是非常重要的工具。

- 第二阶段:从STN中,引入了一个子网络来预测放射变换用于选择输入中的重要区域。明确预测待判别的输入特征是第二阶段的主要特征。DCN是这个阶段的代表性工作。

- 第三阶段:从SENet开始,提出了通道注意力网络(channel-attention network)能自适应地预测潜在的关键特征。CBAM和ECANet是这个阶段具有代表性的工作。

- 第四阶段:self-attention自注意力机制。自注意力机制最早是在NLP中提出并广泛使用。**Non-local网络是最早在CV中使用自注意力机制,并在视频理解和目标检测中取得成功。像EMANet,CCNet,HamNet和the Stand-Alone Network遵循此范式并提高了速度,质量和泛化能力。**最近,**深度自注意力网络(visual transformers)**出现,展现了基于attention-based模型的巨大潜力。

按不同种类分,注意力机制主要分成软注意力机制、强注意力机制、和自注意力机制。

1.软注意力机制:根据每个区域被关注程度的高低,用0~1之间的概率值来表示;与硬注意力相比,软注意力是一个可微的过程,可以通过训练过程的前向和后向反馈学习得到;因为对每部分信息都有考虑,所以相对于硬注意机制,计算量比较大。

2.强注意力机制:即哪些区域是被关注的,哪些区域是不被关注的,是一个是或不是的问题,会直接舍弃掉一些不相关项,如在图像领域的图像裁剪,裁剪后留下的部分即被关注的区域;优势在于会节省一定的时间和计算成本,但是有可能会丢失一部分信息。值得注意的是,因其是一个不可微的过程,所以在cv领域,一般用在强化学习中;如在视频领域中,因为有时序性关系,每张图片即为某个时间点下的采样,强注意力机制则可以看成是否对该时间点的采样关注,可以通过强化学习来训练。

3.自注意力机制:自注意力是对每个输入赋予的权重取决于输入数据之间的关系,即通过输入项内部之间的相互博弈决定每个输入项的权重。与前两项机制相比,自注意力在计算时,具有并行计算的优势。

总结: 硬注意力机制是从当前储存的信息中只选择一个,例如在卷积神经网络中,只选择N个特征图(通道)中的其中1个(通道注意力),或者是从图像中裁切下其中的一小部分区域(空间注意力)。软注意力机制则不丢弃任何信息,只是给他们赋予不同的权重,给予不同的影响力。由于硬注意力机制通常不可微分,很难通过反向传播参与训练,神经网络中通常使用软注意力机制。

**在CV领域注意力机制方式还可以分类为通道注意力,空间注意力,混合域注意力和自注意力等。**下面通过网上的一张综述图介绍卷积神经网络中常见的几种注意力机制模块:

总结:注意力机制的本质是一种权重分配机制,即对不同重要程度的信息赋予不同的权重,让系统学会注意力关注重点信息,同时忽略无关信息。

570

570

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?