监督式深度学习的核心法则:你需要多少数据?

原图作者:Chris Albon

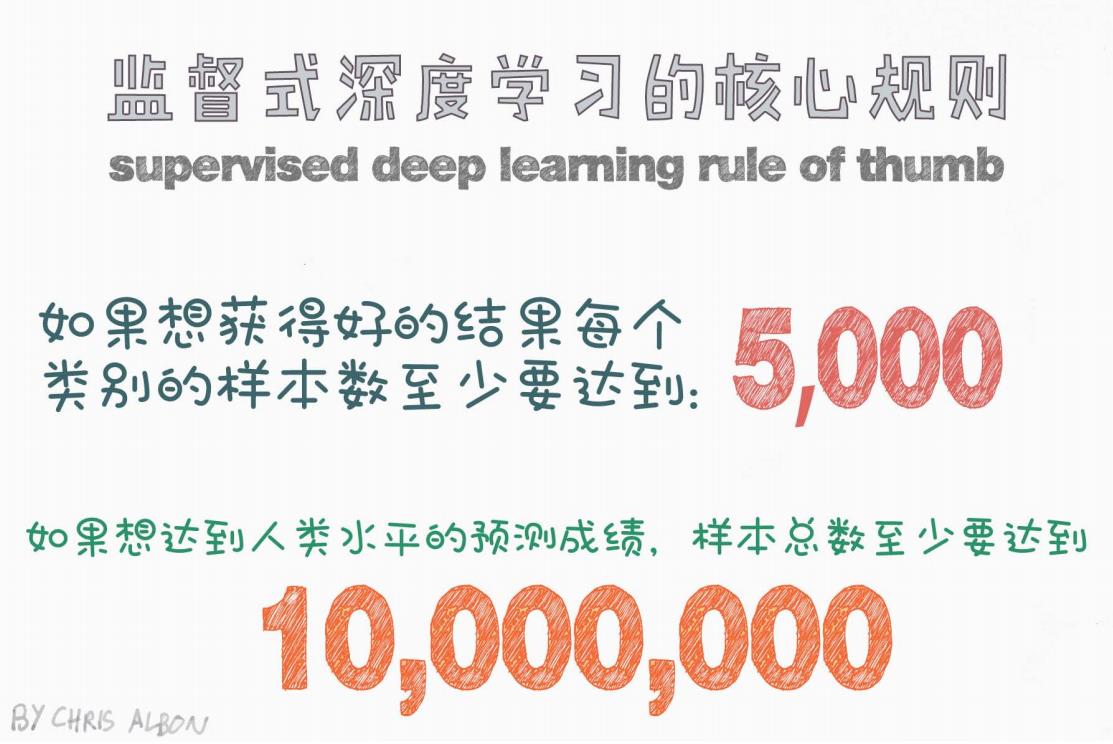

在进行深度学习项目时,我们常常面临一个核心问题:我到底需要多少训练数据?这是许多初学者甚至资深工程师都会困惑的问题。图中给出了一个非常实用的“监督式深度学习样本数量经验法则”,可以作为我们评估数据需求时的参考依据。

经验法则一:如果你想获得“好的”结果,每个类别至少需要 5000 个样本

图中提到的第一条建议是:

如果想获得好的结果,每个类别的样本数至少要达到:5000

这句话的含义是:在一个分类任务中,如果我们希望模型可以对每个类别都能进行基本有效的预测,那么每个类别至少需要5000 条高质量、标注清晰的数据样本。

举个例子:

假如你正在训练一个猫狗识别模型(即2类分类任务):

-

猫类样本:5000 条

-

狗类样本:5000 条

那你总共至少需要 10,000 条训练样本,模型才有可能达到“还不错”的表现。

当然,所谓“还不错”,并不意味着超越人类或者可商用,而是能避免严重过拟合、欠拟合,并具备一定的泛化能力。

经验法则二:如果你想达到“人类水平”的预测精度,总样本数至少需要 1000 万

如果想达到人类水平的预测成绩,样本总数至少需要达到:10,000,000

这条建议更进一步地指出,如果你希望模型在某项任务上能够逼近甚至媲美人类专家的水平,比如图像识别、语音识别、语言理解等领域,那么你就得准备千万级别的数据量。

举个例子:

你想训练一个能像人一样识别图像中的物品的模型,参考 Google 的 ImageNet 分类挑战赛,其训练集包含了:

-

超过 1000 个类别

-

每个类别数千张图像

-

总图像数超过 1400 万张

这正好印证了这条经验法则。

为什么需要这么多数据?

1. 模型参数多,容易过拟合

深度神经网络模型的参数往往是数百万甚至上亿级别,没有大量数据支撑,模型很容易陷入过拟合,只记住训练样本,而无法泛化。

2. 特征空间复杂

深度学习模型的强大之处在于可以自动学习特征,但前提是这些特征在数据中充分存在且多样化。数据不足时,模型就学不到足够的通用特征。

3. 类别不平衡问题

在多分类任务中,如果某些类别的数据量特别少,模型训练出来可能会忽略这些类别,导致严重偏差。5000 是一个让模型“看到足够多该类样本”的下限估计。

真实项目中我们怎么办?

现实项目中,并不是每个人都能拿到成千上万的标注数据,那我们该怎么办?

1. 数据增强(Data Augmentation)

常用于图像、语音任务,例如旋转、缩放、裁剪、添加噪声等,能有效扩展训练集。

2. 迁移学习(Transfer Learning)

加载在大规模数据集(如 ImageNet)上预训练好的模型,只在自己小数据集上微调,可以在数据不足的情况下获得不错效果。

3. 合成数据(Synthetic Data)

通过仿真模拟、人为生成等方式合成更多训练样本,比如 GPT、Diffusion 模型可以用来生成文本或图像训练数据。

4. 半监督 / 弱监督 / 无监督方法

例如伪标签学习、自监督对比学习等,是近年来研究的热点,能在标签缺失或数据稀缺下仍训练出有一定能力的模型。

总结

Chris Albon 总结的“监督式深度学习样本数量法则”并非铁律,但在大多数实际项目中都具有很高的指导意义:

| 目标 | 所需样本量(估计) |

|---|---|

| 获取还不错的结果 | 每类 5000 个样本 |

| 达到人类水平 | 总样本 1000 万 |

这提醒我们,在考虑模型结构、损失函数、调参技巧之前,数据质量和数量始终是最重要的因素之一。

如果你正在启动一个新项目,不妨先看看你的数据量是否符合这些经验线,再决定是否继续深度学习的方向。

欢迎在评论区分享你的项目数据量与模型表现之间的真实关系!

参考资料:

-

Chris Albon. Machine Learning Flashcards

-

Andrew Ng. Data-centric AI Movement

-

Stanford CS231n 课程讲义

1593

1593

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?