前言

所以今天要学习的是另一个大多数人或许都用得上的知识点-线稿上色。

对于插画师来说,线稿一般是用来绘制大概画面和构思创意的方式,差不多就是打草稿。而一张完整的插画需要经过线稿-上色-光影-细节修补等环节。

像是很早前在学习SD时说过的,AI绘画其中的一大问题就是随机性,对于那些有着严格细节把控或者说甲方要求频繁改动的画师来说,AI绘画并不是一个很好的选择。

不过在我们的ControlNet这类可以“摁”着AI的手不要让它乱画的工具出现之后,AI绘画或许在逐渐进入到商业画师的视野。

很好地将AI融入到了自己的工作流程中

这位职业插画师曾经参与过《封神》、《刺杀小说家》、《将夜》等热门电影电视剧的海报制作。

今天的学习内容就是跟着小南老师学习如何把一张线稿丢给AI,让AI来干接下来的活。

第一步:线稿绘制

一般专业插画师都会在专业的绘制软件或者PS上进行线稿的绘制,这里就借用原视频UP分享的格子老师的线稿作为学习资料(感兴趣可以去文末领取)。

第二步:进入文生图中的ControlNet

为啥选择的是文生图而不是图生图中的ControlNet,因为这样做可以完全排除线稿图片本身颜色对生成画面的影响,设置参数如下:

预处理器:invert(from white bg& black line)白底黑线

**模型:control_v11p_sd15_lineart

**

控制权重:1.1

LineArt在这样完成度比较高的线稿上实现的控制效果更为精确,上篇笔记所用的SoftEdge则会给AI更多的发挥空间。

**第三步:提示词和模型参数设置

**

在这里选择的CheckPoint是那种场景人物细节都拉满表现还不错的模型

查阅、整理和输出教程属实不易,觉得这篇教程对你有所帮助的话,可以点击👇二维码领取资料

Lora选择的则是赛博朋克写实风格

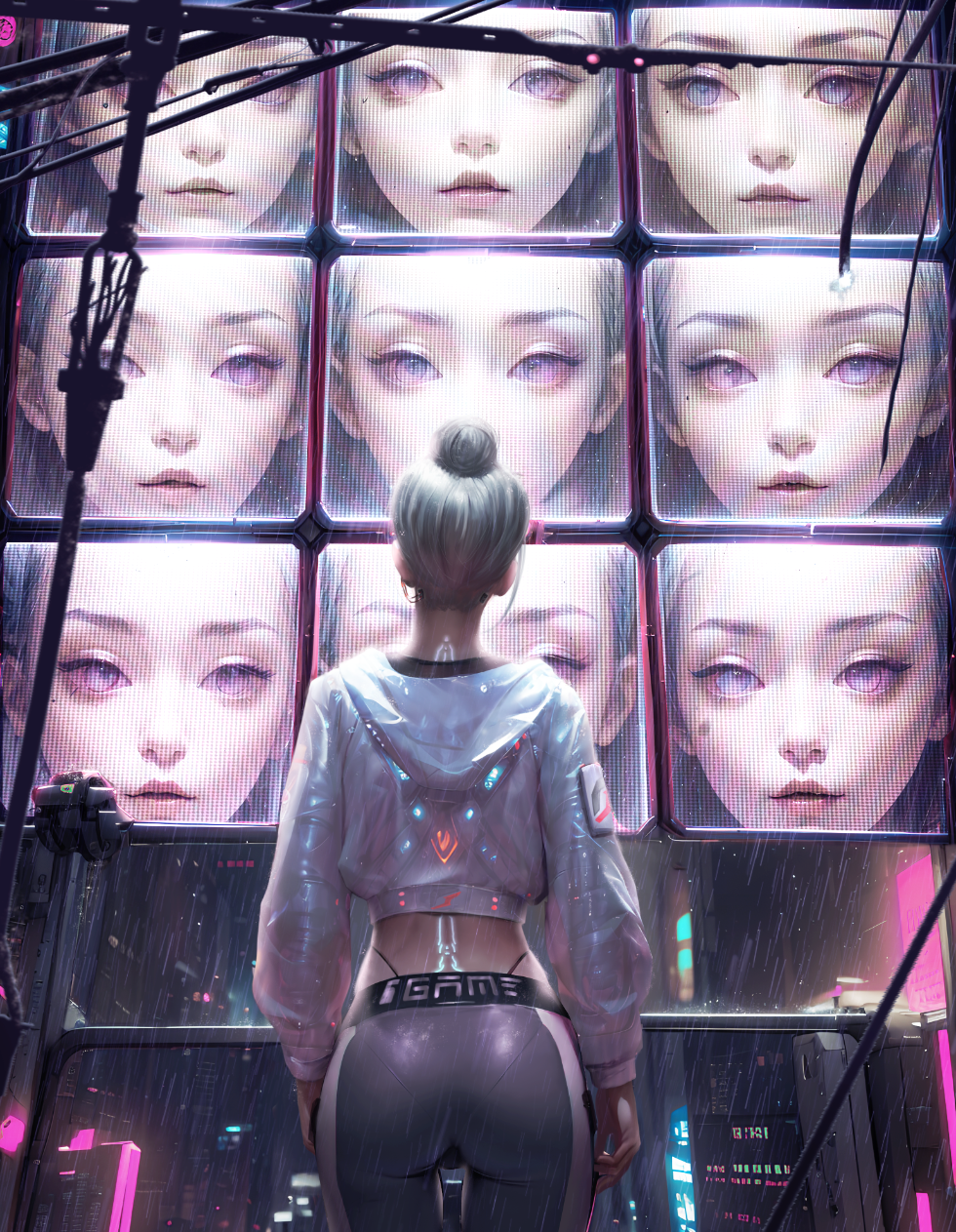

**正向提示词:**best quality,(masterpiece),In the cyberpunk city rainy night,only the light of the LCD screen,a cool cyberpunk girl standing at the intersection of cyberpunk street in the heavy rain,back,slender sexy waist,she looked up at the huge screen composed of nine LCD monitors in front of her,showing the beautiful girl’s flowing rain face,she was wearing a yellow short plastic jacket and low-waisted sexy tight functional pants,showing the edge of underwear,tied with a high ponytail hairstyle,half-length portrait,the background is dense buildings,backlight,futuristic,photorealistic,background of future science and technology,Center the composition,Unreal Engine,Cyberpunk light,8K Resolution,high detail,hyperquality,fantasy,futuristic,Purple light effect,<lora:超写实赛博朋克美女_v1:0.8>,

**反向提示词:**nsfw,(worst quality:1.6), (low quality:1.6), (normal qualiy:1.6),EasyNegative,ng_deepnegative_v1_75t,watermark,logo,text,signature,artist name,bad anatomy, wrong anatomy, extra limb, missing limb,floating limbs, disconnected limbs, mutation, mutated, ugly, disgusting, blurry,amputation, tattoo, cropped, backlight,monochrome,

其余参数:

迭代30、DPM++2M Karras、769*1024、种子2964646560

这里不建议使用高分辨率修复,因为出来的图会比较奇怪。

正如我之前所说的,AI的产出带有随机性,所以格子老师在这里会选择生成多张图片来挑选最适合的作为底图。

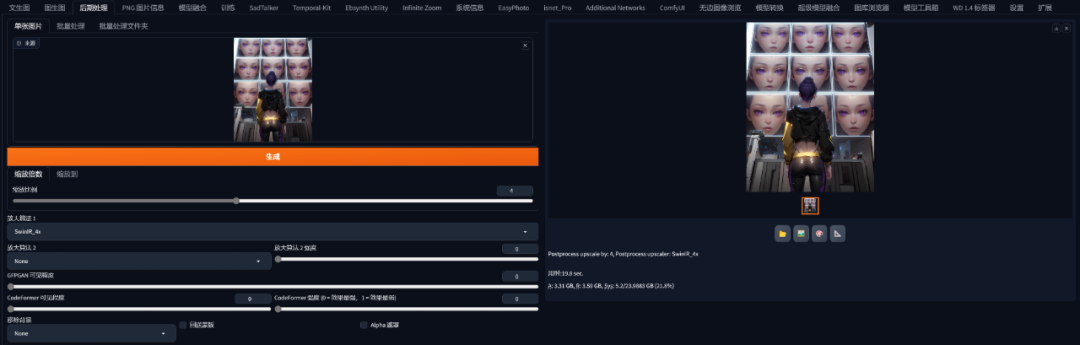

如果显存超过12GB的话可以将总批次数选择为4、单批数量选择4。这样就可以让AI一次画多张图,提升“抽卡”的效率。

在批量生成后选择一张最让自己满意的图片,这张底图不需要太完美,即便是有一些细节上的偏差,都可以随时在结构相似的另一张图里找到“备用方案”,这也是大批量生产的好处。

之后再将符合自己预期的地方截取出来拼接在底图上,为了避免细节不会因为放大模糊,格子老师还通过后期处理的SwinIR 4X放大算法将这些图片超分到4K左右的级别。

**(原图超过10M,这个是我直接截图出来的)

**

之后格子老师会将最喜欢的底图放进PS中进行细节上的处理,例如哪些地方细节不满意就直接从别的图摘过来拼接之类的,在细节处理都搞定之后成品也就完成了!

白毛可太戳我了!

今天的内容就到这里结束啦!

目前 ControlNet 已经更新到 1.1 版本,相较于 1.0 版本,ControlNet1.1 新增了更多的预处理器和模型,每种模型对应不同的采集方式,再对应不同的应用场景,每种应用场景又有不同的变现空间

我花了一周时间彻底把ControlNet1.1的14种模型研究了一遍,跑了一次全流程,终于将它完整下载好整理成网盘资源。

其总共11 个生产就绪模型、2 个实验模型和 1 个未完成模型,现在就分享给大家,点击下方卡片免费领取。

1. 线稿上色

**方法:**通过 ControlNet 边缘检测模型或线稿模型提取线稿(可提取参考图片线稿,或者手绘线稿),再根据提示词和风格模型对图像进行着色和风格化。

**应用模型:**Canny、SoftEdge、Lineart。

Canny 示例:(保留结构,再进行着色和风格化)

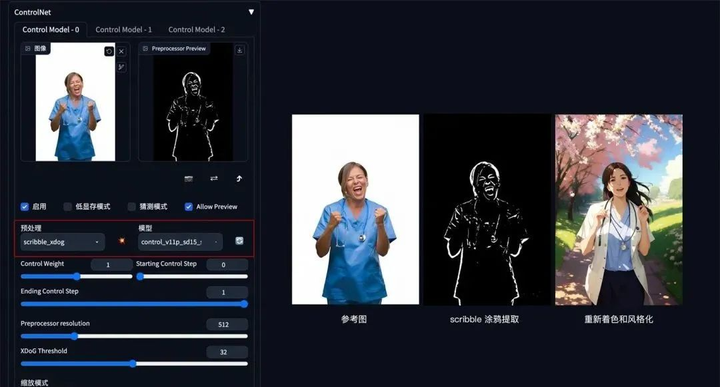

2. 涂鸦成图

方法:通过 ControlNet 的 Scribble 模型提取涂鸦图(可提取参考图涂鸦,或者手绘涂鸦图),再根据提示词和风格模型对图像进行着色和风格化。

应用模型:Scribble。

Scribble 比 Canny、SoftEdge 和 Lineart 的自由发挥度要更高,也可以用于对手绘稿进行着色和风格处理。Scribble 的预处理器有三种模式:Scribble_hed,Scribble_pidinet,Scribble_Xdog,对比如下,可以看到 Scribble_Xdog 的处理细节更为丰富:

Scribble 参考图提取示例(保留大致结构,再进行着色和风格化):

3. 建筑/室内设计

**方法:**通过 ControlNet 的 MLSD 模型提取建筑的线条结构和几何形状,构建出建筑线框(可提取参考图线条,或者手绘线条),再配合提示词和建筑/室内设计风格模型来生成图像。

**应用模型:**MLSD。

MLSD 示例:(毛坯变精装)

这份完整版的ControlNet 1.1模型我已经打包好,需要的点击下方插件,即可前往免费领取!

4. 颜色控制画面

**方法:**通过 ControlNet 的 Segmentation 语义分割模型,标注画面中的不同区块颜色和结构(不同颜色代表不同类型对象),从而控制画面的构图和内容。

**应用模型:**Seg。

Seg 示例:(提取参考图内容和结构,再进行着色和风格化)

如果还想在车前面加一个人,只需在 Seg 预处理图上对应人物色值,添加人物色块再生成图像即可。

5. 背景替换

**方法:**在 img2img 图生图模式中,通过 ControlNet 的 Depth_leres 模型中的 remove background 功能移除背景,再通过提示词更换想要的背景。

**应用模型:**Depth,预处理器 Depth_leres。

**要点:**如果想要比较完美的替换背景,可以在图生图的 Inpaint 模式中,对需要保留的图片内容添加蒙版,remove background 值可以设置在 70-80%。

Depth_leres 示例:(将原图背景替换为办公室背景)

6. 图片指令

**方法:**通过 ControlNet 的 Pix2Pix 模型(ip2p),可以对图片进行指令式变换。

应用模型:ip2p,预处理器选择 none。

**要点:**采用指令式提示词(make Y into X),如下图示例中的 make it snow,让非洲草原下雪。

Pix2Pix 示例:(让非洲草原下雪)

7. 风格迁移

**方法:**通过 ControlNet 的 Shuffle 模型提取出参考图的风格,再配合提示词将风格迁移到生成图上。

**应用模型:**Shuffle。

Shuffle 示例:(根据魔兽道具风格,重新生成一个宝箱道具)

8. 色彩继承

**方法:**通过 ControlNet 的 t2iaColor 模型提取出参考图的色彩分布情况,再配合提示词和风格模型将色彩应用到生成图上。

**应用模型:**Color。

Color 示例:(把参考图色彩分布应用到生成图上)

这份完整版的ControlNet 1.1模型我已经打包好,需要的点击下方插件,即可前往免费领取!

这里就简单说几种应用:

1. 人物和背景分别控制

2. 三维重建

3. 更精准的图片风格化

4. 更精准的图片局部重绘

以上就是本教程的全部内容了,重点介绍了controlnet模型功能实用,当然还有一些小众的模型在本次教程中没有出现,目前controlnet模型确实还挺多的,所以重点放在了官方发布的几个模型上。

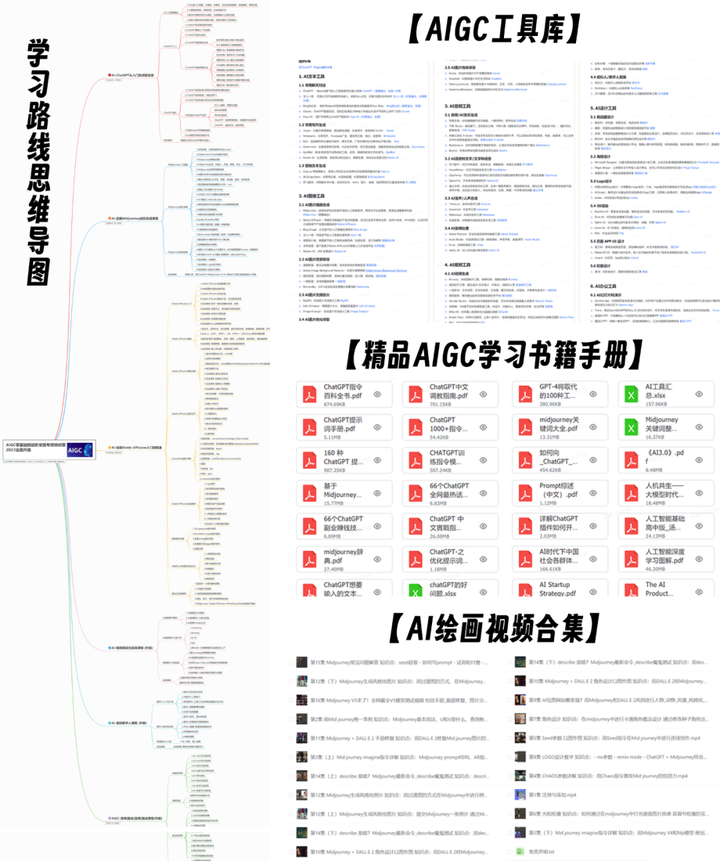

同时大家可能都想学习AI绘画技术,也想通过这项技能真正赚到钱,但是不知道该如何开始学习,因为网上的资料太多太杂乱了,如果不能系统的学习就相当于是白学,因为自身做副业需要,我这边整理了全套的Stable Diffusion入门知识点资料,大家有需要可以直接点击下边卡片获取,希望能够真正帮助到大家。

1090

1090

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?