一、概述

Transformer是由Vaswani等人在2017年提出的一种基于自注意力机制(Self-Attention Mechanism)的深度学习网络架构的大模型,被广泛应用于自然语言处理(NLP)领域,如机器翻译、文本生成等任务。它摒弃了传统的RNN(循环神经网络)和CNN(卷积神经网络)的结构,通过自注意力机制捕捉输入序列中的长距离依赖关系,从而有效地解决了长序列处理中的梯度消失和梯度爆炸问题。使得信息可以在整个序列中自由流动,从而更好地捕捉到序列内部的复杂模式,让模型能够并行处理输入序列,为我们提供了一种全新的处理序列数据的方法,大大提高了训练速度和模型性能。

二、主要组成

1、编码器(Encoder):

编码器负责将输入序列(如文本)进行编码,将每个词或字转换为一个高维向量表示。编码器由多个相同的层堆叠而成,每层包含两个子层:多头自注意力(Multi-Head Self-Attention)和位置前馈神经网络(Position-wise Feed-Forward Neural Network)。

2、解码器(Decoder):

解码器负责根据编码器的输出预测目标序列。与编码器类似,解码器也由多个相同的层堆叠而成,但每层包含三个子层:多头自注意力、多头注意力(Multi-Head Attention,与编码器的输出进行交互)和位置前馈神经网络。

3、自注意力机制:

自注意力机制允许模型在处理序列时关注输入序列中的任意位置。对于输入序列中的每个元素,自注意力机制计算其与其他所有元素之间的关联程度,并将这些关联程度作为权重,对输入序列进行加权求和,得到一个新的表示。多头自注意力将输入分为多个子空间,分别进行自注意力计算,再将结果拼接起来,从而捕捉到不同层次和方面的信息。

通过计算输入序列中每个元素与其他元素的相似度(权重),实现对序列的动态关注和上下文表示的生成。

多头注意力:将输入分成多个子空间进行并行的自注意力计算,增强模型对不同信息的关注。

4、前馈神经网络(FFN):

位置前馈神经网络是一个全连接的前馈神经网络,用于对输入序列的每个位置进行独立的非线性变换。这种设计使得模型能够同时捕捉到序列中的局部和全局信息。

每个自注意力层之后,都有一个FFN,通常包含两个线性变换和非线性激活函数(如ReLU),以进一步提炼特征。

5、位置编码(Positional Encoding):

由于Transformer架构没有循环结构,为解决模型无法直接识别序列位置信息的问题,因此需要额外引入位置信息来表示序列中元素的顺序。位置编码通过为每个位置分配一个特定的向量,将这些向量与输入序列的初始表示相加,从而将位置信息嵌入到模型中。

即:引入位置编码,将位置信息以向量形式添加到输入中。

5、残差连接与层归一化:

残差连接 (Residual Connection)和归一化 (Normalization)被广泛应用于各个组件之间。有助于训练更深网络,残差连接通过将输入直接加到输出上,有助于缓解深层网络中的梯度消失问题;而归一化则通过对输出进行标准化处理,有助于加速训练过程并提高模型的稳定性。

三、相关步骤:

1)输入序列经过嵌入层(Embedding Layer)转换为词向量表示。

添加位置编码以引入位置信息。

2)编码器对输入序列进行多层自注意力计算和位置前馈神经网络变换,得到编码后的表示。

3)解码器根据编码器的输出,结合目标序列的先前预测,进行多层自注意力和多头注意力计算以及位置前馈神经网络变换,得到预测结果。

4)通过损失函数(如交叉熵损失)评估预测结果与实际目标序列之间的差异,并通过反向传播更新模型参数。

四、核心特点与优势:

1、自注意力机制:

Transformer摒弃了传统循环神经网络(RNN)和卷积神经网络(CNN),完全基于自注意力机制,允许模型并行处理输入序列,极大提升训练速度和模型性能。

2、长距离依赖处理:

通过自注意力机制,模型能够捕捉序列中任意位置之间的依赖关系,有效解决长距离依赖问题。

3、并行计算与效率:

自注意力机制的并行性使得Transformer模型在大规模数据集和复杂任务上训练更加高效,适合分布式GPU环境。

4、灵活性与表达力:

多头注意力机制增强了模型的表达能力,允许模型在不同表示子空间中同时关注不同信息,提高了模型处理复杂语言结构的能力。

五、应用范围:

1、各类模型

OpenAI的GPT系列、Bloom等开源模型以及谷歌发布的LaMDA等,都是这一进步的代表。这些模型在各种任务中都取得了显著的性能提升,无论是自然语言处理、图像识别还是语音识别等领域,都有它们的身影。

2、预训练语言模型:

Google的BERT模型就是一种基于Transformer结构的预训练语言模型,它在大规模无监督文本数据上进行预训练,然后可以迁移到各种NLP任务中,如情感分析、命名实体识别等。

3、图像识别方面:

研究人员将Transformer模型与卷积神经网络(CNN)相结合,形成了一种新的架构,称为“视觉Transformer”。这种模型在图像分类、目标检测等任务上取得了令人瞩目的成果。例如,Facebook AI Research团队开发的一种名为DALL-E的模型,就是基于Transformer的图像生成模型,它可以生成逼真的图像,甚至可以生成连人类都无法想象的新颖图像。

4、语音识别方面:

Transformer模型也被用来构建端到端的语音识别系统。这种系统可以直接从原始音频信号中提取特征,并将其转化为文字。这种方法避免了传统的语音识别系统中的许多复杂步骤,如声学模型、语言模型等,从而大大提高了识别的准确率。

六、简述总结

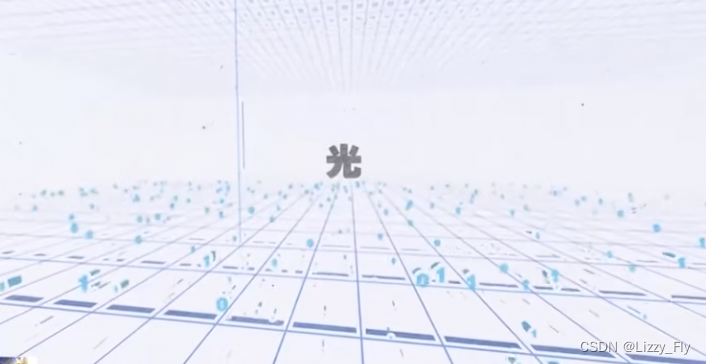

1)在Transformer之前,AI对人类语言的理解相当有限

2)在AI眼中语言由一个个独立的词语组织成

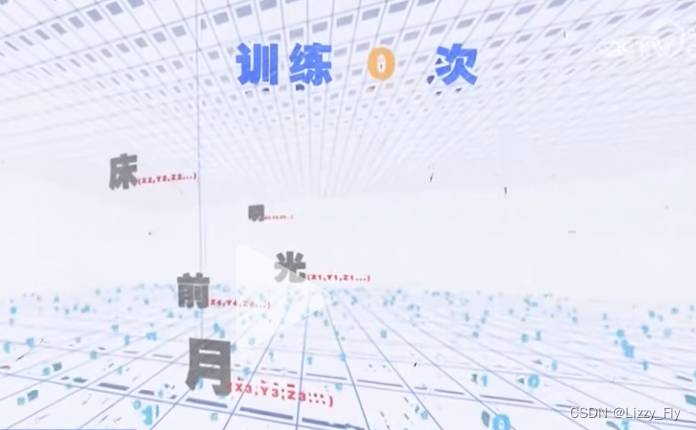

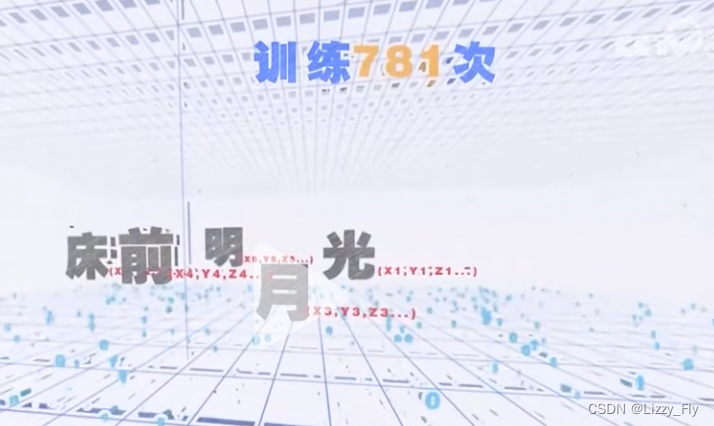

3)而每个词又可以根据语义被表述为一串拥有超多维度的数字,就像地图上的坐标准确标定出每个词语在空间维度中的位置。

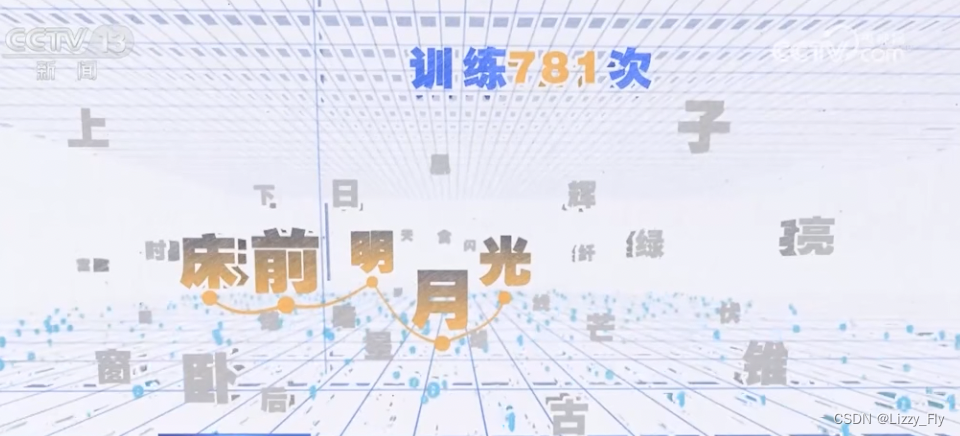

4)大语言模型的训练,让AI在学习海量真实语量的过程中不断调整词语排布,让关联强的相互靠近,最终得到一幅最优的语言地图,AI想要生成新内容,只需要按图索骥,一个接一个串联起身边词即可。

5)但因为AI只能看到最近的词,无法对 句子甚至语篇形成整体概念 ,因此经常给出一些离谱的回答,Transformer的开创性为AI打开了一个全局视角,让AI能通览整篇文本,理解语境,捕捉全文关键词。

6)至此,大模型拥有了对语篇的理解能力,以及生成复杂、连贯、文本的能力,AI迈入了一个新纪元。

1603

1603

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?