什么是Representation Learning?

根据Bengio在2013年的一篇综述论文里的描述,所谓Representation Learning, 就是“learning the representations of the data that make it easier to extract useful information when building classifiers or other predictions”。简单来说就是在进行正式训练之前,提取训练数据的特征的一种方法。

一、 Greedy Layer-Wise Unsupervised Pretraining

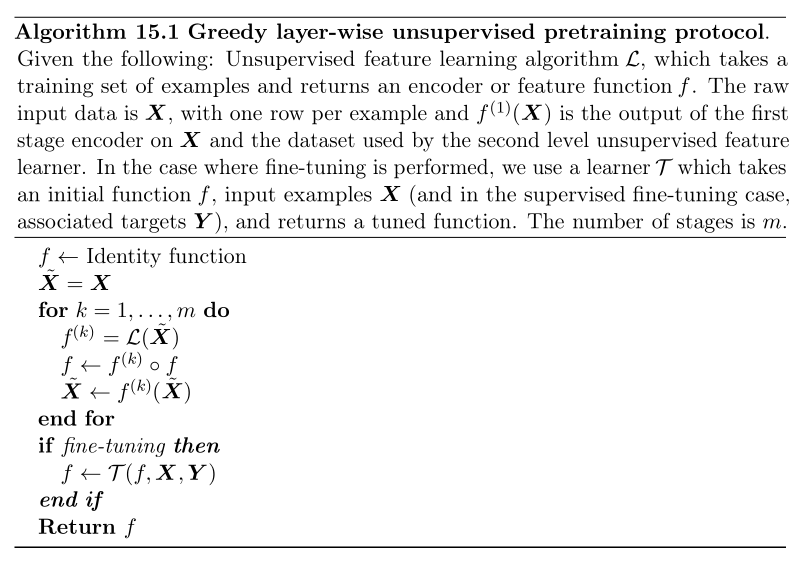

这种算法的基本思想是:利用unsupervised learning来抓取输入数据的特征,然后把这些特征运用到supervised learning里面。这种算法应用的场景是,我们手上有大量未标定的数据,与此同时人工标定会耗费大量的时间和物力,因此我们就先用非监督学习提取大部分没有标定的数据的特征后,再将这些特征运用于监督学习中。

Greedy:对于我们训练的模型,通常是有多层的。因此我们每次取出一层,每层将其参数优化到最佳状态,逐层进行。这样,我们得到的每一层的参数,对于那一层来说都是最优的。

Fine tune:虽然每一层的参数对那层来说都是最优的,但对于整体而言,参数并不一定式最优的,因此需要使用BP算法来对所有参数做一次整体更新,这一步骤称作微调(fine tuning)。

Representation Learning是通过预训练提取数据特征,便于构建分类器。包括贪婪逐层无监督预训练、迁移学习和域自适应、分布式表示。贪婪逐层预训练利用未标记数据获取特征,再用于监督学习。迁移学习跨越不同分布进行学习,解决数据分布差异问题。分布式表示用词向量克服one-hot表示的局限,通过向量距离衡量词的相似性。

Representation Learning是通过预训练提取数据特征,便于构建分类器。包括贪婪逐层无监督预训练、迁移学习和域自适应、分布式表示。贪婪逐层预训练利用未标记数据获取特征,再用于监督学习。迁移学习跨越不同分布进行学习,解决数据分布差异问题。分布式表示用词向量克服one-hot表示的局限,通过向量距离衡量词的相似性。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

308

308

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?