01

简介

《在 AI 爱克斯开发板上用 OpenVINO™ 加速 YOLOv8 分类模型》介绍了在 AI 爱克斯开发板上使用 OpenVINO™ 开发套件部署并测评 YOLOv8 的分类模型,本文将介绍在 AI 爱克斯开发板上使用 OpenVINO™ 加速 YOLOv8 目标检测模型。

请先下载本文的范例代码仓,并搭建好 YOLOv8 的 OpenVINO™ 推理程序开发环境:

git clone

https://gitee.com/ppov-nuc/yolov8_openvino.git

02

导出 YOLOv8 目标检测 OpenVINO™ IR 模型

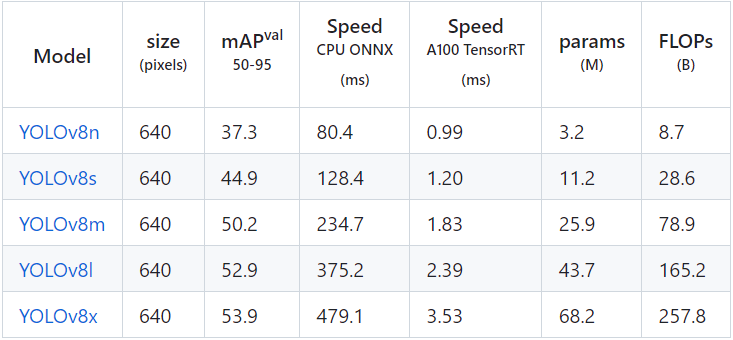

YOLOv8 的目标检测模型有5种,在 COCO 数据集完成训练,如下表所示。

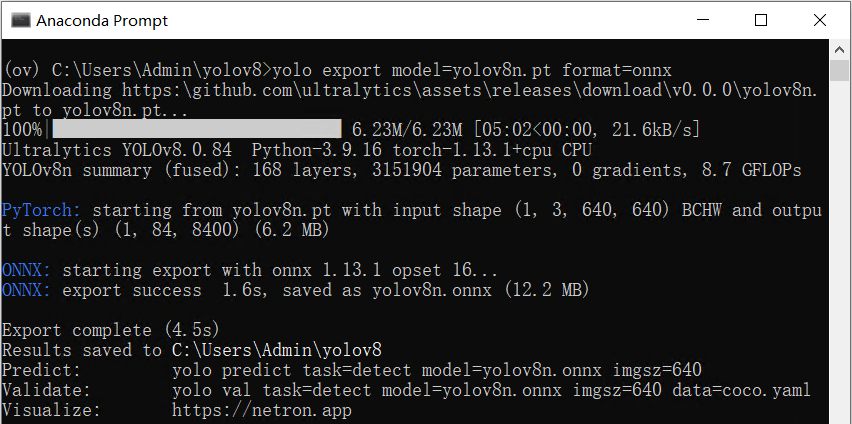

首先使用命令:

yolo export model=yolov8n.pt format=onnx

完成 yolov8n.onnx 模型导出,如下图所示:

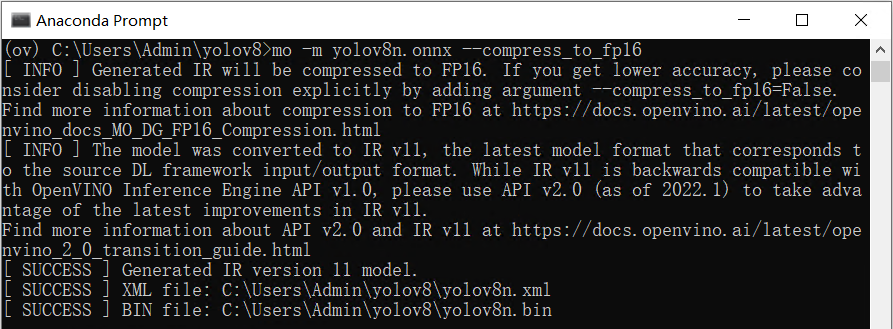

然后使用命令:

mo -m yolov8n.onnx --compress_to_fp16

优化并导出 FP16 精度的 OpenVINO™ IR 格式模型,如下图所示:

03

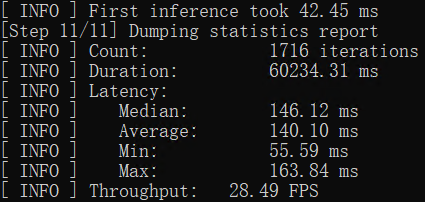

用 benchmark_app 测试

yolov8 目标检测模型的推理计算性能

benchmark_app 是 OpenVINO™ 工具套件自带的 AI 模型推理计算性能测试工具,可以指定在不同的计算设备上,在同步或异步模式下,测试出不带前后处理的纯 AI 模型推理计算性能。

使用命令:

benchmark_app -m yolov8n.xml -d GPU

获得 yolov8n.xml 模型在 AI 爱克斯开发板的集成显卡上的异步推理计算性能,如下图所示:

04

使用 OpenVINO™ Python API 编写

YOLOv8 目标检测模型推理程序

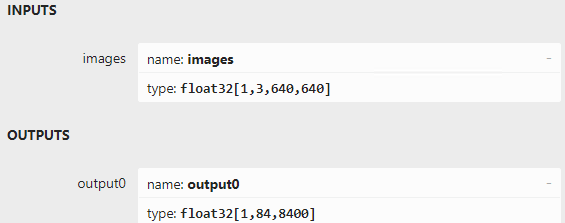

用 Netron 打开 yolov8n.onnx ,如下图所示,可以看到模型的输入是形状为[1,3,640,640]的张量,输出是形状为[1,84,8400]的张量,其中“84”的定义为:cx,cy,h,w和80种类别的分数。“8400”是指 YOLOv8 的3个检测头在图像尺寸为640时,有640/8=80, 640/16=40, 640/32=20, 80x80+40x40+20x20=8400个输出单元格。

基于 OpenVINO™ Python API 的 YOLOv8 目标检测模型的范例程序:

yolov8_od_ov_sync_infer_demo.py

其核心源代码如下所示:

# 实例化Core对象

core = Core()

# 载入并编译模型

net = core.compile_model(f'{MODEL_NAME}.xml', device_name="AUTO")

# 获得模型输出节点

output_node = net.outputs[0] # yolov8n只有一个输出节点

ir = net.create_infer_request()

cap = cv2.VideoCapture("store-aisle-detection.mp4")

while True:

start = time.time()

ret, frame = cap.read()

if not ret:

break

# 图像数据前处理

[height, width, _] = frame.shape

length = max((height, width))

image = np.zeros((length, length, 3), np.uint8)

image[0:height, 0:width] = frame

scale = length / 640

blob = cv2.dnn.blobFromImage(image, scalefactor=1 / 255, size=(640, 640), swapRB=True)

# 执行推理计算

outputs = ir.infer(blob)[output_node]

# 推理结果后处理并显示处理结果

outputs = np.array([cv2.transpose(outputs[0])])

... ...

cv2.imshow('YOLOv8 OpenVINO Infer Demo on AIxBoard', frame)向右滑动查看完整代码

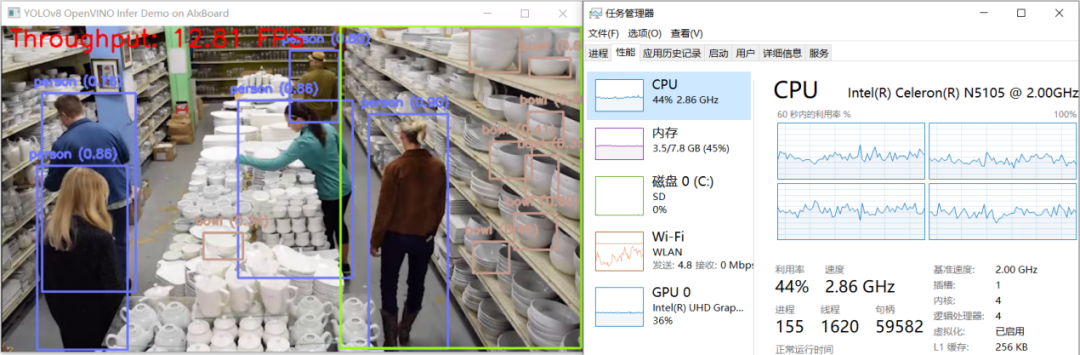

yolov8_od_ov_sync_infer_demo.py 运行结果,如下图所示:

05

结论

AI 爱克斯开发板借助 N5105 处理器的集成显卡(24个执行单元)和 OpenVINO™ ,可以在 YOLOv8 的目标检测模型上获得相当不错的性能。通过异步处理和 AsyncInferQueue ,还能进一步提升计算设备的利用率,提高 AI 推理程序的吞吐量。

下一篇将继续介绍在《在 AI 爱克斯开发板上用 OpenVINO™ 加速 YOLOv8-Seg 实例分割模型》。

--END--

你也许想了解(点击蓝字查看)⬇️➡️ 以AI作画,祝她节日快乐;简单三步,OpenVINO™ 助你轻松体验AIGC

➡️ 还不知道如何用OpenVINO™作画?点击了解教程。➡️ 如何给开源项目做贡献? | 开发者节日福利➡️ 几行代码轻松实现对于PaddleOCR的实时推理,快来get!➡️ 使用OpenVINO 在“端—边—云”快速实现高性能人工智能推理➡️ 图片提取文字很神奇?试试三步实现OCR!➡️【Notebook系列第六期】基于Pytorch预训练模型,实现语义分割任务➡️使用OpenVINO™ 预处理API进一步提升YOLOv5推理性能扫描下方二维码立即体验

OpenVINO™ 工具套件 2023.0点击 阅读原文 立即体验OpenVINO 2023.0

文章这么精彩,你有没有“在看”

807

807

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?