Abstract & Introduction & Related Work

- 研究任务

持续学习(lifelong learning) - 已有方法和相关工作

- LAMOL

- Component Freezing:虽然组件冻结也是微调过程中的一种常见做法,但它是为了防止模型低层的常识损失,相比之下,许多基于架构的LL方法,例如Rusu等人(2016),利用组件冻结来防止改变从以前的任务中学到的知识,并扩大模型以适应新的任务,从而使模型对遗忘免疫,我们的模型与基于架构的方法不同,只有一小部分模型被冻结,其大小在整个学习过程中是不变的

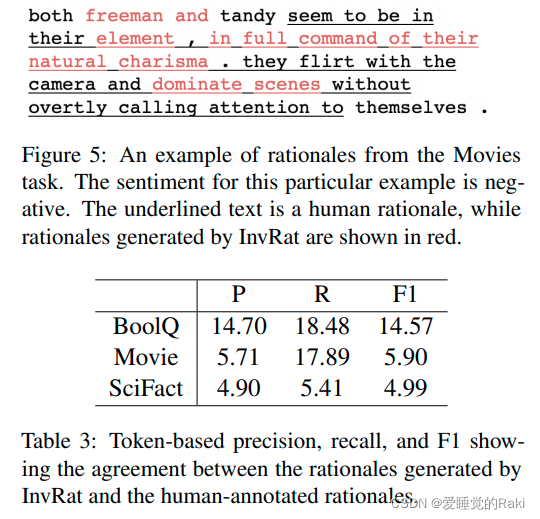

- Rationales:rationale是标签或预测的理由。在NLP中,它们通常是输入文本的一部分,支持或有助于类别标签。rationale可以由人类注释,也可以由机器学习模型生成。在多项研究中,人类的rationale已经被用来加强机器学习

- 面临挑战

- 创新思路

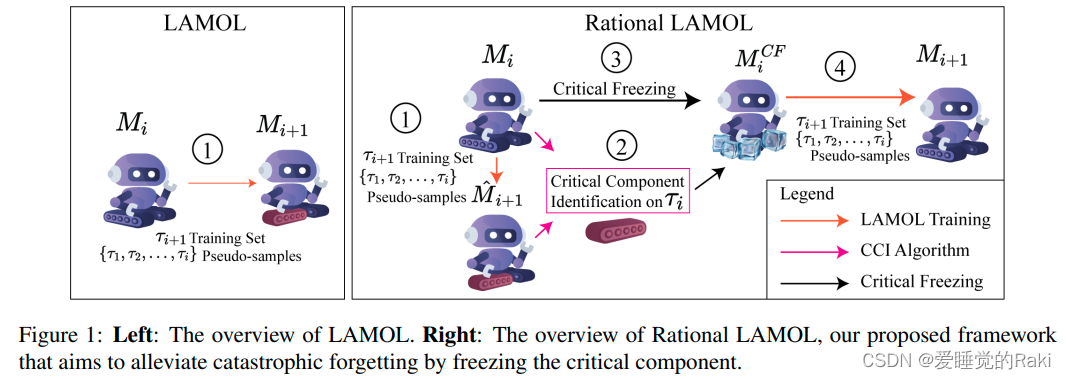

- 为了减轻灾难性遗忘,Rational LAMOL通过应用人类理性指导下的关键冻结,加强了LAMOL,这是一个最近的终生学习语言模型。当人类的理由不可用时,我们建议利用无监督的生成的rationales作为替代

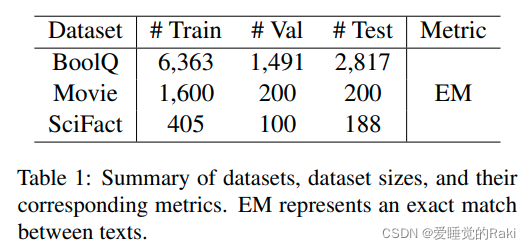

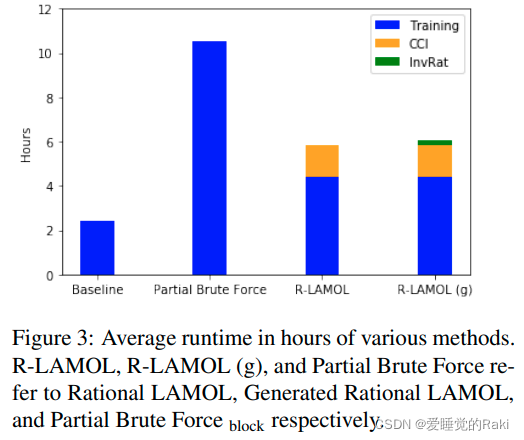

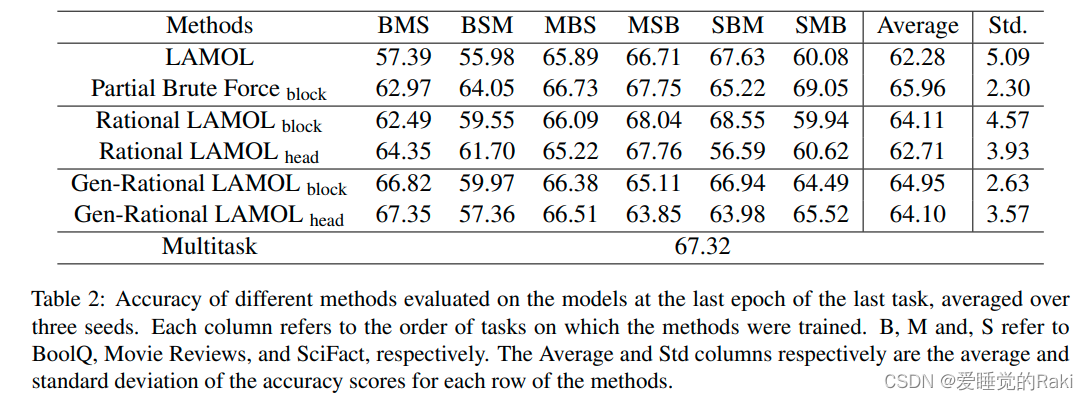

- 实验结论

- 我们证明了在基于transformer模型中冻结可塑性成分(即最容易发生变化的成分)的重要性,以便在LLL环境中加强对以前所学任务的记忆

- 我们提出了关键成分识别算法,该算法通过分析基于transformer的LLL模型的理由,从而找到最可塑的成分来进行冻结。这个步骤就是所谓的临界冻结,最早是在计算机视觉中设计的(Nguyen等人,2020),但我们将其应用到NLP领域

- 我们提出,InvRat(Chang等人,2020)的无监督生成的理由可以有效地作为人类理由的替代物,使我们的框架可以应用于通用的NLP数据集

Methodology

Rational LAMOL

迭代的进行四个步骤:

- 使用模型 M i M_i Mi 使用LAMOL的方式训练得到 M ^ i + 1 \hat{M}_{i+1} M^i+1

- 对 M i M_i Mi 和 M ^ i + 1 \hat{M}_{i+1} M^i+1 使用关键成分识别剖析最具塑性的层或块

- 使用关键冻结,冻结最具塑的成分

- 训练模型,得到

M

i

+

1

{M}_{i+1}

Mi+1

Critical Component Identification (CCI)

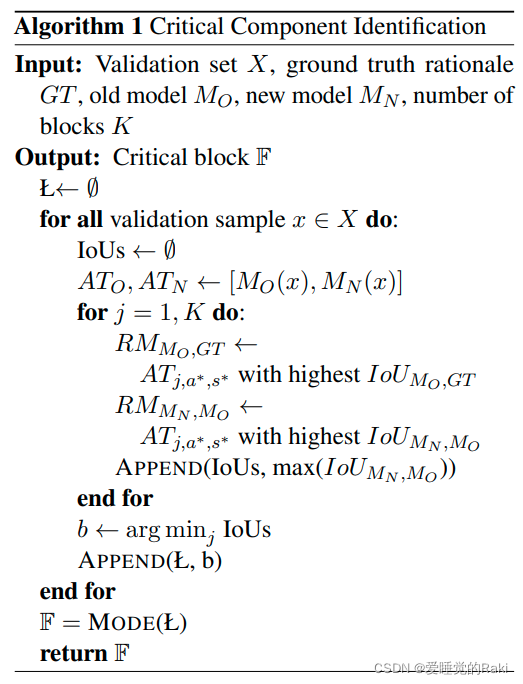

我们提出了关键成分识别(CCI)算法,在完全转向新的任务之前,指出我们基于transformer的LL模型中最可塑的模块

对于

t

a

s

k

i

task_{i}

taski 中的每一个

x

∈

X

x ∈ X

x∈X,CCI对比由

M

i

M_i

Mi 和

M

^

i

+

1

\hat{M}_{i+1}

M^i+1 生成的注意力映射来寻找关于这个样本最可塑的块b

然后,它返回所有b的模式的块 F \mathbb{F} F,该区块由X中的大多数样本投票选出。 注意,为了便于参考,大多数变量名称都保留了与Nguyen等人(2020)相似的名称,为了可读性,一些部分被重构

为了寻找一个样本x的块b,我们迭代所有的块并且进行两个步骤:

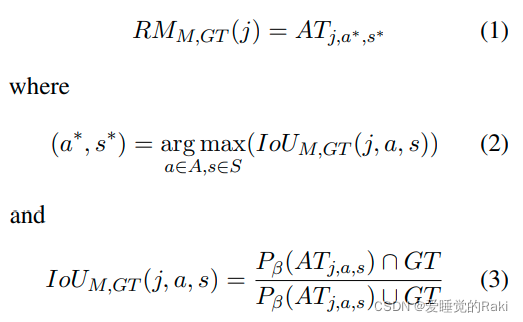

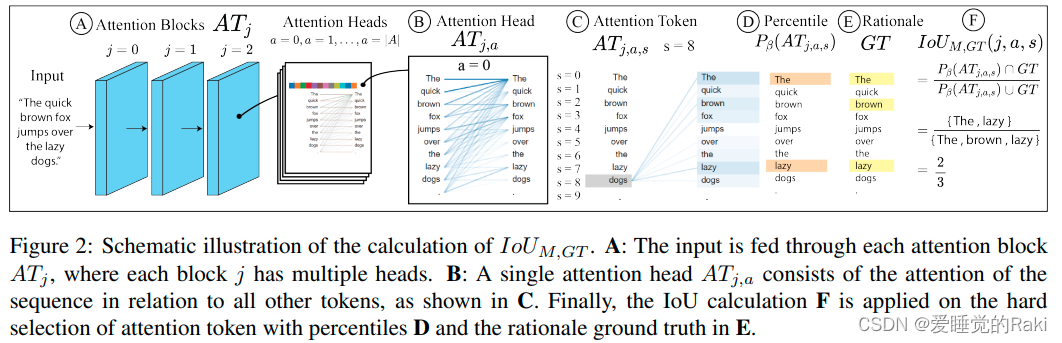

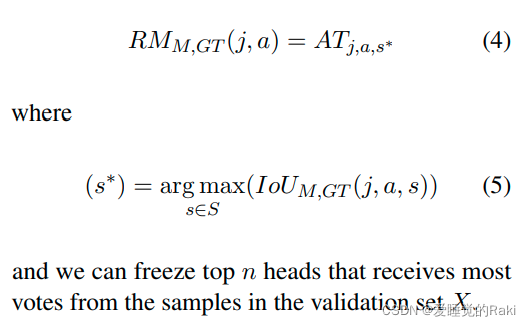

- 首先,我们找到 M O M_O MO 中 j 区块相对于真实数据GT的代表图(即 R M M O , G T ( j ) RM_{MO,GT} (j) RMMO,GT(j)),通过从j区块中选择与人类对样本x的理由最相似的注意头 a ∗ a^∗ a∗和标记 s ∗ s^∗ s∗ 的注意力映射

我们假设,自我注意机制的语义性质会选择与对预测至关重要的积极证据最相关的标记,类似于支持产出的理由片段。为了计算注意力图谱和人类理由之间的相似性,我们使用了交叉联合(IoU)。从形式上看,下面的方程式解释了这一步骤

A是区块中所有注意头的集合,S是x中所有标记的集合。

I

o

U

M

,

G

T

(

j

,

a

,

s

)

IoU_{M,GT}(j,a,s)

IoUM,GT(j,a,s)反映了真实数据和区块j、头a和x中标记s的注意图之间的相似性。由于真实数据包含二进制标签,表明一个标记是否是理由的一部分,我们需要使用

P

β

−

a

P_β -a

Pβ−a 将注意力图

A

T

j

,

a

,

s

AT_{j,a,s}

ATj,a,s转换为二进制标签–一个简单的二进制阈值,对于大于整个序列上的

β

−

t

h

β-th

β−th 百分位的值返回1=(否则,0)。这是需要的,因为IoU是用于比较两个二进制掩码的。图2直观地显示了如何通过钻研模型的每个组成部分来计算IoU的分数

- 到 M N M_N MN 中的区块j相对于 M O M_O MO 的代表图 在 M N M_N MN 中的区块j相对于 M O M_O MO 的代表性映射,这可以通过将方程1-3中的M和 G T GT GT 分别替换为 M N M_N MN 和 M O M_O MO ,并将方程3右侧的GT替换为 P β ( R M M O , G T ( j ) ) P_β(RM_{M_O,GT }(j)) Pβ(RMMO,GT(j))来实现。之后,我们收集块j的最大 I o U M N , M O IoU_{M_N ,M_O} IoUMN,MO,它代表了我们引入任务i+1后模型中持有的任务i的知识量。因此,这个样本x的最可塑区块b是具有最低最大 I o U M N , M O IoU_{M_N ,M_O} IoUMN,MO的块

实际上,transformer块并不是我们可以冻结的最细的颗粒度。因为每个区块都包含几个注意头,有可能单独冻结一些注意头。因此,我们提出另一种算法,适用于头。这与算法1相似,但该算法不是搜索具有最低最大IoU的区块,而是使用注意力区块和注意力头一起作为键进行搜索。虽然IoU的定义保持不变,但代表图的定义将是更高的粒度。形式上,对于一个区块索引j和注意力头a, R M M , G T RM_{M,GT} RMM,GT 将被计算为

Unsupervised Rationale Generation

如第3.2节所述,我们的框架需要理由作为输入。然而,大多数现有的NLP数据集都没有标明理由。

为了克服这一限制,我们利用最近的无监督理由生成框架InvRat(Chang等人,2020年)来生成作为替代的理由。最初,InvRat是为单输入任务设计的,如情感分析。然而,由于我们实验的一些数据集是文本对分类,我们在每个样本的末尾附加了查询(或问题)以适应这些任务

Results and Discussion

Conclusion

为了在NLP任务中有效地保留所学的知识,我们提出了Rational LAMOL,这是一个学习框架,在新任务的训练中使用理由来识别和冻结模型的最关键部分。我们表明,合理的LAMOL能够在很大程度上超过LAMOL的表现。此外,我们的框架可以通过利用无监督的理由生成来应用于任何NLP数据集,消除了对人类理由的需求,同时保持了可比的改进。总的来说,合理的LAMOL在NLP中的LL与模型理解之间架起了一座桥梁,展示了真正的终身语言学习的潜力,并限制了灾难性遗忘的发生

Remark

方法复杂,觉得不靠谱

1844

1844

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?