Transformer 与传统模型:Informer 如何改变时间序列预测的规则

Transformers 是那些聪明的注意力构建者,它们在机器学习的各个领域掀起了波澜。但在时间序列预测领域,它们才真正大显身手。你可能会问,为什么?想象一下,有一个水晶球,它不仅能看到未来,还能理解导致未来的复杂过去事件网络。这就是 Transformers 带来的好处。

秘诀:注意力机制

Transformers 成功的核心在于其巧妙的注意力机制。与那些努力跟踪长期依赖关系的前辈不同,Transformers 可以毫不费力地处理来自不同时间点的信息,让每条数据都得到应有的关注。

可以把它想象成一位指挥大师,指挥着数据点的交响乐。每个音符,无论时间有多远,都会影响最终的旋律。这种动态衡量不同时间步骤重要性的能力是 Transformers 在时间序列预测游戏中脱颖而出的原因。

打破顺序处理链

传统模型(如 RNN 和 LSTM)受到顺序性特征的束缚,只能像长途旅行中疲惫的旅人一样一步步处理数据。而 Transformer 则更像是传送器,可以轻松地在不同时间点之间穿梭。

这种并行处理能力不仅加快了训练和推理速度,还使 Transformers 能够捕捉数据中复杂的非线性关系。这就像鸟瞰整个时间景观,发现地面观察者可能错过的模式和联系。

拓展新高度:处理长序列

时间序列预测的最大挑战之一是处理长序列。这就像试图根据几个世纪的历史数据预测明年的天气一样——至少可以说是势不可挡。但 Transformers 正在迎难而上。

借助稀疏注意力和高效内存使用等巧妙技巧,Transformers 可以处理传统模型无法处理的序列。这种处理大量历史数据的能力为长期预测和趋势分析开辟了新的可能性。

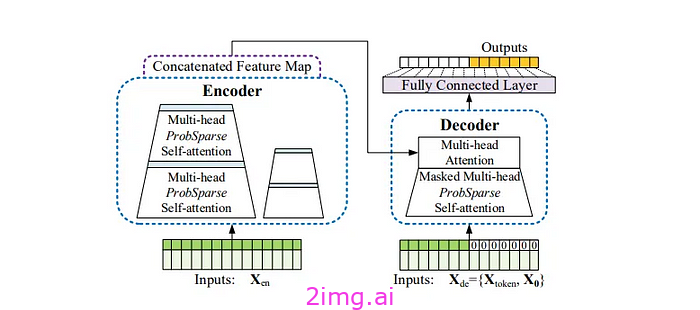

告密者:Transformer 领域的游戏规则改变者

现在,让我们来看一下 Transformer 家族中的一位真正的超级明星:Informer。这一创新模型正在引起人们的关注,并改写了时间序列预测的规则。想象一下,一位侦探能够从大量证据中筛选出关键线索,并以激光般的精度挑选出关键线索——这就是 Informer。

破解长序列密码

Informer 解决了时间序列预测中最棘手的问题之一:处理长序列时标准 Transformers 的二次计算和内存要求。这就像找到一种方法将

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

4010

4010

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?