前言

本文将介绍神经成像领域元分析的发展历程,探讨:

- SDM算法克服了哪些统计错误?

- 比起其他的元分析方法,可以更多的回答哪些问题?

- 其背后体现对脑功能本质理解的何种哲学?

然后介绍基于SDM软件包,进行resting-fMRI 元分析的步骤。

基于种子点差异映射(Seed-based d maping)是神经成像元分析的一种统计技术,从2009年开始在这15年的时间内被广泛用于研究大脑功能和结构的差异。有研究者形容它为:“帮助我们看见树木背后的森林。”其统计模型关注每项研究的效应量(effect size)和样本量,而不仅仅只是激活坐标,所以可以同时处理正负效应。国内外有研究用不同的元分析算法和基于图的金标准进行比较,发现SDM算法表现最优。

笔者在接触脑成像元分析一年的过程中,尝试了不同的算法,最终也选择用SDM算法来完成自己的研究,谨以此文记录学习的思考。

空间 VS 效应

元分析作为一个量化多项文献研究,为该研究问题下总体性结论的研究方法,自问世以来一直是循证医学金字塔顶端。

21世纪初,随着神经成像技术的发展和影像证据的积累,人类也迫切需要在神经影像界开展系统性审查,综合多中心的研究结果,在总体上回答某自变量对大脑的影响是否存在?到底存在在哪?

2002年,激活概率估计法(ALE ,Activation Likelihood Estimation)被提出。ALE算法建立的假设是:每个体素被报告的可能性是以激活峰值点(Foci)为中心, 呈 3D 高斯分布。距离报告峰值点越近,其被报告的概率越高。按照这一假设,为每项研究绘制出模型激活图(MA,modeled activation map),MA图的每个体素点数值为这项研究中该体素被报告的可能性。再将所有纳入的研究的MA图整合在一起,与零假设进行假设检验,找到横跨多项研究中能够被稳定报告的体素点坐标。

“基于体素的元分析本质上就是为每一个体素计算它有多少次足够靠近被报告的峰值点?它被报告的概率是否高于偶然?”SDM算法的开发者Joaquim Radua说。回到21世纪初, ALE算法的确回答了“在总体上某自变量对大脑的影响存在在哪?”这一问题。

但随着我们深入追问,会发现某些因素(比如疾病或特定任务)对大脑产生的影响不是简单的Where,还涉及效应的估计How?比如是让皮层厚度增加还是减少,比如是让前额叶激活还是抑制?传统的ALE模型在数据输入上仅有峰值点坐标,没有统计量,所以它在回答“某自变量对大脑的影响是正向还是负向?”上显得乏力。

2008年,ALE的算法在六年期间来也在不断优化统计模型。其在尝试回答“某自变量对大脑的影响是正向还是负向?”这一问题上也进行了一定探索,虽然本身的模型里没有输入统计量参数,但如果我们将Z值为正的研究放积极组,Z值为负的研究放消极组,分成两组分别计算不就可以知道各自的影响了吗?比如2008年剑桥大学发表在《神经科学与生物行为学评论》上的文章就采用ALE算法和这一分组思路对强迫症患者激活异常进行了研究。

但这样天真的分组也会带来有趣的结果,比如下图某些体素错误的被报告为激活增多又被报告为激活减少,因为它在两组的检验中都显著。

ALE算法在回答“某自变量对大脑的影响是正向还是负向?”上遇挫,更难以去回答“某自变量对大脑的影响程度有多大?”这类随着人类神经科学研究深入而迫切需要讨论的问题。

又一年后,2009年,SDM算法携带着今天早已已经大名鼎鼎的SDM软件包第一代版本正式在英国精神病学杂志上刊登的《强迫症灰质变化的体素元分析》文章里出世。

/减少报告坐标点映射

其正是在ALE算法与多级核密度分析(MKDA,multilevel kernel density analysis)算法的基础上改进而来。其模型需要输入坐标点,样本量和统计量,正负值的报告都会在一张模型脑图上被重建,从而不仅回答了灰质体积/大脑激活在哪一脑区变化,还回答了灰质体积/大脑激活是增加还是减少?

- ALE算法主要关注空间一致性,它背后的哲学是找出该领域研究下跨研究中报告的脑区的一致性。

- 而SDM算法试图平衡空间信息和效应信息,认为大脑活动不仅有“Where”在哪里的问题,还有“How”多强的问题。

从ALE算法到SDM算法的不断发展,体现的是脑成像的缩影,体现的是人类从关注变量与大脑空间关系的对应到引入影响强度等因素得到更全面图景的探索。

预处理(Processing)

因为本文关注算法,省略了文献检索与数据抓取环节。如有问题可参考SDM官方教程,或评论留言。

一、哲学:为每项研究重建效应量脑图

因为大部分MRI研究都是报告研究结果中显著的脑区的峰值坐标点和其统计量。这些坐标点是离散的数据,我们没办法在全脑范围进行分析,从而与其他研究进行整合分析。所以我们要将这些报告出来的坐标点还原在一张空白的大脑脑图上,将离散点坐标点转化成覆盖全脑的连续图像。

为每个体素还原效应量的原理:就是基于其离峰值的距离和效应量的大小。

- 体素离峰值越近,效应量越大;离峰值越远,效应量越小;

- 报告点效应量大,其为附近体素分配的效应量越大;报告点效应量小,其为附近体素分配的效应量越小。

一、方法:SDM预处理自动化流程

准备好每项研究的数据后,即可开始预处理,选择数据的模态,应用的模版,各项异性系数,平滑核,掩模和体素大小后SDM软件既会自动开始处理。

首先它将统计值(t)转化成标准化后的效应量Hedges'g。然后它将所有从坐标点都转化成标准MNI空间。再为每一项研究创造效应量脑图。最后还会应用标准脑掩模,确保分析仅限于关注脑区。

等到软件计算完就可以在工作路径下找到pp文件夹,里面储存了预处理结果,包含pp.htm文件和每项研究生产的四张全脑图。最重要的是通过pp.htm文件检查预处理的摘要。

分别是效应量置信区间上限,效应量置信区间下限;t值置信区间上限,t值置信区间下限。(如果研究样本越大,置信区间范围越小。)

主效应计算(Mean)

二、哲学:整合各项研究的脑图

在预处理的过程中,我们已经将所有的研究都还原到相同的脑空间里,并且为其创造了效应量脑图。现在我们该如何将来自不同研究的脑图合并在一起,得到总体的脑图呢?

传统的ALE每张MA脑图像体素值的取值范围[0,1],指被报告的概率。其合并不同MA图像的原理就是为每个体素进行联合概率计算,使用极值过程理论来还原每个体素被真实报告的可能性。传统元分析合并不同研究的原理有很好的可解释性,但同样涉及一些问题,如某一体素在一项研究中距离两个报告峰值点都很接近,其概率如果叠加这会出现p值超过1的错误。

SDM的每个体素值并不是概率,而是标准化后的效应量, 主要的统计分析是均值分析,包括计算 不同研究中体素值的平均值,然后为不同研究中体素的均值进行加权平均。

为什么要进行加权平均呢?原因很简单,因为不同的研究应该有不同的权重。研究A中的患者数量是研究B中患者数量的4倍,很显然我们应该给研究A更高的权重。但是,如果仅仅通过样本量来对研究权重进行加权又过于简单,如果研究B虽然纳入的患者少,但是估计似乎更精确,因为其样本方差更小(均一度更高)。

具体来说SDM均值的加权公式通过差值的方差的倒数进行加权- -也包括样本容量,从而解释了研究间的异质性。然后计算每个体素的Z分数和p值。比起传统方法,SDM的模型算法更加复杂,更能捕捉研究间的差异和特殊性。其保留了效应量大小,还将异质性分析作为标准流程的一部分(统计量,

,τ²等),从而能更好识别差异,联合不同研究。

二、方法:SDM主效应计算

进行完预处理后选中Mean选项,选择预处理文件夹,过滤研究,协变量和使用CPU既会进行自动化计算。

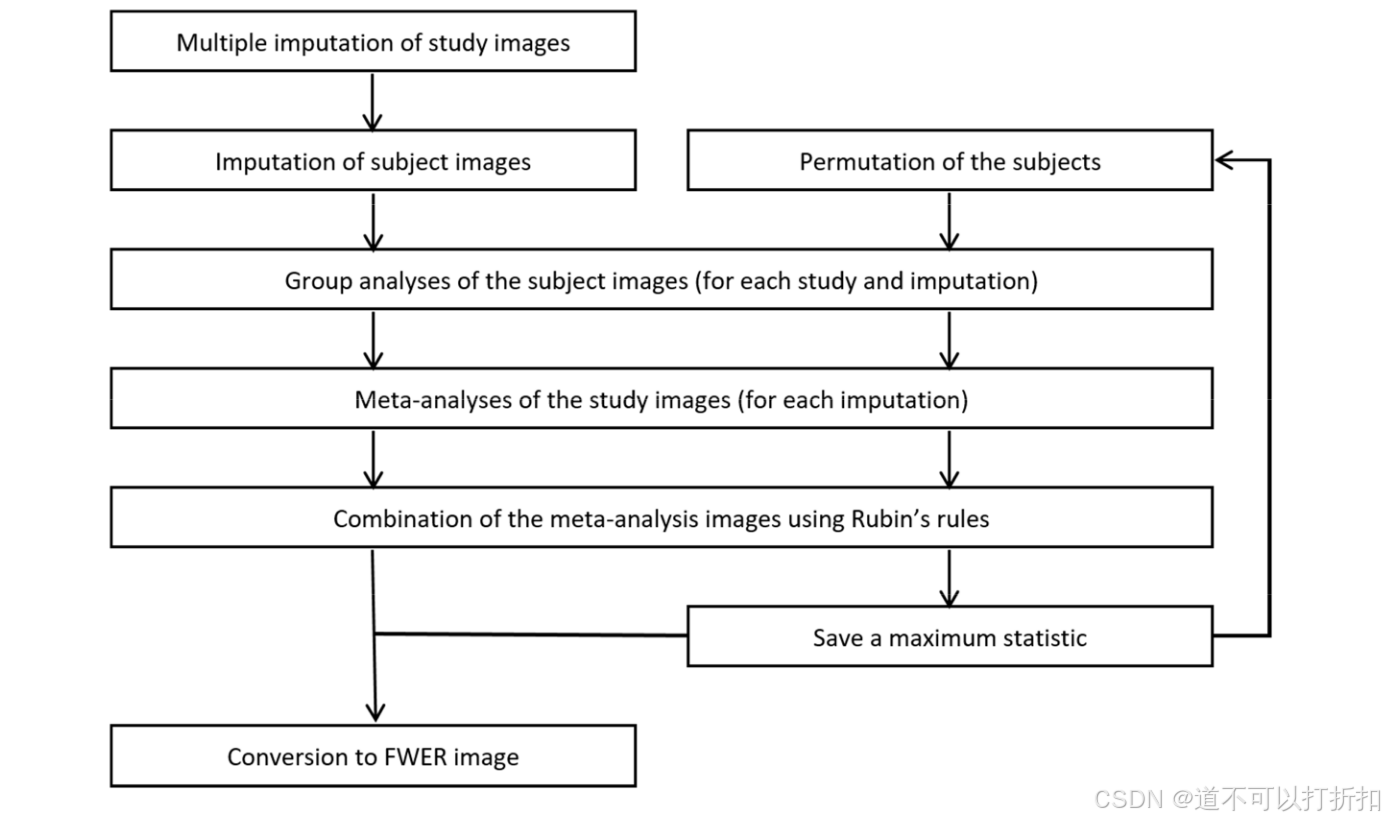

SDM主分析涉及的五个步骤分别为:

- MLE coefficients(MLE系数):用最大似然估计法得到总体效应大小的估计值,表示变量之间关系的强度和方向。表面某一脑区激活的平均强度。

- MLE heterogeneity(MLE异质性):用最大似然估计方法得到的研究间方差,表示研究间效应大小的不一致性,输出不同的异质性参数。

- Multiple imputation:多元差补,填补缺失值。

- Meta-analysis:实质的元分析计算,整合不同研究。

- Rubin's rules:鲁宾法则,处理缺失数据问题,同时保持统计推断的准确性。

在进行了漫长的计算后就会在工作路径输出这几个图,其含义如上图标注。SDM自动化的为我们计算出"uncorrp.nii",让我们在下一步根据自己需要选择合适的阈限和统计检验方式找到显著性的体素与脑区。

总结

本文回溯了给予坐标点的脑科学元分析发展历程,探讨了SDM算法从ALE和MKDA算法中改进发展的过程,其体现的是对脑功能和变量对应关系的本质理解不局限于空间位置的思想。然后介绍了基于SDM软件的操作流程,以及每个步骤具体含义的讲解。在拥有了总体的Z值图后,就可以自己选择阈限和进行多重比较校正,以及在之后进行亚组分析,敏感性分析,元回归分析等。

PS(参考部分总结了SDM算法笔者搜罗到的所有参考资料)

参考

1.官方网站与下载地址:

2.SDM算法第一篇文章,总结强迫症患者灰质体积变化。

Radua, Joaquim, 和David Mataix-Cols. 《Voxel-Wise Meta-Analysis of Grey Matter Changes in Obsessive–Compulsive Disorder》. British Journal of Psychiatry 195, 期 5 (2009年11月): 393–402. https://doi.org/10.1192/bjp.bp.108.055046.

3.SDM算法用作比较分析的第一篇文章,比较强迫症患者和其他焦虑障碍灰质体积变化。

Radua, Joaquim, Odile A. Van Den Heuvel, Simon Surguladze和David Mataix-Cols. 《Meta-Analytical Comparison of Voxel-Based Morphometry Studies in Obsessive-Compulsive Disorder vs Other Anxiety Disorders》. Archives of General Psychiatry 67, 期 7 (2010年7月1日): 701–11. https://doi.org/10.1001/archgenpsychiatry.2010.70.

4.Effect Size-SDM算法更新:引入效应量。

Radua, J., D. Mataix-Cols, M.L. Phillips, W. El-Hage, D.M. Kronhaus, N. Cardoner和S. Surguladze. 《A New Meta-Analytic Method for Neuroimaging Studies That Combines Reported Peak Coordinates and Statistical Parametric Maps》. European Psychiatry 27, 期 8 (2012年11月): 605–11. https://doi.org/10.1016/j.eurpsy.2011.04.001.

5.SDM的综述,介绍了神经成像标准化元分析流程,加权的方法,研究间的异质性,补充的分析

Radua, Joaquim, 和David Mataix-Cols. 《Meta-Analytic Methods for Neuroimaging Data Explained》. Biology of Mood & Anxiety Disorders 2, 期 1 (2012年12月): 6. Meta-analytic methods for neuroimaging data explained | Biology of Mood & Anxiety Disorders | Full Text

6.介绍了如何进行元回归(meta-regression)

Bora, Emre, Alex Fornito, Joaquim Radua, Mark Walterfang, Marc Seal, Stephen J. Wood, Murat Yücel, Dennis Velakoulis和Christos Pantelis. 《Neuroanatomical abnormalities in schizophrenia: A multimodal voxelwise meta-analysis and meta-regression analysis》. Schizophrenia Research 127, 期 1 (2011年4月1日): 46–57. https://doi.org/10.1016/j.schres.2010.12.020.

7.SDM版本更新为各向异性(Anisotropic)

Radua, Joaquim, Katya Rubia, Erick Jorge Canales-Rodríguez, Edith Pomarol-Clotet, Paolo Fusar-Poli和David Mataix-Cols. 《Anisotropic Kernels for Coordinate-Based Meta-Analyses of Neuroimaging Studies》. Frontiers in Psychiatry 5 (2014年). Frontiers | Anisotropic Kernels for Coordinate-Based Meta-Analyses of Neuroimaging Studies.

8.介绍了多模态联合分析(Conjunction)

Carlisi, Christina O., Luke J. Norman, Steve S. Lukito, Joaquim Radua, David Mataix-Cols和Katya Rubia. 《Comparative Multimodal Meta-Analysis of Structural and Functional Brain Abnormalities in Autism Spectrum Disorder and Obsessive-Compulsive Disorder》. Biological Psychiatry 82, 期 2 (2017年7月): 83–102. https://doi.org/10.1016/j.biopsych.2016.10.006.

9.解释了元分析中体素的显著性和组间比较体素的显著性的差异

Albajes-Eizagirre, Anton, 和Joaquim Radua. 《What Do Results from Coordinate-Based Meta-Analyses Tell Us?》 NeuroImage 176 (2018年8月): 550–53. Redirecting.

10.对PSI更新的解释

Albajes-Eizagirre, Anton, Aleix Solanes, Eduard Vieta和Joaquim Radua. 《Voxel-Based Meta-Analysis via Permutation of Subject Images (PSI): Theory and Implementation for SDM》. NeuroImage 186 (2019年2月): 174–84. Redirecting.

311

311

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?