一、介绍

ChatGLM3 是智谱 AI 和清华大学 KEG 实验室联合发布的对话预训练模型。ChatGLM3-6B 是 ChatGLM3 系列中的开源模型,在保留了前两代模型对话流畅、部署门槛低等众多优秀特性的基础上,ChatGLM3-6B 引入了如下特性:

- 更强大的基础模型: ChatGLM3-6B 的基础模型 ChatGLM3-6B-Base 采用了更多样的训练数据、更充分的训练步数和更合理的训练策略。在语义、数学、推理、代码、知识等不同角度的数据集上测评显示,ChatGLM3-6B-Base 具有在 10B 以下的基础模型中最强的性能。

- 更完整的功能支持: ChatGLM3-6B 采用了全新设计的 Prompt 格式 ,除正常的多轮对话外。同时原生支持工具调用(Function Call)、代码执行(Code Interpreter)和 Agent 任务等复杂场景。

- 更全面的开源序列: 除了对话模型 ChatGLM3-6B 外,还开源了基础模型 ChatGLM3-6B-Base 、长文本对话模型 ChatGLM3-6B-32K 和进一步强化了对于长文本理解能力的 ChatGLM3-6B-128K。以上所有权重对学术研究完全开放 ,在填写 问卷 进行登记后 亦允许免费商业使用 。

二、 部署过程

基础环境最低要求说明:

| 环境名称 | 版本信息1 | 版本信息2 |

|---|---|---|

| Ubuntu | 22.04.4 LTS | |

| Cuda | V12.1.105 | |

| Python | 3.10.8 | 3.12.4 |

| NVIDIA Corporation | RTX 3060 *2 | RTX 3090 |

1. 更新基础软件包

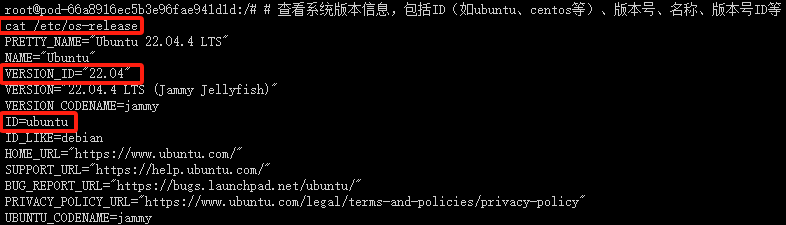

查看系统版本信息

# 查看系统版本信息,包括ID(如ubuntu、centos等)、版本号、名称、版本号ID等

cat /etc/os-release

配置 apt 国内源

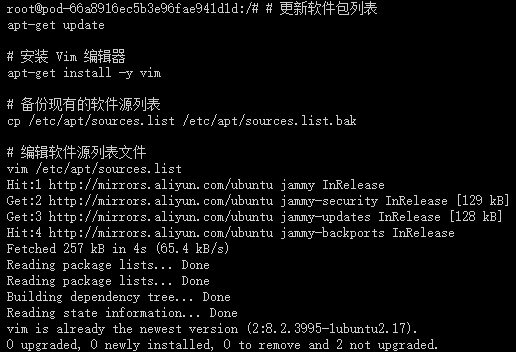

# 更新软件包列表

apt-get update

这个命令用于更新本地软件包索引。它会从所有配置的源中检索最新的软件包列表信息,但不会安装或升级任何软件包。这是安装新软件包或进行软件包升级之前的推荐步骤,因为它确保了您获取的是最新版本的软件包。

# 安装 Vim 编辑器

apt-get install -y vim

这个命令用于安装 Vim 文本编辑器。-y 选项表示自动回答所有的提示为“是”,这样在安装过程中就不需要手动确认。Vim 是一个非常强大的文本编辑器,广泛用于编程和配置文件的编辑。

为了安全起见,先备份当前的 sources.list 文件之后,再进行修改:

# 备份现有的软件源列表

cp /etc/apt/sources.list /etc/apt/sources.list.bak

这个命令将当前的 sources.list 文件复制为一个名为 sources.list.bak 的备份文件。因为编辑 sources.list 文件时可能会出错,导致无法安装或更新软件包,有了备份,如果出现问题,您可以轻松地恢复原始的文件。

# 编辑软件源列表文件

vim /etc/apt/sources.list

这个命令使用 Vim 编辑器打开 sources.list 文件,以便您可以编辑它。这个文件包含了 APT(Advanced Package Tool)用于安装和更新软件包的软件源列表。通过编辑这个文件,您可以添加新的软件源、更改现有软件源的优先级或禁用某些软件源。

在 Vim 中,您可以使用方向键来移动光标,i 键进入插入模式(可以开始编辑文本),Esc 键退出插入模式,:wq 命令保存更改并退出 Vim,或 :q! 命令不保存更改并退出 Vim。

编辑 sources.list 文件时,请确保您了解自己在做什么,特别是如果您正在添加新的软件源,因为错误的源可能会导致软件包安装失败或系统安全问题。如果您不确定,最好先搜索并找到可靠的源信息,或者咨询有经验的 Linux 用户。

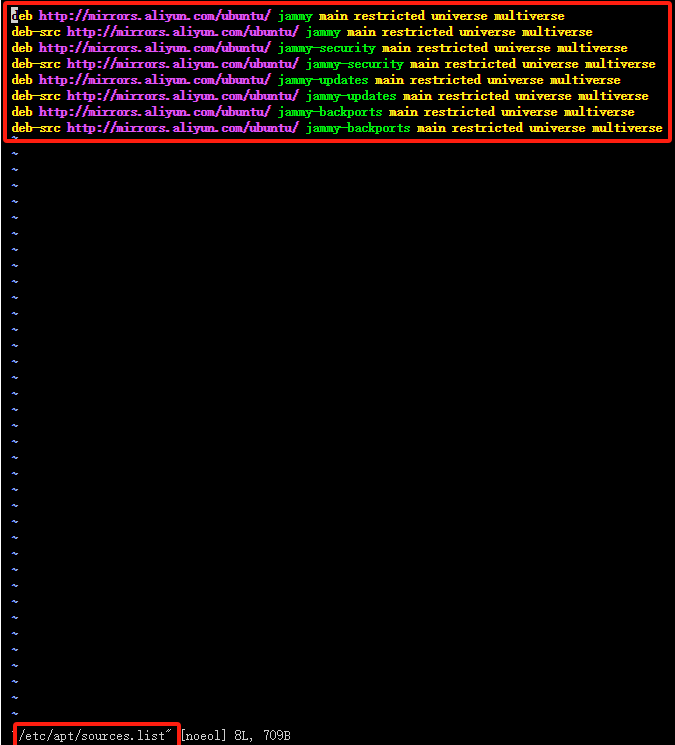

使用 Vim 编辑器打开 sources.list 文件,复制以下代码替换 sources.list里面的全部代码,配置 apt 国内阿里源。

deb http://mirrors.aliyun.com/ubuntu/ jammy main restricted universe multiverse

deb-src http://mirrors.aliyun.com/ubuntu/ jammy main restricted universe multiverse

deb http://mirrors.aliyun.com/ubuntu/ jammy-security main restricted universe multiverse

deb-src http://mirrors.aliyun.com/ubuntu/ jammy-security main restricted universe multiverse

deb http://mirrors.aliyun.com/ubuntu/ jammy-updates main restricted universe multiverse

deb-src http://mirrors.aliyun.com/ubuntu/ jammy-updates main restricted universe multiverse

deb http://mirrors.aliyun.com/ubuntu/ jammy-backports main restricted universe multiverse

deb-src http://mirrors.aliyun.com/ubuntu/ jammy-backports main restricted universe multiverse

安装常用软件和工具

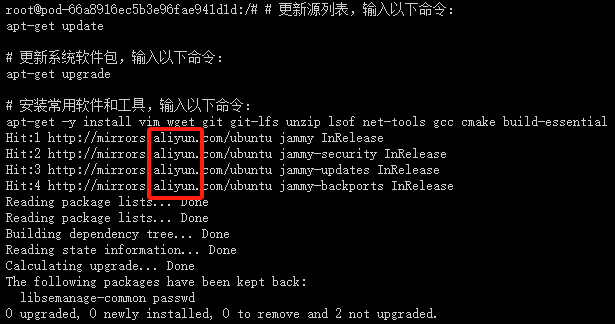

# 更新源列表,输入以下命令:

apt-get update

# 更新系统软件包,输入以下命令:

apt-get upgrade

# 安装常用软件和工具,输入以下命令:

apt-get -y install vim wget git git-lfs unzip lsof net-tools gcc cmake build-essential

出现以下页面,说明国内apt源已替换成功,并且能够正常安装apt软件和工具

2. 安装 NVIDIA CUDA Toolkit 12.1

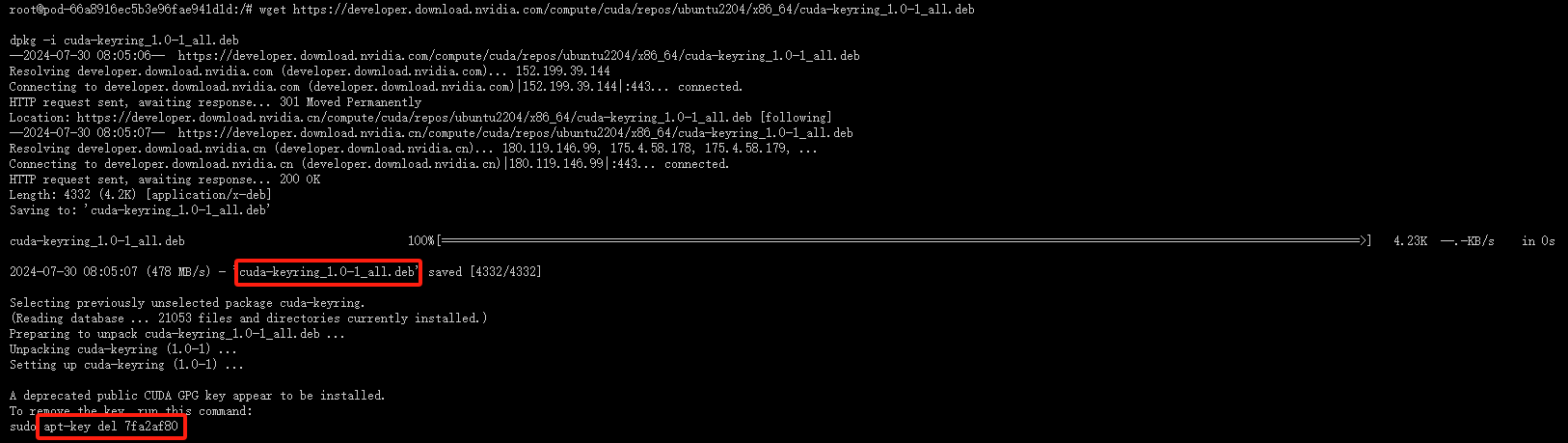

- 下载 CUDA Keyring :

wget https://developer.download.nvidia.com/compute/cuda/repos/ubuntu2204/x86_64/cuda-keyring_1.0-1_all.deb

这个命令用于下载 CUDA 的 GPG 密钥环,它用于验证 CUDA 软件包的签名。这是确保软件包安全性的一个重要步骤。

- 安装 CUDA Keyring :

dpkg -i cuda-keyring_1.0-1_all.deb

使用 dpkg 安装下载的密钥环。这一步是必需的,以便 apt 能够验证从 NVIDIA 仓库下载的软件包的签名。

- 删除旧的 apt 密钥(如果必要) :

apt-key del 7fa2af80

这一步可能不是必需的,除非您知道 7fa2af80 是与 CUDA 相关的旧密钥,并且您想从系统中删除它避免混淆。通常情况下,如果您只是安装 CUDA 并使用 NVIDIA 提供的最新密钥环,这一步可以跳过。

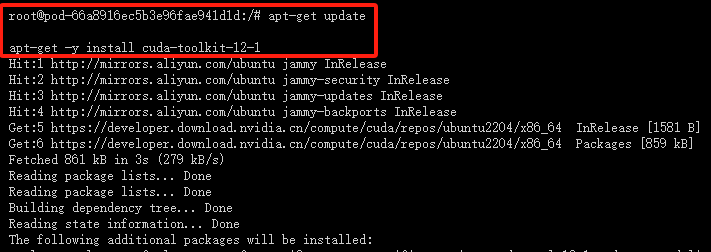

- 更新 apt 包列表 :

apt-get update

更新 apt 的软件包列表,以便包括刚刚通过 cuda-keyring 添加的 NVIDIA 仓库中的软件包。

- 安装 CUDA Toolkit :

apt-get -y install cuda-toolkit-12-1

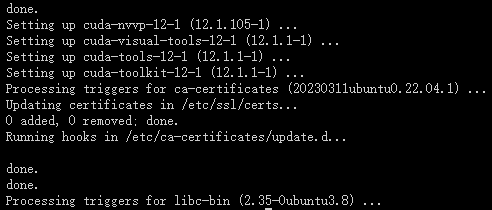

出现以下页面,说明 NVIDIA CUDA Toolkit 12.1 安装成功

注意:这里可能有一个问题。NVIDIA 官方 Ubuntu 仓库中可能不包含直接名为 cuda-toolkit-12-1 的包。通常,您会安装一个名为 cuda 或 cuda-12-1 的元包,它会作为依赖项拉入 CUDA Toolkit 的所有组件。请检查 NVIDIA 的官方文档或仓库,以确认正确的包名。

如果您正在寻找安装特定版本的 CUDA Toolkit,您可能需要安装类似 cuda-12-1 的包(如果可用),或者从 NVIDIA 的官方网站下载 CUDA Toolkit 的 .run 安装程序进行手动安装。

请确保您已查看 NVIDIA 的官方文档或 Ubuntu 的 NVIDIA CUDA 仓库以获取最准确的包名和安装指令。

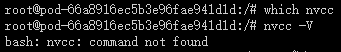

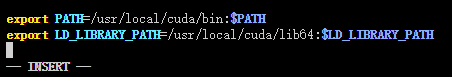

- 出现以上情况,需要配置 NVIDIA CUDA Toolkit 12.1 系统环境变量

编辑 ~/.bashrc 文件

# 编辑 ~/.bashrc 文件

vim ~/.bashrc

插入以下环境变量

# 插入以下环境变量

export PATH=/usr/local/cuda/bin:$PATH

export LD_LIBRARY_PATH=/usr/local/cuda/lib64:$LD_LIBRARY_PATH

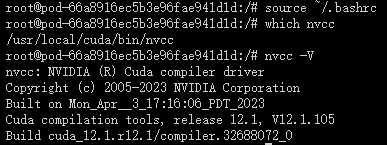

激活 ~/.bashrc 文件

# 激活 ~/.bashrc 文件

source ~/.bashrc

查看cuda系统环境变量

which nvcc

nvcc -V

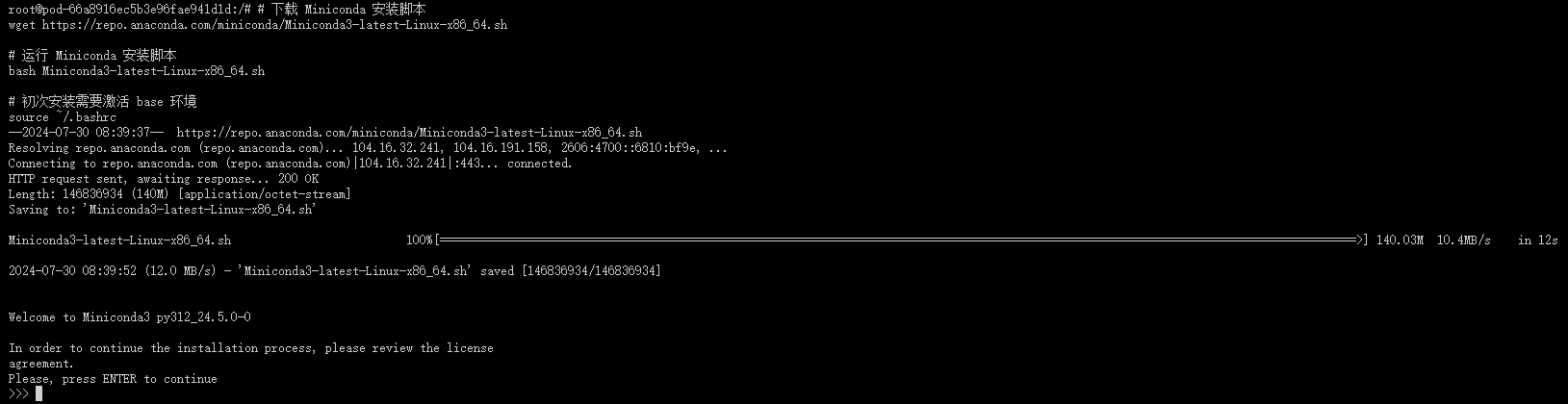

3. 安装 Miniconda

- 下载 Miniconda 安装脚本 :

- 使用

wget命令从 Anaconda 的官方仓库下载 Miniconda 的安装脚本。Miniconda 是一个更小的 Anaconda 发行版,包含了 Anaconda 的核心组件,用于安装和管理 Python 包。

- 使用

- 运行 Miniconda 安装脚本 :

- 使用

bash命令运行下载的 Miniconda 安装脚本。这将启动 Miniconda 的安装过程。

- 使用

# 下载 Miniconda 安装脚本

wget https://repo.anaconda.com/miniconda/Miniconda3-latest-Linux-x86_64.sh

# 运行 Miniconda 安装脚本

bash Miniconda3-latest-Linux-x86_64.sh

# 初次安装需要激活 base 环境

source ~/.bashrc

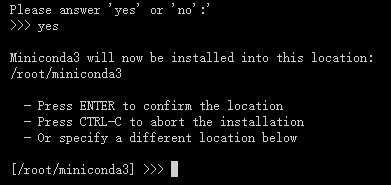

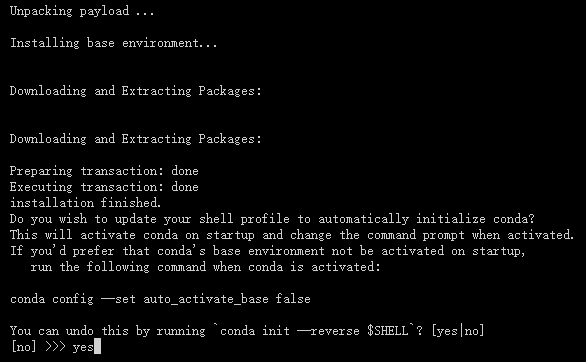

按下回车键(enter)

输入yes

输入yes

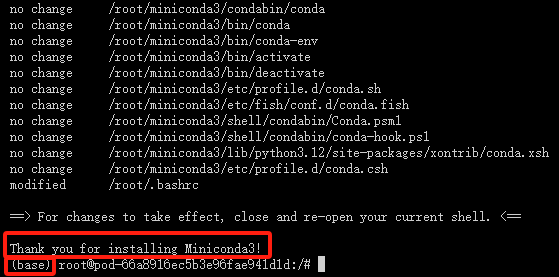

安装成功如下图所示

pip配置清华源加速

# 编辑 /etc/pip.conf 文件

vim /etc/pip.conf

加入以下代码

[global]

index-url = https://pypi.tuna.tsinghua.edu.cn/simple

注意事项:

- 请确保您的系统是 Linux x86_64 架构,因为下载的 Miniconda 版本是为该架构设计的。

- 在运行安装脚本之前,您可能需要使用

chmod +x Miniconda3-latest-Linux-x86_64.sh命令给予脚本执行权限。 - 安装过程中,您将被提示是否同意许可协议,以及是否将 Miniconda 初始化。通常选择 "yes" 以完成安装和初始化。

- 安装完成后,您可以使用

conda命令来管理 Python 环境和包。 - 如果链接无法访问或解析失败,可能是因为网络问题或链接本身的问题。请检查网络连接,并确保链接是最新和有效的。如果问题依旧,请访问 Anaconda 的官方网站获取最新的下载链接。

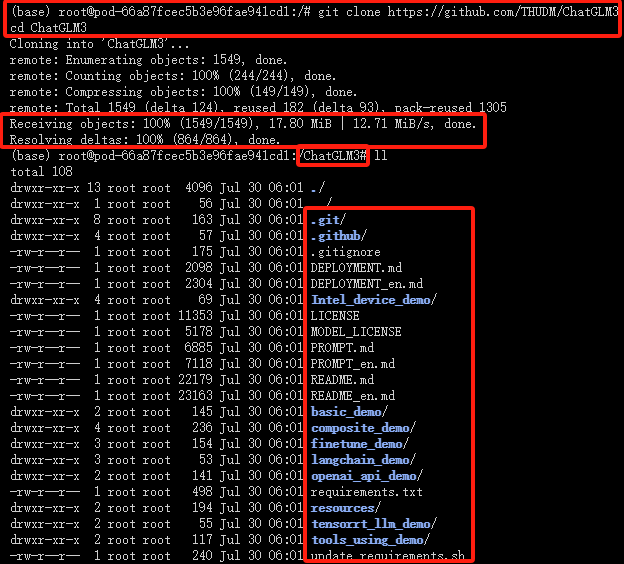

4. 从 github 仓库克隆项目

- 克隆存储库:

- git clone https://github.com/THUDM/ChatGLM3

- 这个命令使用

git clone从指定的 GitHub 地址克隆 "ChatGLM3" 项目,默认情况下 Git 会克隆整个项目的所有提交历史。

- 切换目录:

- cd ChatGLM3

- 这个命令使用

cd(change directory)命令切换当前工作目录到刚才克隆的 "ChatGLM3" 目录中。这意味着接下来执行的所有命令都是在该项目目录下执行。

# 克隆 ChatGLM3 项目

git clone https://github.com/THUDM/ChatGLM3

# 切换到克隆的项目目录中

cd ChatGLM3

出现以上页面即是克隆项目成功!

请注意,如果 git clone https://github.com/THUDM/ChatGLM3 这个链接不存在或者无效,git clone 命令将不会成功克隆项目,并且会报错。确保链接是有效的,并且您有足够的权限访问该存储库。

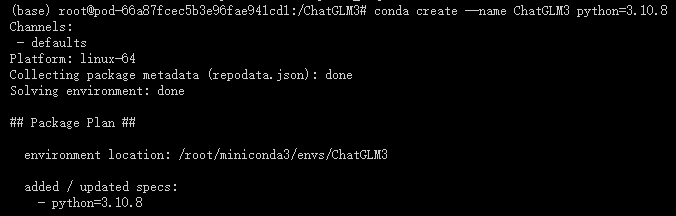

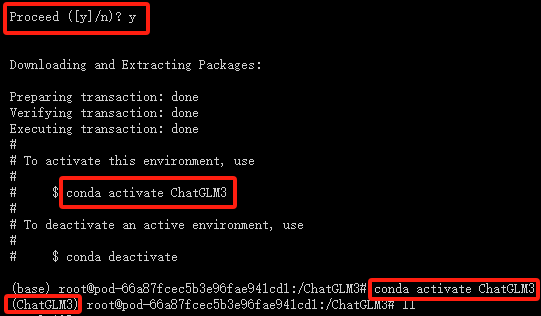

5. 创建虚拟环境

# 创建一个名为 ChatGLM3 的新虚拟环境,并指定 Python 版本为 3.10.8

conda create --name ChatGLM3 python=3.10.8

# 激活新创建的虚拟环境

conda activate ChatGLM3

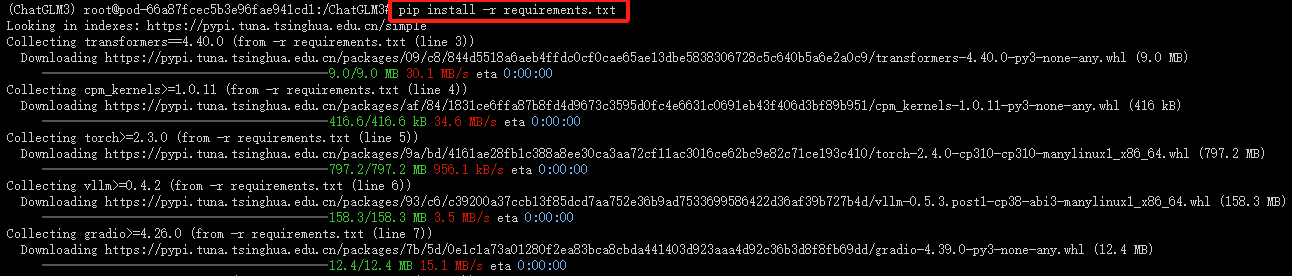

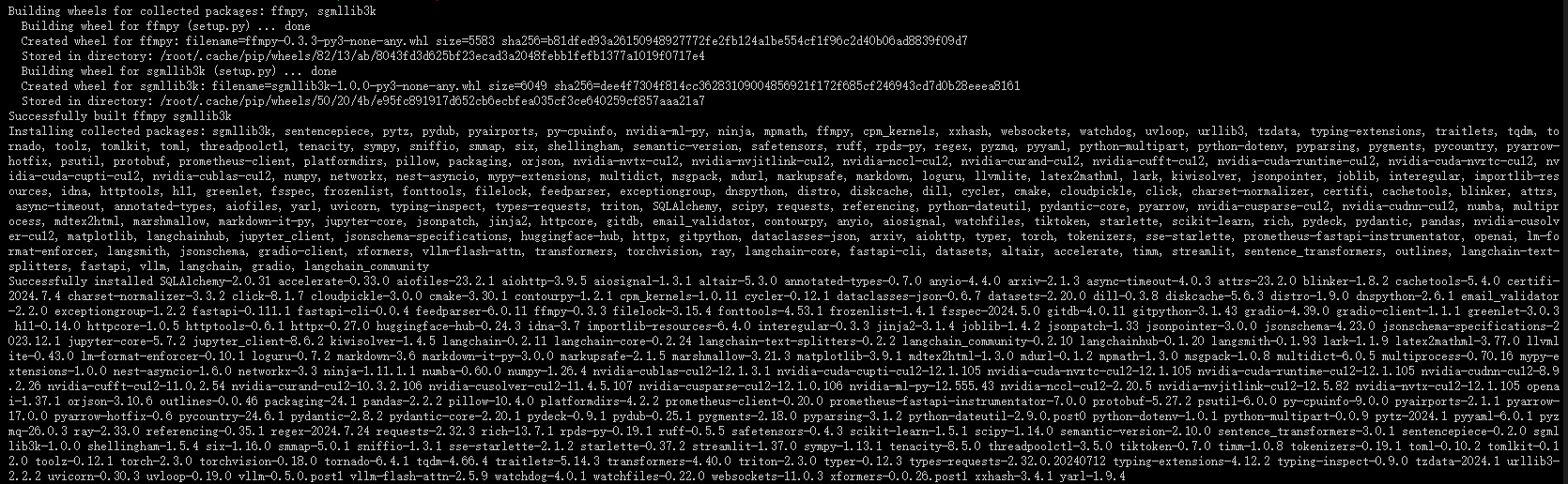

6. 安装模型依赖库:

- 切换到项目目录

# 切换到项目工作目录

cd /ChatGLM3

- 激活 ChatGLM3 虚拟环境

conda activate ChatGLM3

- 安装 requirements.txt 依赖

# 在 ChatGLM3 环境中安装 requirements.txt 依赖

pip install -r requirements.txt

依赖安装成功如下图所示:

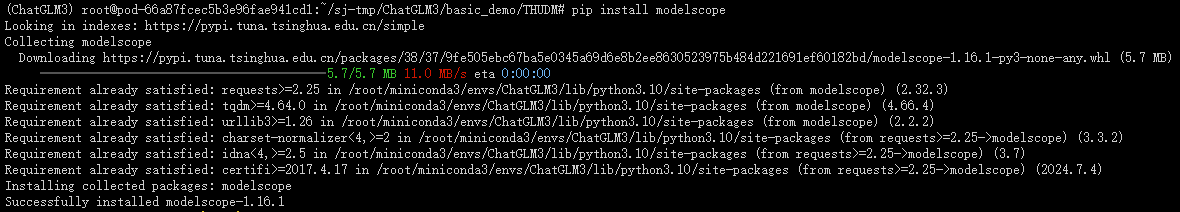

7. 下载预训练模型:

# 创建一个THUDM文件夹

mkdir -p /ChatGLM3/basic_demo/THUDM

# 递归复制ChatGLM3这个整体文件夹到数据盘位置(因为模型有点大,系盘无法存放)

cp -r /ChatGLM3 /root/sj-tmp/

# 切换到 ChatGLM3 项目的 THUDM 目录

cd /root/sj-tmp/ChatGLM3/basic_demo/THUDM

安装 modelscope 依赖包

pip install modelscope

创建一个Python下载脚本

vim modelscope_download.py

插入以下下载代码

# Python 代码下载模型

from modelscope import snapshot_download

model_dir = snapshot_download('ZhipuAI/chatglm3-6b', cache_dir='./', revision='master')

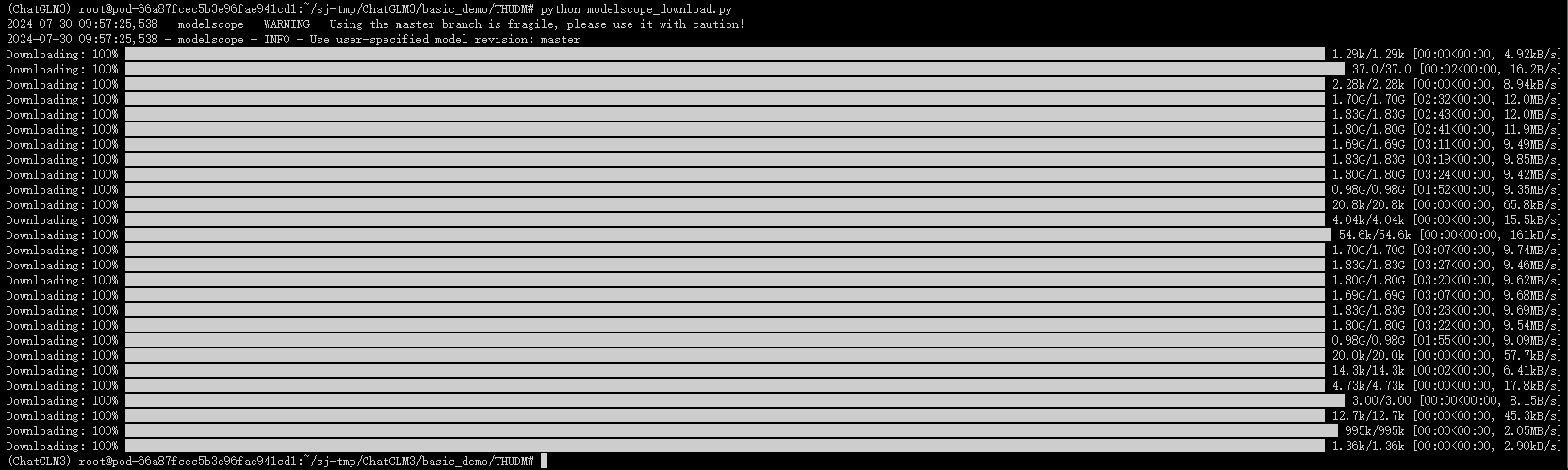

执行 modelscope_download.py 文件进行模型下载

python modelscope_download.py

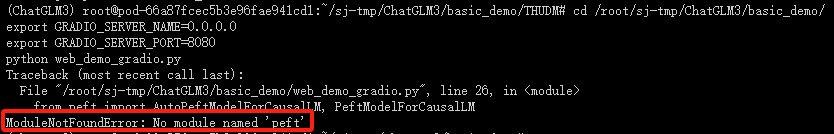

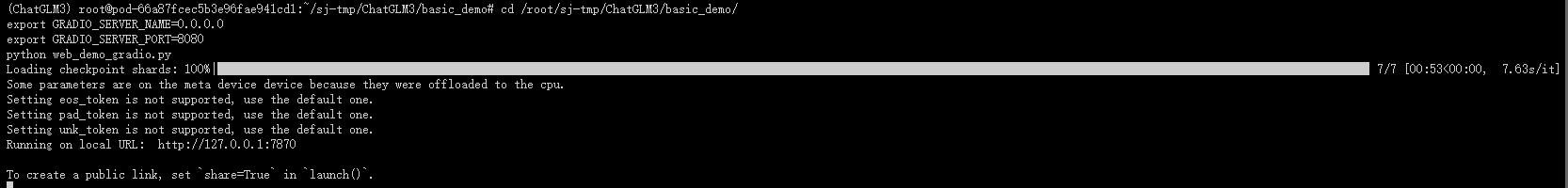

8. 运行 web_demo_gradio.py 文件

cd /root/sj-tmp/ChatGLM3/basic_demo/

python web_demo_gradio.py

出现以上代码“ModuleNotFoundError: No module named 'peft'”报错,安装 peft 依赖包

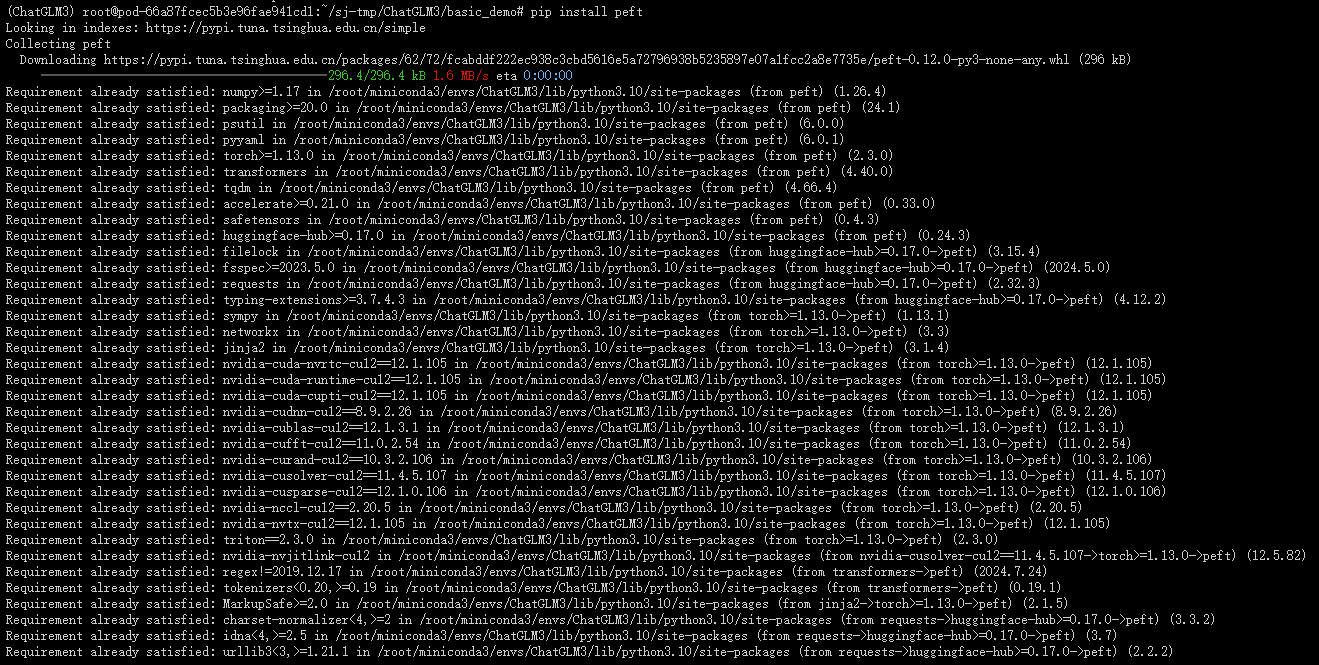

# 安装 peft

pip install peft

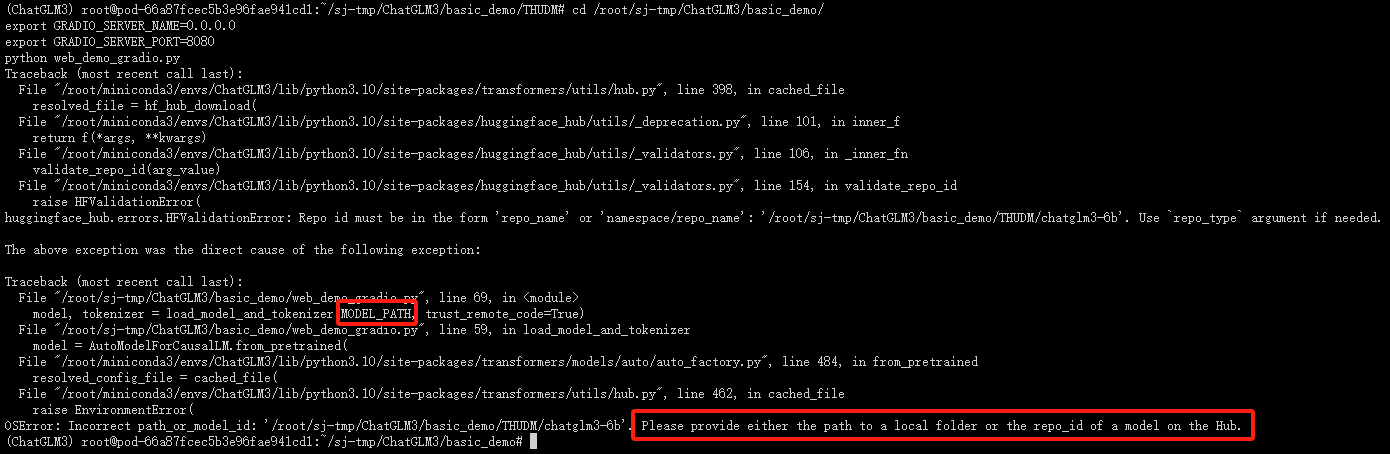

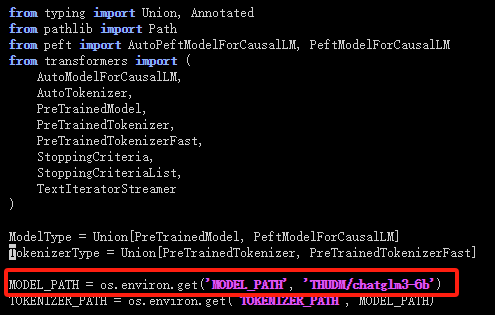

出现以上报错,需要修改模型路径

# 编辑 web_demo_gradio.py 文件

vim web_demo_gradio.py

替换为

MODEL_PATH = os.environ.get('MODEL_PATH', 'THUDM/ZhipuAI/chatglm3-6b')

出现以上结果,还需要继续修改 web_demo_gradio.py 文件的IP和端口,才能进入 gradio 页面

编辑 web_demo_gradio.py 文件

vim web_demo_gradio.py

![]()

替换为

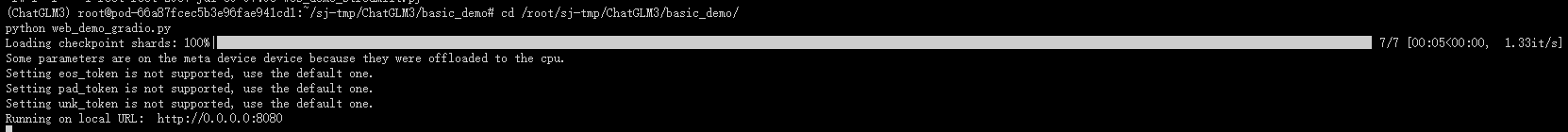

demo.launch(server_name="0.0.0.0", server_port=8080, inbrowser=True, share=True)

替换说明:server_name 为IP地址, server_port 为端口号,根据访问需求进行替换即可

三、网页演示

出现以下Gradio 页面,即是模型已搭建完成。

298

298

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?