从春节期间 Open AI 隆重发布 Sora,带来了全网刷屏,到 PIKA 近日发布的给视频无缝生成音效功能,多模态大模型成为2024年人工智能最受关注的方向之一。

小编今天想和大家聊聊Sora和它背后的数据。

Sora的发布让大家惊掉了下巴,它不但可以生成最长60s视频,还可以保持镜头的前后一致性、超逼真。

从官方发布的视频demo来看,Sora只需要输入包含“构成元素、环境、行为及发生顺序、视频风格”等关键因素的Prompt(提示词),就能生成不同风格的高清、连贯,且具有丰富运镜和转场的60s视频。

例如生成包含人物和城市元素的视频:

提示词:一位时尚女性走在充满温暖霓虹灯和动画城市标牌的东京街道上。她穿着黑色皮夹克、红色长裙和黑色靴子,拎着黑色钱包。她戴着太阳镜,涂着红色口红。她走路自信又随意。街道潮湿且反光,在彩色灯光的照射下形成镜面效果。许多行人走来走去。

Sora也能生成动物和自然风光:

提示词:几只巨大的毛茸茸的猛犸象踏着白雪皑皑的草地走近,它们长长的毛茸茸的皮毛在风中轻轻飘动,远处覆盖着积雪的树木和雄伟的雪山,午后的阳光下有缕缕云彩,太阳高高地挂在空中距离产生温暖的光芒,低相机视角令人惊叹地捕捉到大型毛茸茸的哺乳动物,具有美丽的摄影和景深。

01 聊聊Sora的训练数据

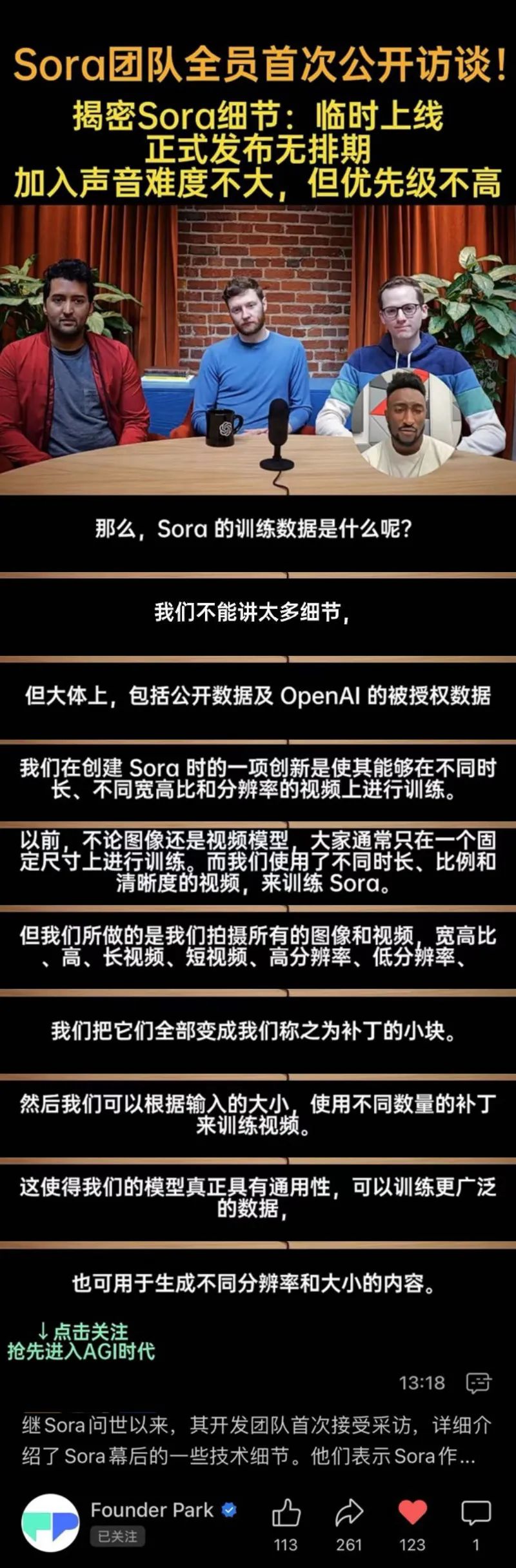

Sora团队谈数据

Sora背后使用的数据,也成为行业中热议的话题。就在近期 OpenAI Sora 团队接受采访时,提到数据相关的内容:

公众号「晓妍聊AI」谈Sora数据

1. 数据集

从Sora目前展示的演示来看,所采用的数据集在质量和多样性方面还是非常好的。通过对比生成的视频与UE(Unreal Engine)的局部相似性,我们可以推测数据集中应该融合了一定比例的UE数据。人类在现实世界中生活,具备对三维空间的基本认知和常识,然而如果直接让大模型学习二维视频,由于单一视角的局限性,模型难以保持三维一致性。UE的物理引擎是基于求解动力学方程构建的,包含了丰富的physics prior和ground truth。将UE生成的数据输入大型模型,经过深度神经网络的压缩,模型能够抽象出一些隐含的物理规律,虽然现在还不会像物理引擎那样精确。

决定视频数据集质量最关键因素不是视频本身,而是对视频内容的详尽描述。OpenAI在开发DALL-E 3时曾发表论文《Improving Image Generation with Better Caption》,核心思想是文生图模型无法根据用户提示生成图像的原因在于训练数据质量的不足,主要问题出在文本描述的粗略和不准确上。为了解决这一问题,OpenAI训练了一个Image-caption模型,就是一个类似GPT的自回归语言模型,encoder采用了CLIP的图像编码部分,能够将输入的图像从像素空间映射到与内容语义对齐的embedding空间,然后生成与图像内容相匹配的详细文本描述。实践证明,使用这种高质量的文本-图片对重新训练DALL-E,能够大幅提升文生图模型的效果。在Sora的训练过程中,他们也采用了类似的caption模型来提升视频文本描述的质量,取得了显著的效果。

2. 视频数据预处理

视频数据的处理是Sora的亮点和最大的创新之处。

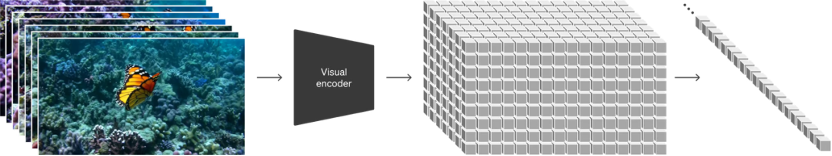

第一步,压缩。视频的raw data很大,我们首先通过VAE(Variational Auto-Encoders,变分自编码器)将其压缩到latent space(潜空间),这个潜空间的维度远小于输入视频对象的维度,它是输入对象的紧凑表示。我们知道视频的像素空间本身含有大量的冗余信息,比如相邻像素格子的取值往往是相似的,潜空间是一种非常好的处理高维复杂数据的方式,同时我们还要保证解码的时候能够从潜变量还原出原数据,那么合适的压缩比就非常重要,压得太多还原出的数据质量就会变差,具体压到多少维度合适这是个工程问题,需要我们通过实验试出来。VAE的优势在于,潜空间的表示不是一个点,而是一个概率分布,可以通过调整采样点控制生成数据的特性,给我们提供了一个更好地理解和控制生成过程的理论框架。

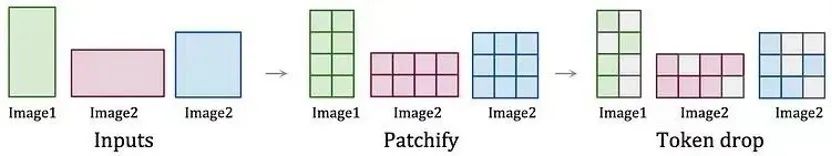

第二步,分割。OpenAI将视频流看成是由空间坐标x,y和时间坐标t组成的三维块,并将其切割成一系列小块,称为spacetime latent patches。这是Sora最出彩的地方,它将时间和空间作为等价的变量处理,统一了时空分割的语言。在此之前,生成模型通常将视频视为连续帧序列,通过关键帧生成、上采样、下采样和插帧技术来创建连续视频。这种方法分别处理空间和时间维度,类似于将视频处理成一系列动图gif,产生的视频动作幅度小,时长短,很难保持长时间连贯性,且需要将所有视频剪裁至统一大小才能处理。而通过分割成patches的方式,可以处理不同持续时间、分辨率和宽高比的视频,这个思想借鉴了 Google DeepMind 在 NaViT 和 ViT(Vision Transformers)上的早期研究成果,OpenAI将其发展为一种为多模态数据而生的高度可扩展且有效表达方式(原文中:highly-scalable and effective representation),这是一种非常优雅且精妙的解题思路,OpenAI将Scaling的理念贯穿于每一个环节里。

将视频数据转化为patches

谷歌提出的将视觉信息patch化

第三步,tokenization。把分割好的patches小块token化成一维的embedding,这里借鉴了谷歌的MAGVIT-v2 视觉tokenizer,它用一个temporarily causal 3D CNN(有时间因果性的3D CNN)去编码视频和图像,以更好地适应有因果性、时间序列性质的任务。

02 多模态大模型训练数据集

尽管模型生成的数据在一定程度上能够增强模型的性能,但它始终无法与真实数据的精确度和稳健性相媲美。海天瑞声始终专注于提供高质量的精标数据服务以及丰富的多模态数据资源。

自去年起,我们与领先的大模型技术企业携手,共同打磨多模态大模型的数据解决方案,致力于为客户打造全方位的一站式数据服务体验。我们的服务涵盖了从数据采集、预处理、清洗、标注到质量检验等一系列工程化流程,确保客户能够获得最优质的数据支持。

1848

1848

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?