OpenKG

大模型专辑

导读 知识图谱和大型语言模型都是用来表示和处理知识的手段。大模型补足了理解语言的能力,知识图谱则丰富了表示知识的方式,两者的深度结合必将为人工智能提供更为全面、可靠、可控的知识处理方法。在这一背景下,OpenKG组织新KG视点系列文章——“大模型专辑”,不定期邀请业内专家对知识图谱与大模型的融合之道展开深入探讨。本期特别邀请到华为大模型技术专家李芳明和浙江大学研究员张文分享“知识与大模型融合技术在电信领域应用探索”。

分享嘉宾 | 李芳明(华为)、张文(浙江大学)

笔记整理 | 邓鸿杰(OpenKG)

内容审定 | 陈华钧

摘要:本次分享是我们团队近两年做的一些知识与大模型融合技术在电信领域应用的一些工作。主要包括两部分内容:

1. 知识图谱与大模型融合故障定界

2. 知识与大模型融合电信领域知识问答

01

知识图谱与大模型融合故障定界

1.1 背景介绍:

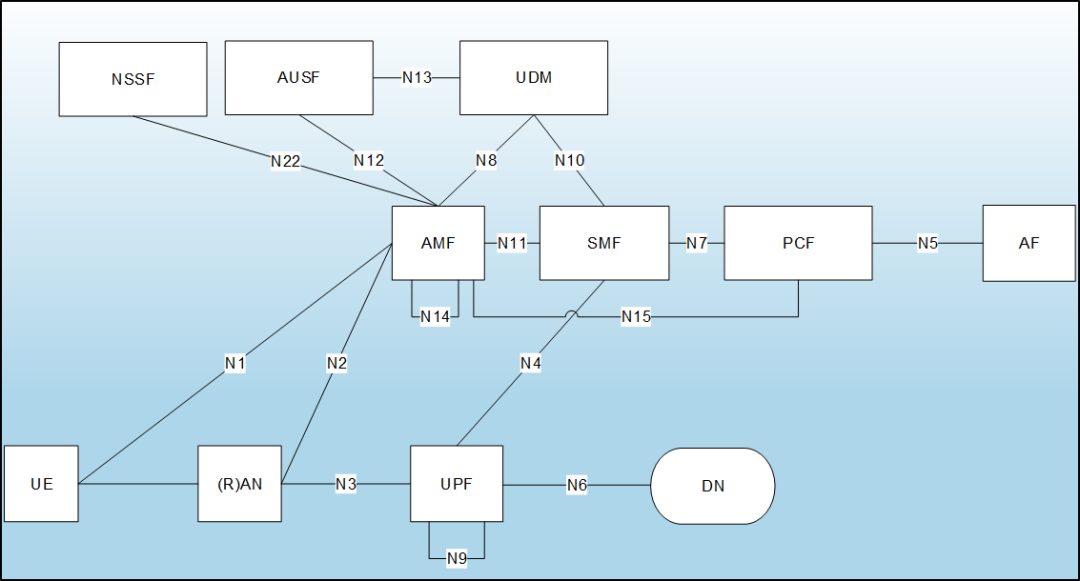

云核心网的特点是为了完成对应的业务功能需要不同网元之间的相互调用,所以当一个网元故障发生时,与其有业务调用关系的网元也会业务受损,表现出故障状态。故障网元实例定界就是在多个网元都出现故障现象时,定位到真正的故障网元,即“始作俑者”。下图是云核心网的逻辑架构图。

整体方案的输入为故障数据包,输出故障网元,目标最大化提升运维工程师的定位效率。PS:机器语言大模型是我们决策式大模型的名字。

1.2 技术方案:

1.2.1 技术方案概述

在ChatGPT出来之前,“模型+知识双驱动”的研究方向是很火的,我们团队之前也做了基于知识图谱的故障定界方案,所以接下来我们就想探索一个基于模型的故障定界方案,说到基于模型那肯定要上大模型,虽然当时大模型没有火热到今天这种地步,也还是很热门的研究方向。

整体方案的设计思路是将故障发生时的异常事件向量化后全部挂载到对应网元上去,得到一个故障时刻的数字网络快照,然后通过图神经网络的方法去完成不同网元之间的异常事件信息交换,经过信息交换后,每个网元都是“知己知彼”,既知道自己发生了什么异常事件,又知道周边网元发生了什么异常事件,接下来就可以通过全连接神经网络推断每个网元是否是根因网元。(有点类似于剧本杀的逻辑,大家都拿到各自剧本,最开始只知道自己身份相关的

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1897

1897

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?