这篇文章的核心内容是关于一种新型的领域自适应目标检测(Domain Adaptive Object Detection, DAOD)方法——DINO Teacher。该方法旨在通过利用大型视觉基础模型(Vision Foundational Models, VFMs),特别是 DINOv2,来提高在不同领域之间进行目标检测的性能。以下是文章的主要研究内容和贡献的总结:

1. 研究背景与动机

-

领域自适应目标检测(DAOD):在计算机视觉中,模型在标记的源数据集上训练,然后需要在未标记的目标数据集上进行测试。由于源域和目标域之间的分布差异,模型在目标域上的性能往往会显著下降。领域适应的目标是通过某种方式将源域的性能迁移到目标域。

-

现有方法的局限性:当前的 DAOD 方法大多基于均值教师(Mean Teacher)框架,通过自标记(self-labelling)的方式在目标域生成伪标签。然而,这种方法存在局限性,因为它依赖于学生模型自身的性能,且在目标域的标签生成上可能不够准确。

2. DINO Teacher 方法

文章提出了 DINO Teacher,一种新的 DAOD 方法,通过以下两个主要组件来解决现有方法的局限性:

-

DINO 标记器(Labeller):使用 DINOv2 作为主干网络,仅在源数据上训练一个检测头,生成目标域的伪标签。这种方法比传统的均值教师方法更准确,因为它利用了 DINOv2 在大规模数据上预训练的泛化能力。

-

特征对齐(Feature Alignment):将学生模型的特征与 DINOv2 的特征进行对齐,分别对源图像和目标图像进行对齐。这种对齐方法不依赖于伪标签的质量,而是通过推动学生模型的特征更接近 DINOv2 的特征来提高泛化能力。

3. 方法细节

-

DINO 标记器:通过在源数据上训练一个检测头,生成目标域的伪标签。实验表明,这种方法比均值教师生成的伪标签更准确。

-

特征对齐:使用 DINOv2 的特征作为对齐目标,通过最大化学生特征和 DINO 特征之间的相似性来对齐。这种方法在不需要伪标签的情况下,提高了学生模型的特征泛化能力。

-

训练阶段:训练分为多个阶段,包括仅在源数据上训练、在目标数据上使用伪标签训练,以及在源数据和目标数据上进行特征对齐。

4. 实验结果

-

数据集:在多个标准数据集上进行了实验,包括 Cityscapes、Foggy Cityscapes、BDD100k 和 ACDC。

-

性能提升:在多个数据集上,DINO Teacher 方法均取得了最先进的性能。例如,在 BDD100k 数据集上,mAP 提升了 +7.6%;在 Foggy Cityscapes 数据集上,mAP 提升了 +2.3%。

-

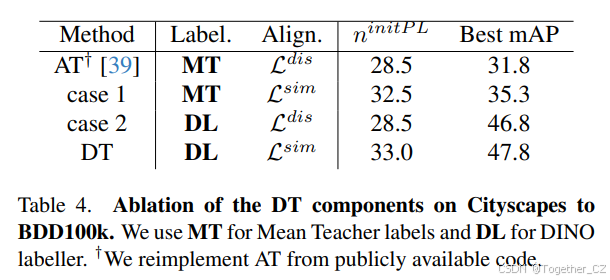

消融研究:通过消融研究验证了 DINO 标记器和特征对齐的有效性。实验表明,DINO 标记器生成的伪标签比均值教师更准确,特征对齐显著提高了模型的泛化能力。

5. 结论

DINO Teacher 方法通过利用大型视觉基础模型的泛化能力,显著提高了领域自适应目标检测的性能。该方法不仅在生成更准确的伪标签方面表现出色,还在特征对齐方面展示了强大的能力,从而在多个标准数据集上取得了最先进的性能。文章还讨论了该方法的潜在改进方向,例如使用更大的模型进行对齐,以及如何进一步优化伪标签的生成过程。

6. 贡献

-

提出了一种新的 DAOD 方法,DINO Teacher,通过 DINOv2 生成更准确的伪标签和进行特征对齐。

-

在多个标准数据集上验证了该方法的有效性,取得了最先进的性能。

-

通过消融研究详细分析了各个组件的贡献,为未来的研究提供了有价值的见解。

这篇文章的核心贡献在于提出了一种新的 DAOD 方法,通过利用大型视觉基础模型的泛化能力,显著提高了在不同领域之间进行目标检测的性能。这里是自己的论文阅读记录,感兴趣的话可以参考一下,如果需要阅读原文的话可以看这里,如下所示:

项目地址在这里,如下所示:

摘要

当前领域自适应目标检测(DAOD)的最先进方法使用了均值教师(Mean Teacher)自标记方法,其中教师模型直接作为学生模型的指数移动平均值,用于在目标域生成标签,然后这些标签被用于通过正反馈循环改进两个模型。这将目标域的学习和标签生成耦合在一起,其他近期工作也利用生成的标签添加额外的领域对齐损失。我们认为这种耦合是脆弱且过度受限的:无法保证仅在源数据上训练的学生能够生成准确的目标域标签并启动正反馈循环,而且很可能通过使用一个接触了更多数据的大型预训练网络来生成更好的目标域标签。视觉基础模型(Vision Foundational Models, VFMs)正是这样的模型,它们即使在冻结状态下也展示了令人印象深刻的跨任务泛化能力。我们希望利用这些模型进行 DAOD,并引入 DINO Teacher,它包含两个组件。首先,我们仅使用源数据训练一个新的标记器,使用大型冻结的 DINOv2 主干网络,并证明它比均值教师生成更准确的标签。其次,我们将学生模型的源图像和目标图像的图像块特征与 DINO 编码器的特征对齐,推动源域和目标域的表示更接近可泛化的 DINO 表示。我们在多个 DAOD 数据集上获得了最先进的性能。

1. 引言

现代深度学习方法在许多计算机视觉任务的广泛基准数据集上能够实现强大的性能,包括分类、目标检测和分割。然而,当在训练分布之外的数据上进行测试时,这种性能通常会显著下降。领域适应通过将网络从标记的源数据集迁移到未标记的目标数据集来解决这一问题。在本工作中,我们特别关注领域自适应目标检测(DAOD)任务。

实现领域适应的两种常见技术是领域不变性和自标记。领域不变性试图最小化源域和目标域特征之间的差异,要么通过使用对抗策略与领域判别器,要么通过最小化某些领域之间的距离度量。自标记方法则尝试为目标数据集生成自己的伪标签。最常见的框架是均值教师,其中标记器直接从正在训练的模型中派生。这是一种引导方法,模型选择置信度高的提议作为目标域的训练真值,从而提高其性能,并在下一次迭代中生成更多和更高质量的伪标签。由于这种自标记方法的性能对用于训练的伪标签的选择非常敏感,许多方法尝试通过超越简单的类别置信度阈值来细化标签选择。

在上述两组方法的交叉领域中,有一些工作利用自生成的标签来改进领域不变性方法。通过使用标签,可以在提议级别或像素级别进行对齐,并且可以约束为同一类别的实例,从而改进早期的图像级别方法。然而,这些方法受到教师网络性能的限制,如果目标域中某些类别样本不足,可能会表现不佳。这些问题使得在小数据集上适应具有显著领域差距的情况变得尤为困难,例如自动驾驶中的严重恶劣天气。

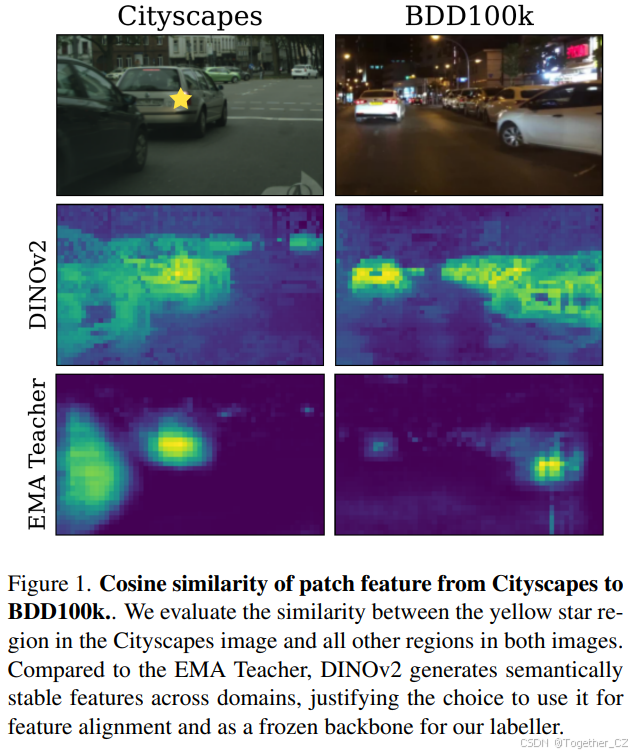

近期,大规模视觉基础模型(VFMs),无论是纯视觉模型(如 DINOv2、SAM)还是结合视觉和语言的模型(如 CLIP),已经广泛可用。这些模型结合了大型架构和在大规模训练数据集上的自监督预训练,并在多项计算机视觉任务上展示了令人印象深刻的性能,包括作为领域适应和泛化方法中的增强和生成方法。鉴于此,我们认为当前用于 DAOD 的均值教师范式已经过时。虽然在机器人或自动驾驶中对小架构进行领域适应有明显应用,且伪标记仍然是一个强大的策略,但我们认为简单地使用学生模型的副本作为教师已不再合理。通过将标记与训练学生模型解耦,我们可以在保持训练模型大小的同时,使用更现代的方法来解决领域适应问题。在这里,我们提出使用经过最小调整的视觉基础模型作为标签来源,强调 VFMs 在多种适应任务中的实用性。同样,虽然类别条件对齐在领域之间可能有益,但我们选择将跨领域对齐与准确实例标签解耦。为此,我们提出将学生表示与 VFM 主干生成的特征对齐。这些模型的特征已被证明能够很好地泛化到不同任务和新目标域。我们在图 1 中展示了不同数据集中相似对象的这些一致特征。

因此,我们提出了用于 DAOD 任务的 DINO Teacher(DT),它以两种方式利用大型视觉基础模型。首先,我们证明在仅使用源数据训练的大型冻结 DINOv2 主干网络上添加一个简单的检测器,比均值教师是一个更好的目标域标记器,展示了均值教师方法的对称架构和有限训练数据的缺点。其次,我们提出使用大型 VFM 的特征空间作为领域对齐的代理。通过分别对源图像和目标图像对齐学生主干特征与 VFM 生成的特征,我们推动学生源域和目标域特征更接近。我们的主要贡献包括:

-

我们证明,使用在大型自监督编码器上训练的简单检测器生成的伪标签,比从学生派生的教师生成的伪标签要准确得多,使用这些新标签可以显著提高性能。

-

其次,我们证明,将小型学生主干的图像块级输出与大型 VFM 在源图像和目标图像上对齐,可以推动模型学习更具泛化能力的特征,而无需使用任何标签,将特征对齐与伪标签质量解耦。

-

我们在多个 DAOD 基准测试中实现了最先进的性能,在 BDD100k 上提高了 +7.6%,在 Foggy Cityscapes 上提高了 +2.3%。我们还在涵盖更广泛恶劣天气条件的 ACDC 测试分割上展示了新的结果,并显著改进了我们的基线。

2. 相关工作

2.1 领域自适应目标检测

领域自适应目标检测(DAOD)基于早期领域适应在图像分类中的工作。DAOD 任务是将一个在标记的源域上训练的检测器适应到一个未标记的目标域。领域适应的常见方法是自标记或伪标记。这些方法通过从仅在源域上训练的模型中采样置信度高的提议,为目标域生成标签。这通常使用均值教师框架(MT),其中模型的迭代平均版本生成更稳健的标签。这个框架构成了许多近期工作的基础。由于这种自标记方法试图通过引导自身生成更多和更好的标签,因此对生成的伪标签中的错误或偏差非常敏感。许多工作试图通过改变选择阈值或过采样罕见类别的实例来减少对罕见类别的偏差。其他方法通过估计边界框的不确定性并使用它来选择或重新加权边界框来改进边界框定位。我们认为均值教师框架中标签生成与学生模型性能之间的耦合限制了生成标签的质量。相反,我们提出通过训练一个独立的标记器来为目标域提供尽可能好的伪标签,从而将标签生成与在学生模型上解决领域适应任务解耦。由于我们仍然需要生成最好的标签来训练学生,因此近期的一些改进,例如过采样罕见类别,可能与我们的框架相辅相成。

另一种常见的领域适应策略是领域不变性。这最初被表述为一种对抗性损失,它推动图像级别的主干特征不包含任何领域信息。其他方法通过直接最小化源域和目标域特征表示之间的距离度量来获得领域不变特征。其中一些距离度量包括对比损失、图对齐或最优传输。最简单的不变性或对齐方法在图像级别上操作,但无法保证图像级别的对齐会导致检测和分割任务所需的实例级别对齐。或者,可以将对齐方法与上述自标记方法结合起来,允许实例级别和类别条件对齐。然而,将对齐项与自标记耦合会导致一种困境:需要良好的标签来进行稳健的对齐,但领域对齐也是生成良好标签所需要的。相反,我们提出通过鼓励学生模型的特征空间与自监督 VFM 在源图像和目标图像上的特征空间相似,间接对齐领域,而无需任何标签。

其他方法使用更强的数据增强,减少在源域和有限的目标域生成标签上的过拟合。这包括 Mixup 和 CutMix 的实现,无偏教师的弱 - 强方法或各种频域变换,这些方法假设某些频带或幅度谱是领域特定的,并且可以在图像之间进行扰动或转移。类似地,一些方法使用生成模型来学习源域和目标域之间的映射,以将标记的源图像转换为目标域图像。最后一种方法是在特征空间中使用掩码重建来学习更好的目标域特征。我们认为这些方法可能与我们的方法相辅相成。

2.2 大型模型在领域适应和泛化中的应用

近期,许多方法开始利用 VFMs 进行领域适应。一些方法试图通过仅微调少量参数或修改编码器的输入提示来改进大型预训练模型。其他方法类似于上述生成方法,CLIPStyler、PØDA、FAMix 和 ULDA 等方法都表明,给定对齐的视觉 - 语言嵌入,可以通过在对齐的图像特征空间中复制由文本编码的领域偏移来合成新的目标域图像或图像特征,从而在不需要任何目标图像的情况下实现适应。尽管所有这些方法都是有趣的研究方向,但我们将重点放在标准 DAOD 任务上,该任务试图在给定相对较小的模型架构(例如 VGG16)的情况下,最大化对未标记目标数据集的性能,这在现实世界中部署网络时是至关重要的。

更接近我们工作的是,UFR 最近使用 Segment Anything 来完善用于增强的实例掩码,但仍训练和评估于较小的架构。尽管增强方法对于领域适应很有用,但自标记方法通常显示出更强的适应性能。鉴于此,我们研究了将 VFMs 作为标记器的使用。如前所述,这些大型模型的一个优势是它们对其他下游任务的泛化能力。近期工作 REIN 表明,完全冻结的主干网络与完全微调的网络在领域泛化的语义分割任务中几乎相当,证实了计算机视觉任务的强特征泛化能力。我们希望利用这种能力,使用大型模型作为标记器在未标记的目标域数据上进行标记,并作为学生网络的对齐目标。

3. 方法

在本节中,我们总结了领域自适应目标检测问题,介绍了基线方法,并解释了我们的贡献。我们主要基于 Adaptive Teacher 框架,并经常将我们的设计选择与该方法进行对比。图 2 概述了我们提出的 DINO Teacher 框架。

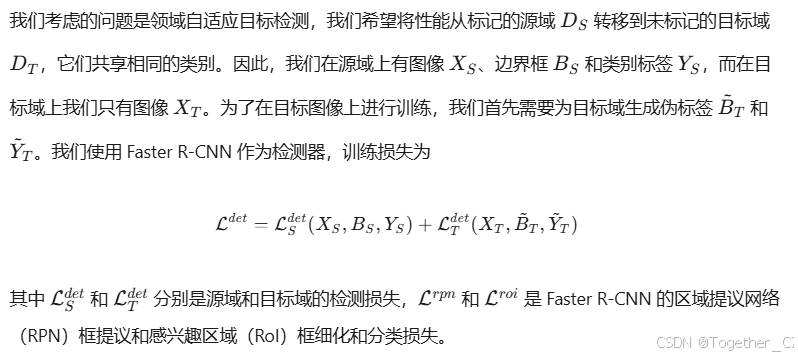

3.1 问题定义

3.2 均值教师框架

3.3 基础模型用于伪标记

3.4 基础模型用于特征对齐

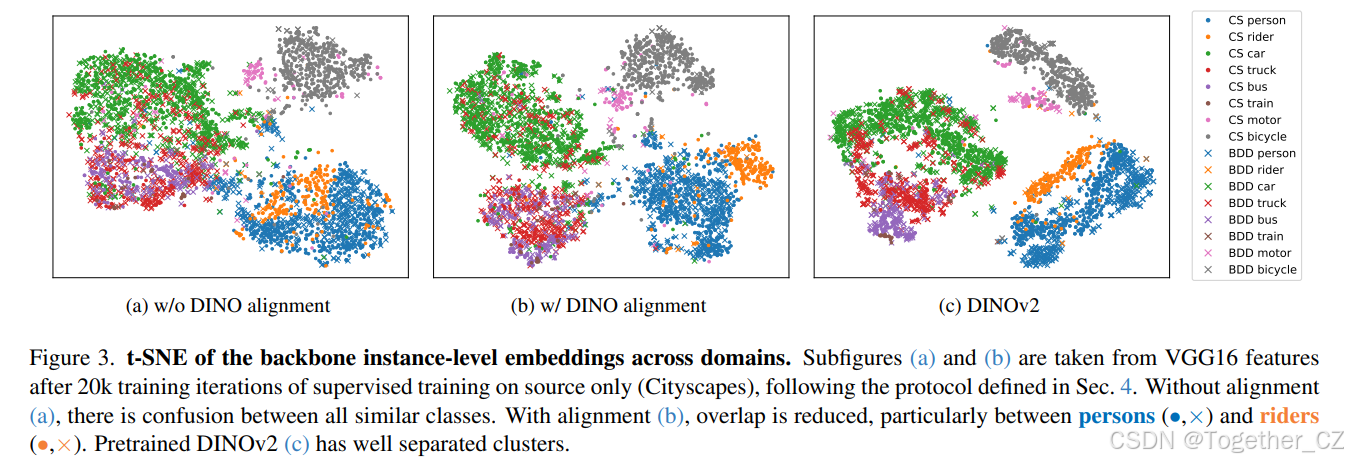

如第 2 节所述,现有的领域不变性方法以两种方式操作。首先,它们可以在图像级别进行对齐,这不能保证实例级别的对齐,并且可能会被背景信息主导,但不需要标签。或者,它们可以使用伪标签来匹配语义相关区域或实例进行对齐,这通常会提高性能,但代价是依赖于准确生成的标签。我们提出一种替代的对齐方法,通过使用代理对齐目标来对齐语义相似区域,而无需使用生成的标签,我们可以独立地对齐学生模型从源图像和目标图像的特征,而无需在领域之间匹配区域。

为此,我们使用 VFM 的特征表示作为我们的对齐目标。同样,我们假设 DINOv2 特征将更好地泛化到目标域,并且任何特定对象类别的表示将比仅在源数据上训练的小学生模型的表示在领域之间更好地定义。为了改进学生,我们提出将学生主干的图像块级特征与冻结的 DINOv2 编码器在源域和目标域的单个图像上的特征进行对齐。这推动学生对两个领域的表示更接近大型模型的表示,减少领域差距。我们在图 3 中使用 t-SNE 比较了学生网络的实例级特征聚类与 DINOv2 对齐以及原始 DINOv2 聚类。这表明 DINO 特征具有更好的稀有类别分离,并且将学生与 DINOv2 对齐可以改善在源域 Cityscapes 和目标域 BDD 上的分离。

与第 3.3 节中描述的标记器不同,我们使用较小的 DINOv2ViT-B 作为对齐编码器。虽然标记器仅在目标训练数据集的每个图像上运行一次,并且在训练学生之前完成,但对齐 DINO 编码器在在线训练中使用,我们发现较大 ViT 模型的推理速度过慢。我们的方法并不要求两个 DINO 编码器相同,并且编码器永远不会同时使用(见图 2)。

3.5 完整方法

我们的完整损失将伪标记检测损失(公式 1)与相似性损失(公式 3)结合起来

4. 实验

4.1 数据集

Cityscapes。所有报告的运行都使用 Cityscapes 作为源数据集。Cityscapes 是一个自动驾驶数据集,包含 2975 张训练图像和 500 张验证图像,检测标签涵盖 8 个类别。

Foggy Cityscapes。Foggy Cityscapes 是一个合成数据集,使用原始清晰图像和深度图模拟三种强度(0.005、0.01、0.02)的雾天天气。它包含 8925 张训练图像和 1500 张验证图像,每个 Cityscapes 图像的每个强度级别都有一个图像。我们在完整的验证数据集上进行评估。

BDD100k。BDD100k 数据集是另一个大型自动驾驶数据集。按照以往的工作,我们在 Daytime 分割的图像上进行训练和评估,这对应于相机和地理位置的领域偏移,但没有显著的天气变化。它包含 36728 张训练图像和 5258 张验证图像。它与 Cityscapes 中的 7 个类别共享。

ACDC。ACDC(Adverse Conditions Dataset with Correspondences)是一个专注于四种恶劣天气条件(雾、夜、雨和雪)的自动驾驶数据集。它与 Cityscapes 共享相同的 8 个目标检测类别。每个分割包含 400 张训练图像和 100 张验证图像(夜间验证为 106 张)。我们在每个单独的分割上进行训练和评估。

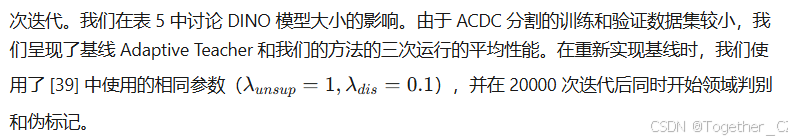

4.2 实验设置

4.3 结果

我们将我们的方法与其他最先进方法的性能进行比较,并报告在 50% IoU 下的类别平均精度(mAP@50)。在表格中,我们使用以下缩写:FR 表示 Faster R-CNN,GA 表示图对齐,MT 表示均值教师。我们在不同的环境、相机和恶劣天气条件下进行评估。

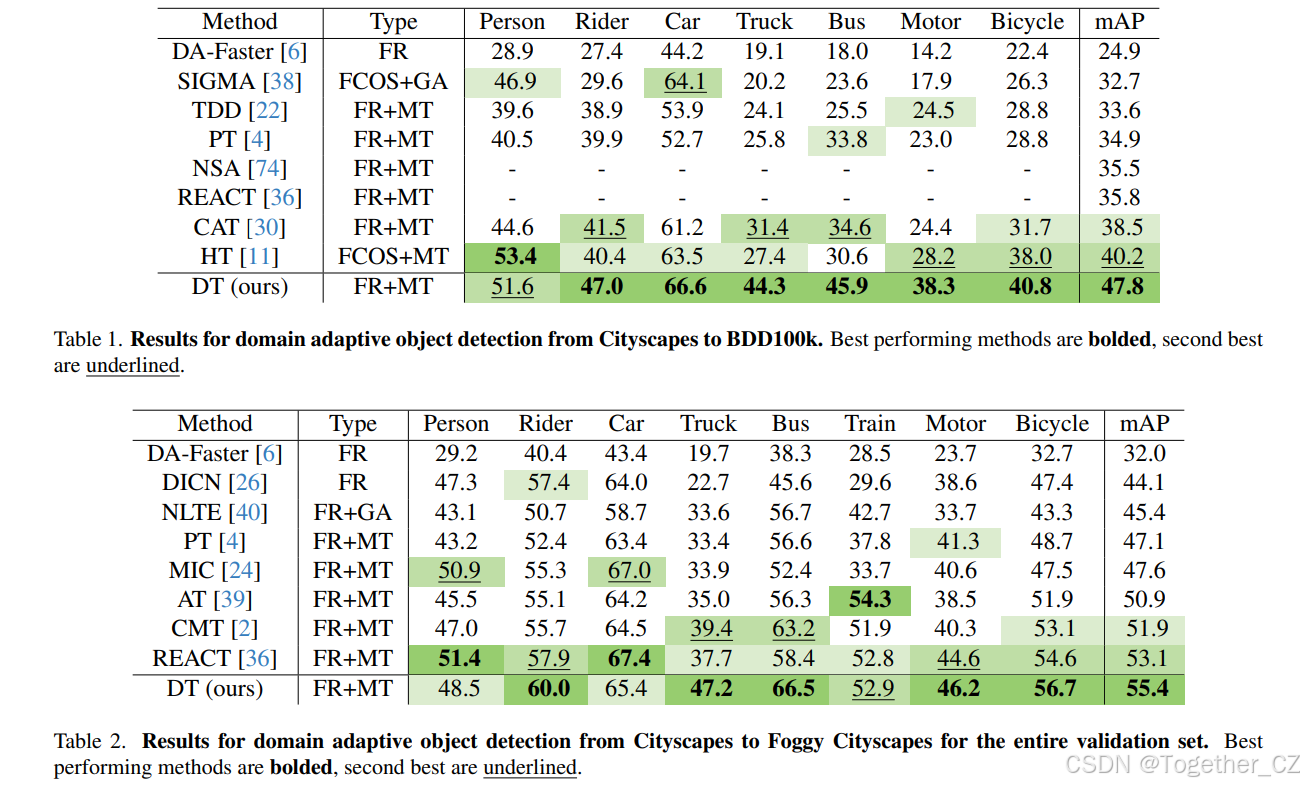

Cityscapes → BDD100k。第一个测试设置考虑了向 BBD100K 的领域适应,对应于不同的环境和相机。我们在表 1 中呈现我们的结果。我们获得了最先进的结果,超过了 Harmonious Teacher 的性能 +7.6%,在罕见类别上有特别大的改进。鉴于目标数据集较大,我们表明通过使用更好的标记器来提高标签质量可以显著提高性能,优于使用均值教师框架。我们在表 5a 中讨论了标记器大小与学生网络性能之间的相关性。

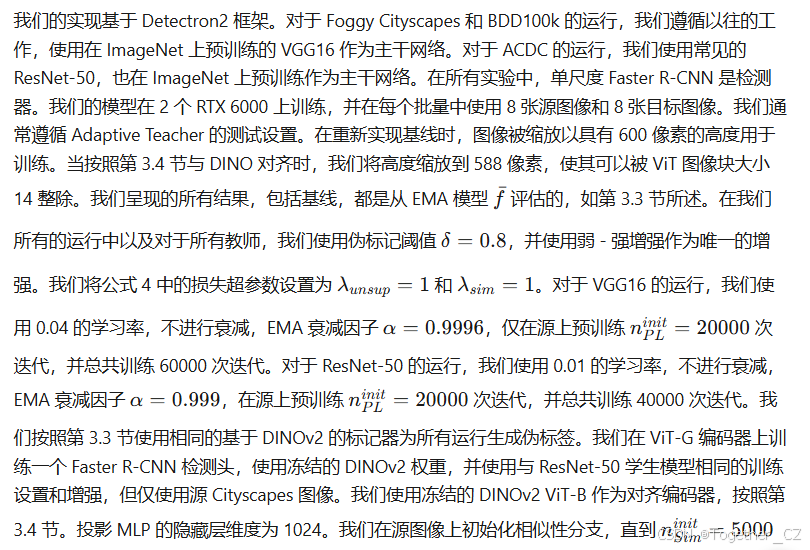

Cityscapes → Foggy Cityscapes。第二个测试考虑了跨相对容易的恶劣天气条件的领域适应,即合成添加的雾。我们在表 2 中呈现了完整验证集的结果,并在此数据集上获得了最先进的性能,与近期的 REACT 方法相比提高了 +2.3%,与我们的基线架构 AT 相比提高了 +4.5%,使用 ViT-G 标签时。与我们在 BDD100k 上的结果相比,我们在这个数据集上的改进较小。我们认为这是由于 Cityscapes 和 Foggy Cityscapes 之间的领域差距较小,后者是通过在原始 Cityscapes 图像上使用一致的程序生成的,并且使用相同的标签。

Cityscapes → ACDC 分割。最后的测试设置考虑了最复杂的设置:恶劣天气、不同的相机和环境,以及目标数据集小得多。我们在表 3 中呈现我们的结果。在这里,我们也观察到与 Adaptive Teacher 基线相比一致且显著的性能改进,在雾上提高了 +6.4%,在夜间提高了 +6.9%,在雨上提高了 +1.3%,在雪上提高了 +1.6%。尽管 DINO 伪标签比均值教师标签表现更好,尤其是在最具挑战性的夜间分割上,我们认为伪标签的质量限制了我们的改进。我们在第 4.5 节中进一步讨论了这一点。另一个问题是目标数据集较小,这导致在伪标签上过拟合,并限制了在测试集上的性能。

4.4 消融研究

我们在 Cityscapes 到 BDD100k 的测试案例上运行我们的消融研究,因为较大的数据集大小和显著的领域差距最能体现不同方法选择的性能改进。

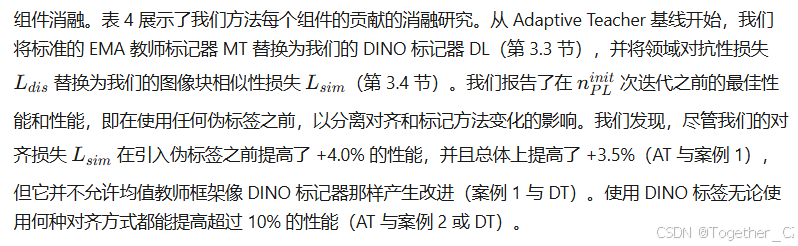

表 4.DINO Teacher 组件的消融研究,从 Cityscapes 到 BDD100k。我们使用 MT 表示均值教师标签,DL 表示 DINO 标记器。†我们从公开代码重新实现了 AT。

教师大小。接下来,我们考虑用作生成伪标签的主干(第 3.3 节)和对齐目标(第 3.4 节)的 DINOv2 模型大小的影响。结果在表 5 中呈现。ViT-S、B、L 和 G 模型分别有 2100 万、8600 万、3 亿和 11 亿参数。表 5a 展示了 DINO 标记器大小的消融研究,将主干从 ViT-B 扩展到 ViT-G 改进了我们的结果。有趣的是,对于 ViT-B 和 ViT-L,最终学生模型比标记器表现更好,这意味着标记器的性能并不是一个直接的上限。尽管标记器仅在源上进行训练,但学生使用目标标签的一个高置信度子集和真实的源标签来学习一个对两个领域都具有泛化能力的表示。从表 5b 我们还发现,与 ViT-S 相比,使用更大的 ViT-B 模型进行对齐可以提高性能,并且两者都比基线表现更好。

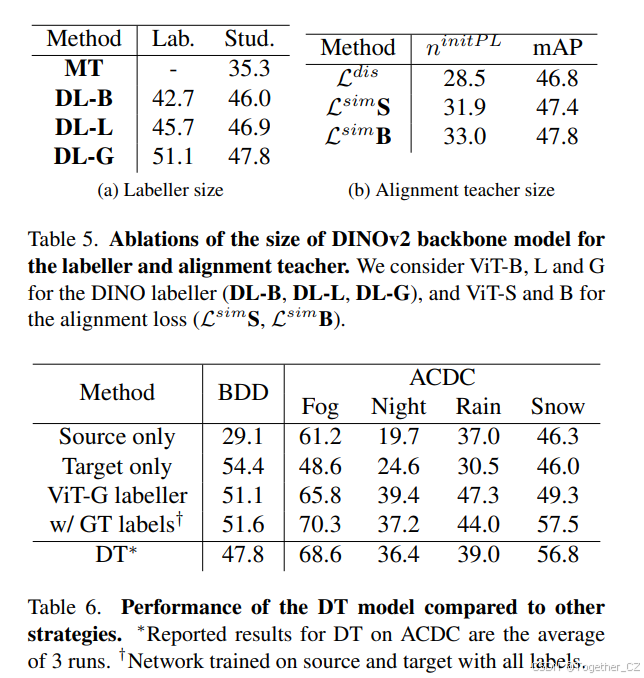

4.5 DINO Teacher 与其他基线的比较

最后,我们考虑我们的 DINO Teacher 与其他目标数据集目标检测策略的比较,并在表 6 中呈现结果。首先,ViT-G DINO 标记器比源数据学生模型泛化得更好,验证了我们选择使用 VFM 标记器进行伪标签生成的合理性。我们的 DT 方法显著优于仅在源数据上训练的学生和仅在目标数据上训练的学生,但在较大的 BDD 数据集上,它落后于仅在目标数据上训练。这表明领域适应对于小数据集的优势。替代的领域适应上限是具有理想标记器的性能,即在目标域有真实标签的情况下,并且在源和目标图像上进行训练,表 6 中用 w/GT 标签表示。这在 ACDC 上比仅在目标数据上训练提高了性能,但在较大的 BDD 数据集上并没有,这意味着在目标数据集上有足够的标签时,使用源数据进行训练可能会降低性能。我们的 DT 模型接近这个上限,但差距表明更好的标记器可能会带来改进。

5. 结论

我们提出了一个新颖的领域自适应目标检测框架 DINO Teacher,其中我们利用了像 DINOv2 这样的视觉基础模型的特征泛化能力。我们的 DINO Teacher 方法由两个组件组成。首先,我们通过仅使用源数据在冻结的 VFM 主干上训练一个检测头来创建一个新的标记器。我们表明,这个简单的框架优于标准的均值教师自标记方法,特别是在 BDD100k 数据集上,展示了均值教师架构的局限性。其次,我们展示了将学生模型的主干特征与冻结的 VFM 编码器的特征对齐,分别对源图像和目标图像进行对齐,可以推动学生学习更具判别力且从源域到目标域泛化得更好的特征,从而提高性能。

附录 A:算法和实现细节

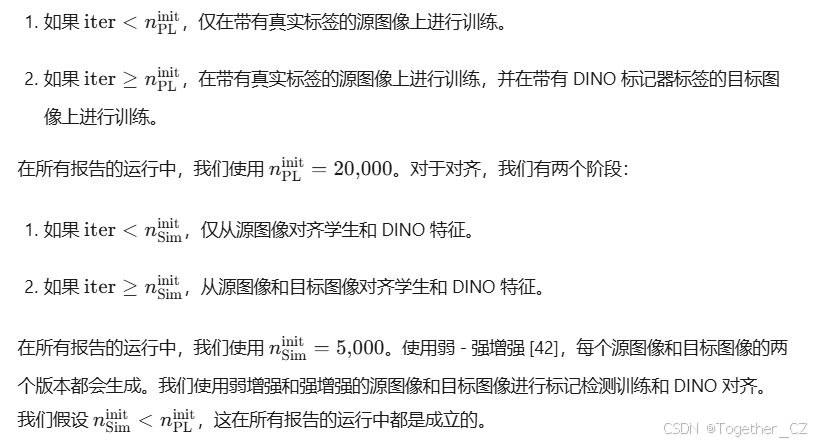

我们提出的方法在多个阶段训练学生模型,用于目标域伪标签训练和对齐。我们在这里介绍所有训练阶段,并在算法 1 中总结我们的方法。对于伪标签训练,我们有两个阶段:

算法 1:DINO Teacher 伪代码

while iter < n_{max} do

Input: 源图像及其标签 (X_S, Y_S, B_S)

Input: 目标图像 X_T

对源图像进行增强 X_S = {X_{weak}^S, X_{strong}^S}

计算源图像的相似性损失 L_{sim}^S (X_S)

计算源图像的检测损失 L_{det}^S (X_S, Y_S, B_S)

if iter ≥ n^{init}_{Sim} then

对目标图像进行增强 X_T = {X_{weak}^T, X_{strong}^T}

计算目标图像的相似性损失 L_{sim}^T (X_T)

end if

if iter ≥ n^{init}_{PL} then

获取 DINO 标签 { ̃Y_T, ̃B_T }

计算目标图像的检测损失 L_{det}^T (X_T, ̃Y_T, ̃B_T)

end if

汇总所有损失并更新学生模型

end while附录 B:额外的消融研究和结果

B.1 使用更大的 ViT-L 进行对齐

在主论文的表 5b 中,我们展示了使用 ViT-S 和 ViT-B 作为 DINOv2 主干进行对齐的结果,并在第 3.3 节中讨论了在在线训练期间使用更大的模型过于耗时。我们在表 7 中添加了 ViT-L 的结果,并展示了更大的对齐目标持续改进最终性能的趋势。这表明如果能够降低训练成本,使用更大的模型进行对齐具有潜力。一种可能的解决方案是预先计算并存储目标数据集中每个图像的 DINO 特征,从而只需要对数据集进行一次前向传递以获取对齐目标。这个单一的前向传递甚至可以与用于生成目标伪标签的 DINO 标记器的前向传递结合起来。然而,这将对较大的数据集产生显著的数据存储需求。

B.2 学生主干网络的选择消融

我们在第 4.3 节的主结果中使用 VGG16 作为主干网络进行 Foggy Cityscapes 和 BDD100k 的领域适应,遵循以往的工作。然而,我们在 ACDC 上的实验选择了 ResNet-50,因为这是更常见的架构。同样,较小的 ViT-S 架构与 VGG 大小相似,并且在使用更好的初始化(如 DINOv2 的蒸馏权重)时通常是一个更强的基线。

我们在表 8 中展示了使用 ResNet-50 主干和 ViT-S 主干在 Cityscapes → BDD100k 测试案例上的额外结果,分别对应 3 种设置:仅源数据(SO)、使用均值教师生成的伪标签(MT)和我们的 DINO Teacher(DT)。我们使用与在 ACDC 上的测试相同的 ResNet-50 训练协议,并使用我们在原始测试中在 BDD100k 上使用的相同 ViT-G 生成的标签。我们考虑了冻结和未冻结的 ViT-S 主干的情况。当未冻结时,ViT 主干的学习率相对于检测头学习率缩小了 0.01 倍。

对于所有设置,更好的架构相比 VGG 结果都带来了性能提升。此外,我们的 DINO Teacher 在所有测试的架构中都显著优于均值教师(约 +5%)。即使使用了更强的学生模型,我们仍然在使用外部标记器生成的标签而不是从学生模型派生的标签时看到了较大的改进。

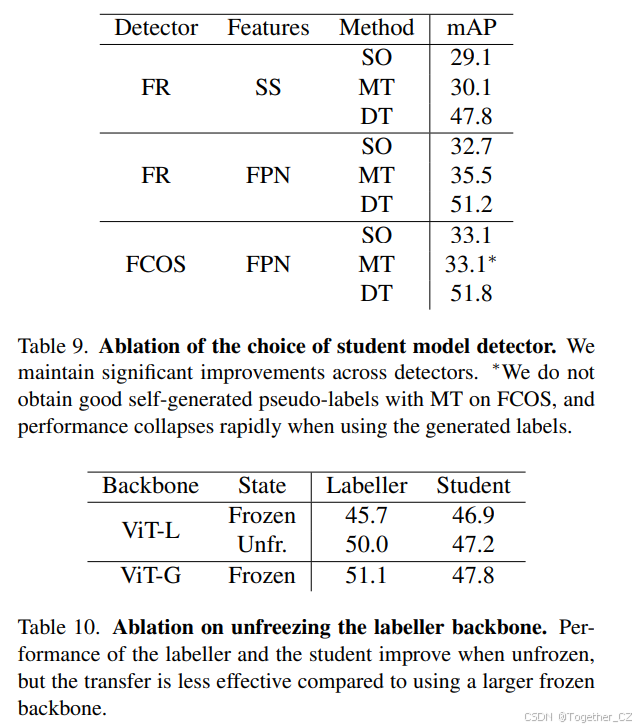

B.3 检测器选择的消融

我们在所有结果中使用了单尺度(SS)Faster R-CNN,但有些工作使用了多尺度 Faster R-CNN(FR)与特征金字塔(FPN)或单阶段方法如 FCOS。我们在表 9 中提供了两者的比较结果,分别比较了仅使用源数据(SO)和使用均值教师生成的伪标签(MT)与我们的 DINO Teacher(DT)。同样,我们看到我们的 DINO Teacher 方法为所有测试的检测器带来了显著的改进。此外,从单尺度到多尺度 Faster R-CNN 的改进在均值教师(+1.0% 到 +2.8%)中比仅使用源数据时更大,这表明均值教师自标记方法的性能对其初始化的源数据模型的性能非常敏感。我们在表 8 中观察到了类似的趋势,当考虑主干网络的变化时。我们无法为单阶段 FCOS 方法生成良好的均值教师伪标签,并发现边界框置信度得分通常远低于两阶段 Faster R-CNN 方法。我们测试了从 0.3 到 0.8 的多个边界框置信度阈值用于伪标签选择,但所有这些都导致了源数据集和目标数据集上的性能迅速下降,这意味着在使用任何伪标签之前,最佳性能就已经出现。

B.4 解冻标记器主干的消融

在主论文中,我们考虑了最简单的设置,即保持标记器 ViT 主干冻结,维护预训练的 DINOv2 权重,并在表 5a 中展示了标记器主干大小和性能的影响。在这里,我们考虑了解冻标记器主干的情况,并在源图像上与检测器一起训练。我们通常遵循第 4.2 节中的训练方案,但将主干的学习率缩小了 0.01 倍。我们在表 10 中展示了在 Cityscapes 图像上训练的标记器在未标记的目标 BDD 上的性能,以及使用标记器伪标签在 BDD 上训练的 VGG 学生的性能。我们发现,尽管解冻主干使标记器的性能显著提升(+4.3%),但对学生的改进较小(+0.3%)。我们发现,由于解冻而导致的标记器性能提升并没有像使用更大的冻结主干那样有效地转移到学生模型上。

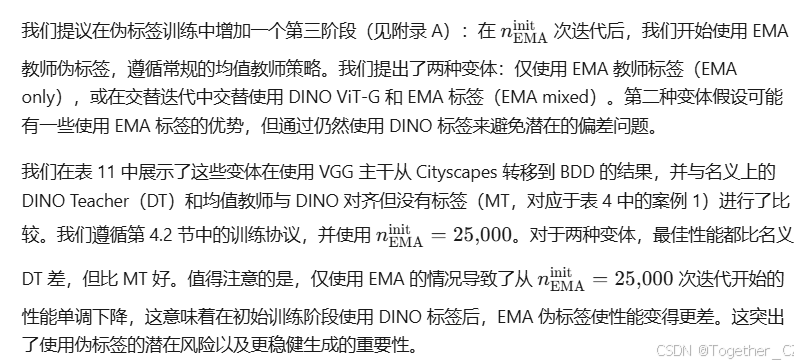

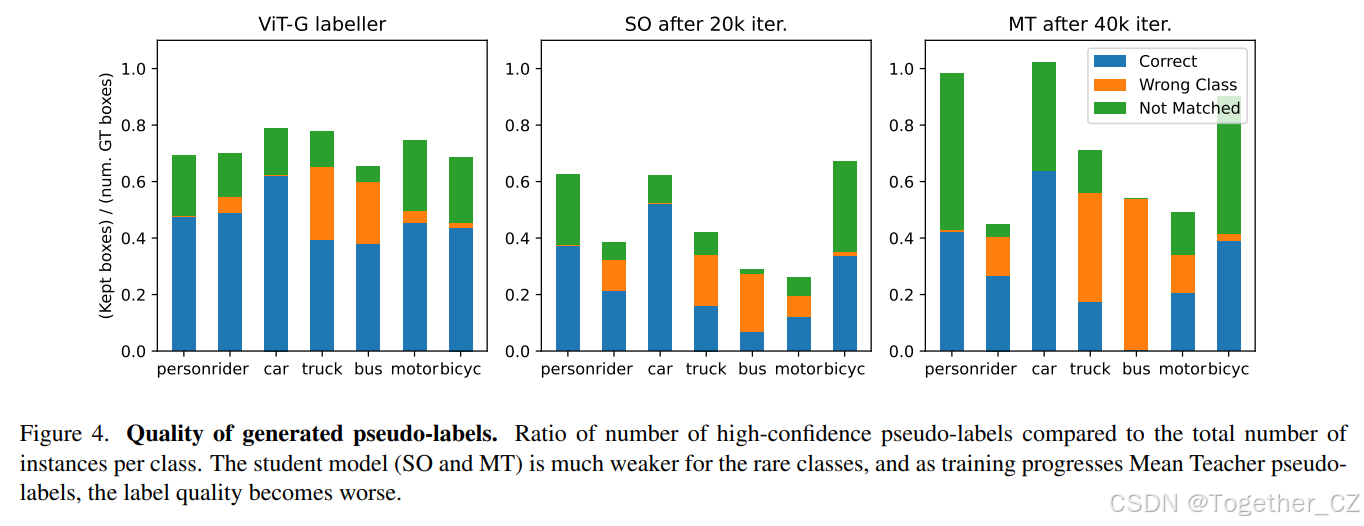

B.5 使用 EMA 教师标签的消融

我们的方法与均值教师基线的主要区别在于,我们使用 DINO 标记器而不是 EMA 教师生成目标伪标签,从而获得了更好的性能。然而,在许多情况下(较小的标记器在表 5b 中,ACDC 雾和雪分割,更大的学生主干和检测器),从接触目标数据的学生派生的教师模型表现优于仅在源数据上训练的标记器。因此,我们研究了是否可以将 EMA 教师标签与使用 DINO 标记器结合起来。

B.6 自标记方法的问题

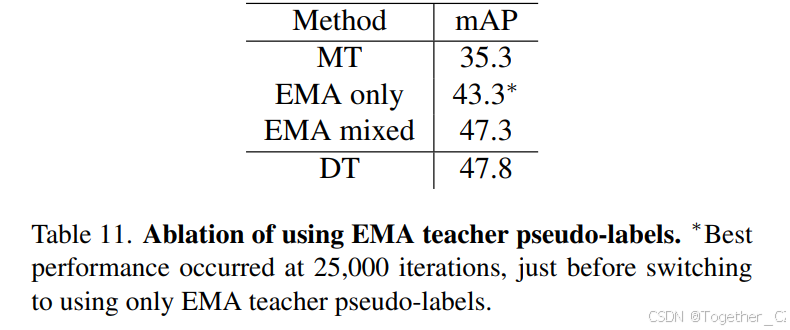

当我们比较自生成标签与使用外部标签源时,我们通常发现自标记的性能不仅更差,而且可能不稳定:与仅在源数据上进行训练相比,在目标数据上的性能在初始阶段有所提升后可能会下降。这在我们在表 11 中的消融研究中最为明显,即使使用 DINO Teacher 标签初始化,仅在 nEMAinit 次迭代后使用均值教师标签也会随着时间的推移导致性能下降。我们相信这可以通过伪标签中的类别混淆来解释,特别是对于罕见类别,这会导致随着时间的推移类别表示退化。

为了探讨这一点,图 4 展示了在目标 BDD 数据集上,置信度值高于阈值 δ=0.8(因此保留为标签)的伪标签数量与给定类别实际实例数量的比率,用于三个标记器:我们的 ViT-G DINO 标记器、在 nPLinit=20,000 次迭代(当开始均值教师伪标签生成时)的源数据 VGG 学生,以及在 40{,}000 次迭代时的均值教师 EMA 教师。我们观察到,源数据学生是一个糟糕的罕见类别标记器,如卡车、公交车和摩托车,这种糟糕的初始性能导致随着训练的继续标签变得更差。我们看到常见类别(如汽车)的置信度高的框增加,这些框与罕见类别框匹配(橙色线条为卡车和公交车)或与任何真实实例不匹配(汽车上的绿色条)。

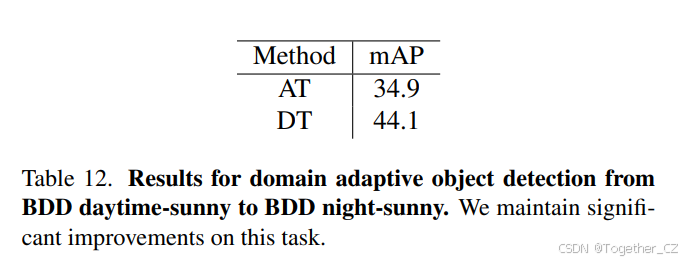

B.7 BDD Daytime-Sunny 到 BDD Night-Sunny 的结果

我们在主结果中遵循现有的领域适应工作,考虑从 Cityscapes 到 BDD100k Daytime 的领域适应。然而,BDD100k 数据集包含许多非白天场景的图像,包括许多夜间场景。近期在领域泛化方面的工作由 Wu 和 Deng 提出,提出了一个主要由 BDD100k 图像组成的新数据集,包含多种天气条件。它包含五个分割:来自 BDD100k 的白天晴朗(白天且无显著天气)分割,同样来自 BDD100k 的夜间晴朗分割,从小于 BDD100k 图像渲染的黄昏雨天和夜间雨天分割,以及由 Foggy Cityscapes 和 Adverse-Weather 图像组成的白天雾天分割。提出的白天晴朗分割与我们在第 4.1 节中介绍的 Daytime 分割不同。

我们考虑了白天晴朗和夜间晴朗分割,它们的图像数量相似,分别有 19{,}395 张训练图像和 8{,}313 张测试图像用于白天晴朗,以及 18{,}310 张训练图像和 7{,}848 张测试图像用于夜间晴朗。这个测试案例类似于 Cityscapes → Foggy Cityscapes,但数据集更大且领域差距是非合成的。我们使用第 4.2 节中描述的 VGG16 主干的训练协议。由于我们使用了新的源数据集,我们训练了一个新的 ViT-L DINO 标记器用于白天晴朗分割。我们在表 12 中展示了 Adaptive Teacher 基线(AT)和我们的 DINO Teacher(DT)的结果。与从 Cityscapes 到 BDD100k Daytime 的领域适应类似,我们发现 DINO Teacher 在目标数据集上带来了显著的改进,达到了 +9.2%。

B.8 完整的 ACDC 结果

我们在表 3 中平均了用于获得表 3 中结果的 ACDC 运行的完整每类 AP 和 mAP。表 13 展示了我们重新实现的 Adaptive Teacher 的结果,表 14 展示了我们的 DINO Teacher 的结果。我们表明,我们的 DINO Teacher 与 Adaptive Teacher 基线相比持续改进。然而,基线和我们提出的方法在最具挑战性的夜间和雨天分割中对某些罕见类别(特别是骑手和自行车)都存在困难。这在较简单的雾天和雪天分割中没有看到,也没有在适应到 BDD100k Daytime(表 1)或 Foggy Cityscapes(表 2)时看到。这可能是由于有限的标签、骑手和自行车实例之间的重叠框,或者骑手实例被错误地伪标记为人员,所有这些都可能导致训练问题。

附录 C:定性结果

我们在图 5 中展示了定性结果,比较了我们的方法与基线 Adaptive Teacher 在转移到 BDD100k、Foggy Cityscapes 和 ACDC Night 时的表现。总体而言,我们的方法在罕见类别(如卡车和火车)上表现更好,并且在具有重叠对象的复杂场景中表现更好。我们还从错误类别中产生了更少的误检。我们在图 5 中展示了定性结果,比较了我们的方法与基线 Adaptive Teacher 在转移到 BDD100k、Foggy Cityscapes 和 ACDC Night 时的表现。总体而言,我们的方法在罕见类别(如卡车和火车)上表现更好,并且在具有重叠对象的复杂场景中表现更好。我们还从错误类别中产生了更少的误检。

1582

1582

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?