在日常机器学习调参过程中,我们常常使用网格搜索、随机搜索和基于GP的SMBO(Sequential Model-Based Optimization)搜索。然而还有一些其他方法也很好用,比如笔者今天所介绍的基于TPE的SMBO(Sequential Model-Based Optimization)搜索。

TPE搜索简要介绍:

TPE(Tree-structured Parzen Estimators)搜索最核心的思想: 根据贝叶斯公式:P(Y|X) =[ P(X|Y) X P(Y) ] / P(X),基于GP的SMBO的思想是估计P(Y|X), 而基于TPE的SMBO的思想是估计P(X|Y)。

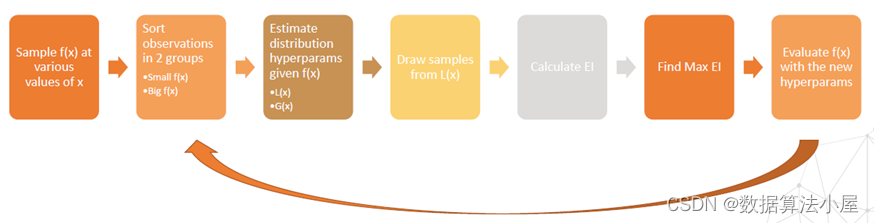

TPE搜索的流程如下,如下图所示:

- 对f(x)抽样

- 分成small f(x) 和 big f(x)

- 估计 small f(x) 的分布 L(x),估计 big f(x)的分布 G(x)

- 对L(x) 进行抽样

- 计算EI,找到最大的EI

- 根据EI更新f(x)

- 重复 2 ~ 7

TPE搜索调参实例:

下面介绍如何

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

4650

4650

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?