交叉熵是信息论中的一个重要概念,主要用于度量两个概率分布间的差异性,在深度学习中,一般用来求目标与预测值之间的差距。

信息论

交叉熵是信息论中的一个概念,要想了解交叉熵的本质,需要先从最基本的概念讲起。

1 信息量

信息量和事件发生的概率有关。

可见该函数符合我们对信息量的直觉 ,概率越大,信息量就越小。

2 熵

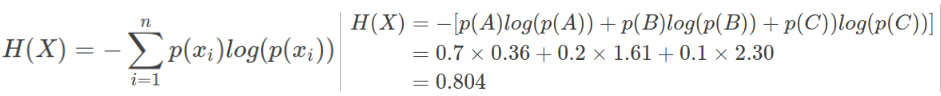

考虑另一个问题,对于某个事件,有n种可能性,每一种可能性都有一个概率p(xi)。

我们现在有了信息量的定义,而**熵**用来表示所有信息量的期望,即:

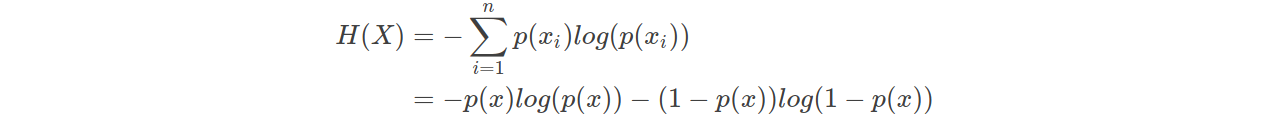

然而有一类比较特殊的问题,比如投掷硬币只有两种可能,字朝上或花朝上。买彩票只有两种可能,中奖或不中奖。我们称之为0-1分布问题(二项分布的特例),对于这类问题,熵的计算方法可以简化为如下算式:

3 相对熵(KL散度)

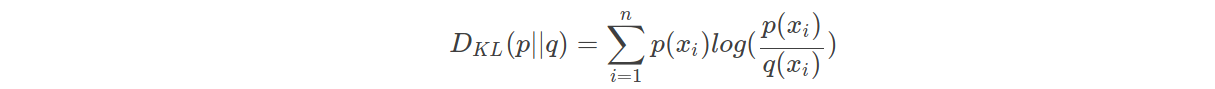

相对熵又称KL散度,如果我们对于同一个随机变量 x 有两个单独的概率分布 P(x) 和 Q(x),我们可以使用 KL 散度(Kullback-Leibler (KL) divergence)来衡量这两个分布的差异

KL散度的计算公式:

n为事件的所有可能性。DKL的值越小,表示q分布和p分布越接近

4 交叉熵

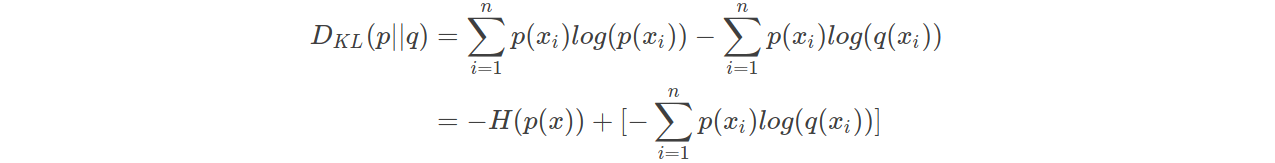

对上式变形可以得到:

等式的前一部分恰巧就是p的熵,等式的后一部分,就是交叉熵

KL散度 = 交叉熵 - 信息熵

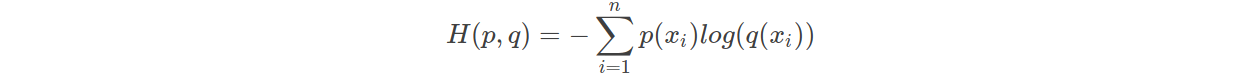

交叉熵公式表示为:

在机器学习中,我们需要评估label和predicts之间的差距,使用KL散度刚刚好,即DKL(y||y^),由于KL散度中的前一部分−H(y)不变,故在优化过程中,只需要关注交叉熵就可以了。所以一般在机器学习中直接用用交叉熵做loss,评估模型。

机器学习中交叉熵的应用

1 为什么要用交叉熵做loss函数?

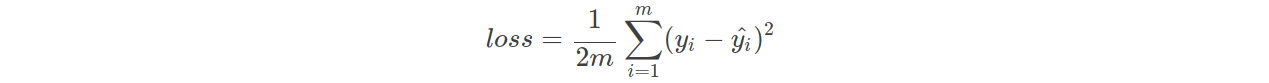

在线性回归问题中,常常使用MSE(Mean Squared Error)作为loss函数,比如:

这里的m表示m个样本的,loss为m个样本的loss均值。

MSE在线性回归问题中比较好用,那么在逻辑分类问题中还是如此么?

2 交叉熵在单标签多分类

这里的单类别是指,每一张图像样本只能有一个类别,比如只能是狗或只能是猫。

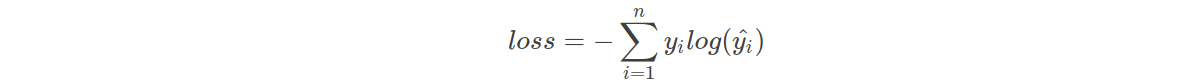

单标签时,每张图片的损失是一个交叉熵,交叉熵针对的是所有类别(所有类别概率和是1)

交叉熵在单分类问题上基本是标配的方法

上式为一张样本的loss计算方法。式中n代表着n种类别。

上式为一张样本的loss计算方法。式中n代表着n种类别。

举例说明,比如有如下样本

3 交叉熵在多标签分类

这里的多类别是指,每一张图像样本可以有多个类别,比如同时包含一只猫和一只狗

多标签时,每张图片的损失是N个交叉熵之和(N等于类别数),交叉熵针对的是单个类别(单个类别概率和是1)

和单分类问题的标签不同,多分类的标签是n-hot。

比如下面这张样本图,即有青蛙,又有老鼠,所以是一个多分类问题

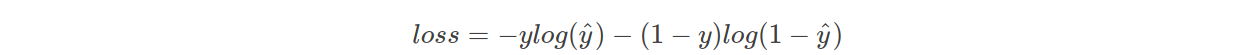

值得注意的是,这里的Pred不再是通过softmax计算的了,这里采用的是sigmoid。将每一个节点的输出归一化到[0,1]之间。所有Pred值的和也不再为1。换句话说,就是每一个Label都是独立分布的,相互之间没有影响。所以交叉熵在这里是单独对每一个节点进行计算,每一个节点只有两种可能值,所以是一个二项分布。前面说过对于二项分布这种特殊的分布,熵的计算可以进行简化。

同样的,交叉熵的计算也可以简化,即

注意,上式只是针对一个节点的计算公式。这一点一定要和单分类loss区分开来。

例子中可以计算为:

学习过程

交叉熵损失函数经常用于分类问题中,特别是在神经网络做分类问题时,也经常使用交叉熵作为损失函数,此外,由于交叉熵涉及到计算每个类别的概率,所以交叉熵几乎每次都和sigmoid(或softmax)函数一起出现。

我们用神经网络最后一层输出的情况,来看一眼整个模型预测、获得损失和学习的流程:

- 神经网络最后一层得到每个类别的得分

scores; - 该得分经过

sigmoid(或softmax)函数获得概率输出; - 模型预测的

类别概率输出与真实类别的one hot形式进行交叉熵损失函数的计算。

参考(感谢)

https://zhuanlan.zhihu.com/p/35709485

7339

7339

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?