残差网络&ResNet&DenseNet

1、前言

在VGG中,卷积网络达到了19层,在GoogLeNet中,网络史无前例的达到了22层。那么,网络的精度会随着网络的层数增多而增多吗?在深度学习中,网络层数增多一般会伴着下面几个问题

计算资源的消耗

模型容易过拟合

梯度消失/梯度爆炸问题的产生

问题1可以通过GPU集群来解决,对于一个企业资源并不是很大的问题;问题2的过拟合通过采集海量数据,并配合Dropout正则化等方法也可以有效避免;问题3通过Batch Normalization也可以避免。貌似我们只要无脑的增加网络的层数,我们就能从此获益,但实验数据给了我们当头一棒。

作者发现,随着网络层数的增加,网络发生了退化(degradation)的现象:随着网络层数的增多,训练集loss逐渐下降,然后趋于饱和,当你再增加网络深度的话,训练集loss反而会增大。注意这并不是过拟合,因为在过拟合中训练loss是一直减小的。

当网络退化时,浅层网络能够达到比深层网络更好的训练效果,这时如果我们把低层的特征传到高层,那么效果应该至少不比浅层的网络效果差,或者说如果一个VGG-100网络在第98层使用的是和VGG-16第14层一模一样的特征,那么VGG-100的效果应该会和VGG-16的效果相同。所以,我们可以在VGG-100的98层和14层之间添加一条直接映射(Identity Mapping)来达到此效果。

从信息论的角度讲,由于DPI(数据处理不等式)的存在,在前向传输的过程中,随着层数的加深,Feature Map包含的图像信息会逐层减少,而ResNet的直接映射的加入,保证了 L+1层的网络一定比 L层包含更多的图像信息。

基于这种使用直接映射来连接网络不同层直接的思想,残差网络应运而生。

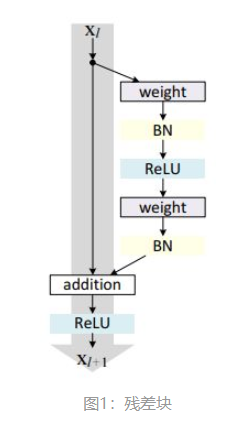

1.1、残差块

残差网络是由一系列残差块组成的,残差块分成两部分直接映射部分和残差部分。

图1中的Weight在卷积网络中是指卷积操作,addition是指单位加操作。

一般,这种版本的残差块叫做resnet_v1,keras代码实现如下:

def res_block_v1(x, input_filter, output_filter):

res_x = Conv2D(kernel_size=(3,3), filters=output_filter, strides=1, padding='same')(x

残差网络&ResNet&DenseNet1、前言1.1、残差块2、残差网络:ResNet2.1、ResNet的网络结构3、残差网络:DenseNet3.2、设计理念3.3、网络结构1、前言在VGG中,卷积网络达到了19层,在GoogLeNet中,网络史无前例的达到了22层。那么,网络的精度会随着网络的层数增多而增多吗?在深度学习中,网络层数增多一般会伴着下面几个问题计算资源的消耗模型容易过拟合梯度消失/梯度爆炸问题的产生问题1可以通过GPU集群来解决,对于一个企业资源并不是很大的

残差网络&ResNet&DenseNet1、前言1.1、残差块2、残差网络:ResNet2.1、ResNet的网络结构3、残差网络:DenseNet3.2、设计理念3.3、网络结构1、前言在VGG中,卷积网络达到了19层,在GoogLeNet中,网络史无前例的达到了22层。那么,网络的精度会随着网络的层数增多而增多吗?在深度学习中,网络层数增多一般会伴着下面几个问题计算资源的消耗模型容易过拟合梯度消失/梯度爆炸问题的产生问题1可以通过GPU集群来解决,对于一个企业资源并不是很大的

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1894

1894

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?