1.ResNet

ResNet(Residual Neural Network),又叫做残差神经网络,是由微软研究院的何凯明等人2015年提出,获得ImageNet ILSVRC 2015比赛冠军;获得CVPR2016最佳论文奖

1.1 解决的痛点

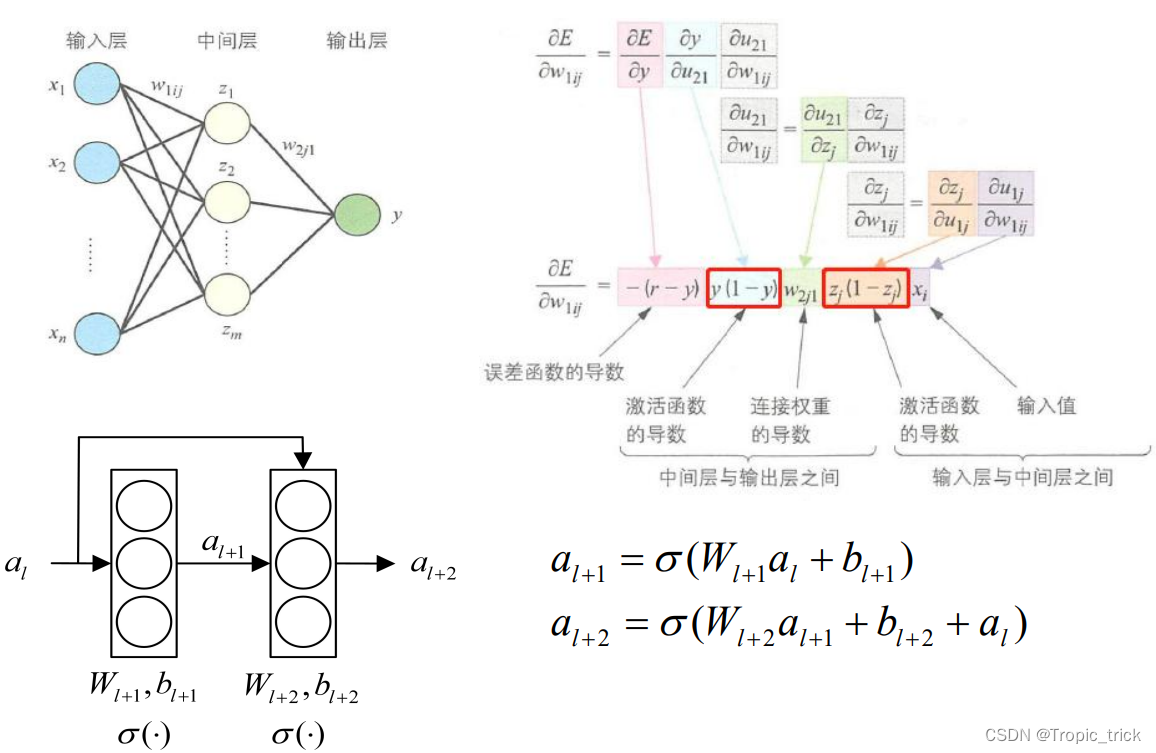

以前的神经网络随着卷积网络层数的增加,误差的逆传播过程中存在的梯度消失和梯度爆炸问题同样也会导致模型的训练难以进行;甚至会出现随着网络深度的加深,模型在训练集上的训练误差会出现先降低再升高的现象

残差网络的引入则有助于解决梯度消失和梯度爆炸问题

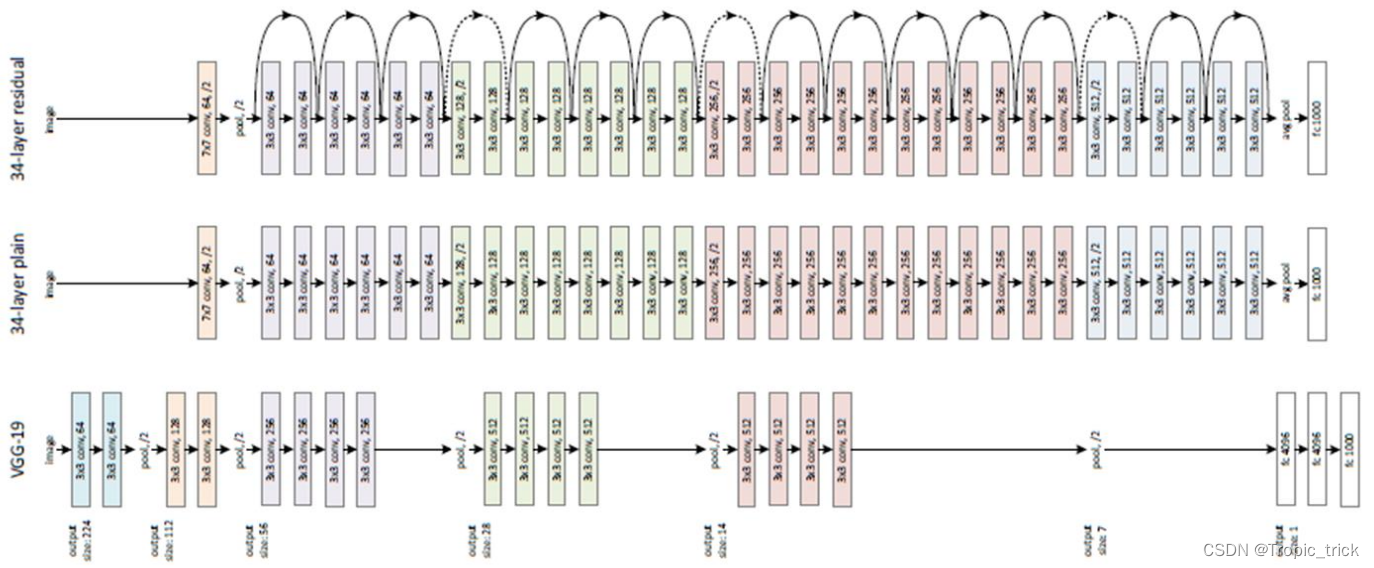

1.2 网络结构

1.3 残差块

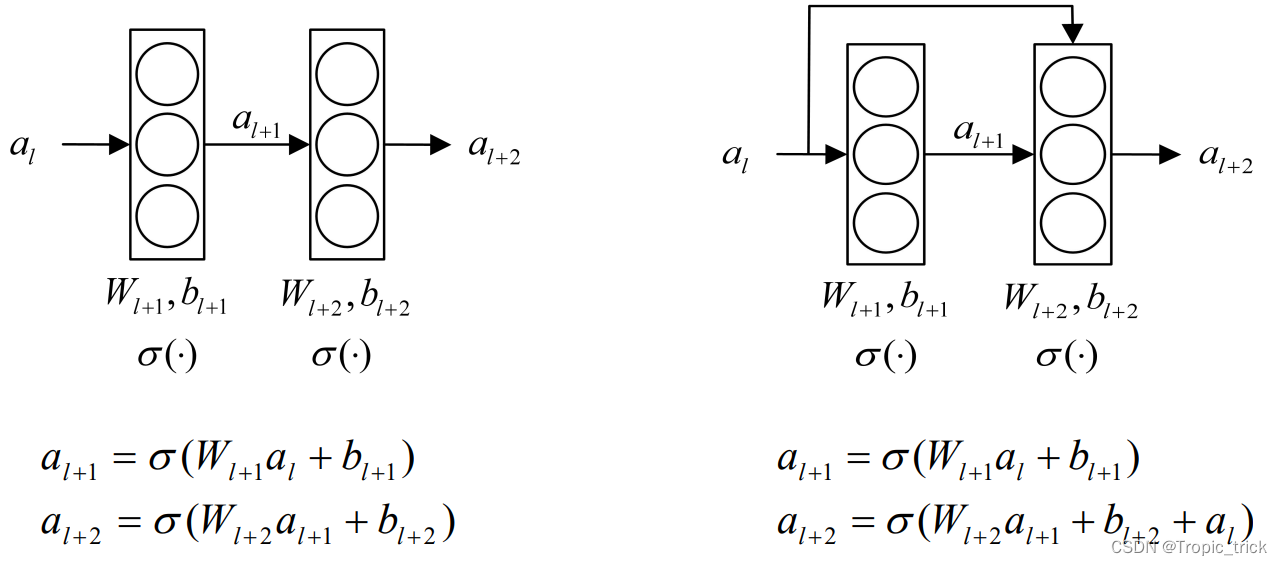

ResNet的核心是叫做残差块(Residual block)的小单元, 残差块可以视作在标准神经网络基础上加入了跳跃连接(Skip connection)

1.4 Skip connections的作用

-

解决梯度消失问题:在深层神经网络中,梯度在反向传播过程中可能会逐渐消失,导致前层的参数更新非常缓慢,训练过程变得困难。跳跃连接可以在反向传播时直接传递梯度,从而缓解梯度消失问题,促进深层网络的训练。

-

加快收敛速度:通过引入跳跃连接,网络的优化问题被转换为学习残差映射(即输出与输入之间的差值),这比直接学习原始映射要容易得多。这样可以加快网络的收敛速度,使训练过程更加高效。

-

提高网络性能:跳跃连接可以帮助网络保持输入信息的完整性,减少信息的丢失,使得网络能够更好地捕捉到数据中的重要特征,从而提升模型的性能。

-

减少参数量:虽然ResNet引入了跳跃连接,但它并不会显著增加模型的参数量,因为跳跃连接本身并不需要额外的参数。这使得网络在保持较高性能的同时,仍然能够保持相对较低的复杂度。

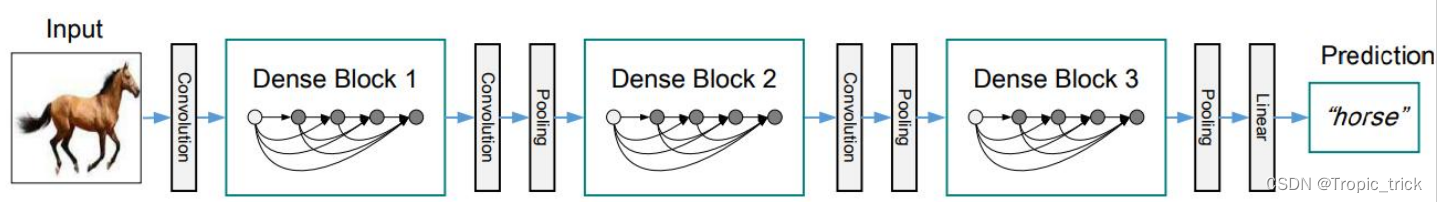

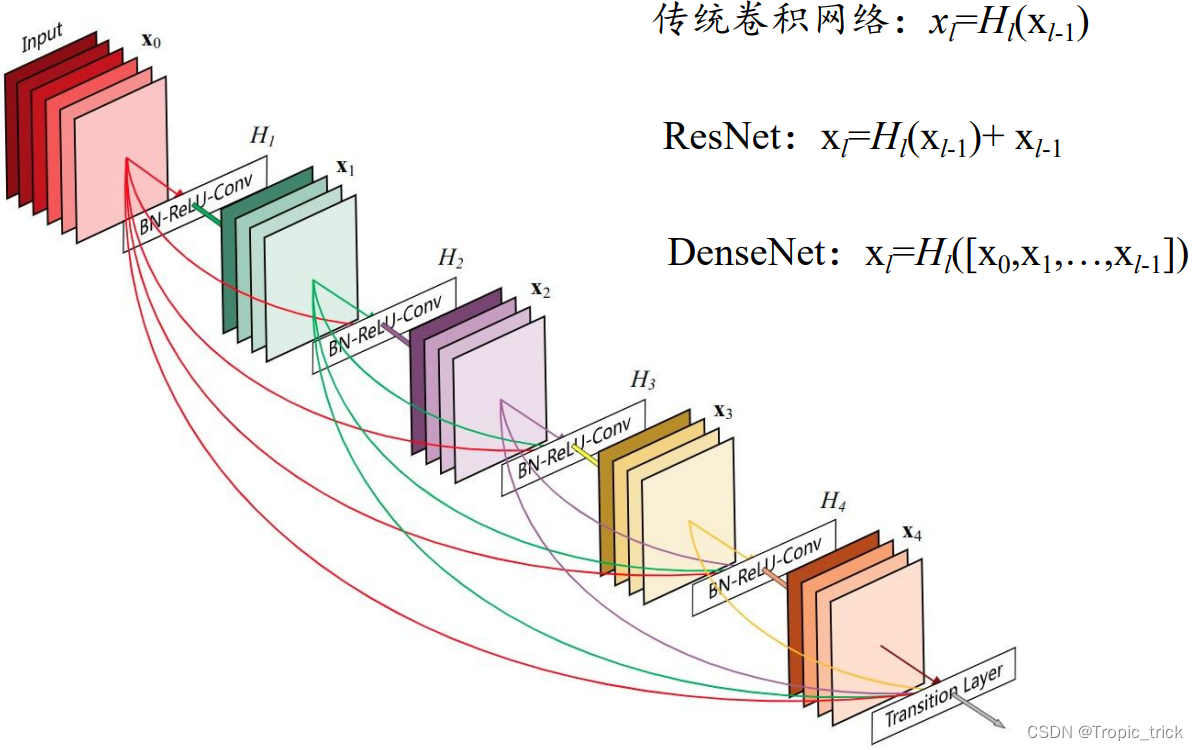

2. DenseNet

DenseNet中,两个层之间都有直接的连接;每一层都使用前面所有层的特征映射作为输入,并且 使用其自身的特征映射作为所有后续层的输入。

2.1 优势

-

更有效的信息传递和特征重用:DenseNet通过在每一层直接连接所有前面的层,使得特征能够在网络的各个层之间更加高效地传递和重用,,简化了梯度流和特征流的路径。这种密集连接机制有助于保持信息的流动和梯度的传播,提升了模型的表现。

-

减少梯度消失问题:与ResNet相似,DenseNet也能缓解梯度消失问题。但由于每一层都直接连接到之前的所有层,DenseNet能更有效地确保梯度的顺畅传播,进一步缓解梯度消失问题,尤其是在非常深的网络中。

-

更高的参数效率:参数效率更高,因为它通过特征的重用减少了冗余特征的学习。大量的连接共享了信息,所需的参数总量相对较少,从而减少了过拟合的风险。

-

更好的正则化效果:密集连接结构具有一定的正则化效果,因为每一层的输入都是所有前面层的输出的联合。这样,网络在训练过程中更不容易陷入局部最优解,模型的泛化能力更强。

-

更深但更紧凑的网络结构:DenseNet的设计允许构建非常深的网络,但由于其高效的参数利用,实际计算复杂度和存储需求并没有显著增加。这使得DenseNet在处理复杂任务时能够保持较高的性能和效率。

2.2 5层的稠密块示意图

在实验中,DenseNets随着参数数量的增加,在精度上产生一致的提高,而没有任何性能下降或过拟合的迹象

1965

1965

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?