H2O Deep Learning 模块

(一)Activation and Loss函数

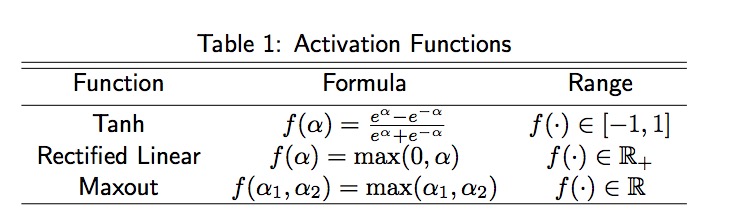

H2O支持的Activation Functions

tanh函数关于0对称,使得训练算法收敛较快

Rectified Linear函数在图像识别上面有较高的性能表现

Maxout函数是广义的Rectified Linear函数

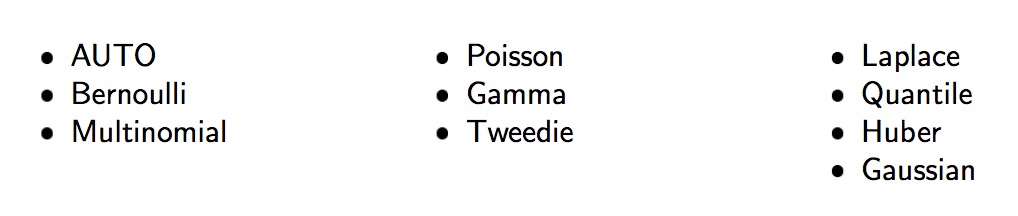

对于响应变量,可以指定以下的几个分布函数:

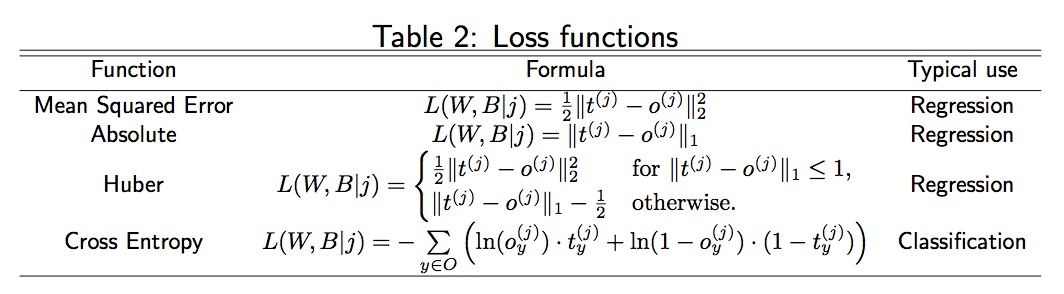

每一个分布都有对应的损失函数,Bernoulli和Multinomial分布对应cross-entropy(log)损失,Gaussian分布对应于Mean Squared Error,Laplace分布对应于Absolute损失, Huber对应Huber损失,对于Poisson, Gamma和 Tweedie 分布, 损失函数不能改变,所以损失函数设置为AUTO.

损失函数如下:

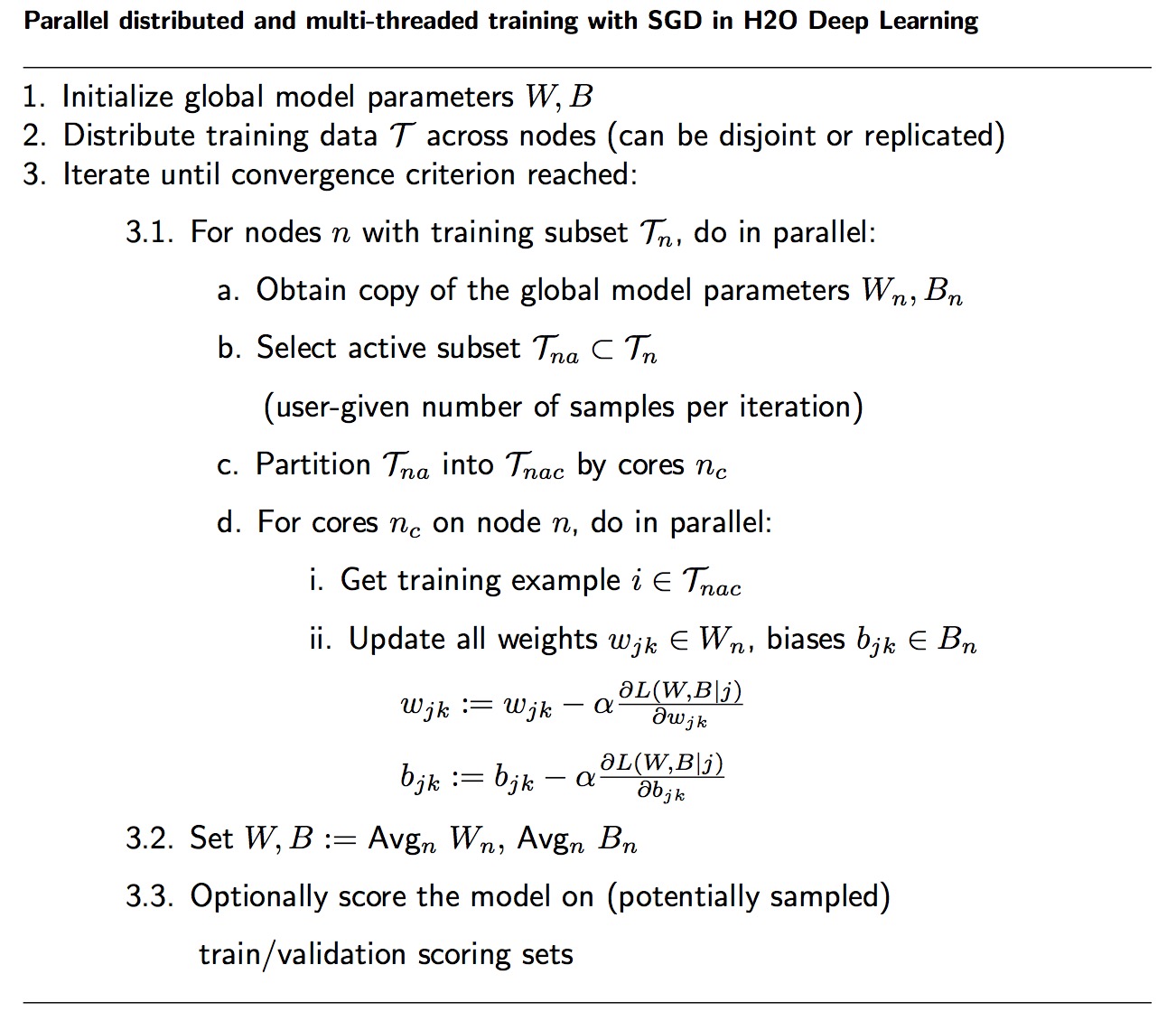

(二)Parallel Distributed Network Training

最小化损失函数L(W, B | j)需要使用SGD,传统的SGD算法速度很快,但并行化之后整个算法的速度就变慢了,H2O实现了一个叫Hogwild!的架构,它是一种共享内存的模型,核心思想是将数据先分发到各个节点并行执行,然后每个节点的数据再分发到每个节点的多核上,使用多线程异步执行。从而提高效率

(三) Specifying the Number of Training Samples

H2O是可扩展的,能充分利用计算节点的能力

使用train samples per iteration参数,如果指定为-1,所有节点处理每次迭代处理他们的本地数据。设置为-2,基于计算能力和网络开销会自动调整合适的参数,参数会影响整个训练过程的收敛速度。

例如说:整个训练数据10millions,在四个节点的集群上指定每次迭代的训练数据100000,每个节点每次迭代会处理25000个数据,one epoch会经过40次分布式迭代。

(四)Regularization

H2O深度学习框架支持正则化去防止过拟合, 包括L1:Lasso和L2:Ridge regularization

损失函数就变成如下形式:

L0(W, B | j) = L(W, B | j) + 1R1(W, B | j) + 2R2(W, B | j).

第二种正则化的方式是 dropout,它在训练样本前向传播的过程中约束了在线优化的方式,对于一个神经元,以概率P限制神经元,对于输入神经元一般小于0.2,对于隐层神经元一般大于0.5

(五)Advanced Optimization

在梯度下降中,学习率的取值非常关键,如果过大就不会收敛,如果过小则收敛速度 太慢。一般步长可以由线性搜索算法来确定。在机器学习中,经常使用自适应调整学习 率的方法。

1、Momentum Method

2、Rate Annealing

3、Adaptive Learning

本文详细介绍了H2O深度学习模块的核心功能,包括激活和损失函数的选择、并行分布式网络训练、训练样本数量的设定、正则化技术以及高级优化方法等内容。

本文详细介绍了H2O深度学习模块的核心功能,包括激活和损失函数的选择、并行分布式网络训练、训练样本数量的设定、正则化技术以及高级优化方法等内容。

462

462

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?